极智算总结:

- 算力平台:GPU利用率与集群线性加速比

- 首个国产全功能GPU的万卡集群来了!“中国英伟达”出品

- 升腾大模型|分布式并行-7——模型算力利用率(MFU)+硬件算力利用率(HFU...

- 模型训练mfu多少算先进

- 【AI问爱答】第二期问答干货请查收,诚邀您来提问

- 910c与h20性能差距

- GPU利用率与模型算力利用率

算力平台:GPU利用率与集群线性加速比

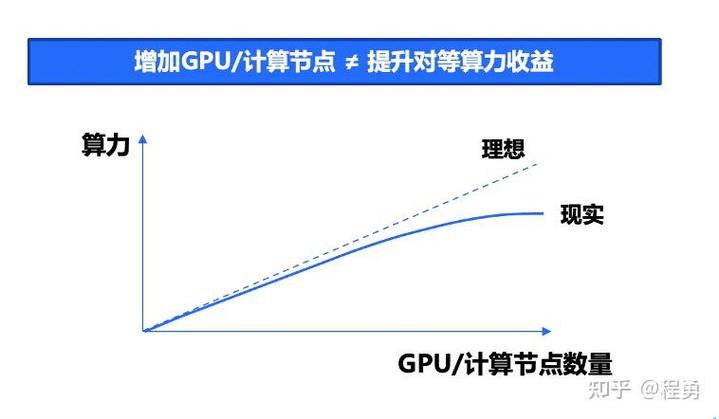

〖壹〗、例如,在千卡GPU集群中,GPU算力利用率(MFU)约为59%;在万卡GPU集群中,GPU算力利用率(MFU)约为52%。集群线性加速比 集群线性加速比是指当GPU卡数量增加时,某个计算任务完成速度提高的比例(即该计算任务完成时间缩短的比例)与GPU卡数量增加的比例的比值。

〖贰〗、算力利用率是一个静态指标,表示给定GPU集群下的有效算力获取情况;而线性加速比是一个动态指标,反映集群扩展能力。GPU集群线性加速比可通过平均每张GPU卡的计算吞吐、算力利用率或集群总算力增加比例与GPU卡数量增加比例的比值来表示。实际应用中,由于通信开销等因素,无法实现完美的线性加速。

〖叁〗、算力利用率与线性加速比不同,线性加速比描述了集群总有效算力随着GPU卡数量增加的变化情况。实践中,GPU集群的线性加速比受多种因素影响,理想情况下可达90%以上,但实际算力利用率通常在50%左右。

〖肆〗、算力利用率:算力利用率和线性加速比k一起描述集群性能。理想情况下,随着GPU数量增加,算力线性增长。但在实际情况下,由于多种因素的影响,线性加速比一般在90%以上,而大规模集群的算力利用率通常在50%左右。

〖伍〗、GPU集群的算力可以用公式Q = C*N*u来衡量,其中C是单卡峰值算力,N是GPU数量,u是算力利用率。算力利用率和线性加速比k一起描述集群性能,理想情况下,随着GPU数量增加,算力线性增长,但实际效率受多种因素影响,一般线性加速比在90%以上,大规模集群的算力利用率通常在50%左右。

〖陆〗、这一特性使得H20在组建大规模集群时能够保持较高的集群线性加速比,从而提升整体计算效率。适用于大规模集群 集群线性加速比高:由于H20的高卡间互联带宽和PCIe Gen5连接支持,使得H20集群在配备400GbE集群网络情况下,线性加速比接近于1。

首个国产全功能GPU的万卡集群来了!“中国英伟达”出品

〖壹〗、首个国产全功能GPU的万卡集群来了,由“中国英伟达”摩尔线程出品。这个集结了超过10000张高性能GPU的超复杂工程,总算力超万P,专为万亿参数级别的复杂大模型训练而设计。其特点不仅在于规模庞大,还包括:有效计算效率(MFU)高:目标比较高达60%,可达到世界水平。

〖贰〗、首个国产全功能GPU的万卡集群已到来,国产“中国英伟达”摩尔线程为其打造。这个集群集结了超过10000张高性能GPU,算力超万P,专为复杂大模型训练设计。其规模与性能,不仅在于万卡万P的超大算力,还体现在有效计算效率(MFU)比较高可达60%,显存容量达到PB级,卡间互联总带宽和节点互联总带宽同样达到PB级。

〖叁〗、首个国产全功能GPU的万卡集群已经由“中国版英伟达”摩尔线程正式发布。以下是关于该万卡集群的详细解算力强大:该万卡集群的算力超过万P,专为训练万亿参数级别的复杂大模型而设计。夸娥万卡集群的超大算力达到10ExaFlops,显存容量和卡间互联总带宽均达到PB级,实现了算力、显存和带宽的系统性协同优化。

〖肆〗、摩尔线程是一家2020年10月成立的中国高性能GPU芯片设计公司,总部位于北京,被称为“中国版英伟达”。核心定位上,以自研MUSA统一系统架构为核心,集成AI计算、图形渲染、视频编解码、科学计算四大引擎,产品可对标英伟达,覆盖数据中心、桌面级、智算集群等场景。

升腾大模型|分布式并行-7——模型算力利用率(MFU)+硬件算力利用率(HFU...

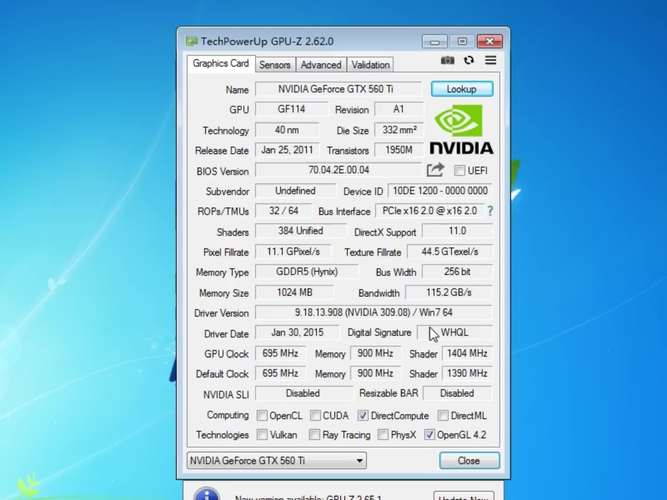

〖壹〗、模型算力利用率(MFU)MFU是指模型一次前反向计算消耗的矩阵算力与机器算力的比值。在大模型中,矩阵运算(Matrix Multiplications,GEMMs)是计算的主要成分。

模型训练mfu多少算先进

MFU(Model Flops Utilization)达到40%+的水平可以视为相对先进的指标借鉴。分析如下:MFU的定义与重要性:MFU是衡量大模型训练效率的重要指标,它反映了模型在训练过程中对GPU算力的利用效率。MFU分数较高意味着模型训练效率较高,能够更有效地利用GPU资源,从而降低训练成本和时间。

MFU的计算公式为:MFU = 实际训练的吞吐 / GPU理论巅峰吞吐 其中,实际训练的吞吐可以通过测量得到,而GPU理论巅峰吞吐则可以通过查询GPU的性能参数来获得。例如,对于一块A100/A800 GPU,其巅峰性能可以通过查询相关文档得到,通常为312 * 1e12 flops(使用bf16或fp16精度)。

GPU利用率和MFU都是衡量GPU在计算任务中表现的重要指标,但它们关注的侧重点不同。GPU利用率主要反映GPU核心的活跃程度,而MFU则更侧重于衡量模型在GPU上的实际计算效率。在评估大模型训练效率时,应综合考虑这两个指标,以及数据预处理、传输流程等其他因素,以全面评估和优化训练过程。

【AI问爱答】第二期问答干货请查收,诚邀您来提问

〖壹〗、若您绑定了邮箱,爱问系统会向您发送通知,告知您的提问是否审核通过。审核未通过原因:若提问未能通过审核,爱问已在【删除原则】中详细列出可能的原因。您可查看此原则以了解具体详情。审核标准:爱问制定了严格的审核标准,旨在确保提问质量和社区环境。提问前,请仔细阅读【删除原则】,以避免因不符合要求而被拒绝。

〖贰〗、若您绑定了邮箱,爱问系统会向您通知是否审核通过。至于未能通过的原因,爱问已详细列出在【删除原则】中,您可查看以了解具体详情。为了确保您的提问质量和社区环境,爱问制定了严格审核标准。请在提问前仔细阅读【删除原则】,避免因不符合要求而被拒绝。

910c与h20性能差距

〖壹〗、互联方面,H20支持第四代NVLink,带宽900GB/s,远超910C的392GB/s,集群扩展性更好。成本与量产能力:910C双Die封装成本更低、良率更高,量产速度快,国产化率超90%,适合快速部署。H20已停止台积电投片,依赖库存,后续供应受限,且单卡费用在6500 - 8000美元,费用较高。

〖贰〗、c和H20在性能方面存在一些差异。910c可能在某些特定功能或性能指标上有其独特之处。它或许在数据处理速度、图形渲染能力或者特定应用场景下的表现较为突出。其硬件配置和软件优化可能使得它在一些专业领域或者日常使用中能够提供高效的体验。而H20也有自身的优势。

〖叁〗、c和H20在性能方面存在一些差异。910c可能在某些特定的运算任务上有着不错的表现,其处理器或许能较为高效地处理一些常规的数据处理工作。它的图形处理能力也可能处于一定水平,能满足日常的图形显示需求。在存储方面,可能有一定的容量和读写速度,以保障数据的快速存储与读取。

〖肆〗、能效比上,910C功耗约310W,低于H20的400W,长期运营成本更优。总体而言,910C在单卡算力和成本控制上领先,H20则在存储带宽、集群互联及生态兼容性上占优。二者分别代表自主可控与世界技术的差异化路径,实际选取需结合应用场景与供应链稳定性。

GPU利用率与模型算力利用率

〖壹〗、GPU利用率主要衡量的是GPU核心在计算任务中的活跃程度,而模型算力利用率(MFU)则是用来衡量大模型训练时GPU的实际使用效率。GPU利用率 GPU利用率是指GPU核心在执行计算任务时的占用情况。由于GPU是一个多核处理器,包含许多可以并行计算的小核心,因此只要有一个核心在持续计算,GPU利用率就会显示为100%。

〖贰〗、GPU利用率与模型算力利用率(MFU)GPU利用率:GPU利用率是衡量GPU核心在计算或工作时的活跃程度。由于GPU是一个多核处理器,包含许多小的独立核心,这些核心可以并行计算。因此,只要有一个核心在持续计算,GPU利用率就会显示为100%,即使其他核心处于空闲状态。

〖叁〗、算力利用率测试:通过编写代码(如使用pytorch的mm算子),我们可以测试不同矩阵形状的算力利用率。通常,随着矩阵维度的增大,算力利用率会越来越高。综上所述,大模型GPU算力卡的算力计算方法和利用率是衡量其性能的重要指标。

好了,文章到这里就结束啦,如果本次分享的算力mfu是什么意思和算力m和t问题对您有所帮助,还望关注下本站哦!