极智算总结:

- 大模型GPU算力卡汇总

- 百度昆仑芯片性能是T4的3倍?如何在服务器市场发挥作用?

- T4高效配置实战解析

- 华为升腾和百度昆仑芯对比

- gpu3090、t〖肆〗、teslap100、tpuv3-8之间是几倍的算力关系?

- 一张t4卡算力多少t

大模型GPU算力卡汇总

GB200fp16 Tensor Cores算力:极高,由Grace CPU和两个Blackwell tensor core GPU组成。架构:Blackwell 显存:大容量,支持高效的数据处理和模型训练。算力卡性能评估 在评估一个算力卡的性能时,主要关注其fp16 Tensor Cores算力,因为这是大模型训练和推理中常用的数制。

算力利用率测试:通过编写代码(如使用pytorch的mm算子),我们可以测试不同矩阵形状的算力利用率。通常,随着矩阵维度的增大,算力利用率会越来越高。综上所述,大模型GPU算力卡的算力计算方法和利用率是衡量其性能的重要指标。

H20系列GPU针对大模型场景进行了优化设计,通过优化显存和P2P带宽,提升了算力利用率,并支持2T RDMA扩展,实现了集群线性加速。同时,H20还支持FP8算法创新,进一步提升了性能。算力利用率提升:H20得益于HBM3容量和带宽升级,虽然标称算力降低,但实际利用率大幅提升,FP16算力利用率高达72%。

单片算力:国产GPU在单片算力上尚未达到世界领先水平。例如,华为升腾在fp16精度上接近A100,但不支持364精度,可能会存在精度损失。壁仞科技的单卡支持fp32精度,算力接近H100,但也不支持64精度。多芯片集群能力:大模型训练需要多卡集群能力,且要保证运算效率。

总结:RTX 4090就像经济适用男一样,虽然不一定拥有最顶级的配置,但胜在性价比高,能够满足大部分人的需求。H100:隐形富豪的象征 性能卓越:H100的单卡算力是A100的两倍多,集群算力更是A100的6倍多。同时,它配备了80G HBM3显存,支持多卡NVLink互联,可以组成高达160G的显存池子。

首个国产全功能GPU的万卡集群来了,由“中国英伟达”摩尔线程出品。这个集结了超过10000张高性能GPU的超复杂工程,总算力超万P,专为万亿参数级别的复杂大模型训练而设计。其特点不仅在于规模庞大,还包括:有效计算效率(MFU)高:目标比较高达60%,可达到世界水平。

百度昆仑芯片性能是T4的3倍?如何在服务器市场发挥作用?

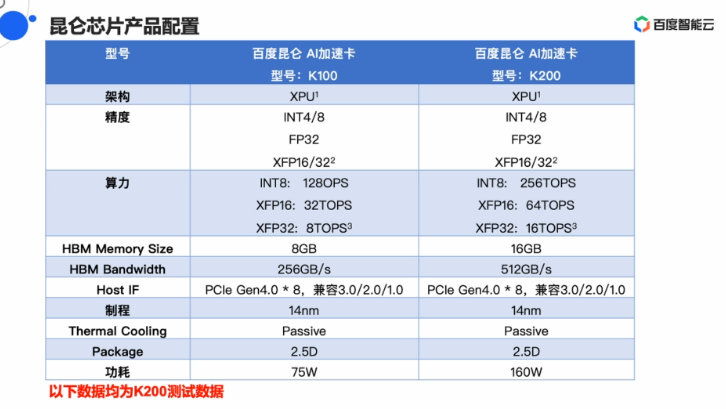

〖壹〗、是的,百度昆仑芯片K200在GemmInt8的Benchmark测试中性能是英特尔T4 GPU的三倍。昆仑芯片在服务器市场主要通过以下几个方面发挥作用:高性能AI推理:昆仑芯片定位为通用AI芯片,拥有高性能的计算单元和内存带宽,特别适用于AI推理任务。

〖贰〗、在性能对比测试中,K200在语音模型Bert/Ernie和图像分割YOLOV3算法中表现出色,且在线上性能数据方面,稳定性优于T4,延迟也有所降低。近来,百度已通过百度云以定向邀请的方式提供K200的AI算力,未来将根据用户反馈进一步扩大服务范围。

〖叁〗、性能与算力 华为升腾:升腾910B的FP16算力达到320 TFLOPS,功耗为310W。在混合精度优化场景下,其推理效率接近英伟达A100,但在通用场景下,A100的生态适配更优。百度昆仑芯:昆仑芯K200的INT8算力高达640 TOPS,是英伟达T4(130 TOPS)的9倍。P800型号则支持8bit推理,吞吐量超过A800 20%。

〖肆〗、在实际应用中,百度昆仑展现出了卓越的性能。在微型基准测试中,昆仑在int8中实现了204TOPS,在int16中实现了49TOPS,分别是设计峰值性能的88%和85%,并且在int8和int16中分别以76倍和13倍的改进优于NVIDIA T4。在百度搜索引擎服务中,昆仑也表现出了高度灵活性和性能。

〖伍〗、总结 百度昆仑和华为NPU都是针对智能计算领域推出的高性能处理器。百度昆仑以昆仑芯XPU架构为核心,提供了全栈的软件工具和丰富的产品线,适用于多种AI应用场景。而华为NPU则基于DaVinci架构,不仅在手机芯片中得到了广泛应用,还推出了独立的NPU系列用于推理和训练场景。

〖陆〗、在基准测试中,昆仑芯片在int8和int16中的性能分别以76倍和13倍的改进优于NVIDIA T4。在YOLOv3中,昆仑芯片以高吞吐量支持卷积运算;在BERT中,以高吞吐量支持矩阵乘法运算。在百度搜索引擎服务中,昆仑芯片的吞吐量提高了7到8倍。

T4高效配置实战解析

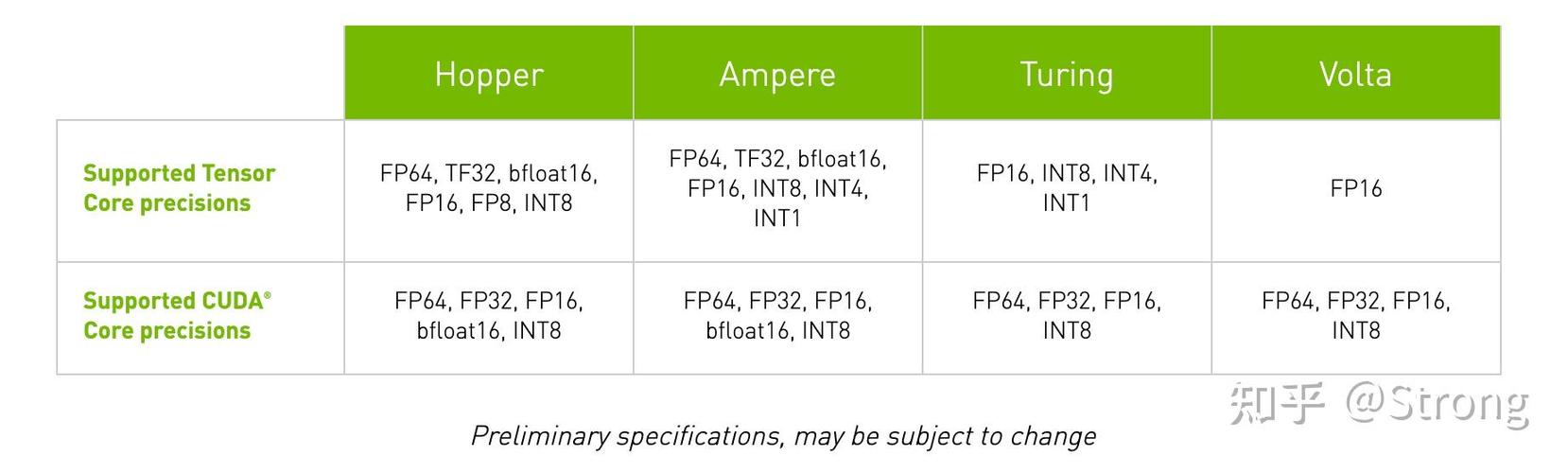

T4高效配置实战解析 T4计算卡高效配置的核心要素 T4计算卡的高效配置需系统性整合硬件选型、驱动优化与软件生态适配。其核心在于深度理解T4的架构特性,并基于这些特性进行针对性的配置优化。T4基于Turing架构,搭载2560个CUDA核心与320个Tensor Core,结合16GB GDDR6显存,为AI推理任务提供了强大的硬件基础。

T4通过动态分配机制实现FP3FP16及INT8混合精度运算,显著提升深度学习模型的推理效率。此外,T4采用4组GPC(Graphics Processing Cluster)结构,每组包含2个TPC(Texture Processing Cluster),结合8GB GDDR6显存与256位总线带宽,形成高吞吐量计算通路。

内政建设与资源准备:主要资源包括食物、木材、石材、铁矿和金币。解锁T4兵种需要海量的资源,因此提前扩大资源产出及储备是必须的。详细步骤解析 主堡升级至25级 每次升级主堡都有严格的前置建筑条件,比如农田、伐木场等资源建筑和仓库、兵营等军事建筑,所以必须平衡发展。

华为升腾和百度昆仑芯对比

〖壹〗、华为升腾和百度昆仑芯各有优势,具体对比如下:性能与算力 华为升腾:升腾910B的FP16算力达到320 TFLOPS,功耗为310W。在混合精度优化场景下,其推理效率接近英伟达A100,但在通用场景下,A100的生态适配更优。百度昆仑芯:昆仑芯K200的INT8算力高达640 TOPS,是英伟达T4(130 TOPS)的9倍。

〖贰〗、升腾和昆仑芯都是在人工智能计算领域有着重要地位的产品,它们各有特点。升腾在华为强大的技术研发体系支撑下,有着较为完善的生态布局。其在一些特定的华为自有应用场景中能很好地适配,发挥出高效能。昆仑芯则凭借自身的技术优势,在性能表现上也较为突出,在市场上也有一定的份额和用户群体。

〖叁〗、选取升腾还是昆仑芯更划算,取决于多种因素。不同场景下二者各有优劣。升腾是华为推出的人工智能计算产品线,具有强大的计算能力和丰富的软件生态。其硬件性能在一些深度学习任务中表现出色,并且华为围绕升腾构建了较为完善的产业体系,能提供从芯片到应用的一站式解决方案。

〖肆〗、升腾910:据华为官方介绍,升腾910是近来全球AI单芯片计算密度最大的芯片。这一卓越性能使得升腾910在处理复杂AI任务时具有极高的效率和准确性。此外,升腾910还支持多种AI算法和模型,为开发者提供了更加灵活和高效的开发平台。

〖伍〗、升腾910:算力特点:作为华为的全栈全场景人工智能芯片,升腾910在算力上表现出色,是算力最强的AI处理器之一。思元370:算力特点:寒武纪的思元370作为第三代云端AI芯片,提供了强大的计算能力,适用于云端大规模数据处理。

〖陆〗、. 百度昆仑芯 昆仑芯3代在电磁场仿真领域突破,国家电网特高压工程全面采用其AI预测系统。这些企业的共同特点是:- 拥有自主可控的物理计算硬件 - 在垂直领域已实现商业化落地 - 获得国家级科研项目支持 - 研发投入占比超营收15 需注意物理AI仍处早期阶段,技术路线可能面临迭代风险。

gpu3090、t〖肆〗、teslap100、tpuv3-8之间是几倍的算力关系?

〖壹〗、NVIDIA的GPU3090、T4和Tesla P100在不同精度数据类型条件下的比较高理论算力值可以通过比较具体数值来理解它们之间的算力关系。GPU3090、T4和Tesla P100分别代表了NVIDIA不同架构的GPU产品。TPU与GPU在架构上存在显著差异。GPU实质上是一个处理器,其设计适合执行图形和并行计算任务。

一张t4卡算力多少t

〖壹〗、t。T4采用了最新的Turing架构,单卡提供1TFLOPS的单精浮点计算能力和65TFLOPS的混合精度(FP16,FP32)矩阵计算能力,一张t4卡算力75t,TeslaT4是一款独特的GPU产品,专为AI推理工作负载。

〖贰〗、T4卡GN6i:配备4核CPU和15G内存,比较高可搭载4张NVIDIA T4-16G卡,费用为16900元/月。P4卡GN5i:配备2核CPU和8G内存,比较高可搭载2张NVIDIA P4-8G卡,费用为23900元/月。P100卡GN5:配备4核CPU和30G内存,比较高可搭载8张NVIDIA P100-16G卡,费用为19050元/月。

〖叁〗、T4 fp16 Tensor Cores算力:适中,适合推理和一般数据处理。架构:Turing 显存:满足一般深度学习需求。RTX-8000 fp16 Tensor Cores算力:高性能,适合大规模数据处理和模型训练。架构:Turing 显存:大容量,支持高效的数据吞吐。Volta系列 V100fp16 Tensor Cores算力:高性能,适合大规模数据处理。

〖肆〗、通过采用NVIDIA T4 GPU,VIVO显著加速了推荐系统的部署,解决了CPU算力和性能瓶颈问题。在推荐业务中,单张T4 GPU推理卡的性能超过6台78核CPU服务器,成本节省约75%。

〖伍〗、CUDA Cores与Tensor Cores:每个SM包含64个CUDA Cores和8个Tensor Cores。CUDA Cores负责传统的并行计算任务,而Tensor Cores则专门优化张量运算,如矩阵乘法和加法,这对于深度学习等应用至关重要。

关于算力T4,算力etf的介绍到此结束,希望对大家有所帮助。