极智算总结:

- 常见的关于GPU云服务器和GPU物理服务器的区别(值得收藏)

- gpu服务器与普通服务器的硬件区别

- gpu服务器和普通服务器有什么区别

- (转载)一文看懂英伟达A100、H100、A800、H800、H20

- gpu服务器和普通服务器有什么区别?

- GPU云服务器厂商综合评测与排名(2025年更新版)

- GPU服务器与CPU服务器的区别,如何选取GPU服务器

- GPU服务器和普通服务器有什么区别?

常见的关于GPU云服务器和GPU物理服务器的区别(值得收藏)

稳定性 GPU云服务器:突破了传统GPU服务器的限制,具有高并行、高吞吐、低时延的极致性能。云服务器提供商通常会提供稳定的基础设施和运维支持,确保服务的稳定性和数据的高可用性。GPU物理服务器:稳定性需要用户自行部署和保障。

GPU 云服务器(GPU Cloud Computing,GPU)是提供 GPU 算力的弹性计算服务。它具有超强的并行计算能力,作为 IaaS(Infrastructure as a Service,基础设施即服务)层的尖兵利器,服务于深度学习训练、科学计算、图形图像处理、视频编解码等多种高性能计算场景。

云GPU服务器,即基于云计算技术提供的,配备有图形处理器(GPU)的虚拟或物理服务器。这种服务器能够借助云厂商的强大资本力,让用户免去购买GPU的高额成本,同时依然能够使用到计算能力强大但颇为昂贵的GPU,如A100等。这就相当于用户只花费了较少的成本,却享受到了高性能的计算服务。

通用服务器:低配的一般为500-550w,还有800W、1000W、1200W和1600W,通常超过2KW的不多。GPU服务器在功耗上明显高于通用服务器。单台服务器费用 GPU服务器:费用通常是通用服务器的2-3倍,实际出货一台轻松过十万,大几十万到上百万也是正常,主要取决于GPU卡的费用。

GPU云服务器产品优势 高性能计算:GPU云服务器具备强大的浮点计算能力,能够处理大规模的数据集和复杂的计算任务,显著提升AI模型的训练速度和推理效率。弹性可扩展:用户可以根据实际需求,灵活调整GPU云服务器的配置和规模,满足不同阶段和场景下的计算需求。

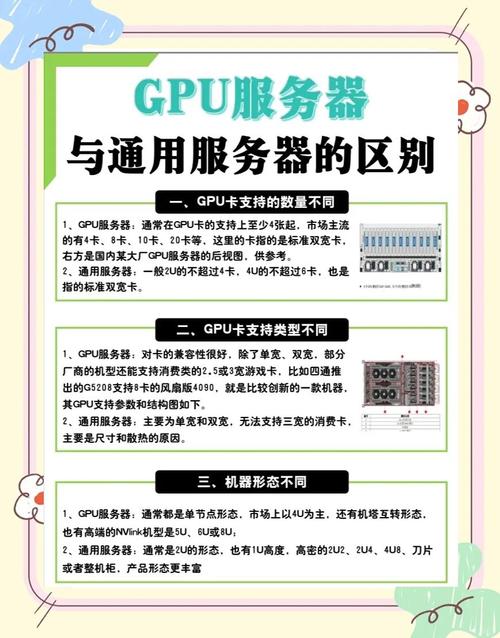

gpu服务器与普通服务器的硬件区别

GPU服务器和普通服务器之间的主要区别在于它们所针对的工作负载类型以及为此优化的硬件配置。以下是两者之间的一些关键差异:处理器(CPU)普通服务器:通常配备多核高性能中央处理器(CPU),这些CPU适用于处理大量并发请求或执行复杂的计算任务,如数据库查询、Web服务等。

普通服务器:计算能力相对较弱,适用于一般的计算任务,但无法胜任大规模并行计算或高性能计算任务。硬件配置 GPU服务器:通常配备高性能的GPU显卡,以及与之匹配的CPU、内存和存储设备,以满足高性能计算需求。普通服务器:硬件配置相对简单,主要关注CPU、内存和存储等基本配置,以满足一般应用需求。

普通服务器:相对较低的硬件成本,适用于小规模的计算需求。普通服务器的硬件配置相对简单,因此其成本也相对较低。显卡服务器(GPU服务器):由于GPU的高性能和计算能力,其硬件成本通常较高。此外,GPU服务器的配置也相对复杂,需要更多的硬件资源来支持其高性能的计算任务。

GPU服务器:由于配备了高性能的GPU和相关的硬件资源,GPU服务器的费用通常较高。普通服务器:费用相对较为亲民,适合预算有限的用户或企业。稳定性与可靠性:GPU服务器:通常设计为能够长时间稳定运行,以满足高性能计算任务的需求。它们通常具有更高的可靠性和稳定性要求。

普通服务器:功耗相对较低,硬件成本也较为亲民,适合预算有限的用户。GPU服务器:功耗较高,硬件成本昂贵,但性能卓越,适合对性能要求极高的业务。并行计算能力:普通服务器:并行计算能力有限,处理大量任务时效率较低。GPU服务器:并行计算能力是其核心优势,能同时处理大量任务,数据处理效率极高。

GPU服务器和普通服务器的主要区别在于硬件配置和性能表现。GPU服务器通常配备了专门的图形处理器(GPU),用于加速图像处理和渲染等任务,可以提供更高的计算性能和处理能力。而普通服务器则通常配备普通的CPU和内存,没有专门的图形处理器,性能相对较低。

gpu服务器和普通服务器有什么区别

〖壹〗、GPU服务器和普通服务器的主要区别如下:核心功能与应用场景 GPU服务器:基于GPU构建,主要应用于视频编解码、深度学习、科学计算等多种需要高性能计算的场景。GPU服务器提供快速、稳定、弹性的计算服务,并具备和标准云服务器一致的管理方式。

〖贰〗、显卡服务器(GPU服务器):由于GPU的大规模并行计算特性,其功耗较高。因此,GPU服务器需要更多的电力供应来支持其高性能的计算任务。硬件成本 普通服务器:相对较低的硬件成本,适用于小规模的计算需求。普通服务器的硬件配置相对简单,因此其成本也相对较低。

〖叁〗、GPU服务器:由于配备了高性能的GPU和相关的硬件资源,GPU服务器的费用通常较高。普通服务器:费用相对较为亲民,适合预算有限的用户或企业。稳定性与可靠性:GPU服务器:通常设计为能够长时间稳定运行,以满足高性能计算任务的需求。它们通常具有更高的可靠性和稳定性要求。

〖肆〗、GPU服务器和普通服务器之间的主要区别在于它们所针对的工作负载类型以及为此优化的硬件配置。以下是两者之间的一些关键差异:处理器(CPU)普通服务器:通常配备多核高性能中央处理器(CPU),这些CPU适用于处理大量并发请求或执行复杂的计算任务,如数据库查询、Web服务等。

〖伍〗、通用服务器:哪里都可以用,比如做私有云、分布式存储、管理节点、HPC通用算力节点等等。两者在业务场景定位上有所不同,GPU服务器更专注于高性能计算和图形处理等领域,而通用服务器则更为通用,适用于多种场景。

〖陆〗、显卡服务器与普通服务器的区别主要包括以下几点:硬件配置与性能:普通服务器:主要依靠中央处理器进行单线程或小规模并行计算,性能适用于常规任务。GPU服务器:额外搭载了强大的图形处理器,拥有数千个并行计算核心,能同时处理大规模数据和图形密集任务,计算性能远超普通服务器。

(转载)一文看懂英伟达A100、H100、A800、H800、H20

H100在Transformer-based AI任务(如GPT)中比A100快6倍,而推理吞吐量也更高。小结 AI训练:需要高带宽 + 高精度计算,推荐H100/A100及其变种。AI推理:需要低延迟 + 高吞吐量,推荐H100/H800/H20。H100在Transformer模型训练和推理吞吐量方面遥遥领先。A100/A800仍然是中等预算下的优秀选取。

对于AI训练任务,建议选取H100或A100系列GPU,它们提供强大的计算能力和高带宽内存,适合处理大规模数据集和复杂模型。推理场景 对于AI推理任务,A800或H800系列GPU是更好的选取。它们提供稳定的计算能力和适中的内存容量与带宽,满足大多数推理任务的需求。

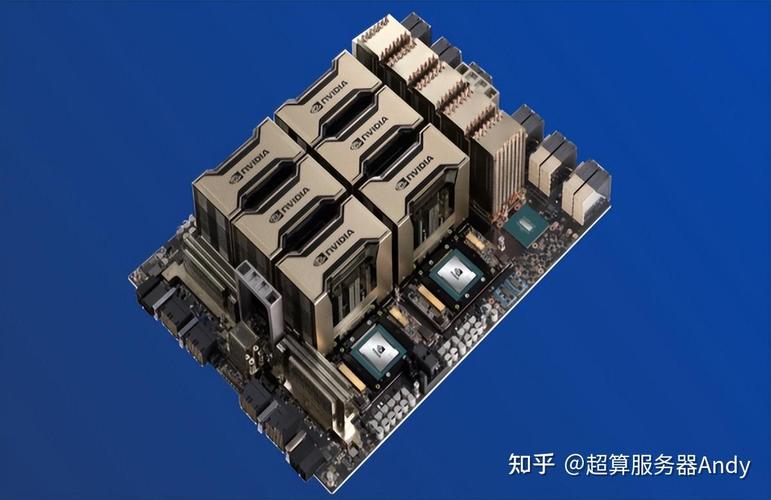

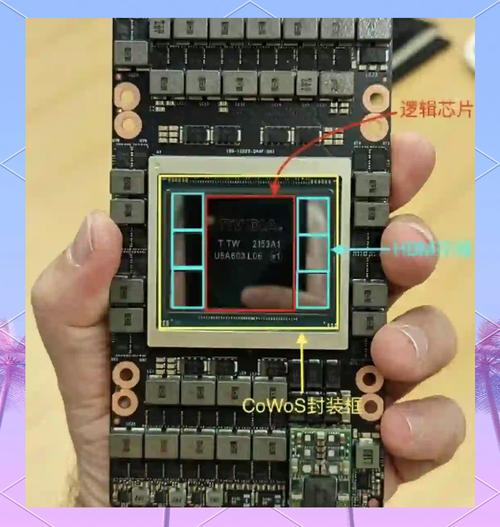

A100:拥有40GB显存,提供PCIE版和SXM版两种形式。A100是英伟达上一代的高性能GPU,广泛应用于AI计算、高性能计算等领域。A800:作为A100的替代产品,A800同样拥有80GB显存(与后续提到的H100、H800的某版本相同),也提供PCIE版和SXM版。

A100和A800:均属于Tesla系列中的高性能计算(HPC)和人工智能(AI)加速型号。A100是NVIDIA推出的旗舰级AI加速GPU,而A800则是针对中国市场推出的特供版(低配版)。H100和H800:同样属于Tesla系列,但更侧重于大模型训练和推理。

本文将对比英伟达A100、A800、H100、H800各版本之间的区别。首先,A100和A800都支持40GB和80GB显存,其中A800的显存传输速率由A100的600GB/s降至400GB/s,其它参数基本一致。H100和H800版本均支持80GB显存,其中H800的芯片间数据传输速度为H100的一半。

gpu服务器和普通服务器有什么区别?

GPU服务器和普通服务器的主要区别如下:核心功能与应用场景 GPU服务器:基于GPU构建,主要应用于视频编解码、深度学习、科学计算等多种需要高性能计算的场景。GPU服务器提供快速、稳定、弹性的计算服务,并具备和标准云服务器一致的管理方式。

显卡服务器(GPU服务器):由于GPU的大规模并行计算特性,其功耗较高。因此,GPU服务器需要更多的电力供应来支持其高性能的计算任务。硬件成本 普通服务器:相对较低的硬件成本,适用于小规模的计算需求。普通服务器的硬件配置相对简单,因此其成本也相对较低。

GPU服务器:由于配备了高性能的GPU和相关的硬件资源,GPU服务器的费用通常较高。普通服务器:费用相对较为亲民,适合预算有限的用户或企业。稳定性与可靠性:GPU服务器:通常设计为能够长时间稳定运行,以满足高性能计算任务的需求。它们通常具有更高的可靠性和稳定性要求。

GPU服务器和普通服务器之间的主要区别在于它们所针对的工作负载类型以及为此优化的硬件配置。以下是两者之间的一些关键差异:处理器(CPU)普通服务器:通常配备多核高性能中央处理器(CPU),这些CPU适用于处理大量并发请求或执行复杂的计算任务,如数据库查询、Web服务等。

通用服务器:哪里都可以用,比如做私有云、分布式存储、管理节点、HPC通用算力节点等等。两者在业务场景定位上有所不同,GPU服务器更专注于高性能计算和图形处理等领域,而通用服务器则更为通用,适用于多种场景。

GPU云服务器厂商综合评测与排名(2025年更新版)

华为云:国产化方案生态逐步完善,但与世界主流框架的兼容性仍有提升空间。腾讯云:生态支持相对较弱,主要依赖自身平台资源。 安全性(10%)优刻得(UCloud):提供数据加密、合规认证、容灾备份等全方位安全保障,符合医疗等行业高标准要求。阿里云:安全性较高,但需额外购买安全合规模块。

京东云:排名第五,京东云凭借其在电商场景优化和定制化存储方案方面的优势,为电商行业提供了高效的GPU云服务器服务。其支持的NVIDIA A10/A40等GPU型号,在性能和性价比上均表现出色。电信云:排名第六,电信云依托其网络带宽优势和丰富的政企客户服务经验,在GPU云服务器领域也占据了一定的市场份额。

华为升腾生态伙伴:中科曙光液冷AI服务器市占率超30%,2024年升腾服务器订单增长120%,在智慧城市和自动驾驶领域应用落地成果显著。神州数码是华为升腾服务器核心分销商,2025年Q2升腾业务收入占比达60%,受益于政务云订单和国产算力采购政策。

好的gpu云服务器有腾讯云服务器,阿里云服务器,优刻得,华为云,百度云服务器。腾讯云服务器 腾讯云服务器依托腾讯云旗下的产品,稳定性和口碑毋庸置疑,而且这几年的力度也是比较诚意的,比如对于新客和老客的优惠和续费的力度还是有一些的。

摩尔线程:摩尔线程是一家专注于GPU芯片设计的创新型企业,其产品广泛应用于图形渲染、人工智能等领域。国产DPU厂商:芯启源:芯启源是一家专注于DPU芯片研发的公司,其产品具有高性能、低延迟和可编程的特点。浪潮:浪潮作为领先的服务器厂商,也推出了自己的DPU产品,旨在提升服务器的性能和效率。

Featurize提供10元注册代金券,而恒源云则新用户注册有额外10代金券,学生用户可享受5折优惠,并且拥有多种活动和奖励,如免费存储50GB等。恒源云还特别提供了中文界面的notebook,对于使用习惯中文界面的用户来说更为便捷。

GPU服务器与CPU服务器的区别,如何选取GPU服务器

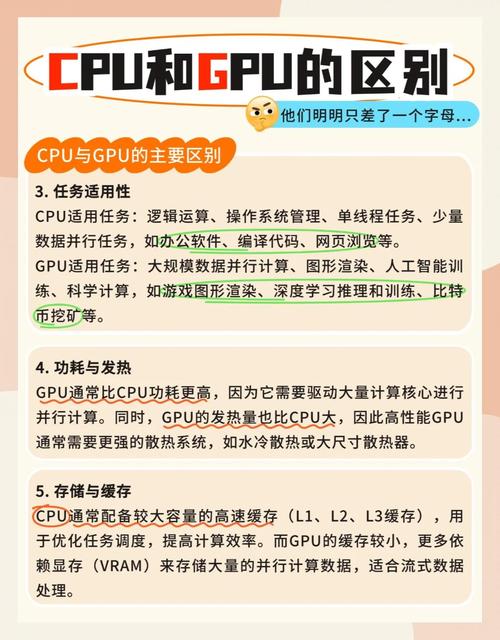

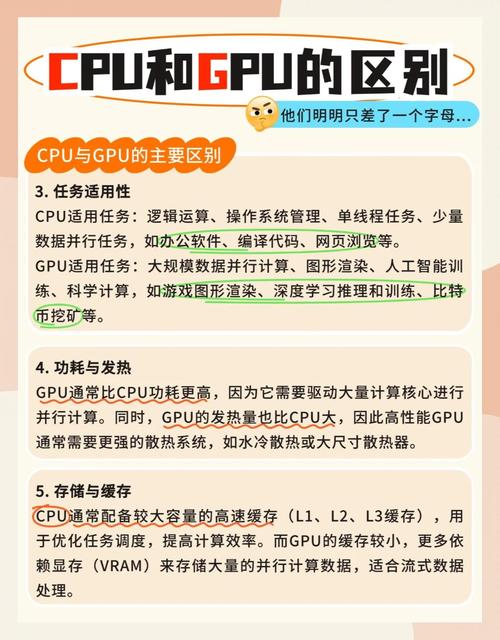

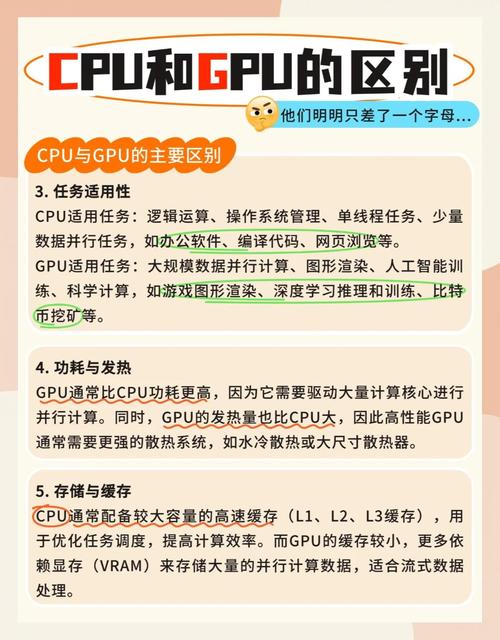

GPU架构以大量小而快的逻辑单元,以并行方式处理任务,特别适合重复计算。CPU则擅长处理复杂逻辑和控制任务。GPU在高强度并行计算中性能优于CPU。GPU服务器应用场景 GPU服务器适用于视频编解码、深度学习、科学计算等场景。提供高计算性能,有效提高计算效率与竞争力。

综上所述,GPU服务器与CPU服务器在处理任务类型和性能上存在显著差异。在选取GPU服务器时,应综合考虑业务需求、性能指标、服务器类型、特殊要求以及综合评估等因素,以确保所选服务器能够满足特定应用场景的需求。

GPU服务器与CPU服务器的主要区别在于它们的计算能力和适用场景。以下是两者的区别及如何选取GPU服务器的详细解GPU服务器与CPU服务器的区别 计算能力:CPU服务器:CPU擅长处理复杂的逻辑运算和程序流程控制,适合执行各种通用任务。

GPU服务器和普通服务器有什么区别?

〖壹〗、GPU服务器和普通服务器的主要区别如下:核心功能与应用场景 GPU服务器:基于GPU构建,主要应用于视频编解码、深度学习、科学计算等多种需要高性能计算的场景。GPU服务器提供快速、稳定、弹性的计算服务,并具备和标准云服务器一致的管理方式。

〖贰〗、显卡服务器(GPU服务器):由于GPU的大规模并行计算特性,其功耗较高。因此,GPU服务器需要更多的电力供应来支持其高性能的计算任务。硬件成本 普通服务器:相对较低的硬件成本,适用于小规模的计算需求。普通服务器的硬件配置相对简单,因此其成本也相对较低。

〖叁〗、GPU服务器:由于配备了高性能的GPU和相关的硬件资源,GPU服务器的费用通常较高。普通服务器:费用相对较为亲民,适合预算有限的用户或企业。稳定性与可靠性:GPU服务器:通常设计为能够长时间稳定运行,以满足高性能计算任务的需求。它们通常具有更高的可靠性和稳定性要求。

〖肆〗、通用服务器:哪里都可以用,比如做私有云、分布式存储、管理节点、HPC通用算力节点等等。两者在业务场景定位上有所不同,GPU服务器更专注于高性能计算和图形处理等领域,而通用服务器则更为通用,适用于多种场景。

〖伍〗、GPU服务器和普通服务器之间的主要区别在于它们所针对的工作负载类型以及为此优化的硬件配置。以下是两者之间的一些关键差异:处理器(CPU)普通服务器:通常配备多核高性能中央处理器(CPU),这些CPU适用于处理大量并发请求或执行复杂的计算任务,如数据库查询、Web服务等。

〖陆〗、显卡服务器与普通服务器的区别主要包括以下几点:硬件配置与性能:普通服务器:主要依靠中央处理器进行单线程或小规模并行计算,性能适用于常规任务。GPU服务器:额外搭载了强大的图形处理器,拥有数千个并行计算核心,能同时处理大规模数据和图形密集任务,计算性能远超普通服务器。

END,本文到此结束,如果可以帮助到大家,还望关注本站哦!