极智算总结:

- 一文让你彻底了解算力到底是如何计算出来的——算力的计算方法(CPU和G...

- 计算机系统算力怎么算出来的

- 搞懂算力到底怎么算?

- 如何计算SOC芯片中CPU的算力

- 算力怎么计算

- 算力计算有哪些方法?算力计算适用方法

- 代码中的算力是什么意思,怎么算

- 算力和云计算的区别

- 算力单位怎么换算?

- 挖矿算力怎么计算

一文让你彻底了解算力到底是如何计算出来的——算力的计算方法(CPU和G...

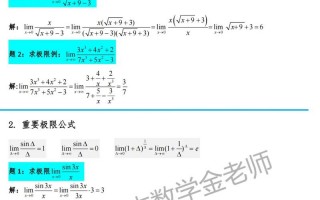

CPU的算力通常用每秒执行的浮点运算次数(FLOPS,Floating Point Operations Per Second)来衡量。算力的计算可以通过了解CPU的核心数、每个核心的时钟频率以及每个时钟周期能够执行的浮点运算次数来进行。

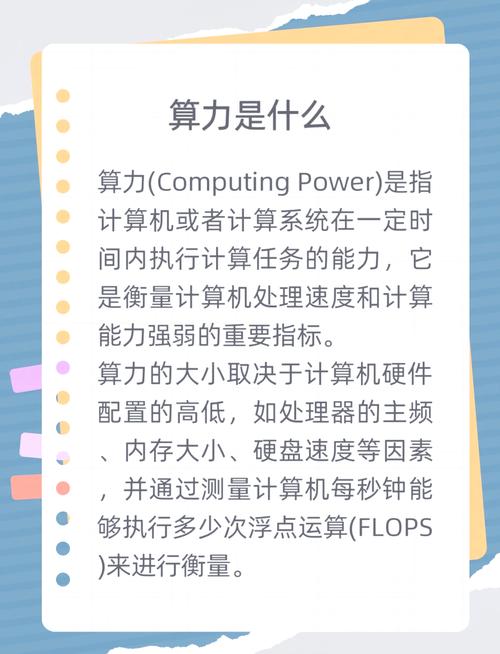

CPU和GPU的算力主要通过每秒执行的浮点运算次数来衡量,具体计算涉及核心数量、主频以及单周期浮点计算能力。以下是详细解释: 算力的衡量标准: 算力主要通过FLOPS来衡量。它反映了计算机每秒能执行的浮点运算数量,是衡量计算机处理速度和计算能力的重要指标。

FLOPS的定义: FLOPS是Floating Point Operations Per Second的缩写,即每秒浮点运算次数,是衡量计算机、CPU或GPU处理小数计算效率的重要指标。 CPU的算力计算: CPU的算力主要由其核心数、频率以及浮点计算能力共同决定。

代码中的“算力”指处理器(CPU/GPU)的计算能力,即设备每秒能完成的浮点运算次数(FLOPS),是衡量计算性能的核心指标。

CPU和GPU的算力计算涉及多个因素,包括核心数量、主频和单周期浮点计算能力。以Intel Cascade Lake架构的Xeon Platinum 8280为例,该CPU在理论峰值双精度浮点性能上可达4192 TFLOPS;而NVIDIA Volta架构的V100GPU则有833 TFLOPS的理论峰值双精度浮点性能。

计算机系统算力怎么算出来的

计算机系统算力的计算方式因硬件类型和应用场景不同而有所差异,常见方法包括峰值计算法和CUDA核心计算法,区块链领域则以哈希率衡量算力。以下从不同维度展开说明:GPU算力的核心计算方法GPU算力通常以浮点运算能力(FLOPS)为单位,代表每秒可执行的浮点运算次数。

在一些需要大规模并行计算的任务中,如深度学习训练,GPU的显存大小、带宽以及计算核心数量等都决定了其算力。大显存能存储更多数据,高带宽可快速传输数据,众多计算核心则能高效执行计算任务。再者,内存的读写速度也会影响算力。快速的内存能让数据更及时地被CPU和GPU读取处理,避免因内存瓶颈降低算力。

算力主要通过计算设备的核心性能指标来评估。算力(Computational Power),即计算能力,是计算机系统或设备执行数值计算和处理任务的核心能力。以下是对算力计算方式的详细解释:CPU算力 CPU的算力通常用每秒执行的浮点运算次数(FLOPS,Floating Point Operations Per Second)来衡量。

搞懂算力到底怎么算?

算力主要通过计算设备的核心性能指标来评估。算力(Computational Power),即计算能力,是计算机系统或设备执行数值计算和处理任务的核心能力。以下是对算力计算方式的详细解释:CPU算力 CPU的算力通常用每秒执行的浮点运算次数(FLOPS,Floating Point Operations Per Second)来衡量。

CPU算力的提升主要依靠时钟频率和内核数。时钟频率的高低在很大程度上反映了CPU速度的快慢,而内核数是CPU内部可以执行指令的单个处理单元的数量。通常来说,时钟频率越大、内核数越多,CPU的性能越强,但这也带来了能耗过高、发热过大的问题。

算力:AI的“体力”。训练复杂的AI模型需要大量的计算能力,如训练GPT-4需要上万块GPU。AI在日常生活中的应用场景 AI已经渗透到我们生活的方方面面,以下是几个典型的应用场景:医疗:AI可以通过分析肺部CT片,在0.5秒内揪出癌细胞,这得益于卷积神经网络(CNN)的应用。

支持企业及组织使用天津人工智能计算中心算力服务,比较高按实际购买金额的50%给予算力“服务券”,单个主体每年不超过30万元。河北省廊坊市 每年发放不超过1000万元算力券,对落户企业、承接重大项目单位、使用本地算力服务平台的主体按不同标准奖励,每个单位每年不超过100万元。

BTC/ETH挖矿(PoW算法):BTC/ETH等加密货币主要基于PoW(Proof of Work,工作量证明)算法来实现共识机制。该原理下的挖矿过程,是计算机通过穷举法不断寻找合适的Nonce值,以计算出满足特定条件的Hash值。这一过程消耗了大量的算力和电力资源,且存在算力中心化和能源浪费的问题。

如何计算SOC芯片中CPU的算力

CPU的DMIPS算力计算公式为:算力DMIPS = 内核的数量 × 主频 × DMIPS/MHz。内核数量:指CPU中处理核心的数量,多核心能够并行处理更多任务,提高整体算力。主频:CPU的工作频率,单位为MHz或GHz,表示CPU每秒能够执行的时钟周期数。主频越高,CPU在单位时间内能够执行的指令数越多。

CPU算力= CPU核心数 × 主频× DMIPS/MHz其中,CPU核心数是指芯片中CPU的核心数量;主频是指CPU的工作频率,单位为MHz;DMIPS/MHz是指每兆赫兹主频下CPU的DMIPS性能值,这个值通常由芯片制造商提供或可以通过测试获得。

在实际项目中,通常使用DMIPS来衡量CPU的性能,计算公式为:CPU核心数 * 主频 * DMIPS/MHz。以一款六核A55架构,主频6GHz的芯片为例,其DMIPS性能为7,那么算力DMIPS值为6 * 1660MHz * 7DMIPS/MHz,等于31374 DMIPS。

算力怎么计算

GPU算力的核心计算方法GPU算力通常以浮点运算能力(FLOPS)为单位,代表每秒可执行的浮点运算次数。

通用计算场景(以FLOPS为单位):使用基础公式“算力(FLOPS)= 核心数量 × 时钟频率(GHz)× 每时钟周期浮点运算次数”。核心数量指CPU物理核心数、GPU流处理器或SM单元数;时钟频率是处理器每秒运行周期数,单位为GHz;每周期运算次数由架构决定。

算力主要通过计算设备的核心性能指标来评估。算力(Computational Power),即计算能力,是计算机系统或设备执行数值计算和处理任务的核心能力。以下是对算力计算方式的详细解释:CPU算力 CPU的算力通常用每秒执行的浮点运算次数(FLOPS,Floating Point Operations Per Second)来衡量。

GPU的算力计算相对复杂,但核心思路是通过核心数量、频率和每周期计算能力来确定。主要有两种方法:峰值算力法和CUDA核心算力法。

算力计算有哪些方法?算力计算适用方法

分布式计算:分布式计算是一种分布式计算技术,它可以将一个复杂的计算任务分解成多个小任务,然后将这些小任务分发到多台计算机上进行计算,最后将计算结果汇总,从而达到解决复杂计算问题的目的。

算力计算方式:GPU的算力计算相对复杂,因为它取决于多个因素,包括GPU的架构、核心数、主频、内存带宽等。通常,GPU制造商会提供具体的算力数值,如NVIDIA的GPU通常会提供FP32(32位浮点数)或FP16(16位浮点数)等精度下的算力。

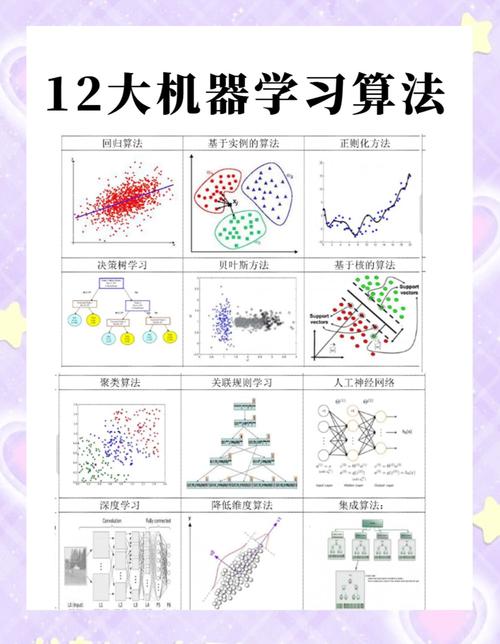

算力计算的方法主要有以下几种:分布式计算:描述:将复杂的计算任务分解成多个小任务,并分发到多台计算机上进行并行计算,最后汇总结果。优势:能够充分利用多台计算机的计算资源,提高计算效率。网格计算:描述:与分布式计算类似,也是将计算任务分解成多个小任务,并分发到多台计算机上。

通用计算场景(以FLOPS为单位):使用基础公式“算力(FLOPS)= 核心数量 × 时钟频率(GHz)× 每时钟周期浮点运算次数”。核心数量指CPU物理核心数、GPU流处理器或SM单元数;时钟频率是处理器每秒运行周期数,单位为GHz;每周期运算次数由架构决定。

DMIPS算力计算公式 CPU的DMIPS算力计算公式为:算力DMIPS = 内核的数量 × 主频 × DMIPS/MHz。内核数量:指CPU中处理核心的数量,多核心能够并行处理更多任务,提高整体算力。主频:CPU的工作频率,单位为MHz或GHz,表示CPU每秒能够执行的时钟周期数。

企业算力使用量可以通过以下公式来计算:算力(TFLOPs)= 核心数量 × 核心频率(GHz) × 每个核心每时钟周期的FLOPs数 / 10^12这个公式较为具体,适用于了解硬件详细参数的情况下进行算力计算。

代码中的算力是什么意思,怎么算

代码中的“算力”指处理器(CPU/GPU)的计算能力,即设备每秒能完成的浮点运算次数(FLOPS),是衡量计算性能的核心指标。

算力是指计算机计算系统执行各种计算任务的能力。它通常通过处理器(CPU、GPU等)的运算速度、效率和并行处理能力来衡量,并不仅仅是“速度”的概念,还涉及计算资源的有效使用和如何在有限的时间内处理复杂的数据和任务。

算力是一个简称,是指专门用来挖掘比特币的的专业计算机,这种专业的计算机被称为矿机。这种计算机的运算能力就叫做算力。比如一台矿机的算力在14T,这就是这台计算机的运算能力。

算力和云计算的区别

算力和云计算在概念、提供方式和应用场景等方面存在明显区别。 概念本质:算力简单来说,是指计算能力,是对数据进行处理、运算的能力大小,像电脑芯片每秒能进行的计算次数就是算力的体现。而云计算是一种基于互联网的计算方式,通过将计算资源、存储资源等整合起来,以服务的形式提供给用户。

云计算强调的是服务模式,注重资源的整合与共享,让用户便捷使用资源;而算力聚焦于计算的能力大小,是硬件性能的体现。云计算可以利用多种算力资源来构建服务体系,算力是支撑云计算运行的基础,二者相互关联又各有侧重 。

关联与差异 关联:云计算可以提供算力资源,这些资源在一定程度上可以支持AI大模型的训练和推理。云计算的灵活性和可扩展性使得它成为AI算力资源的一个重要来源。差异:尽管云计算可以提供算力资源,但AI大模型算力还需要考虑硬件、软件和网络架构等多个层面的综合性能。

与云计算的区别本地算力强调「即时响应」和「隐私保护」,无需依赖网络上传数据到远程服务器。而云计算更侧重大规模数据处理,适合需要海量资源支撑的任务(如视频渲染)。

云计算与算力:云计算的兴起为算力的分布和共享提供了新的可能。通过云计算中心,算力资源得以高效匹配和分配,满足不同用户的需求。这进一步推动了算力的普及和应用。算力时代的挑战与机遇:在算力时代,算力已经从稀缺资源转变为驱动数字经济和社会进步的核心力量。然而,这也带来了新的挑战和机遇。

算力单位怎么换算?

算力单位p和flops换算:1P=1024*1024=1048576G。算力介绍如下:算力是计算机设备或计算/数据中心处理信息的能力,是计算机硬件和软件配合共同执行某种计算需求的能力。算力的英文名是computility。其中的compu-是计算的词根,表达“算”的含义,-utility是效用、实用的意思。

算力单位p和flops的换算关系:1P等于1024乘以1024,即1048576G。关于算力的介绍:算力是计算机设备或计算/数据中心处理信息的能力,它反映了计算机硬件和软件共同满足某种计算需求的能力。算力的英文名为computility,其中compu-代表计算的词根,表达“算”的概念,而-utility则表示效用或实用性。

算力单位常见的有哈希率等。比如,1K算力等于1000算力,1M算力等于1000K算力,也就是1000000算力,1G算力等于1000M算力,即1000000000算力,1T算力等于1000G算力,为1000000000000算力。这些换算关系是基于十进制的。在虚拟货币挖矿中,算力的大小直接影响挖矿的效率和收益。

挖矿算力怎么计算

首先,算力代表的是矿机每秒的运算次数,如达到1次/s,则对应算力为1H。因此知道挖币矿机的运作时间与运算次数即可计算其算力。算力的单位是每千位一变化,最小单位H为1次,1K=1000H,1G=1000K,1T=1000G,1P=1000T,1E=1000P。

明确矿机参数 算力:每台蚂蚁矿机S19 Pro的算力为110T。 功耗:每台矿机的功耗为3250瓦,10台则为35千瓦。 电费成本:假设电费为0.36元每度。计算总算力与全网算力的比例 总算力:10台矿机的总算力为110T * 10 = 1100T。

挖矿算力主要通过矿机每秒的运算次数来计算。以下是关于挖矿算力计算的详细解算力的定义 算力代表的是矿机每秒的运算次数。例如,如果矿机每秒能进行1次运算,则其算力为1H(Hash,哈希值)。算力是衡量矿机性能的重要指标,决定了矿机在挖矿过程中的竞争力。

挖矿算力是指挖矿设备在每秒计算次数,它是挖矿的关键指标。挖矿算力的计算方法是:挖矿设备在每秒计算次数乘以每次计算的数量,即可得出挖矿算力。例如,一台挖矿设备每秒计算1000次,每次计算的数量为100,则该挖矿设备的挖矿算力为100000。

OK,关于算力计算和算力计算器 挖币网的内容到此结束了,希望对大家有所帮助。