极智算总结:

- ai算力芯片有哪些

- 什么是CPU、GPU、NPU、TPU,及算力对比?

- 谷歌tpu为什么没有火

- 最新市场主流“AI芯片”概念梳理

- GPU发展历史,TPU、寒武纪等体系架构及其比较

- 算力基础知识(一)

- 算力新贵横空出世!智算加速卡是什么东西竟能硬刚GPU和TPU!

- 一文看懂CPU、GPU、NPU,TPU,DPU,IPU

ai算力芯片有哪些

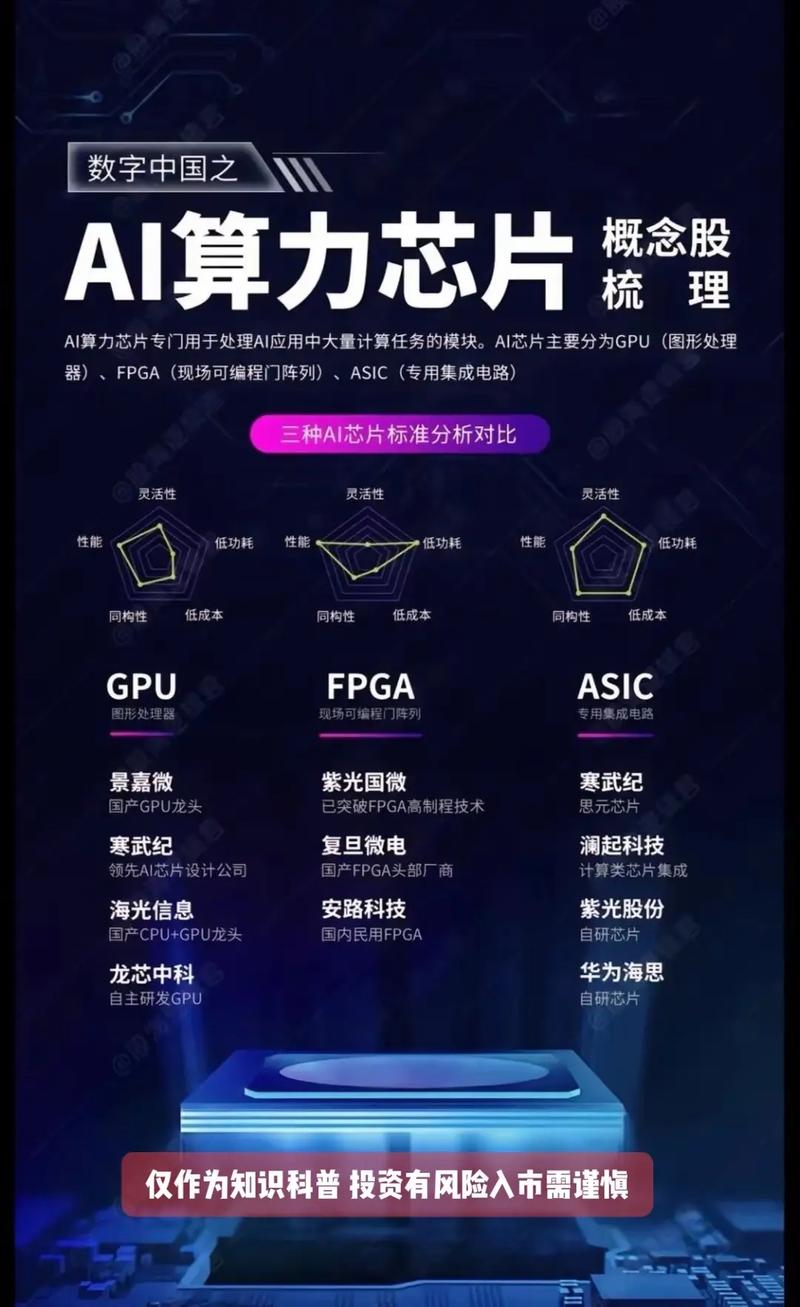

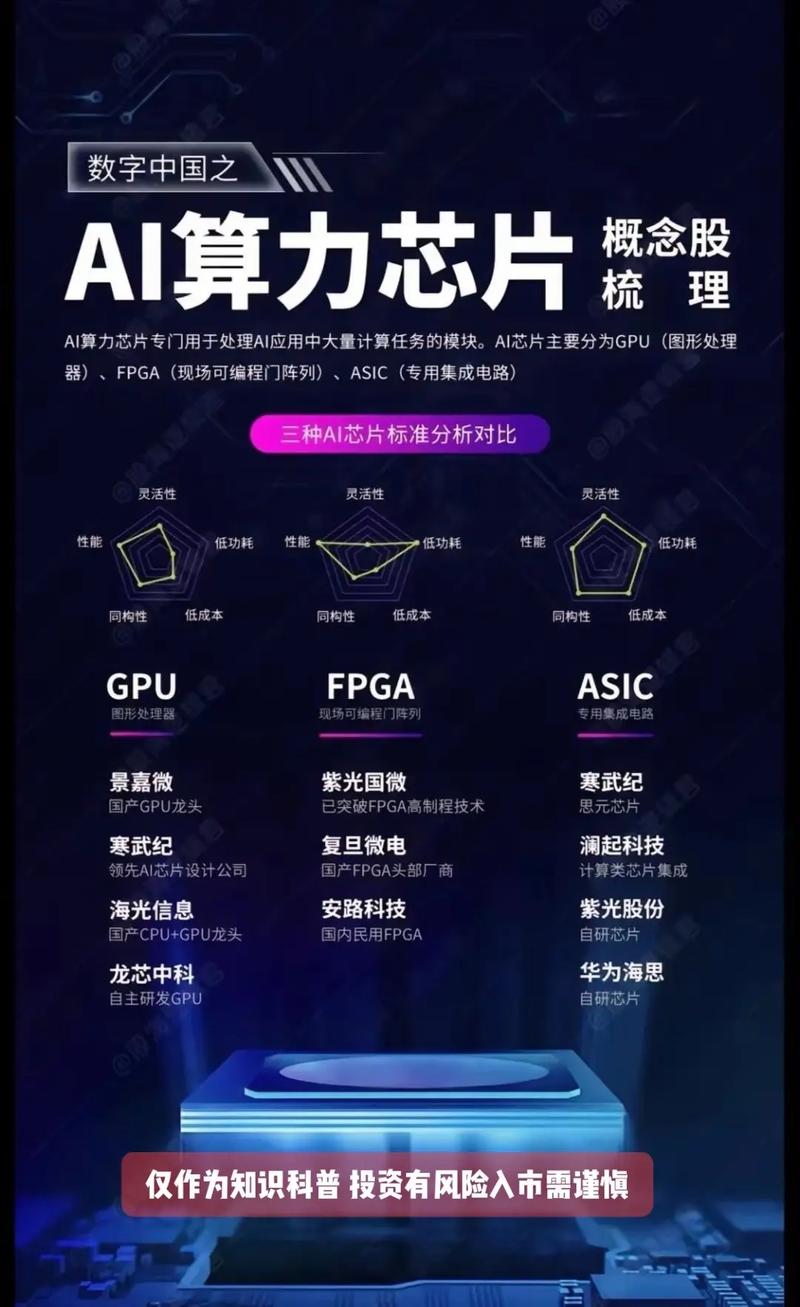

〖壹〗、AI芯片主要包括GPU(图形处理器)、FPGA(现场可编程门阵列)、ASIC(专用集成电路)等。这些芯片在AI领域发挥着重要作用,为AI模型的训练和推理提供强大的算力支持。GPU:最初专用于图形处理制作,后逐渐应用于计算。性能高、通用性好,但功耗较高。FPGA:利用门电路直接运算,速度较快。

〖贰〗、AI国产算力芯片的主要企业及产品包括清微智能、摩尔线程、华为升腾、海光信息、寒武纪,以及壁仞科技、燧原科技、沐曦集成电路等。以下为具体介绍:清微智能:以可重构AI芯片(RPU)为核心技术,其TX81芯片在1000P算力规模下,相比GPU集群具备更强的互联能力和效率优势。

〖叁〗、AI算力芯片主要有以下几种类型:GPU、CPU、FPGA、ASIC,以及进一步细分的TPU、DPU、NPU等。主要类型 GPU(图形处理器):GPU是专为处理复杂图形和计算密集型任务而设计的处理器。在AI领域,GPU因其强大的并行计算能力而被广泛应用于深度学习模型的训练和推理。

〖肆〗、AI算力芯片的龙头股主要有海光信息、龙芯中科、寒武纪、景嘉微等。AI算力芯片与处理器龙头海光信息:它是国内唯一基于x86架构的服务器CPU/DCU龙头。其深算二号性能接近英伟达A100,是国产化替代的核心标的,并且DCU产品全面兼容ROCm GPU计算生态。

〖伍〗、润欣科技较为突出的三款芯片有奇异摩尔的服务器级RISC - V CPU、“AI Booster”芯片以及润欣科技自研的最新AI算力芯片。服务器级RISC - V CPU:这是由奇异摩尔自研的全球首款服务器级RISC - V CPU,于2024年3月5日发布,性能堪比英伟达GPU。

〖陆〗、谷歌(Google):TPU芯片在AI推荐系统与深度学习领域表现优异,自研架构优化算力效率。AMD:通过Radeon Instinct系列布局AI芯片,近年市场份额快速提升,聚焦数据中心异构计算。国内核心企业AI服务器相关企业:浪潮信息、工业富联、中科曙光。

什么是CPU、GPU、NPU、TPU,及算力对比?

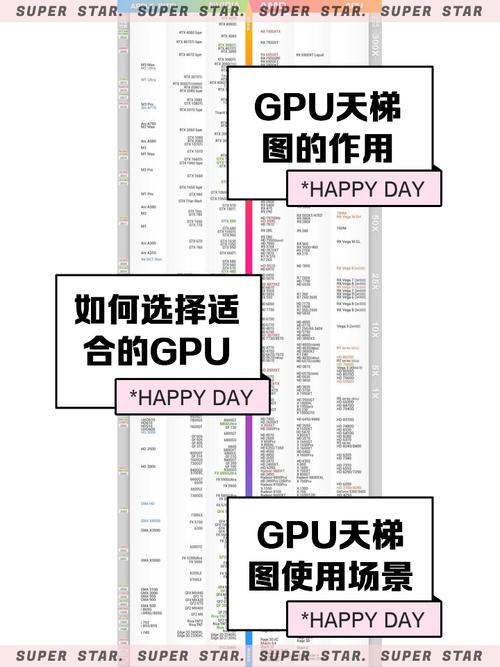

〖壹〗、GPU是一种专门用于高效处理图像和图形的处理器,具有强大的并行计算能力。它最初是为了处理三维图形而设计的,但随着技术的发展,已广泛应用于科学计算、计算机视觉、深度学习等领域。

〖贰〗、定义:GPU是图形处理器,专为图像和图形处理而设计。 算力特点:GPU拥有更多核心和高速内存,对大规模并行任务有显著优势,因此在科学计算、计算机视觉和深度学习等领域有广泛应用。 NPU: 定义:NPU是神经处理单元,专为深度学习优化。 算力特点:NPU注重矩阵运算和卷积运算,能高效处理神经网络计算。

〖叁〗、GPU,作为图形处理器,专为图像和图形处理而设计,现在广泛应用于科学计算、计算机视觉和深度学习。与CPU相比,GPU拥有更多核心和高速内存,对大规模并行任务有显著优势。NPU,神经处理单元,是专为深度学习优化的处理器,设计上注重矩阵运算和卷积运算,能高效处理神经网络计算。

〖肆〗、CPU:精于控制和复杂运算。GPU:精于简单且重复的运算,适合并行计算。TPU:专为深度学习算法设计,高效处理张量运算。NPU:模仿大脑神经网络,处理神经元和突触运算。应用场景:CPU:通用处理器,适用于各种计算任务。GPU:图像处理、科学计算、密码破解、数值分析、海量数据处理等。

谷歌tpu为什么没有火

谷歌TPU没有普及的核心原因在于它的设计定位与市场需求存在错位。 应用场景过于垂直TPU全称张量处理器,是谷歌专门为AI训练和推理设计的芯片。它的优势在于处理神经网络计算时效率极高,但这也导致其功能单一。相比之下,英伟达的GPU既能跑AI模型,又能支持游戏渲染、视频剪辑等通用计算任务,市场覆盖面更广。

英伟达在AI训练市场的高算力GPU一直占据领先地位,但随着谷歌TPU、AMD MI300以及云厂商自研芯片等的强势涌入,AI训练市场的格局正在发生变化。首先,英伟达的高算力GPU虽然一直是AI训练的首选,但并非没有竞争对手。AMD即将推出的MI300芯片就是一个强有力的挑战者。

OpenAI选取与谷歌合作,而不再依赖英伟达的主要原因在于谷歌TPU芯片的高度特化优势、成本效益以及市场需求的转变。谷歌TPU芯片的高度特化优势:谷歌的TPU(Tensor Processing Unit)芯片设计初衷就是针对AI任务进行优化,特别是张量运算。

TPU芯片概念股主要有科德教育、中航信、艾布鲁、浙数文化、浙大网新、雅克科技、寒武纪、中芯世界、长电科技。科德教育:参股中昊芯英,该公司创始人参与过谷歌TPU 2/3/4代AI训练芯片主要设计等工作,涉及TPU芯片设计的核心环节。中航信:已完成TPU芯片流片和量产,年产量超2万片,具备实际的生产能力。

技术亮点 自研光通信器件:谷歌利用自己定制的光开关将4000多个TPU v4芯片组合到一台超级计算机系统中。这种光通信器件具有成本低、功耗低、速度快等优点,并且可以轻松地动态重新配置芯片之间的连接,有助于避免出现问题并实时调整以提高性能。

最新市场主流“AI芯片”概念梳理

Maia 100:面向AI的芯片,旨在与英伟达AI图形处理单元展开竞争。Cobalt 100:面向通用计算任务的芯片,将与英特尔处理器争夺市场。亚马逊 Trainium:训练芯片。Inferentia:推理芯片。亚马逊是唯一一家在服务器中提供训练和推理两种类型芯片的云提供商。中国主流AI芯片 华为升腾芯片 升腾910:用于训练。升腾310:用于推理。

科技巨头围猎“AI芯片”,国内外主流厂商梳理 国外主流厂商:谷歌:TPU系列:TPU(Tensor Processing Unit)是谷歌专为机器学习设计的专用处理器。TPU v5p是谷歌迄今为止最强大、比较高效的TPU芯片,其训练性能比TPU v4快8倍,训练嵌入密集模型的速度快9倍。

世界主流AI芯片 谷歌TPU:专为机器学习设计,最新升级版本TPU v5p性能显著提升,训练效率是TPU v4的8倍,同时在内存和带宽方面也有显著增强。谷歌对AI芯片市场的迅速扩张持乐观态度。AMD MI300系列:包括MI300X和MI300A,分别在训练和推理方面表现出色。

GPGPU由GPU的架构演进而来,并能使用更高级别的编程语言,在性能和通用性上更加强大,是近来AI加速服务器的主流选取。中科曙光提供高端计算机、存储、服务器等ICT基础设施,其GPGPU产品深算一号是最早实现商业化的国产GPGPU芯片。总结 随着AIGC商业化应用的加速落地,AI芯片市场将迎来高速增长。

AI芯片知识初级总结 AI芯片基本概念 AI芯片,即人工智能芯片,是用神经网络、计算架构去构建模拟人类智能运算方式的芯片。它主要分为两个方向:推理和训练。推理芯片主要用于执行已经训练好的AI模型,对输入数据进行处理并输出结果;而训练芯片则用于训练AI模型,即通过学习大量数据来优化模型的参数。

GPU发展历史,TPU、寒武纪等体系架构及其比较

〖壹〗、寒武纪的体系架构主要采用了流式处理的乘加树和类脉动阵列的结构。其技术演进路线从DianNao系列AI加速专用芯片开始,逐渐发展到DadianNao、ShiDianNao和PuDianNao等架构。这些架构在算力、能效比和通用性方面不断取得突破。寒武纪智能芯片具备完备的指令集及灵活的处理器架构,在人工智能领域已具备通用性。

〖贰〗、TPU与寒武纪体系架构比较: 技术原理:两者都旨在设计出适合智能算法的通用型芯片,以提高智能应用的能效。 运算效率:TPU采用经典的脉动阵列技术,对于特定运算效率较高。 通用性:寒武纪芯片则通过将算法基本操作分类处理,实现了更全面的通用性,能够处理更多类型的智能算法。

〖叁〗、TPU是Google为机器学习设计的芯片,具有高效能,能加速TensorFlow运行,性能远超GPU。与GPU相比,TPU采用低精度计算,优化矩阵乘法与卷积运算,减少I/O操作,拥有更大的片上内存,能提供显著性能提升。

算力基础知识(一)

算力基础知识(一)算力的定义与重要性 1 定义 算力,或计算能力,是指计算机系统执行算法、处理数据和解决问题的能力。在更专业的层面上,算力可以量化为单位时间内处理数据的速度,通常用每秒浮点运算次数(FLOPS, Floating Point Operations Per Second)来衡量。

AI基础知识算力 算力是衡量计算机处理数据能力的关键指标,尤其在AI领域,算力的重要性不言而喻。 运算单位 FLOPS(Floating-point Operations Per Second):这是衡量算力的一种常用单位,主要用于科学计算和工程计算,表示每秒钟能够完成多少次浮点数(小数)的加减乘除运算。

算力基础知识(二)算力(计算能力)作为人工智能、大数据、云计算等领域的核心资源,其重要性不言而喻。掌握模型的算力需求、研究算力对程序和算法性能的影响,以及如何评估和选取合适的算力资源,是提升系统效率的关键。以下是对算力基础知识的进一步探讨。

算力新贵横空出世!智算加速卡是什么东西竟能硬刚GPU和TPU!

〖壹〗、智算加速卡,是为AI、机器学习、大模型推理训练等场景量身打造的高性能计算加速硬件。其“智”并非指其本身具备智能,而是强调其为智能计算服务。简而言之,智算加速卡是专为AI这种对算力需求极大的应用而设计的“专用加速器”,相较于传统的GPU或TPU,它更侧重于算力密度、并行处理及模型优化能力。

〖贰〗、通用算力、超算算力和智算算力是三种根据应用场景和计算特性划分的算力类型。通用算力:定义:一般指基于CPU的计算能力,设计用于处理广泛的计算任务。特点:通用算力具有广泛的适用性,能够处理各种不同类型的计算需求,如日常办公、数据处理、网络服务等。

〖叁〗、高达500P的算力水平:500P智算中心拥有高达500P(Petaflops,千万亿次浮点运算/秒)的算力水平。这一算力资源足以支撑极大规模的AI模型训练,满足各种复杂AI应用的需求。

〖肆〗、与智算/超算的对比通算服务器功率显著低于智算/超算场景。后者因搭载大量GPU/TPU加速卡,单机柜功率可达40kW至100kW,例如超算中心为训练大模型配置的液冷机柜,功率密度常超过60kW。而通算服务器以CPU为主,功耗集中在350W至1kW(单机)或6kW至20kW(单机柜),更适用于通用计算、存储等场景。

一文看懂CPU、GPU、NPU,TPU,DPU,IPU

〖壹〗、IPU是一种用于连接多个处理器的硬件设备,可实现多处理器中不同处理器之间的通信和协调,从而提高性能。它可加速网络基础设施,释放CPU内核,实现应用程序性能的提升。IPU还集成了高度优化的硬件和软件,以实现高效的人工智能计算。它在深度学习、机器学习和自然语言处理等领域具有出色的性能。

〖贰〗、CPU、GPU、NPU、DPU、TPU、IPU、LPU、MCU、MPU 这9大主流芯片我都认识。以下是关于这九种芯片的详细介绍: CPU(中央处理器)架构设计:采用复杂指令集(CISC)或精简指令集(RISC)架构,注重通用性和顺序执行能力。

〖叁〗、DPU(Data Processing Unit)是新型可编程多核处理器,具备高算力和高性能网络接口,能高效解析、处理数据,减少CPU和GPU的负担,适用于特定任务,如网络协议处理、加密解密等。

〖肆〗、CPU、GPU、DPU、TPU和NPU是计算机和AI领域中的五种重要处理器,它们各自承担着不同的任务,共同协作以提升设备的性能和效率。下面,我将用简单易懂的语言为大家解释这些概念。

〖伍〗、一文带你了解CPU,GPU,TPU,DPU,NPU,BPU 首先,CPU(中央处理器)是机器的核心,承担计算、控制和存储任务。CPU结构包括运算器、控制器、寄存器和高速缓存,遵循冯诺依曼架构,核心是存储程序并顺序执行。然而,CPU在并行计算上受限于存储单元和控制单元的占用空间,计算单元相对较小。

〖陆〗、GPU、TPU、DPU、BPU、NPU分别是五种各有侧重的处理器,它们的主要区别如下:GPU:定义:最初为图形处理而生,擅长并行处理大量简单任务。优势:在游戏、渲染和物理模拟中表现卓越,同时在深度学习和科学计算等领域也崭露头角。特点:高并行性和计算效率。TPU:定义:专为深度学习设计。

算力TPU的介绍就聊到这里吧,感谢你花时间阅读本站内容,更多关于算力龙头10股、算力TPU的信息别忘了在本站进行查找哦。