极智算总结:

- 挖矿算力怎么计算

- 算力计算有哪些方法?算力计算适用方法

- 大白话解释GPU的算力是怎么算出来的?

- 一文让你彻底了解算力到底是如何计算出来的——算力的计算方法(CPU和G...

- 算力的单位是?

- 搞懂算力到底怎么算?

- 算力是什么意思?

- 计算机系统算力怎么算出来的

- 算力怎么计算

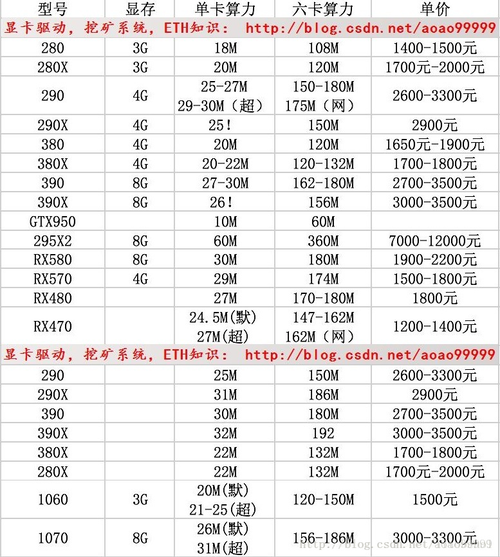

挖矿算力怎么计算

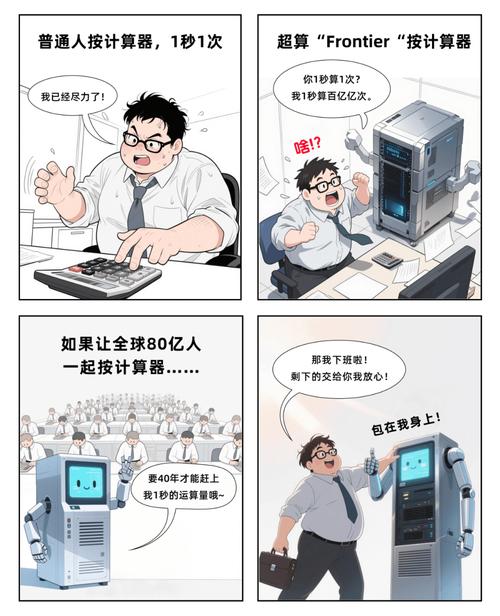

首先,算力代表的是矿机每秒的运算次数,如达到1次/s,则对应算力为1H。因此知道挖币矿机的运作时间与运算次数即可计算其算力。算力的单位是每千位一变化,最小单位H为1次,1K=1000H,1G=1000K,1T=1000G,1P=1000T,1E=1000P。

挖矿算力主要通过矿机每秒的运算次数来计算。以下是关于挖矿算力计算的详细解算力的定义 算力代表的是矿机每秒的运算次数。例如,如果矿机每秒能进行1次运算,则其算力为1H(Hash,哈希值)。算力是衡量矿机性能的重要指标,决定了矿机在挖矿过程中的竞争力。

明确矿机参数 算力:每台蚂蚁矿机S19 Pro的算力为110T。 功耗:每台矿机的功耗为3250瓦,10台则为35千瓦。 电费成本:假设电费为0.36元每度。计算总算力与全网算力的比例 总算力:10台矿机的总算力为110T * 10 = 1100T。

挖矿算力是指挖矿设备在每秒计算次数,它是挖矿的关键指标。挖矿算力的计算方法是:挖矿设备在每秒计算次数乘以每次计算的数量,即可得出挖矿算力。例如,一台挖矿设备每秒计算1000次,每次计算的数量为100,则该挖矿设备的挖矿算力为100000。

挖矿算力是通过挖矿设备在每秒计算次数乘以每次计算的数量来计算的。具体解释如下:计算方法:挖矿算力等于挖矿设备在每秒进行的计算次数与每次计算所处理的数据量的乘积。

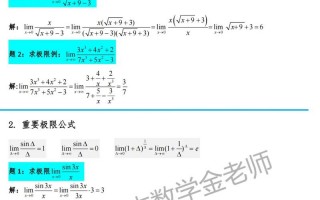

算力计算有哪些方法?算力计算适用方法

分布式计算:分布式计算是一种分布式计算技术,它可以将一个复杂的计算任务分解成多个小任务,然后将这些小任务分发到多台计算机上进行计算,最后将计算结果汇总,从而达到解决复杂计算问题的目的。

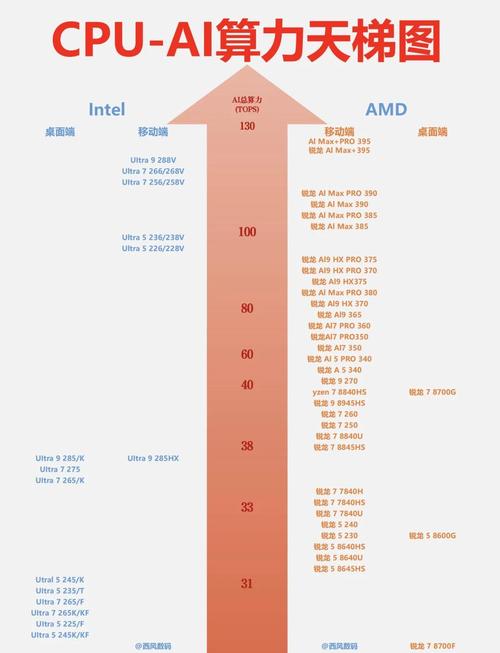

通用计算场景(以FLOPS为单位):使用基础公式“算力(FLOPS)= 核心数量 × 时钟频率(GHz)× 每时钟周期浮点运算次数”。核心数量指CPU物理核心数、GPU流处理器或SM单元数;时钟频率是处理器每秒运行周期数,单位为GHz;每周期运算次数由架构决定。

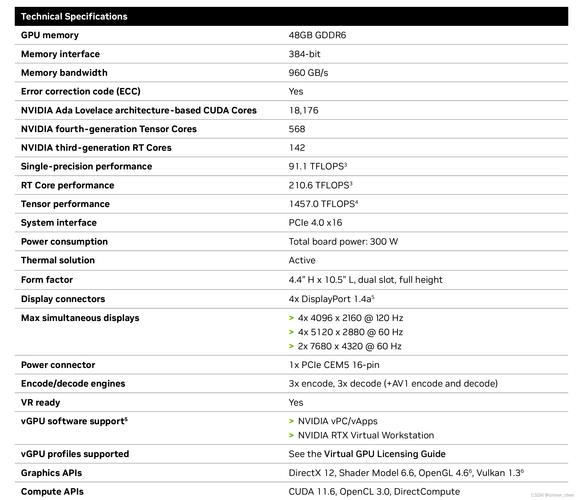

算力计算方式:GPU的算力计算相对复杂,因为它取决于多个因素,包括GPU的架构、核心数、主频、内存带宽等。通常,GPU制造商会提供具体的算力数值,如NVIDIA的GPU通常会提供FP32(32位浮点数)或FP16(16位浮点数)等精度下的算力。

算力计算的方法主要有以下几种:分布式计算:描述:将复杂的计算任务分解成多个小任务,并分发到多台计算机上进行并行计算,最后汇总结果。优势:能够充分利用多台计算机的计算资源,提高计算效率。网格计算:描述:与分布式计算类似,也是将计算任务分解成多个小任务,并分发到多台计算机上。

企业算力使用量可以通过以下公式来计算:算力(TFLOPs)= 核心数量 × 核心频率(GHz) × 每个核心每时钟周期的FLOPs数 / 10^12这个公式较为具体,适用于了解硬件详细参数的情况下进行算力计算。

SOC芯片中CPU的算力主要通过DMIPS来计算。具体计算方式及步骤如下:DMIPS算力计算公式 CPU的DMIPS算力计算公式为:算力DMIPS = 内核的数量 × 主频 × DMIPS/MHz。内核数量:指CPU中处理核心的数量,多核心能够并行处理更多任务,提高整体算力。

大白话解释GPU的算力是怎么算出来的?

〖壹〗、综上所述,GPU的算力是通过CUDA核心数、核心时钟频率和每核心单个周期浮点计算系数这三个参数计算出来的。同时,还需要考虑不同精度的算力表述以及显存带宽的影响。在实际应用中,还需要结合具体的应用场景和需求来评估GPU的算力表现。

〖贰〗、GPU算力,通俗地说,就是GPU干活儿的“能力”大小。它衡量的是GPU在单位时间内能够处理的数据量和完成计算任务的复杂程度。如果GPU算力强大,就意味着它能在很短的时间内同时处理大量的数据和任务,迅速完成复杂的计算任务。反之,如果GPU算力较弱,处理同样任务的速度就会慢很多。

〖叁〗、计算成本呈指数级增长:GPT-3训练成本1200万美元,GPT-4估计1亿~2亿美元,未来100万亿参数模型成本可能突破10亿美元。数据效率的关键作用:DeepMind的Chinchilla定律指出,“小模型+大数据”可能比“大模型+小数据”更高效。例如,700亿参数模型用5倍数据训练,性能可能超过数据不足的1万亿参数模型。

〖肆〗、FCC:即开即用、快速上手的计算云平台,相当于酒店,拎包入住。FCC-E:一站式企业级计算云平台,相当于别墅,独门独栋。FCP:一站式多云算力运营平台,相当于地基,你来做主。希望这次介绍能让你对速石科技的三大产品有更清晰的认识。

一文让你彻底了解算力到底是如何计算出来的——算力的计算方法(CPU和G...

CPU的算力通常用每秒执行的浮点运算次数(FLOPS,Floating Point Operations Per Second)来衡量。算力的计算可以通过了解CPU的核心数、每个核心的时钟频率以及每个时钟周期能够执行的浮点运算次数来进行。

CPU和GPU的算力主要通过每秒执行的浮点运算次数来衡量,具体计算涉及核心数量、主频以及单周期浮点计算能力。以下是详细解释: 算力的衡量标准: 算力主要通过FLOPS来衡量。它反映了计算机每秒能执行的浮点运算数量,是衡量计算机处理速度和计算能力的重要指标。

FLOPS的定义: FLOPS是Floating Point Operations Per Second的缩写,即每秒浮点运算次数,是衡量计算机、CPU或GPU处理小数计算效率的重要指标。 CPU的算力计算: CPU的算力主要由其核心数、频率以及浮点计算能力共同决定。

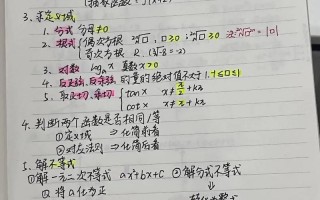

算力的单位是?

算力单位p和flops换算:1P=1024*1024=1048576G。算力介绍如下:算力是计算机设备或计算/数据中心处理信息的能力,是计算机硬件和软件配合共同执行某种计算需求的能力。算力的英文名是computility。其中的compu-是计算的词根,表达“算”的含义,-utility是效用、实用的意思。

算力,即计算能力,是衡量一个系统或设备处理数据、执行运算任务的能力。在描述算力时,通常会使用特定的单位来表示其性能水平。以下是对算力单位的详细概述:基本算力单位 FLOPS(Floating Point Operations Per Second):浮点运算次数每秒,是衡量处理器浮点运算能力的主要单位。

核心结论:算力单位中的“p”通常指petaFLOPS(千万亿次计算/秒),而“a”并非标准单位,可能是输入错误或其他术语简称,需具体情况具体分析。 关于两者的定义和应用范围 “p”指petaFLOPS:这是衡量计算机性能的常用单位,代表每秒能完成1千万亿次浮点运算,大型超算或AI训练常用这一单位。

算力单位主要包括TFLOPS、PFLOPS、EFLOPS和ZFLOPS。定义 TFLOPS (Tera Floating Point Operations Per Second):每秒一万亿次浮点运算。这是衡量计算能力的一种单位,常用于描述高性能计算机或图形处理器的运算速度。PFLOPS (Peta Floating Point Operations Per Second):每秒一千万亿次浮点运算。

算力是数据的处理能力。通常把每秒钟处理数据能力的多少表示其算力的强弱。算力的计量单位一般采用FLOPs(Floating-point operations per second),即每秒钟所执行的浮点运算次数。量级分为MFLOPs、GFLOPs、TFLOPs、PFLOPs、EFLOPs和ZFLOPs等,当然还有其他表示方法如MIPS、DMIPS、OPS和Hash/s等。

搞懂算力到底怎么算?

〖壹〗、算力主要通过计算设备的核心性能指标来评估。算力(Computational Power),即计算能力,是计算机系统或设备执行数值计算和处理任务的核心能力。以下是对算力计算方式的详细解释:CPU算力 CPU的算力通常用每秒执行的浮点运算次数(FLOPS,Floating Point Operations Per Second)来衡量。

〖贰〗、CPU算力的提升主要依靠时钟频率和内核数。时钟频率的高低在很大程度上反映了CPU速度的快慢,而内核数是CPU内部可以执行指令的单个处理单元的数量。通常来说,时钟频率越大、内核数越多,CPU的性能越强,但这也带来了能耗过高、发热过大的问题。

〖叁〗、算力:AI的“体力”。训练复杂的AI模型需要大量的计算能力,如训练GPT-4需要上万块GPU。AI在日常生活中的应用场景 AI已经渗透到我们生活的方方面面,以下是几个典型的应用场景:医疗:AI可以通过分析肺部CT片,在0.5秒内揪出癌细胞,这得益于卷积神经网络(CNN)的应用。

〖肆〗、支持企业及组织使用天津人工智能计算中心算力服务,比较高按实际购买金额的50%给予算力“服务券”,单个主体每年不超过30万元。河北省廊坊市 每年发放不超过1000万元算力券,对落户企业、承接重大项目单位、使用本地算力服务平台的主体按不同标准奖励,每个单位每年不超过100万元。

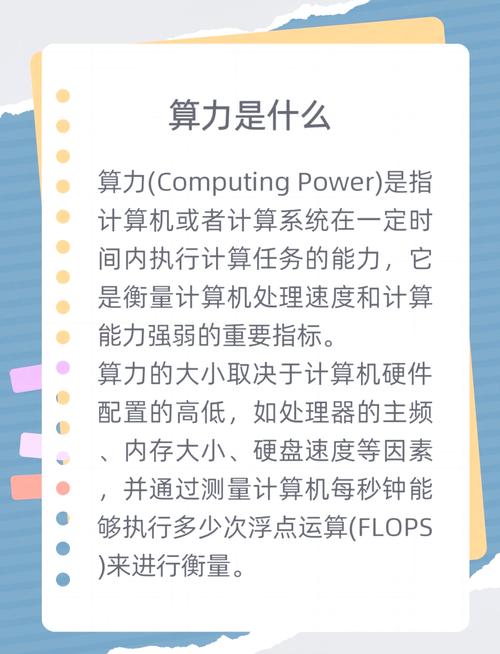

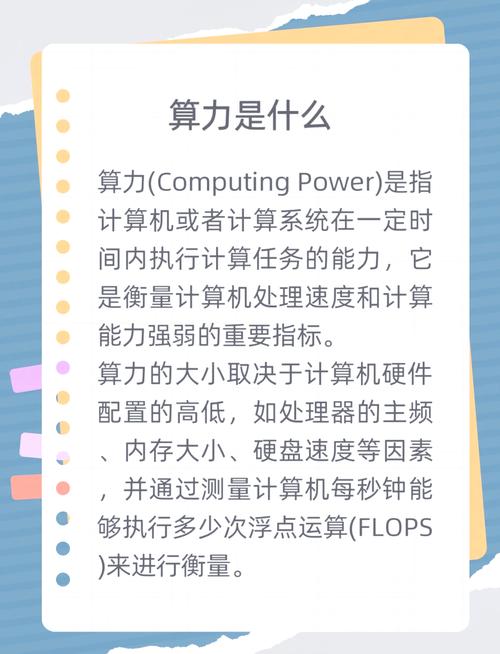

算力是什么意思?

〖壹〗、算力,简单来说,是指计算机的计算能力,尤其在比特币挖矿中扮演着关键角色。这种能力通过测量一个矿工每秒能执行多少次哈希碰撞(hash/s)来衡量,这是工作量证明机制POW(Proof Of Work)的基础。1P算力,即1个Petabyte(PB,1千万亿),相当于约105万吉比特(GB)。

〖贰〗、算力是计算机设备或计算/数据中心处理信息的能力,是计算机硬件和软件配合共同执行某种计算需求的能力。算力的英文名是computility。其中的compu-是计算的词根,表达“算”的含义,-utility是效用、实用的意思。computility用来表达计算的能力,即算力。

〖叁〗、算力是指计算能力或计算资源的强弱程度,它是一种重要的科技基础能力,被广泛地应用在各个领域。基本定义 算力即计算能力,是计算机或其他计算设备在特定时间内可以完成计算任务的能力。涉及计算机硬件性能、软件算法效率以及数据处理和分析能力等多个方面。已成为衡量信息技术发展水平的重要指标之一。

计算机系统算力怎么算出来的

〖壹〗、计算机系统算力的计算方式因硬件类型和应用场景不同而有所差异,常见方法包括峰值计算法和CUDA核心计算法,区块链领域则以哈希率衡量算力。以下从不同维度展开说明:GPU算力的核心计算方法GPU算力通常以浮点运算能力(FLOPS)为单位,代表每秒可执行的浮点运算次数。

〖贰〗、在一些需要大规模并行计算的任务中,如深度学习训练,GPU的显存大小、带宽以及计算核心数量等都决定了其算力。大显存能存储更多数据,高带宽可快速传输数据,众多计算核心则能高效执行计算任务。再者,内存的读写速度也会影响算力。快速的内存能让数据更及时地被CPU和GPU读取处理,避免因内存瓶颈降低算力。

〖叁〗、算力主要通过计算设备的核心性能指标来评估。算力(Computational Power),即计算能力,是计算机系统或设备执行数值计算和处理任务的核心能力。以下是对算力计算方式的详细解释:CPU算力 CPU的算力通常用每秒执行的浮点运算次数(FLOPS,Floating Point Operations Per Second)来衡量。

算力怎么计算

〖壹〗、GPU算力的核心计算方法GPU算力通常以浮点运算能力(FLOPS)为单位,代表每秒可执行的浮点运算次数。

〖贰〗、通用计算场景(以FLOPS为单位):使用基础公式“算力(FLOPS)= 核心数量 × 时钟频率(GHz)× 每时钟周期浮点运算次数”。核心数量指CPU物理核心数、GPU流处理器或SM单元数;时钟频率是处理器每秒运行周期数,单位为GHz;每周期运算次数由架构决定。

〖叁〗、算力主要通过计算设备的核心性能指标来评估。算力(Computational Power),即计算能力,是计算机系统或设备执行数值计算和处理任务的核心能力。以下是对算力计算方式的详细解释:CPU算力 CPU的算力通常用每秒执行的浮点运算次数(FLOPS,Floating Point Operations Per Second)来衡量。

〖肆〗、GPU的算力计算相对复杂,但核心思路是通过核心数量、频率和每周期计算能力来确定。主要有两种方法:峰值算力法和CUDA核心算力法。

〖伍〗、算力单位p和flops换算:1P=1024*1024=1048576G。算力介绍如下:算力是计算机设备或计算/数据中心处理信息的能力,是计算机硬件和软件配合共同执行某种计算需求的能力。算力的英文名是computility。其中的compu-是计算的词根,表达“算”的含义,-utility是效用、实用的意思。

OK,关于算力是怎么算出来的和算力是怎么产生的的内容到此结束了,希望对大家有所帮助。