极智算总结:

英伟达a100显卡算力

DGX A100系统算力:单台DGX A100服务器的算力可以高达5 Peta Flops。DGX A100集成了8个NVIDIA A100 GPU,每个GPU均支持12路NVLink互连总线,提供了超高的计算密度和灵活性。

在人工智能快速发展的当下,训练级显卡作为提供算力的关键硬件,扮演着至关重要的角色。本文将深入对比英伟达 A100 显卡、英特尔旗舰训练显卡 Habana GaudiAMD 旗舰训练显卡 MI250X,以及 Cloud-A100 系列(包括 Cloud-A100 X、Cloud-A100 X Pro 和 Cloud-A100 Z),以揭示它们各自的独特魅力与优势。

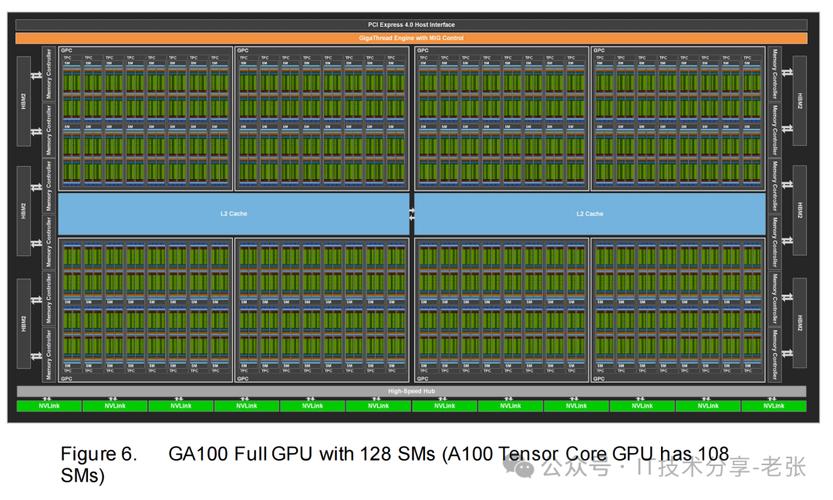

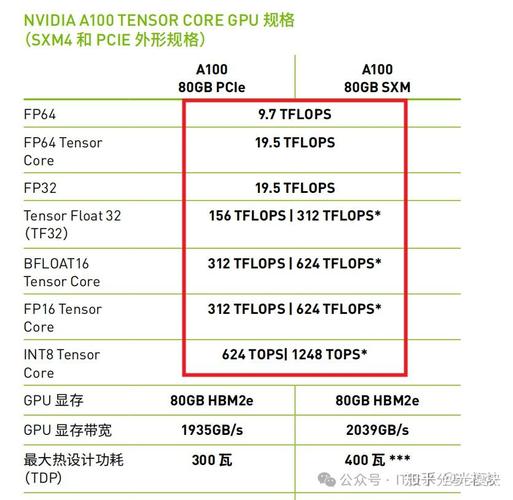

英伟达A100 GPU产品了解 参数概述:PCIe和SXM两版本算力参数一致。不同算力精度对应不同的业务场景:HPC场景使用FP64,AI场景使用FP32和FP16。算力分为CUDA core的标准算力和Tensor core加速后的算力。A100的组成单元:A100 GPU基于NVIDIA Ampere架构,包含7个GPC(图形处理集群)。

P算力(1 petaFLOPS)理论上需要约52块NVIDIA A100显卡,实际应用中可能需要57-62块以考虑冗余。硬件需求计算依据1P算力即每秒1千万亿次『10』浮点运算,其硬件配置需基于显卡的单卡算力进行推算。

一文了解英伟达A100算力的“计算公式”

英伟达A100 GPU产品了解 参数概述:PCIe和SXM两版本算力参数一致。不同算力精度对应不同的业务场景:HPC场景使用FP64,AI场景使用FP32和FP16。算力分为CUDA core的标准算力和Tensor core加速后的算力。

计算:GPU算力 = (6912 × 41 GHz × 2) ÷ 10^12 = 15 TFLOPS 双精度FP64:GPU的双精度算力通常是单精度的一半(具体取决于硬件设计和优化),因此A100的双精度算力约为75 TFLOPS(15 TFLOPS ÷ 2)。

计算公式为:GPU算力 = Fclk * Freq * N_SM 以NVIDIA A100为例,其白皮书中给出的数据是:FP32 Tensor Core指令吞吐64 FLOPS/Cycle,核心运行频率为41GHz,SM数量为108。值得注意的是,Tensor Core中的MAC或FFA融合乘加指令,每次执行计算两次,即一次乘法和一次加法。

[公式]公式中,F_clk表示GPU的时钟周期内指令执行数(单位为FLOPS/Cycle),F_req为运行频率(单位为GHz),N_SM为GPU SM数量(单位为Cores)。以NVIDIA A100白皮书的数据为例。A100中的FP32 Tensor Core指令吞吐量为64 FLOPS/Cycle,核心运行频率为41GHz,SM数量为108。

华为gpu服务器购买费用调研

华为GPU服务器的费用因型号、配置和采购渠道不同差异较大,通常单台售价在10万至50万元人民币区间。影响费用的核心因素 GPU型号:搭载NVIDIA A100的机型比国产升腾910B成本高约30%-50%。 计算节点数量:8卡服务器(如Atlas 800)比4卡机型贵60%以上。

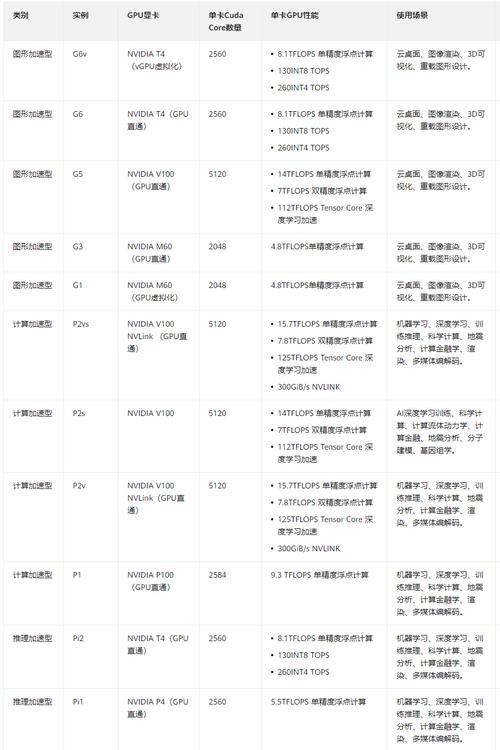

G6v.xlarge.2年费7,199元,相当于月均599元,较按月计费节省约13%。代理商折扣政策通过华为云代理商(如典名科技)购买,可享受折扣和返利政策,进一步降低企业成本。例如,G6v.xlarge.2年费实际支付约7,199×0.7×0.85=4,266元,较原价降低约41%。

企业级GPU服务器的费用区间通常在5万元至50万元人民币之间,具体取决于配置、品牌和应用场景。基础配置影响费用 入门级:搭载1-2张中端GPU(如NVIDIA T4或A10),费用约5-15万元,适合轻量级AI推理或图形处理。

腾讯云:新用户赠送额度高,但续费费用陡增,整体性价比一般。 生态支持(15%)优刻得(UCloud):预装TensorFlow、PyTorch等主流框架镜像,支持多模态大模型训练,联合DeepWisdom推出AI Agent开发平台MGX,提供全球智算网络支持。阿里云:生态资源丰富,但部分高级功能需额外购买。

看透性价比陷阱 避免迷信最新显卡 在算力领域,“买新不买旧”的逻辑并不总是成立。例如,RTX 4090的显存位宽为288bit,比RTX 5080的192bit高出50%,在AI推理中延迟更低,且费用更便宜5%。因此,选取显卡时应关注其与实际任务的适配度。

液冷GPU服务器相关厂商主要分为芯片厂商、服务器厂商及其他相关厂商三类:芯片厂商NVIDIA、AMD、Intel是GPU芯片的核心供应商,其芯片功耗与散热需求直接影响液冷系统的设计标准。例如,NVIDIA最新一代GPU的TDP(热设计功耗)显著提升,推动服务器厂商开发更高效率的液冷方案以应对散热挑战。

a100服务器转让费用

A100服务器转让费用存在较大波动,具体费用因型号、时间及市场供需关系而异,近来成交价范围大致在80万元至95万元/台,二手GPU组件费用可能低至2000-3000元更具性价比。全新服务器成交费用波动根据公开成交记录,A100服务器费用受市场供需影响显著。

华为GPU服务器的费用因型号、配置和采购渠道不同差异较大,通常单台售价在10万至50万元人民币区间。影响费用的核心因素 GPU型号:搭载NVIDIA A100的机型比国产升腾910B成本高约30%-50%。 计算节点数量:8卡服务器(如Atlas 800)比4卡机型贵60%以上。

购买费用全新整机:报价集中在75万–80万元,如含8张A100 80GB SXM4/NVLINK的服务器主机,上海、深圳等地供应商有现货,包邮且2天内发货。单卡借鉴:A100 80GB单卡费用约25万–44万元,八卡单独购买总成本约66万–65万元,但不含服务器其他硬件。

一文看懂英伟达A100、A800、H100、H800各个版本有什么区别?

A100:拥有40GB显存,提供PCIE版和SXM版两种形式。A100是英伟达上一代的高性能GPU,广泛应用于AI计算、高性能计算等领域。A800:作为A100的替代产品,A800同样拥有80GB显存(与后续提到的H100、H800的某版本相同),也提供PCIE版和SXM版。

本文将对比英伟达A100、A800、H100、H800各版本之间的区别。首先,A100和A800都支持40GB和80GB显存,其中A800的显存传输速率由A100的600GB/s降至400GB/s,其它参数基本一致。H100和H800版本均支持80GB显存,其中H800的芯片间数据传输速度为H100的一半。

A800:基于A100,限制了NVLink互联带宽,适合AI推理和训练 H800:基于H100,限制了带宽,但仍然保留了较高的计算能力,适用于大型AI训练 A800和H800是英伟达专为中国市场推出的受限版GPU,以符合美国的出口管制要求。

文章分享结束,gpu服务器a100和gpu服务器公司的答案你都知道了吗?欢迎再次光临本站哦!