极智算总结:

- 高性能GPU服务器集群拓扑及组网方案

- gpu服务器普遍功率是多少

- 如何搭建多人共用的gpu服务器?

- gpu服务器是什么配置

- GPU服务器需要什么配置

- 8块4090显卡!机架式GPU服务器方案

- GPU服务器BGP线路显卡物理机

- gpu服务器与普通服务器的硬件区别

- 如何选取GPU服务器配置?

- 阿里云GPU服务器配置费用:一年、1个月和1小时GPU收费标准

高性能GPU服务器集群拓扑及组网方案

〖壹〗、测试时需搭配200Gbps交换机以发挥卡间性能。L40S架构优化数据路径,采用单机4卡设计消除主机带宽瓶颈。综上所述,高性能GPU服务器集群拓扑及组网方案需综合考虑硬件拓扑、内部互联技术、网络技术选取以及带宽分析等因素,以实现高效的数据传输和计算性能。

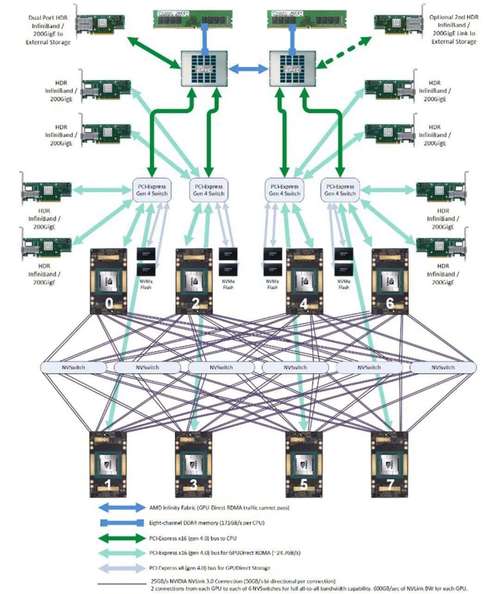

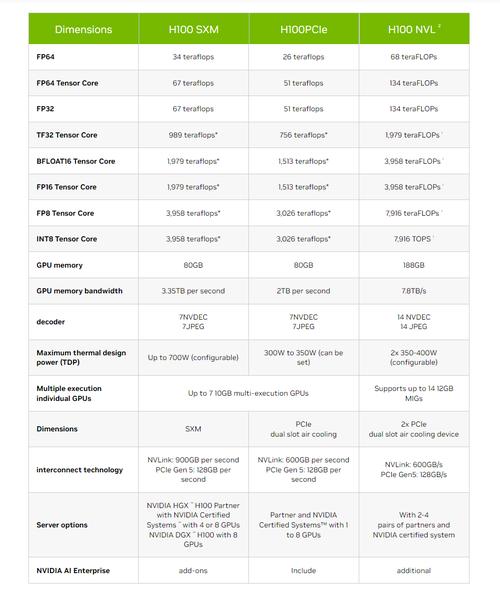

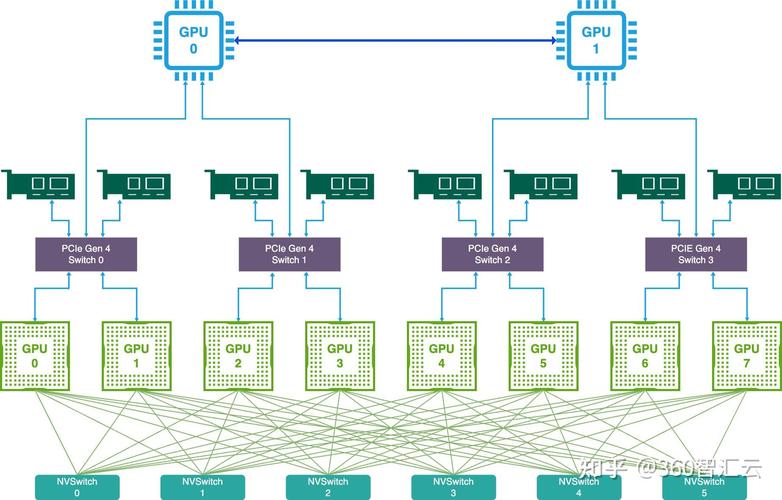

〖贰〗、高性能GPU服务器集群拓扑及组网方案 高性能GPU服务器硬件拓扑与集群组网,采用集群式架构,每台主机配备8块高性能GPU,包括A100、A800、H100、H800四种机型。典型8*A100GPU主机内部硬件架构包括高效互联的PCIe总线、NVLink、DCGM监视工具、NVSwitch交换芯片等。

〖叁〗、在GPU/TPU集群网络组网中,NVLink、InfiniBand、ROCE以太网Fabric以及DDC网络方案是当前流行的技术选取。这些技术各有优劣,适用于不同的场景和需求。以下是对这些技术的详细分析:NVLink交换系统 优势:高速点对点链路:NVLink是专门设计为连接GPU的高速点对点链路,具有比传统网络更高的性能和更低的开销。

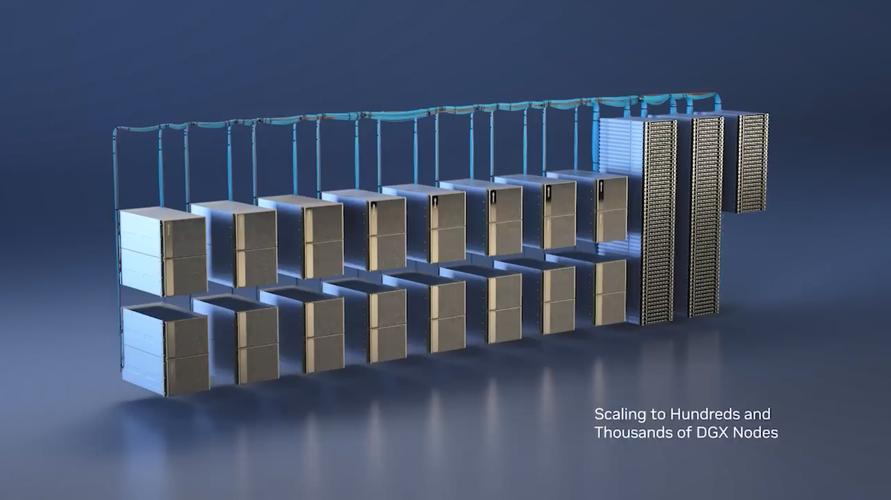

〖肆〗、性能表现:每台B200服务器都配备了八颗与第五代NVIDIA NVLink互连的NVIDIA Blackwell GPU,提供卓越的训练和推论效能。在128台服务器的规模下,该组网方案将能够支持大规模并行计算和深度学习应用,实现高效的计算资源利用和数据处理能力。

〖伍〗、两台GPU服务器卡要实现点对点组网,可以通过使用专用的高速互连网络来实现,比如InfiniBand(IB)网络。以下是具体的组网步骤:购买并安装专用高速互连设备:选取设备:根据两台GPU服务器的配置和需求,选取适合的InfiniBand设备。

〖陆〗、Ares rack内部署1台frontend-TOR,连接每台服务器的2*100GE端口。但这种方式下,使用单200GE可能会降低布线、运维、管理复杂度,收益会明显大于分为2根线缆带来的可靠性提升。

gpu服务器普遍功率是多少

〖壹〗、GPU服务器的普遍功率范围是1000W - 5000W+。功率范围概述 GPU服务器的功率主要取决于其搭载的GPU数量以及其他硬件配置。一般来说,随着显卡数量的增加,服务器的功耗也会线性增长。因此,不同配置的GPU服务器在功率上会有较大的差异。

〖贰〗、一块GPU卡一般耗电350W,一般4U的服务器最大可以支持8块GPU卡,通常业内多称之为8卡GPU服务器,当然也有4卡,6卡的。如果装满8卡GPU,那么其耗电在2800瓦,差不多就是 13A电力。

〖叁〗、服务器功率一般在125瓦~350瓦之间,但高性能服务器的功耗可能会远超这个范围。服务器的功率因配置和用途的不同而有所差异。一般来说,普通服务器的功率在125瓦到350瓦之间,这是大多数服务器在正常运行时的功耗范围。然而,这并不意味着所有服务器的功耗都会落在这个区间内。

〖肆〗、基础配置功率 若配备单颗Intel至强或AMD EPYC处理器(中端型号)、1-2块GPU(如NVIDIA T4或A10)、4-8块硬盘,空载功率通常在300-500W,满载可达800-1200W。

如何搭建多人共用的gpu服务器?

〖壹〗、搭建多人共用的GPU服务器,可以按照以下步骤进行:选取服务器硬件:确保支持GPU:选取能够支持至少一个或多个高性能GPU的服务器硬件。考虑CPU、内存和硬盘:根据任务需求,选取性能强劲的CPU、足够的内存容量以及充足的硬盘空间。电源和散热:确保电源供应稳定且散热系统能够有效应对高负载运行时的热量问题。

〖贰〗、电源:选取能够承载CPU和GPU消耗的电源,确保稳定运行。二级存储:固态硬盘或SATA硬盘,用于存储数据和系统文件。选取GPU 根据计算需求选取合适的GPU品牌和型号。特斯拉工作站产品(C系列):主动降温,适合桌面计算机。服务器产品(M系列):被动降温,适合安装在服务器上。

〖叁〗、管理、磁盘、网络、SSH密钥:在“管理”下方找到“可用性策略”,如需要创建可抢占实例(以相对低廉的费用使用高性能的GPU服务器,但有效期只有24小时,过期或遇到特殊情况会被自动删除),只需将“抢占”设置为开启。SSH密钥部分可以暂时忽略,后续会详细讲解。

〖肆〗、为GPU创建Resource Mapping:在Proxmox上创建Resource Mapping,实现GPU设备的池化管理,便于虚拟机动态分配。部署DoraCloud云桌面 在线安装DoraCloud:使用一键安装脚本在线安装DoraCloud。基础配置:安装后,进入DoraCloud后台,根据配置向导完成虚拟化、资源池、集群、用户数据库的配置。

gpu服务器是什么配置

〖壹〗、GPU服务器是基于GPU的计算服务,适用于视频编解码、深度学习、科学计算等场景,提供高性能图形处理与计算能力;普通服务器则以CPU为核心,适用于常规办公、Web服务等低负载场景。两者在核心组件、应用场景、性能特点上存在显著差异。

〖贰〗、GPU服务器:通常配备高性能的GPU卡,以及与之匹配的高性能CPU、内存和存储设备。普通服务器:硬件配置相对较为通用,主要根据具体应用场景进行配置。费用:GPU服务器:由于配备了高性能的GPU和其他相关硬件,费用相对较高。普通服务器:费用相对较为亲民,根据具体配置和品牌有所不同。

〖叁〗、GPU服务器的典型配置如下:CPU:类型:Intel Xeon 或 AMD EPYC系列。核心数:至少16核,以提供强大的多任务处理能力。主频:至少0GHz,确保高效的处理速度。缓存:至少64MB,以加快数据访问速度。GPU:类型:NVIDIA Tesla、Quadro或GeForce系列,专为并行计算而设计。

〖肆〗、GPU服务器:不仅需要充足的系统内存来支持操作系统和其他应用程序,还需要为每个GPU分配专用的显存(VRAM)。显存用于存储GPU处理过程中的临时数据,对于处理大规模数据集和复杂图形任务至关重要。因此,GPU服务器的内存配置通常更高,以满足GPU的显存需求。

〖伍〗、塔式GPU服务器:机箱较大,配置可以很高,冗余扩展也很齐备,应用范围非常广,成本低于机架、刀片服务器。具备良好的扩展能力和散热性能,可以配置多路处理器、多根内存、多块硬盘、多个冗余电源和散热风扇。机架式服务器:外形像交换机,有1U(1U=75英寸=445cm)、2U、4U等规格。

GPU服务器需要什么配置

〖壹〗、GPU服务器需要以下关键配置:高性能的GPU:核心部件:高性能GPU是GPU服务器的核心,直接影响服务器的处理能力。选取要点:通常选取专业级GPU,如NVIDIA的Tesla或Quadro系列、AMD的Radeon Instinct系列。需关注内存容量、浮点计算能力(TFLOPS)、内存带宽及最大显示分辨率。

〖贰〗、内存配置:根据任务需求选取内存容量,深度学习和大数据分析任务通常需要较大容量内存(如32GB或64GB)。存储性能:高速SSD存储能加快数据加载和读取速度,提高整体效率。网络带宽:对于大规模数据传输,选取支持10GbE或更高网络速度的服务器。考虑预算与性价比 高性能GPU通常成本较高,需在性能和预算间平衡。

〖叁〗、GPU服务器的典型配置如下:CPU:类型:Intel Xeon 或 AMD EPYC系列。核心数:至少16核,以提供强大的多任务处理能力。主频:至少0GHz,确保高效的处理速度。缓存:至少64MB,以加快数据访问速度。GPU:类型:NVIDIA Tesla、Quadro或GeForce系列,专为并行计算而设计。

〖肆〗、GPU服务器:不仅需要充足的系统内存来支持操作系统和其他应用程序,还需要为每个GPU分配专用的显存(VRAM)。显存用于存储GPU处理过程中的临时数据,对于处理大规模数据集和复杂图形任务至关重要。因此,GPU服务器的内存配置通常更高,以满足GPU的显存需求。

〖伍〗、核心功能与硬件配置GPU加速能力:通过加装独立显卡(如NV GT730 2G显存),GPU服务器可承担图形渲染、浮点运算等CPU不擅长的任务。例如,NV GT730显卡支持GDDR5显存,能高效处理3D图形应用程序、视频解码等场景。异构计算架构:结合CPU与GPU的并行计算能力,显著提升科学计算、深度学习等任务的运算速度。

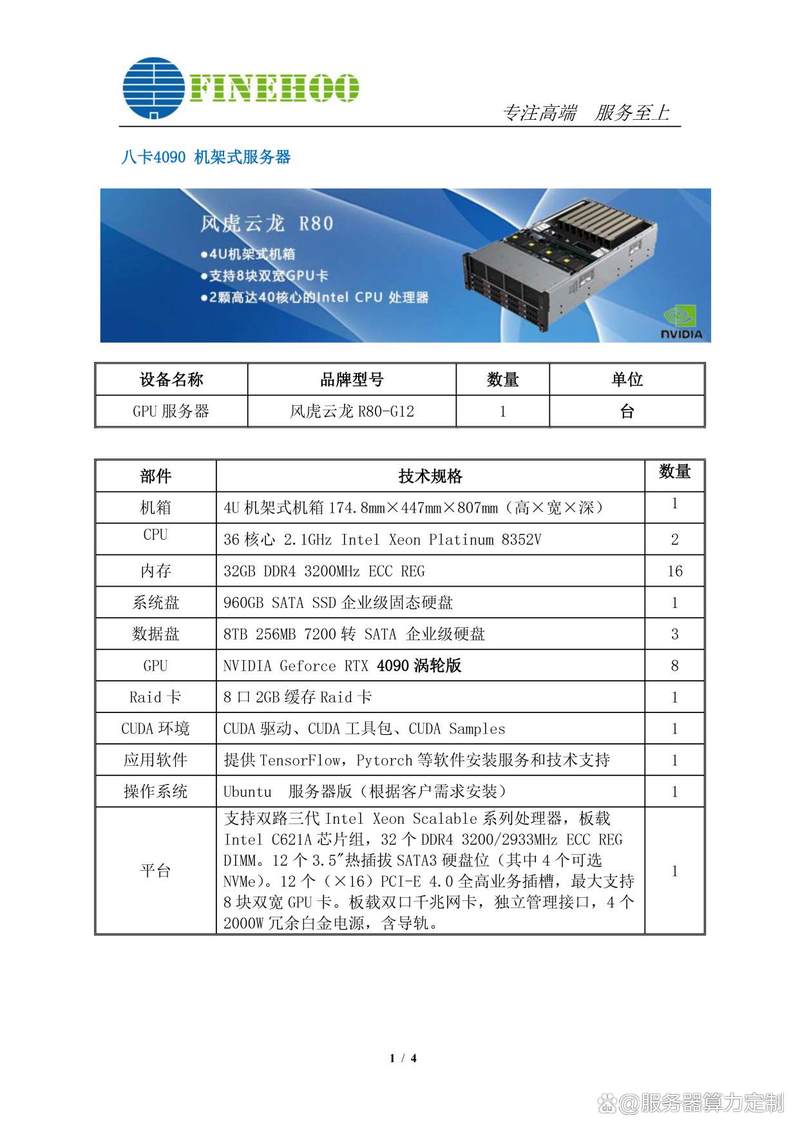

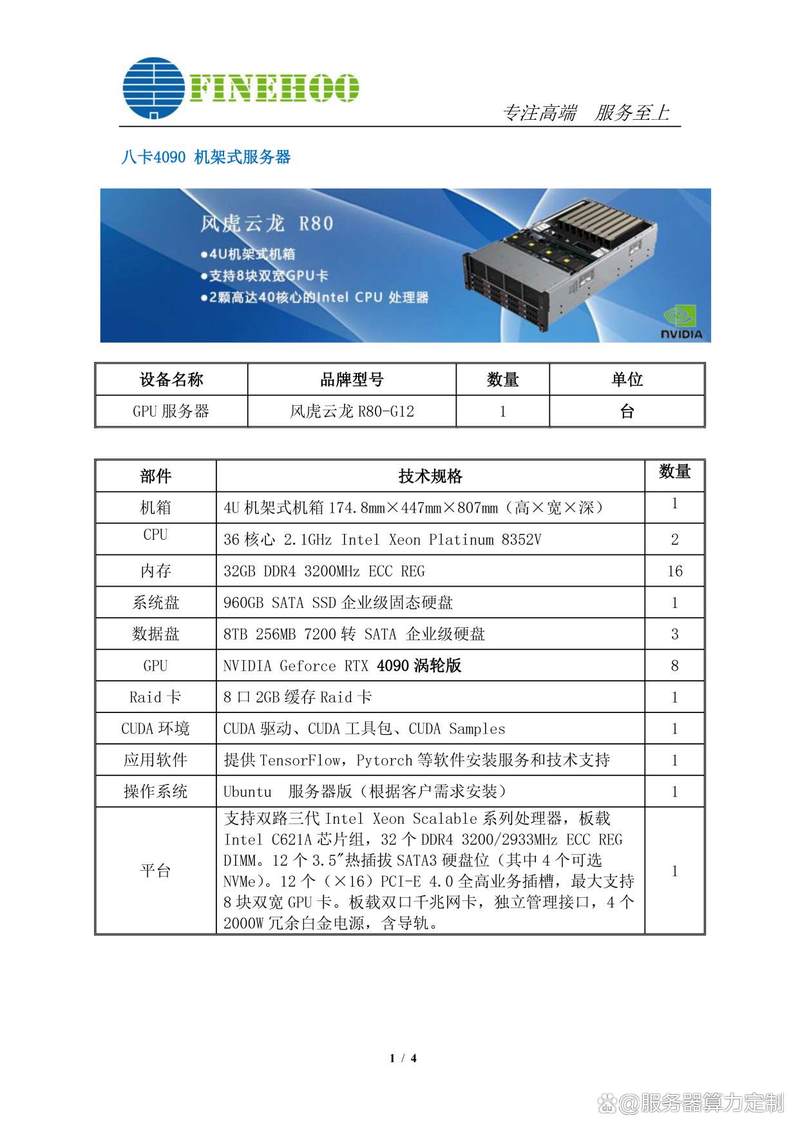

8块4090显卡!机架式GPU服务器方案

针对您提出的机架式GPU服务器方案需求,以下是一个基于8块NVIDIA Geforce RTX 4090显卡的详细方案。此方案旨在提供强大的计算力,以支持复杂的数据分析、机器学习及深度学习等任务。服务器基础配置 机箱:选取一款高质量的机架式服务器机箱,确保有足够的空间和散热能力来容纳8块RTX 4090显卡。

卡英伟达4090深度学习服务器 这款服务器搭载了8张NVIDIA Geforce RTX 4090涡轮版显卡,以其极致的计算性能和效率,能够显著减少深度学习模型的训练和推理任务时间。

方案二:4090 8GPU 4U机架式服务器GPU配置:8块NVIDIA GeForce RTX 4090,每卡24GB GDDR6X显存,集群总显存192GB。支持数十亿参数模型训练(如70亿参数模型全参数微调,130亿级模型LoRA/QLoRA微调)。

任务调度优化:采用Kubernetes集群管理,提高GPU利用率至85%以上。硬件迭代规划:与机房签订3年以上合约可获得15-20%的电费折扣。综上所述,托管八卡4090算力服务器到苏州胜网高电机房或中国电信苏州太湖世界数据中心都是较为划算的选取。

张4090跑70B参数的详细解释如下:显卡配置:8张NVIDIA RTX 4090 48GB GPU可以支撑70B(即700亿)参数大模型的分布式训练。这种配置能够轻松实现高效并行计算,无论是多模态联合优化还是超大规模语言模型微调。

GPU服务器BGP线路显卡物理机

GPU服务器BGP线路显卡物理机是一种配备独立显卡、通过BGP多线网络接入,并具备专业机房环境支持的特殊服务器,主要用于图形处理、异构计算及深度学习等高性能计算场景。

自己架设游戏服务器需要的配置主要包括:高性能GPU、强大的CPU、优质的机房线路、更高的带宽以及良好的服务器防御性能。高性能GPU:游戏服务器需要配备高质量的图形处理器(GPU),以提供丰富的媒体和高质量的图形渲染。强大的GPU能够支持更高的帧数,从而提升游戏的流畅度和玩家的游戏体验。

阿里云GPU服务器:全球覆盖,企业级稳定;提供T4/V100/A100等多种GPU型号选取;费用相对较高,但性能稳定可靠。腾讯云GPU服务器:国内低延迟,BGP优化;提供T4/A10/A100等GPU型号选取;适合游戏、直播等国内业务场景。

GPU服务器因其高功耗特性,托管费用相对较高。在苏州地区,托管费用通常在1270到8576元之间,具体费用取决于服务器的配置、功率以及所需的数据中心设施和专业运维服务。带宽费用:带宽费用也是租赁GPU服务器时需要考虑的重要因素。

苏州GPU算力服务器托管五大高性价比机房推荐:苏州新海宜云数据中心 位置:苏州工业园区 特点:T3+机房设施先进,拥有电信+联通+移动+BGP多线接入,网络稳定且提供高速带宽和优质服务。适合对计算性能和网络稳定性有极高要求的大型企业和互联网公司。

云服务器:按使用量付费,适合流量波动大的业务(如直播平台)。关键点:根据业务周期选取(短期项目选云服务器,长期业务选物理机)。推荐方案小型视频站:租用云服务器(如阿里云ECS、腾讯云CVM),配置2核4G+100M带宽+200GB SSD,月费约500-1000元。

gpu服务器与普通服务器的硬件区别

GPU服务器和普通服务器之间的主要区别在于它们所针对的工作负载类型以及为此优化的硬件配置。以下是两者之间的一些关键差异:处理器(CPU)普通服务器:通常配备多核高性能中央处理器(CPU),这些CPU适用于处理大量并发请求或执行复杂的计算任务,如数据库查询、Web服务等。

成本GPU服务器硬件成本高,但单位算力成本低;普通服务器初始投入低,但扩展成本可能更高。服务器CPU与普通CPU的六大区别指令集不同服务器CPU采用RISC(精简指令集),优化特定任务;普通CPU采用CISC(复杂指令集),兼顾通用性。

GPU服务器:由于配备了高性能的GPU和其他相关硬件,费用相对较高。普通服务器:费用相对较为亲民,根据具体配置和品牌有所不同。管理与维护:GPU服务器:由于硬件配置的特殊性,可能需要更专业的技术人员进行管理和维护。普通服务器:管理和维护相对较为简单,一般技术人员即可完成。

GPU服务器:由于配备了高性能的GPU和相关的硬件资源,GPU服务器的费用通常较高。普通服务器:费用相对较为亲民,适合预算有限的用户或企业。稳定性与可靠性:GPU服务器:通常设计为能够长时间稳定运行,以满足高性能计算任务的需求。它们通常具有更高的可靠性和稳定性要求。

如何选取GPU服务器配置?

CPU性能:选取强大的多核CPU(如Intel Xeon系列或AMD EPYC系列),以支持GPU的性能发挥。内存配置:根据任务需求选取内存容量,深度学习和大数据分析任务通常需要较大容量内存(如32GB或64GB)。存储性能:高速SSD存储能加快数据加载和读取速度,提高整体效率。

选取GPU型号 边缘服务器:在边缘服务器租用上,需根据业务量和使用场景来选取GPU型号。例如,对于火车站卡口、机场卡口或公安卡口等场景,可能需要选取T4或P4等型号的GPU服务器。中心端Inference:在中心端进行Inference时,可能需要考虑吞吐量、使用场景和数量等因素,选取如V100等高性能GPU服务器。

首先明确业务需求,确定是否需要GPU服务器的高性能计算能力。如果业务涉及深度学习、科学计算等需要大量并行计算的场景,则应选取GPU服务器。GPU接口类型:根据服务器的硬件配置和业务需求,选取合适的GPU接口类型,如PCIe、NVLink等。

阿里云GPU服务器配置费用:一年、1个月和1小时GPU收费标准

V100-16G卡GN6v实例:配备NVIDIA V100 16G GPU卡,8核32G内存的配置,年费用大约在45960元左右(3830元/月 * 12月)。T4卡GN6i实例:配备NVIDIA T4 GPU卡,4核15G内存的配置,年费用大约在20328元左右(1694元/月 * 12月)。

A10卡VGN7i-vws:NVIDIA A10 GPU卡,30核186G CPU内存,优惠费用74600元/1个月。T4卡VGN6i-vws:NVIDIA T4 GPU卡,10核46G CPU内存,优惠费用28556元/1个月。V100-32G卡GN6e:NVIDIA V100 GPU卡,12核92G CPU内存,优惠费用94900元/1个月。

GPU计算型gn7i(A10卡):32核188G内存,包月32199元/月起,支持大模型训练等高性能场景。此外,还有其他规格的费用:入门款vgn6i - vws:4核23G内存(含Quadro软件授权),包月9026元/月起,适合图形可视化。高性能实例GN8t系列(16核128G):包月69517元/月起,支持弹性裸金属服务器配置。

GPU计算型 GN10Xp(境外)(NVIDIA V100):1352元/7天 ≈ 5800元/月 1年费用(大致估算):同样假设年付有折扣,但腾讯云具体折扣需借鉴官方活动,上述费用乘以相应折扣系数可得年付费用。

阿里云GPU服务器费用因实例类型、配置、计费模式不同而有差异。主流实例及优惠费用如下:GPU计算型gn6i(T4卡):4核15G配置,包月优惠价1681元/月起,包年16148元/年起(折后4折),适用于深度学习、视频处理。

阿里云GPU服务器费用因多种因素而异。不同型号和配置的GPU服务器费用有较大差别。比如入门级的可能相对较为便宜,其计算能力和显存等配置相对较低,适合一些对计算要求不是特别高的基础任务,费用可能在每月几百元到数千元不等。

好了,本文到此结束,如果可以帮助到大家,还望关注本站哦!