极智算总结:

- npu用什么操作系统

- 做超级计算的linux需要什么配置

- 从0开始搭建AI绘图工具

- 如何在服务器使用显卡

- 如何在Linux系统中安装GPU驱动

- 深度学习系统是用桌面版还是服务器版

- gpu服务器用的什么系统

- 如何搭建多人共用的gpu服务器?

npu用什么操作系统

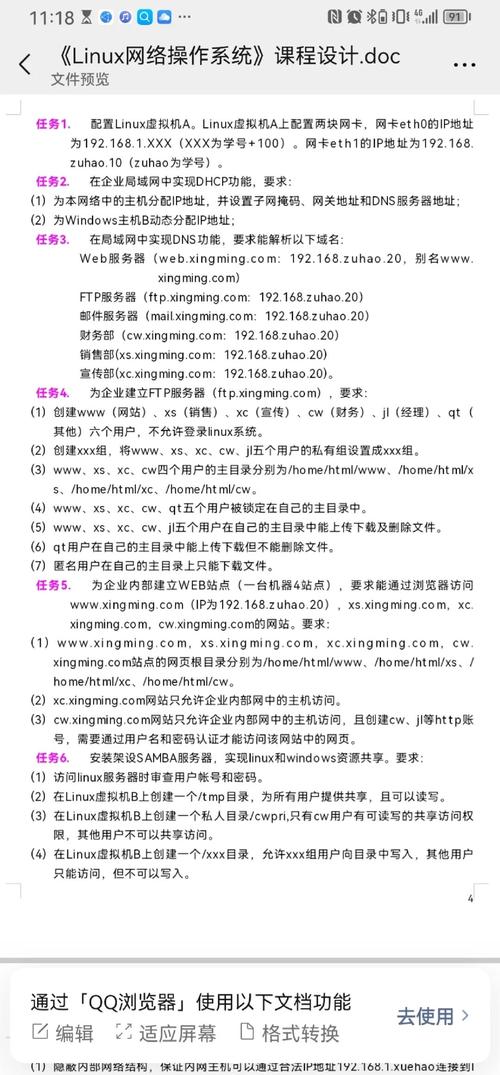

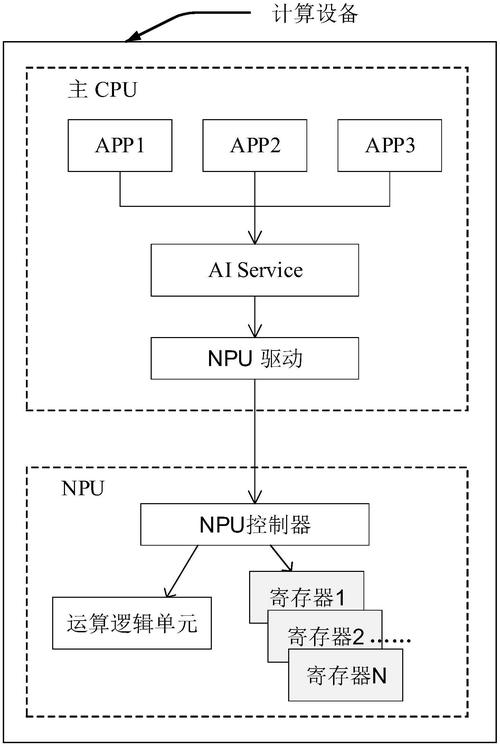

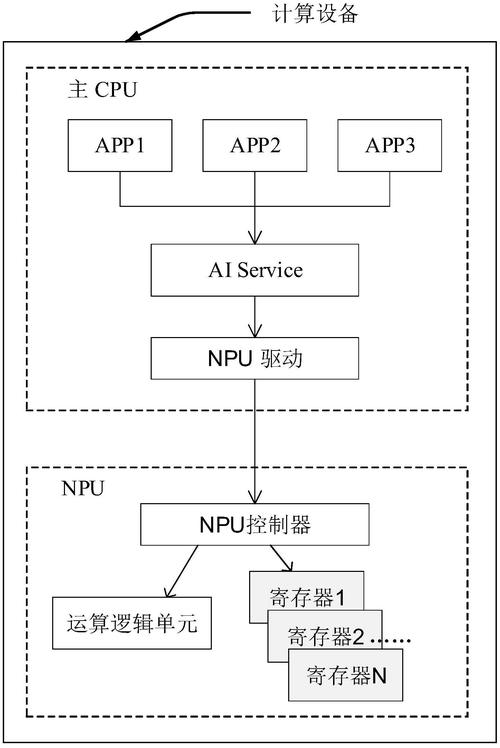

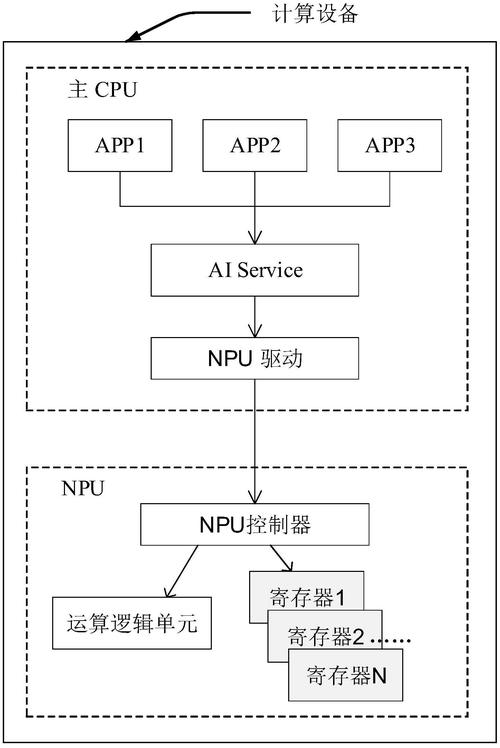

NPU可使用的操作系统包括Windows 1Ubuntu 204(及更新版本)以及国产操作系统银河麒麟V11。具体说明如下: Windows 11系统英特尔 NPU驱动程序明确支持Windows 11操作系统。作为微软最新的桌面操作系统,Windows 11在硬件兼容性方面进行了优化,能够为NPU提供稳定的驱动环境。

NPU(神经网络处理器)可适配多种操作系统。 Linux操作系统较为常用。它具有高度的灵活性和可定制性,许多科研机构、企业在开发基于NPU的深度学习模型训练和推理应用时,会选取Linux。

使用Copilot+ 电脑硬件Copilot+ 电脑是微软推出的新型Windows 11硬件,其核心优势在于集成高效能NPU,可支持AI密集型任务。例如,实时翻译、影像生成等场景中,NPU能提供每秒超40万亿次操作(TOPS)的算力,显著提升处理效率。用户若需高性能AI计算,可优先选取此类设备。

使用Copilot+电脑访问AI功能Copilot+电脑是微软推出的搭载高效能NPU的Windows 11设备,支持实时翻译、影像生成等AI密集型任务,NPU算力可达每秒超40万亿次操作(TOPS)。用户可通过此类设备直接调用AI功能,例如使用ONNX运行时以编程方式调用NPU进行模型推理,适用于需要高性能AI计算的场景。

操作系统要求:确保你的设备已经安装了Windows 11操作系统,因为这是在任务管理器中查看NPU占用率的必要条件。应用程序支持:虽然NPU可以在任务管理器中被监测到,但它的实际使用还取决于应用程序的支持。只有那些支持并利用NPU加速的应用程序才能充分利用NPU的性能。

做超级计算的linux需要什么配置

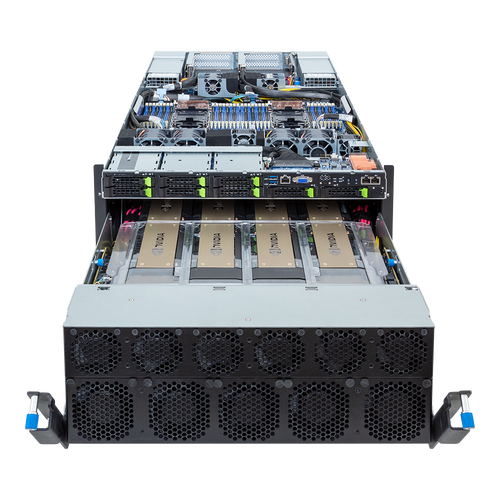

〖壹〗、硬件配置多核CPU服务器:超级计算依赖大规模并行计算,需选取多核心、高主频的CPU(如Intel Xeon或AMD EPYC系列),核心数越多,并行任务处理能力越强。GPU服务器:若涉及深度学习或科学计算,需配备NVIDIA Tesla、A100等加速卡,利用CUDA核心实现GPU并行计算,显著提升浮点运算性能。

〖贰〗、Linux基本命令和Shell脚本编写:由于超算平台通常运行在Linux系统上,因此需要熟悉基本的Linux命令和Shell脚本编写。 作业管理系统Slurm:了解如何提交、监控和管理作业,以便充分利用计算资源。 编程技能:掌握编程语言和脚本编写,以便在科学计算和数据分析中开发高效的计算代码。

〖叁〗、既然是超级计算机,自然要使用高性能的固态硬盘SSD,每个IO节点有2TB的SSD,IO带宽达到5GB/s,从下图可以看出1个2TB SSD由5个400GB 小SSD组成,那估计每个的带宽是1GB/s。IO节点对外有两种接口:高速互联接口和Infiniband QDR存储网络接口。

从0开始搭建AI绘图工具

从0开始搭建AI绘图工具指南 要从零开始搭建一个AI绘图工具,你可以遵循以下步骤,这些步骤涵盖了从购买云服务器到配置和运行AI绘图工具的整个过程。购买GPU云服务器 首先,你需要购买一台带有GPU的云服务器,因为AI绘图工具通常需要大量的计算资源,特别是图形处理能力。

款AI绘图免费软件实测推荐!零基础也能秒变大师0 Stable Diffusion 推荐理由:近来最强大的开源AI绘画模型之一。只需输入一句提示词(prompt),就能快速生成令人惊叹的绘画作品。它支持多种风格和主题,无论是写实、动漫还是科幻风格,都能轻松驾驭。

首先,你需要访问笔魂AI绘图工具的官方网站。在浏览器中输入正确的网址,即可进入该工具的界面。这是使用笔魂AI绘图工具的第一步,也是后续所有操作的基础。输入文字描述 进入工具界面后,你会看到一个输入框。在这里,你可以输入你想要生成的图片的文字描述。

fooocus是一款基于Gradio的图像生成软件,专为AI绘图设计。它最大的特点是简单易操作,用户只需关注提示词的书写,即可生成高质量的图片。这款工具由斯坦福大学博士生张吕敏(网名lllyasviel)开发,他是controlnet的制作者,对fooocus进行了大量的优化,使其比midjourney等工具更加易用。

如何在服务器使用显卡

〖壹〗、方案一(ubuntu-drivers模式):使用sudo ubuntu-drivers devices命令显示系统中检测到的显卡及其推荐的驱动状态。使用sudo ubuntu-drivers install --gpgpu命令自动检测并安装最适合硬件的驱动程序。

〖贰〗、准备工作确认硬件兼容性检查服务器主板是否具备PCIe插槽(通常为x16规格),这是外接显卡的核心接口。若服务器无内置PCIe插槽,需通过PCIe扩展卡或外置显卡坞(如Thunderbolt 3/4接口设备)实现连接,但后者可能受带宽限制影响性能。

〖叁〗、准备工作确认服务器兼容性需检查服务器是否具备PCIe插槽(常见为x8或x16规格),这是外接显卡的硬件基础。部分服务器可能需通过扩展卡或转接板支持额外PCIe通道。选取适配显卡根据服务器用途(如计算、渲染或AI训练)选取显卡型号,需确保显卡尺寸(如全高/半高)与机箱空间匹配,且电源功率足够。

〖肆〗、我个人偏好第三种方法,因为它对显卡无损。测试了Intel S5000VSA主板,使用PCI-E 8X转16X转接线连接影驰GT240显卡,成功点亮显示器并正常运行,但未安装Windows系统,未能进一步测试显卡性能。尽管如此,这种方法在大多数情况下都是可行的,可以满足临时或偶尔使用服务器作为图形处理设备的需求。

如何在Linux系统中安装GPU驱动

〖壹〗、确认GPU型号 使用命令lspci | grep i nvidia来识别你的GPU型号,这是选取对应驱动程序的基础。选取并安装CUDA和驱动程序 确定版本:对于PyTorch等深度学习框架,推荐使用CUDA 18配合NVIDIA驱动450.80.02或更新版本。

〖贰〗、在Linux系统中安装GPU驱动,可以按照以下步骤进行:版本对齐:选取合适的版本:确保选取的CUDA版本与GPU驱动程序版本相匹配,通常推荐使用CUDA的最新稳定版本,以保证最佳性能和兼容性。访问NVIDIA官方网站:访问NVIDIA的CUDA Toolkit Archive页面,根据GPU型号和操作系统选取相应的版本。

〖叁〗、欲在Linux环境下查看GPU显卡及安装驱动,关键命令与步骤如下。首先,使用`nvidia-smi`命令,它能直观显示GPU状态,如:GPU名称、计算速度、温度等,帮助诊断硬件问题。安装过程分三步。第一步,访问NVIDIA官方网站,根据系统类型下载合适的驱动。第二步,执行安装程序。

〖肆〗、在Linux/Ubuntu系统中安装NVIDIA驱动的步骤及问题解决策略如下:准备阶段:确认硬件信息:确保你知道自己的NVIDIA GPU型号,例如GTX 1060。下载对应驱动:根据GPU型号,从NVIDIA官方网站下载适用于你的Linux/Ubuntu系统的驱动程序。禁用开源驱动Nouveau:在命令模式下输入相关指令,保存并重启电脑。

〖伍〗、关闭桌面管理器(Ubuntu默认为lightdm,其他系统可能为gdm或kdm),以便在安装驱动前确保系统稳定。执行runfile安装驱动,注意操作步骤的顺序和细节。安装完成后,使用`nvidia-smi`命令检查NVIDIA设备是否正常工作。在成功安装NVIDIA驱动后,可以使用`nvidia-smi -pm 1`开启持久模式,以减少加载驱动的时间。

〖陆〗、在Linux系统中安装Nvidia驱动的步骤如下:禁用开源驱动Nouveau:在Ubuntu 04系统上,编辑配置文件以禁用Nouveau驱动。重启电脑并验证Nouveau驱动是否已被禁用。下载并准备Nvidia驱动文件:访问Nvidia官方网站,下载与你的系统平台及GPU型号相匹配的驱动文件。将下载的驱动文件上传到Linux服务器。

深度学习系统是用桌面版还是服务器版

如果以稳定性来说Server版的UBUNTU系统是要稳定一些的,两者无所谓,看你是否需要使用桌面图形,如果是在字符界面下操作那么server版本的更合适些,因为UBUNTU系统本来应用于深度学习环境就有很多兼容性问题,所以建议用server版本的。你可以询问下他们,他们主要做深度学习方向的GPU服务器和GPU工作站。

选取适合的Linux发行版本Fedora系列:推荐新手入门首选,尤其是RHEL(Red Hat Enterprise Linux)和CentOS系统。RHEL是企业级服务器系统,需订阅服务,但提供稳定支持;CentOS是其免费社区版,适合个人和企业使用。Fedora桌面版界面绚丽,适合个人学习;RHEL和CentOS则更注重服务器场景的规范性。

如需考虑学习成本,可以采用Windows开发环境搭配Linux服务器进行训练,但这并非最佳选取。微软自身在训练神经网络时,同样倾向于使用Linux。因此,Linux在深度学习环境方面有其独特优势。

可以使用腾讯云服务器(但注意您提到的可能是Cloud Studio,这是腾讯云提供的一个在线开发环境,而非直接指代服务器本身)进行深度学习,但需要配置相应的环境和软件。

对于深度学习初学者来说,前期使用轻薄本是否足够,需要从以下几个关键点来分析: 学习阶段的需求基础理论阶段:如果处于学习算法原理、编写简单模型(如全连接网络、小型CNN/RNN)的阶段,轻薄本完全够用。此时主要依赖Python、NumPy等工具,对算力要求极低。

gpu服务器用的什么系统

〖壹〗、GPU服务器通常使用的操作系统包括Windows Server、Linux和VMware ESXi。Windows Server是Microsoft开发的服务器操作系统,它支持多种GPU,并提供简单易用的图形界面,非常适合需要在Windows环境下进行开发和部署的项目。

〖贰〗、联想GPU系统概述如下:系统定位与架构:联想深腾7000G是一款基于GPU加速的高性能计算服务器,专为需要高计算性能的场景设计。采用Cluster架构,每个服务器节点配备GPU加速设备,结合Intel处理器的强大性能,提供高效运算能力。硬件配置:每个节点配备GPU加速设备,这些GPU设备专为图形处理和高度并行计算设计。

〖叁〗、NVIDIA下一代DGX GPU服务器确实将采用水冷散热系统。以下是关于这一信息的详细解 水冷散热系统的应用:NVIDIA在2024 SIEPR经济峰会上宣布,其下一代DGX GPU服务器将采用水冷散热系统。这一技术选取旨在提高服务器的散热效率,从而支持更高性能的GPU运行。

〖肆〗、考虑配套设施应用软件和服务的使用价值。考虑总体GPU集群系统软件的完善程度以及工程效率:例如像DGX这类GPU一体化的超级计算机,它有十分完善的从底层操作系统驱动Docker到其他部分都是固定且优化过的,这时效率就较高。

〖伍〗、GPU服务器的典型配置如下:CPU:类型:Intel Xeon 或 AMD EPYC系列。核心数:至少16核,以提供强大的多任务处理能力。主频:至少0GHz,确保高效的处理速度。缓存:至少64MB,以加快数据访问速度。GPU:类型:NVIDIA Tesla、Quadro或GeForce系列,专为并行计算而设计。

〖陆〗、GPU服务器BGP线路显卡物理机是一种配备独立显卡、通过BGP多线网络接入,并具备专业机房环境支持的特殊服务器,主要用于图形处理、异构计算及深度学习等高性能计算场景。

如何搭建多人共用的gpu服务器?

搭建多人共用的GPU服务器,可以按照以下步骤进行:选取服务器硬件:确保支持GPU:选取能够支持至少一个或多个高性能GPU的服务器硬件。考虑CPU、内存和硬盘:根据任务需求,选取性能强劲的CPU、足够的内存容量以及充足的硬盘空间。电源和散热:确保电源供应稳定且散热系统能够有效应对高负载运行时的热量问题。

电源:选取能够承载CPU和GPU消耗的电源,确保稳定运行。二级存储:固态硬盘或SATA硬盘,用于存储数据和系统文件。选取GPU 根据计算需求选取合适的GPU品牌和型号。特斯拉工作站产品(C系列):主动降温,适合桌面计算机。服务器产品(M系列):被动降温,适合安装在服务器上。

管理、磁盘、网络、SSH密钥:在“管理”下方找到“可用性策略”,如需要创建可抢占实例(以相对低廉的费用使用高性能的GPU服务器,但有效期只有24小时,过期或遇到特殊情况会被自动删除),只需将“抢占”设置为开启。SSH密钥部分可以暂时忽略,后续会详细讲解。

为GPU创建Resource Mapping:在Proxmox上创建Resource Mapping,实现GPU设备的池化管理,便于虚拟机动态分配。部署DoraCloud云桌面 在线安装DoraCloud:使用一键安装脚本在线安装DoraCloud。基础配置:安装后,进入DoraCloud后台,根据配置向导完成虚拟化、资源池、集群、用户数据库的配置。

连接两个GPU服务器到互连设备上:物理连接:使用专用的InfiniBand线缆将两台服务器的InfiniBand网卡连接起来。检查连接:确保连接稳定且无误,避免松动或接触不良导致的通信故障。设置驱动程序:安装驱动:在每台服务器上安装InfiniBand网卡的驱动程序,确保它们能够正常工作。

高性能GPU服务器集群拓扑及组网方案如下:硬件拓扑 主机配置:每台主机配备8块高性能GPU,机型包括A100、A800、H100、H800。内部硬件架构:PCIe总线:提供高效数据传输,支持CPU、内存、NVME、GPU和网卡等设备互联。PCIe Gen5提供卓越性能。

好了,关于gpu服务器装什么系统好和gpu服务器和普通服务器区别的问题到这里结束啦,希望可以解决您的问题哈!