极智算总结:

服务器上安装GPU的目的和意义是什么?

GPU服务器是指在服务器中安装了高性能的显卡(GPU),以提供更加强大的计算能力和图形处理能力。GPU服务器广泛应用于深度学习、图像处理、自然语言处理、科学计算等领域。GPU服务器的性能优越,可以大幅缩短计算时长,提高工作效率。由于GPU服务器费用较高,一般只有企业或者研究机构等拥有比较充足的资金才会购买。

GPU服务器是基于GPU的、应用于多种场景的快速稳定弹性计算服务,具有出色的图形处理和高性能计算能力,能提升计算处理效率,满足各类互联网应用需求。具体作用如下:深度学习领域简单深度学习模型:GPU服务器可为机器学习提供训练或者预测服务。

GPU服务器是基于GPU的计算服务,适用于视频编解码、深度学习、科学计算等场景,提供高性能图形处理与计算能力;普通服务器则以CPU为核心,适用于常规办公、Web服务等低负载场景。两者在核心组件、应用场景、性能特点上存在显著差异。

不再被GPU各种驱动绑架!一站式解决GPU问题

不再被GPU各种驱动绑架!一站式解决GPU问题 对于需要进行AI项目的同学而言,寻找和支持各种版本的GPU驱动无疑是一项艰巨的任务。找到驱动后又常常面临各种不兼容的问题,这极大地影响了项目的进度和效率。然而,随着云计算技术的飞速发展,云GPU服务器已经为解决这类问题提供了有效的方案。

电脑内存不足同样可能导致游戏报错。在玩游戏之前,建议关闭不必要的程序,为游戏腾出足够的内存空间。这可以通过任务管理器来完成,结束那些占用大量内存的进程。通过以上步骤,应该能够解决《流放之路2》侦测到老旧的GPU驱动的问题。如果问题仍然存在,建议访问游戏论坛或联系游戏客服,寻求更专业的帮助。

在英雄联盟客户端的设置中,将图像偏好设置为DX9传统模式,这有助于解决某些与显卡驱动兼容性的问题。卸载腾讯WeGame:有玩家反映,卸载腾讯WeGame后,英雄联盟的运行变得更加流畅,不再出现GPU驱动重启的问题。如果安装了WeGame并遇到此问题,可以尝试卸载后观察是否有所改善。

GPU云服务器常见问题及故障解决方案

解决方式:安装图形驱动的实例:手动安装VNC Server,通过VNC Client登录。系统启动失败:检查第三方软件冲突,卸载问题软件或重装系统。常见问题解答 什么是NVIDIA Tesla?定义:NVIDIA推出的高性能计算产品线,专为科学计算、HPC及超大规模数据中心设计。

解决方案: 检查网络连接:确保服务器网络连接正常,无物理或逻辑故障。 优化网络配置:根据业务需求,调整网络带宽、安全组规则等配置。 使用内网互通:在云服务商提供的内网环境下,实现GPU云服务器与其他云产品的快速互通。

综上所述,云GPU服务器为解决GPU驱动和兼容性问题提供了有效的方案。通过选取合适的云GPU服务器和配置环境,用户可以轻松享受高性能的计算服务,专注于AI项目的研发和创新。

如何在服务器使用显卡

〖壹〗、方案一(ubuntu-drivers模式):使用sudo ubuntu-drivers devices命令显示系统中检测到的显卡及其推荐的驱动状态。使用sudo ubuntu-drivers install --gpgpu命令自动检测并安装最适合硬件的驱动程序。

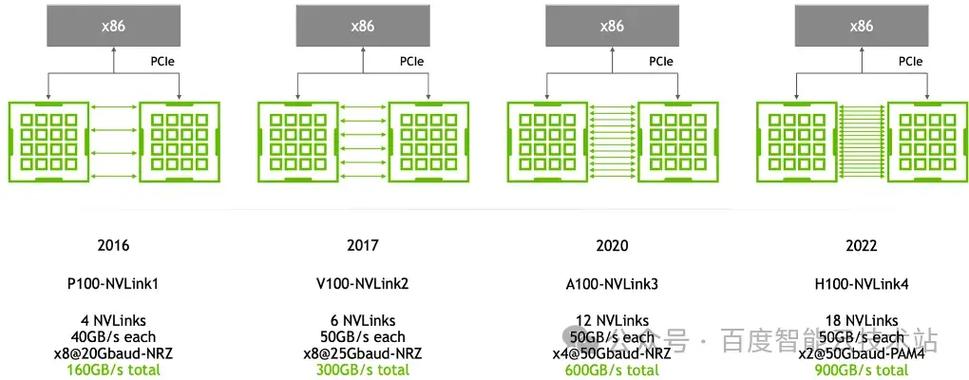

〖贰〗、准备工作确认硬件兼容性检查服务器主板是否具备PCIe插槽(通常为x16规格),这是外接显卡的核心接口。若服务器无内置PCIe插槽,需通过PCIe扩展卡或外置显卡坞(如Thunderbolt 3/4接口设备)实现连接,但后者可能受带宽限制影响性能。

〖叁〗、固定与接线:重新安装扩展卡模块(如需),连接显卡的辅助供电线,并检查所有线缆是否牢固。通电测试:启动服务器后,通过BIOS或系统日志确认显卡是否被识别。若未显示,需检查PCIe插槽是否启用或尝试更换插槽。

华为服务器如何安装四张算力卡

〖壹〗、安装算力卡:打开服务器的机箱,找到PCIe插槽。将算力卡插入PCIe插槽中,确保插卡时插头与插槽对应正确,且插卡完全插入位。根据需要,安装Riser卡或拉手条,以及相应的电源线缆。重复此步骤,直至四张算力卡均安装完毕。服务器上电与驱动安装:关闭机箱,重新连接电源线,并启动服务器。

〖贰〗、华为服务器安装四张算力卡,首先要确保服务器具备相应的扩展插槽来支持这么多算力卡。 准备工作: - 确认服务器型号及支持的扩展规格,了解其PCIe插槽的数量、带宽等参数,看是否能容纳四张算力卡。 - 准备好四张适配的算力卡,确保其与服务器兼容。

〖叁〗、升腾芯片:AI加速卡市场占比提升至15%在2024年国内AI加速卡市场中,华为升腾910/910B系列产品成为除英伟达外的主要选取,市场占有率从2023年的11%提升至15%。

〖肆〗、虚拟化支持 华为云提供NPU虚拟化技术,将物理机中的升腾AI处理器(NPU)切分为多个虚拟NPU(vNPU),并挂载至容器中使用。这种技术允许单台服务器的NPU资源被划分为多个vNPU,供不同用户按需申请,从而降低算力使用成本。

好了,本文到此结束,如果可以帮助到大家,还望关注本站哦!