极智算总结:

- 高性能GPU服务器集群拓扑及组网方案

- 服务器自己搭建好还是租用好

- GPU服务器需要什么配置

- ...元全功能二合一白群晖,8100T,蜗牛小机箱,M2固态,本地GPU服务器...

- 如何搭建多人共用的gpu服务器?

- 如何科学的搭建一台深度学习服务器?

- 搭建一台大模型服务器怎样配置好?

- 8块4090显卡!机架式GPU服务器方案

高性能GPU服务器集群拓扑及组网方案

〖壹〗、测试时需搭配200Gbps交换机以发挥卡间性能。L40S架构优化数据路径,采用单机4卡设计消除主机带宽瓶颈。综上所述,高性能GPU服务器集群拓扑及组网方案需综合考虑硬件拓扑、内部互联技术、网络技术选取以及带宽分析等因素,以实现高效的数据传输和计算性能。

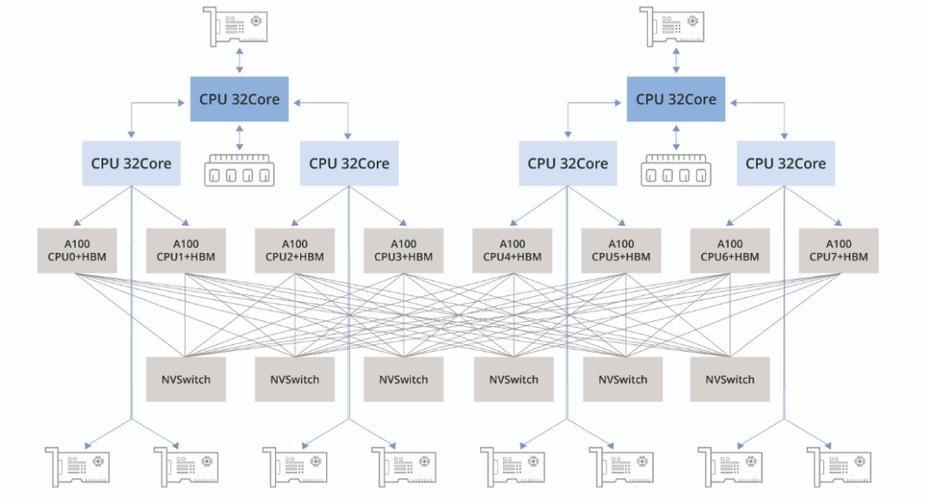

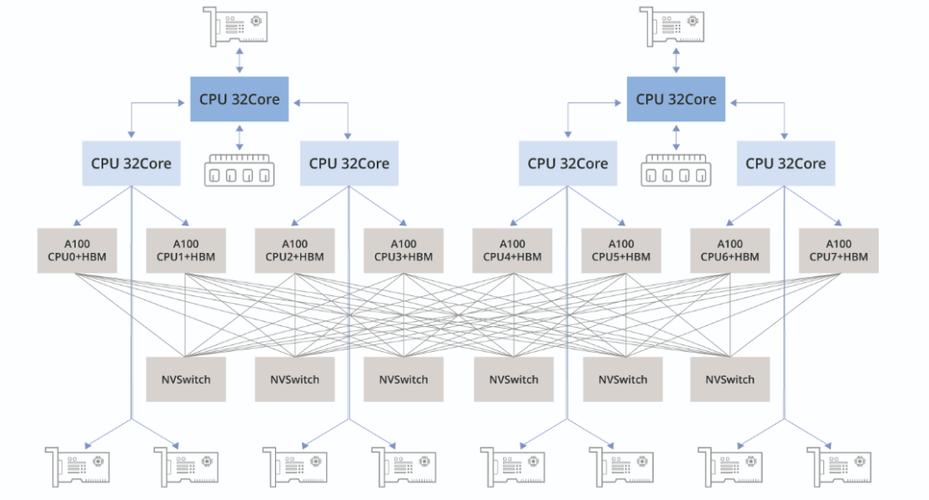

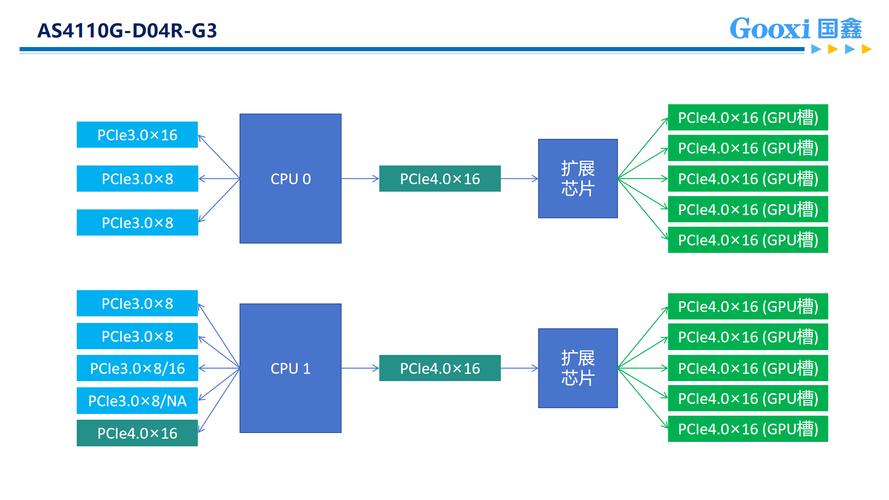

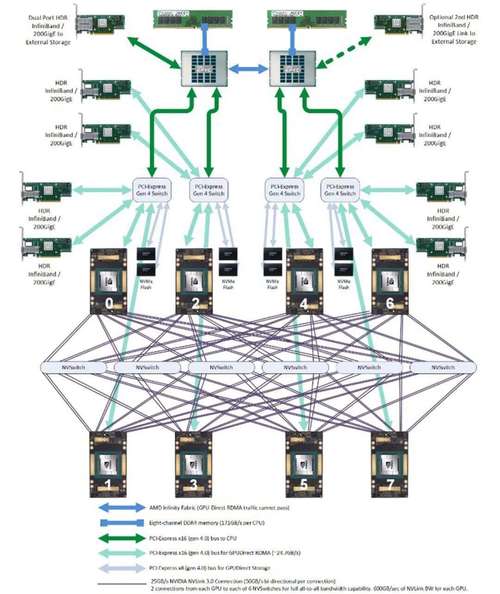

〖贰〗、高性能GPU服务器集群拓扑及组网方案 高性能GPU服务器硬件拓扑与集群组网,采用集群式架构,每台主机配备8块高性能GPU,包括A100、A800、H100、H800四种机型。典型8*A100GPU主机内部硬件架构包括高效互联的PCIe总线、NVLink、DCGM监视工具、NVSwitch交换芯片等。

〖叁〗、在GPU/TPU集群网络组网中,NVLink、InfiniBand、ROCE以太网Fabric以及DDC网络方案是当前流行的技术选取。这些技术各有优劣,适用于不同的场景和需求。以下是对这些技术的详细分析:NVLink交换系统 优势:高速点对点链路:NVLink是专门设计为连接GPU的高速点对点链路,具有比传统网络更高的性能和更低的开销。

服务器自己搭建好还是租用好

〖壹〗、避免自行搭建:除非企业具备独立机房、专业团队及持续维护能力,否则自行搭建成本高、风险大,性价比低于托管或租用。总结:企业应根据业务规模、技术能力、成本预算及长期规划综合决策。若无特殊需求,租用服务器更简单高效;若需高度定制化与控制权,托管是更优选取。

〖贰〗、综上所述,服务器托管在节约成本、灵活性和可靠性方面相较于自建机房具有显著优势。因此,对于数据型公司来说,选取服务器托管是一个更为明智的决策。

〖叁〗、自行搭建本地服务器需要购买硬件和网络设备,涉及较大的初始投资。而租用主机通常只需支付相对较低的月费或年费,无需承担高额的前期成本。租用主机的服务商通常拥有专业的技术团队,提供24/7的技术支持和维护,这对于没有技术背景的用户来说是极大的便利。

〖肆〗、线路:在服务器托管中,企业不必租用昂贵的网络线路,可以共享或独享数据中心高速带宽。服务器托管比自建机房更具有灵活性 在服务器托管中,可以根据自己的需求灵活选取自己想要获取的增值服务,达到灵活调配资源,充分应用资源的目的。

〖伍〗、如果对安全要求比较低,用户规模比较小的,只是一般的企业展示型网站,选取租用云服务会更划算。除此外,未来一段时间对服务器性能需求存在波动的用户,也建议选取租服务器,避免硬件升级浪费。而如果对安全要求高的,访问量、用户规模较大的,例如电商、金融等平台,就适合选取购买服务器。

〖陆〗、首先,租用服务器对于直接购买服务器有绝对优势(包括可以按需租用,根据游戏客流量大小选定所需租用的服务器大小,性能,带宽等等),而且无需自行维护,费用相对于自行购买服务器便宜,且无需担心电源、网络问题,省心省力。另外如果假设一个手游,可惜借鉴下图,以及优势可以了解一下。

GPU服务器需要什么配置

〖壹〗、GPU服务器需要以下关键配置:高性能的GPU:核心部件:高性能GPU是GPU服务器的核心,直接影响服务器的处理能力。选取要点:通常选取专业级GPU,如NVIDIA的Tesla或Quadro系列、AMD的Radeon Instinct系列。需关注内存容量、浮点计算能力(TFLOPS)、内存带宽及最大显示分辨率。

〖贰〗、内存配置:根据任务需求选取内存容量,深度学习和大数据分析任务通常需要较大容量内存(如32GB或64GB)。存储性能:高速SSD存储能加快数据加载和读取速度,提高整体效率。网络带宽:对于大规模数据传输,选取支持10GbE或更高网络速度的服务器。考虑预算与性价比 高性能GPU通常成本较高,需在性能和预算间平衡。

〖叁〗、GPU服务器的典型配置如下:CPU:类型:Intel Xeon 或 AMD EPYC系列。核心数:至少16核,以提供强大的多任务处理能力。主频:至少0GHz,确保高效的处理速度。缓存:至少64MB,以加快数据访问速度。GPU:类型:NVIDIA Tesla、Quadro或GeForce系列,专为并行计算而设计。

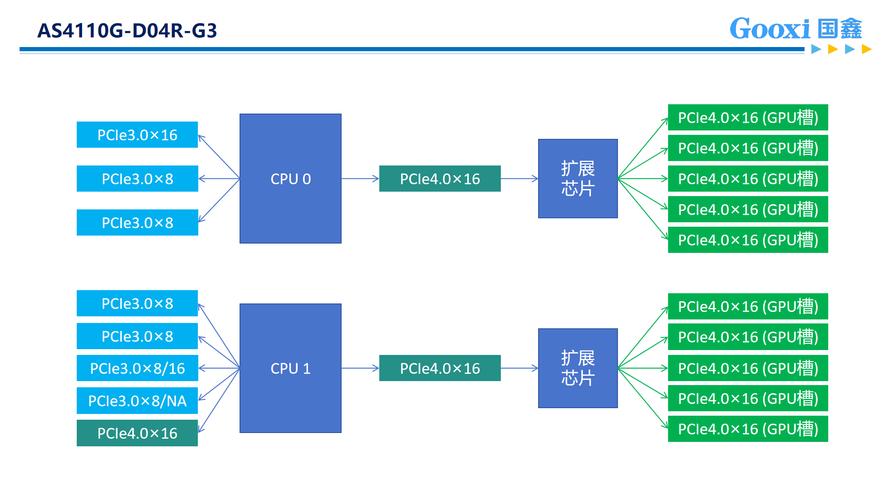

〖肆〗、PCIe版本:PCIe 0/0提供更高传输带宽,需匹配服务器主板支持。 尺寸与插槽:全高/半高、双槽/单槽设计需符合机箱空间。 多卡支持:NVLink或SLI技术对多GPU协同工作至关重要。散热与功耗 TDP(热设计功耗):高功耗GPU(如300W以上)需配套散热方案和电源冗余。

〖伍〗、核心功能与硬件配置GPU加速能力:通过加装独立显卡(如NV GT730 2G显存),GPU服务器可承担图形渲染、浮点运算等CPU不擅长的任务。例如,NV GT730显卡支持GDDR5显存,能高效处理3D图形应用程序、视频解码等场景。异构计算架构:结合CPU与GPU的并行计算能力,显著提升科学计算、深度学习等任务的运算速度。

...元全功能二合一白群晖,8100T,蜗牛小机箱,M2固态,本地GPU服务器...

机箱:蜗牛B款,虽然空间略小,但通过巧妙布局实现了高性能NAS的搭建。系统搭建与优化 系统选取:二合一白群晖系统,引导在固态上,提升开机速度。版本选用DSM3,洗白后可以使用QC教程进行进一步优化。

如何搭建多人共用的gpu服务器?

搭建多人共用的GPU服务器,可以按照以下步骤进行:选取服务器硬件:确保支持GPU:选取能够支持至少一个或多个高性能GPU的服务器硬件。考虑CPU、内存和硬盘:根据任务需求,选取性能强劲的CPU、足够的内存容量以及充足的硬盘空间。电源和散热:确保电源供应稳定且散热系统能够有效应对高负载运行时的热量问题。

电源:选取能够承载CPU和GPU消耗的电源,确保稳定运行。二级存储:固态硬盘或SATA硬盘,用于存储数据和系统文件。选取GPU 根据计算需求选取合适的GPU品牌和型号。特斯拉工作站产品(C系列):主动降温,适合桌面计算机。服务器产品(M系列):被动降温,适合安装在服务器上。

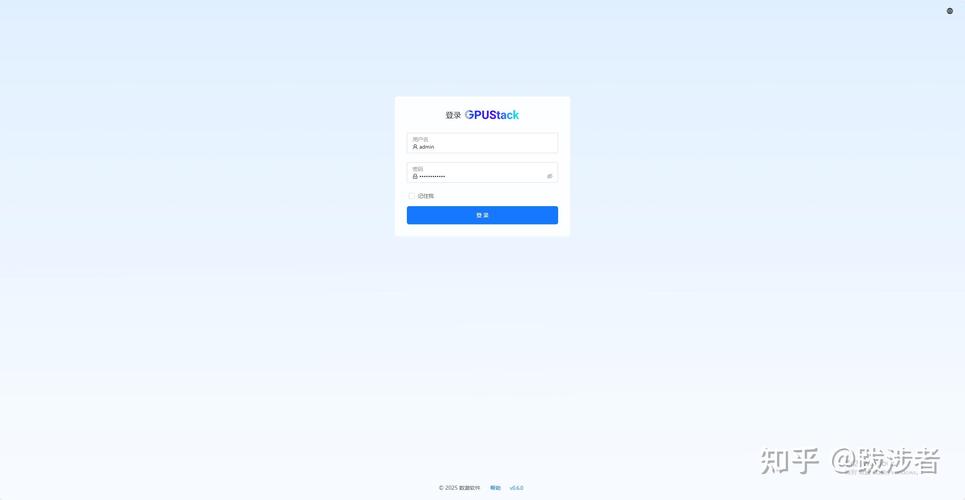

为GPU创建Resource Mapping:在Proxmox上创建Resource Mapping,实现GPU设备的池化管理,便于虚拟机动态分配。部署DoraCloud云桌面 在线安装DoraCloud:使用一键安装脚本在线安装DoraCloud。基础配置:安装后,进入DoraCloud后台,根据配置向导完成虚拟化、资源池、集群、用户数据库的配置。

连接两个GPU服务器到互连设备上:物理连接:使用专用的InfiniBand线缆将两台服务器的InfiniBand网卡连接起来。检查连接:确保连接稳定且无误,避免松动或接触不良导致的通信故障。设置驱动程序:安装驱动:在每台服务器上安装InfiniBand网卡的驱动程序,确保它们能够正常工作。

高性能GPU服务器集群拓扑及组网方案如下:硬件拓扑 主机配置:每台主机配备8块高性能GPU,机型包括A100、A800、H100、H800。内部硬件架构:PCIe总线:提供高效数据传输,支持CPU、内存、NVME、GPU和网卡等设备互联。PCIe Gen5提供卓越性能。

GPU服务器配置:安装wget-ssl和nv驱动,确保GPU服务器的正常运行。配置ShellClash等网络工具,提升网络使用体验。系统优化:禁用NAS因磁盘过热而自动关机的功能,通过其他方式解决M.2 sata过热问题(如增加散热片)。定期清理系统垃圾文件,保持系统整洁。

如何科学的搭建一台深度学习服务器?

〖壹〗、科学的搭建深度学习服务器需要综合考虑GPU、CPU、内存、磁盘存储和服务器机架等多个方面。在选取时,需根据具体任务需求、预算和可用空间等因素进行权衡。通过合理的配置和搭配,可以搭建出性价比高、性能强劲的深度学习服务器,满足各种深度学习任务的需求。

〖贰〗、综上所述,科学的搭建一台深度学习服务器需要综合考虑GPU、CPU、内存、磁盘存储及机架等多个方面。通过合理的配置与优化,可以构建出性价比高、性能稳定的深度学习服务器,满足各种深度学习任务的需求。

〖叁〗、总体方案概述在3500元的预算内,组装一台能够进行AI深度学习的基础服务器是可行的,但需要注意的是,这样的配置可能在性能和扩展性上有所限制。因此,我们需要在满足基本需求的前提下,尽可能优化硬件选取。

〖肆〗、深度学习环境搭建指南:配置深度学习环境服务器 安装Nvidiadocker:借鉴Nvidiadocker教程进行配置,确保可以在docker环境中使用GPU。拉取nvidia/cuda镜像:根据Linux版本和服务器cuda驱动版本,选取cudnn8devel版本,在服务器端拉取镜像。创建自定义镜像:自行创建dockerfile文件并命名为Dockerfile。

〖伍〗、搭建一台大模型服务器的配置建议 搭建一台用于运行大型模型(如大型语言模型)的服务器,需要综合考虑计算能力、内存、存储空间、网络、软件框架、安全性、扩展性以及预算等多个方面。

〖陆〗、选取云服务器规格 首先,登录潞晨云服务器的管理控制台。在控制台中,根据深度学习任务的需求,选取适合的云服务器规格。对于深度学习任务,特别是涉及图像识别、自然语言处理等复杂任务时,建议选取配置更高的GPU实例。GPU实例能够显著加速深度学习模型的训练和推理过程,提高计算效率。

搭建一台大模型服务器怎样配置好?

根据预算选取配置:服务器配置费用可能相差很大,根据您的预算和需求选取合适的配置。在有限的预算内,优先满足模型的计算、内存和存储需求,以确保服务器的性能和稳定性。总结 搭建一台大模型服务器需要综合考虑多个方面,包括CPU与GPU、内存、存储、网络、软件框架、安全性、扩展性和预算等。

方案三:基于RTX 5090的8卡服务器(理论配置)GPU配置:8块RTX 5090,每卡32GB显存,总显存256GB。可部署百亿级大模型(如DeepSeek、Qwen等),支持高并发、多任务推理负载。核心价值:集群扩展性强,适合科研工程化落地、大规模推理服务部署、高性能AI平台搭建等严苛场景。

OLLAMA_ORIGINS设置为*,表示允许所有来源访问Ollama服务。模型部署与共享 拉取大模型并安装:打开Ollama官方网站,单击Models菜单,选取DeepSeek-R1,根据推荐配置选取7B或14B大模型下载部署。

8块4090显卡!机架式GPU服务器方案

针对您提出的机架式GPU服务器方案需求,以下是一个基于8块NVIDIA Geforce RTX 4090显卡的详细方案。此方案旨在提供强大的计算力,以支持复杂的数据分析、机器学习及深度学习等任务。服务器基础配置 机箱:选取一款高质量的机架式服务器机箱,确保有足够的空间和散热能力来容纳8块RTX 4090显卡。

卡英伟达4090深度学习服务器 这款服务器搭载了8张NVIDIA Geforce RTX 4090涡轮版显卡,以其极致的计算性能和效率,能够显著减少深度学习模型的训练和推理任务时间。

方案二:4090 8GPU 4U机架式服务器GPU配置:8块NVIDIA GeForce RTX 4090,每卡24GB GDDR6X显存,集群总显存192GB。支持数十亿参数模型训练(如70亿参数模型全参数微调,130亿级模型LoRA/QLoRA微调)。

任务调度优化:采用Kubernetes集群管理,提高GPU利用率至85%以上。硬件迭代规划:与机房签订3年以上合约可获得15-20%的电费折扣。综上所述,托管八卡4090算力服务器到苏州胜网高电机房或中国电信苏州太湖世界数据中心都是较为划算的选取。

如果你还想了解更多这方面的信息,记得收藏关注本站。