极智算总结:

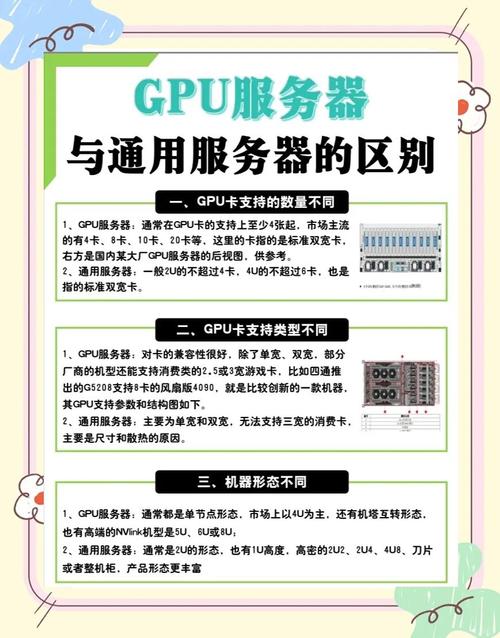

GPU服务器和普通服务器有什么区别?

〖壹〗、GPU服务器和普通服务器的主要区别如下:核心功能与应用场景 GPU服务器:基于GPU构建,主要应用于视频编解码、深度学习、科学计算等多种需要高性能计算的场景。GPU服务器提供快速、稳定、弹性的计算服务,并具备和标准云服务器一致的管理方式。

〖贰〗、显卡服务器(GPU服务器):由于GPU的大规模并行计算特性,其功耗较高。因此,GPU服务器需要更多的电力供应来支持其高性能的计算任务。硬件成本 普通服务器:相对较低的硬件成本,适用于小规模的计算需求。普通服务器的硬件配置相对简单,因此其成本也相对较低。

〖叁〗、GPU服务器:由于配备了高性能的GPU和相关的硬件资源,GPU服务器的费用通常较高。普通服务器:费用相对较为亲民,适合预算有限的用户或企业。稳定性与可靠性:GPU服务器:通常设计为能够长时间稳定运行,以满足高性能计算任务的需求。它们通常具有更高的可靠性和稳定性要求。

〖肆〗、GPU服务器和普通服务器之间的主要区别在于它们所针对的工作负载类型以及为此优化的硬件配置。以下是两者之间的一些关键差异:处理器(CPU)普通服务器:通常配备多核高性能中央处理器(CPU),这些CPU适用于处理大量并发请求或执行复杂的计算任务,如数据库查询、Web服务等。

〖伍〗、通用服务器:哪里都可以用,比如做私有云、分布式存储、管理节点、HPC通用算力节点等等。两者在业务场景定位上有所不同,GPU服务器更专注于高性能计算和图形处理等领域,而通用服务器则更为通用,适用于多种场景。

GPU服务器到底有什么作用?

GPU服务器的作用主要是提供基于GPU的快速、稳定、弹性的计算服务,应用于视频编解码、深度学习、科学计算等多种场景。以下是对GPU服务器作用的详细阐述:GPU加速计算提升性能GPU加速计算通过转移应用程序计算密集部分的工作负载到GPU,实现应用程序性能的显著提升。

GPU服务器:主要面向需要高性能计算能力的场景,如深度学习训练、图形渲染、科学计算等。GPU的并行处理能力在这些领域具有显著优势,能够大幅提升计算效率。普通服务器:适用于日常办公、网站托管、数据存储和基本的计算任务。它们通常不需要像GPU服务器那样强大的计算能力。

GPU服务器:适用于深度学习训练、视频渲染、科学计算等需要高性能计算的场景。例如,可以使用GPU服务器作为深度学习训练的平台,结合云服务器提供的计算服务、对象存储提供的云存储服务等,实现高效的深度学习训练。普通服务器:适用于一般的办公场景、数据存储、网站托管等。

GPU服务器是一种配备高性能图形处理器的服务器,其作用主要体现在图形处理与计算加速、深度学习与机器学习以及高性能计算集群等方面。 图形处理与计算加速: GPU服务器具备强大的并行处理能力,能够高效地进行图形处理和计算加速。

主要功能 GPU服务器主要承担高性能计算任务。与传统的CPU相比,GPU具备强大的并行处理能力,使其特别适合处理大规模数据和进行复杂计算。在服务器中的作用 并行计算能力提升:GPU拥有众多流处理核心,可以并行处理大量数据,极大地提升了服务器的计算能力。

定义 GPU服务器通过集成高性能的图形处理器,能够执行复杂的图形处理和大规模数据并行运算任务。主要作用 高性能计算:GPU服务器在高性能计算领域具有显著优势,其强大的浮点计算能力使得它能够快速处理大规模数据运算任务,提高计算效率。

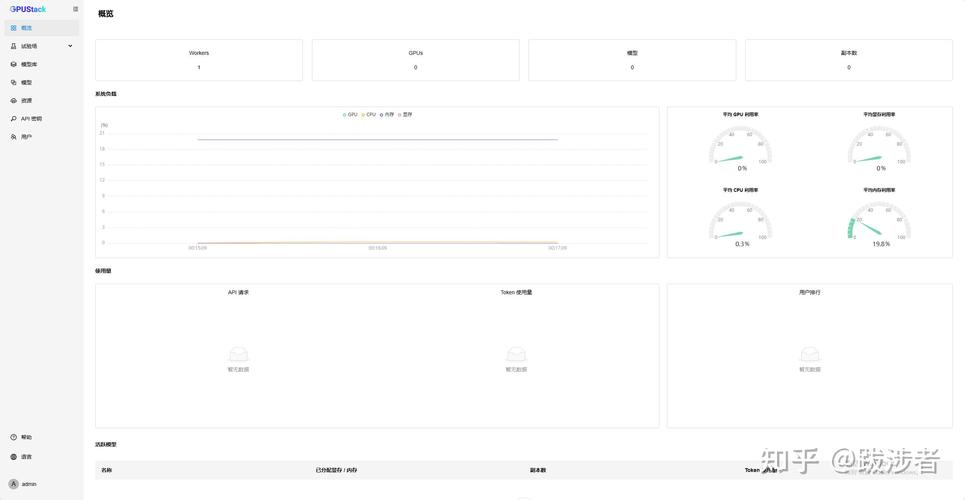

如何搭建多人共用的gpu服务器?

搭建多人共用的GPU服务器,可以按照以下步骤进行:选取服务器硬件:确保支持GPU:选取能够支持至少一个或多个高性能GPU的服务器硬件。考虑CPU、内存和硬盘:根据任务需求,选取性能强劲的CPU、足够的内存容量以及充足的硬盘空间。电源和散热:确保电源供应稳定且散热系统能够有效应对高负载运行时的热量问题。

为GPU创建Resource Mapping:在Proxmox上创建Resource Mapping,实现GPU设备的池化管理,便于虚拟机动态分配。部署DoraCloud云桌面 在线安装DoraCloud:使用一键安装脚本在线安装DoraCloud。基础配置:安装后,进入DoraCloud后台,根据配置向导完成虚拟化、资源池、集群、用户数据库的配置。

电源:选取能够承载CPU和GPU消耗的电源,确保稳定运行。二级存储:固态硬盘或SATA硬盘,用于存储数据和系统文件。选取GPU 根据计算需求选取合适的GPU品牌和型号。特斯拉工作站产品(C系列):主动降温,适合桌面计算机。服务器产品(M系列):被动降温,适合安装在服务器上。

管理、磁盘、网络、SSH密钥:在“管理”下方找到“可用性策略”,如需要创建可抢占实例(以相对低廉的费用使用高性能的GPU服务器,但有效期只有24小时,过期或遇到特殊情况会被自动删除),只需将“抢占”设置为开启。SSH密钥部分可以暂时忽略,后续会详细讲解。

高性能GPU服务器集群拓扑及组网方案如下:硬件拓扑 主机配置:每台主机配备8块高性能GPU,机型包括A100、A800、H100、H800。内部硬件架构:PCIe总线:提供高效数据传输,支持CPU、内存、NVME、GPU和网卡等设备互联。PCIe Gen5提供卓越性能。

高性能GPU服务器集群拓扑及组网方案

测试时需搭配200Gbps交换机以发挥卡间性能。L40S架构优化数据路径,采用单机4卡设计消除主机带宽瓶颈。综上所述,高性能GPU服务器集群拓扑及组网方案需综合考虑硬件拓扑、内部互联技术、网络技术选取以及带宽分析等因素,以实现高效的数据传输和计算性能。

高性能GPU服务器集群拓扑及组网方案 高性能GPU服务器硬件拓扑与集群组网,采用集群式架构,每台主机配备8块高性能GPU,包括A100、A800、H100、H800四种机型。典型8*A100GPU主机内部硬件架构包括高效互联的PCIe总线、NVLink、DCGM监视工具、NVSwitch交换芯片等。

高性能GPU服务器硬件拓扑与集群组网全攻略 在大模型训练领域,采用8卡GPU集群成为了普遍选取,例如A100、A800、H100、H800等机型。以8*A100 GPU主机为例,其内部硬件拓扑高效且强大,为训练提供了强有力的支持。

在GPU/TPU集群网络组网中,NVLink、InfiniBand、ROCE以太网Fabric以及DDC网络方案是当前流行的技术选取。这些技术各有优劣,适用于不同的场景和需求。以下是对这些技术的详细分析:NVLink交换系统 优势:高速点对点链路:NVLink是专门设计为连接GPU的高速点对点链路,具有比传统网络更高的性能和更低的开销。

两台GPU服务器卡要实现点对点组网,可以通过使用专用的高速互连网络来实现,比如InfiniBand(IB)网络。以下是具体的组网步骤:购买并安装专用高速互连设备:选取设备:根据两台GPU服务器的配置和需求,选取适合的InfiniBand设备。

Ares rack内部署1台frontend-TOR,连接每台服务器的2*100GE端口。但这种方式下,使用单200GE可能会降低布线、运维、管理复杂度,收益会明显大于分为2根线缆带来的可靠性提升。

服务器上安装GPU的目的和意义是什么?

〖壹〗、GPU服务器是指在服务器中安装了高性能的显卡(GPU),以提供更加强大的计算能力和图形处理能力。GPU服务器广泛应用于深度学习、图像处理、自然语言处理、科学计算等领域。GPU服务器的性能优越,可以大幅缩短计算时长,提高工作效率。由于GPU服务器费用较高,一般只有企业或者研究机构等拥有比较充足的资金才会购买。

〖贰〗、GPU服务器的作用主要是提供基于GPU的快速、稳定、弹性的计算服务,应用于视频编解码、深度学习、科学计算等多种场景。以下是对GPU服务器作用的详细阐述:GPU加速计算提升性能GPU加速计算通过转移应用程序计算密集部分的工作负载到GPU,实现应用程序性能的显著提升。

〖叁〗、GPU服务器是一种配备高性能图形处理器的服务器,其作用主要体现在图形处理与计算加速、深度学习与机器学习以及高性能计算集群等方面。 图形处理与计算加速: GPU服务器具备强大的并行处理能力,能够高效地进行图形处理和计算加速。

〖肆〗、GPU服务器是什么?GPU服务器是基于GPU(图形处理器)的应用,在视频编解码、深度学习、科学计算等多场景中提供稳定、快速且弹性的计算服务。GPU服务器的作用:GPU能够加速计算,提供卓越的应用软件性能。

〖伍〗、GPU服务器是一种配备了高性能图形处理器的服务器,其主要作用是进行高性能计算、图形渲染和深度学习等任务。以下是关于GPU服务器的详细解释:定义 GPU服务器通过集成高性能的图形处理器,能够执行复杂的图形处理和大规模数据并行运算任务。

〖陆〗、GPU服务器是一种利用图形处理器进行高性能计算的服务器。以下是关于GPU服务器的详细解主要功能 GPU服务器主要承担高性能计算任务。与传统的CPU相比,GPU具备强大的并行处理能力,使其特别适合处理大规模数据和进行复杂计算。

END,本文到此结束,如果可以帮助到大家,还望关注本站哦!