极智算总结:

- 中国长城推出4u8卡gpu服务器

- ...科研新动力:2024下半年8卡GPU服务器,科研界新宠

- 8卡算力服务器散热量

- 华为gpu服务器购买费用调研

- 8块4090显卡!机架式GPU服务器方案

- 8卡gpu服务器功率要求

中国长城推出4u8卡gpu服务器

〖壹〗、中国长城推出的4U8卡GPU服务器是一款高性能、高密度的计算解决方案,专为满足大规模并行计算和深度学习等应用需求而设计。

〖贰〗、龙芯服务器品牌有曙光、北方自控、诚迈科技、中核华辉、兴研科技、浪潮信息、中兴通讯、联想开天、中国长城、中科曙光、同方股份、浪潮计算机、超越科技、航天706所、国鑫、紫光股份(新华三)等。曙光:早期推出龙腾服务器填补空白,现有机架式、刀片等系列产品。

...科研新动力:2024下半年8卡GPU服务器,科研界新宠

综上所述,这两款8卡GPU服务器均具备出色的计算性能、稳定性和可扩展性,是科研工作者在2024年下半年进行深度学习研究和模型训练的理想选取。无论是选取RTX 4090还是A100显卡的服务器,都能为用户带来卓越的计算体验和科研成果。

8卡算力服务器散热量

〖壹〗、卡算力服务器的散热量通常在3600W至6800W之间,具体取决于GPU型号、功耗设计及运行状态。以下从关键参数、影响因素及散热设计三方面展开分析:核心散热参数不同GPU配置的散热需求差异显著。

〖贰〗、单卡FP16算力:148 TFLOPS 显存:96GB HBM3e 典型配置:8卡H20服务器(如戴尔XE9680)总算力1,184 TFLOPS(FP16),两台合计算力≥2,368 TFLOPS(FP16)或4,736 TFLOPS(FP8)。优势:显存容量大,适合高参数模型推理;支持FP8精度,算力翻倍。

〖叁〗、AI算力:搭载了20个GPU插槽,用户可以根据自身需求,采用最大20个单宽GPU卡或8个双宽GPU卡的模式进行算力的提升。同时,该服务器还能接入GPU、XPU、NPU等算力模块,满足用户在不同场景下的异构计算需求。数据传输:采用了PCle0协议,传输速率高达16GT/s,有效满足了大数据的传输需求。

〖肆〗、一般来说,在一些常见的深度学习计算任务中,单张H100的算力能达到数TFLOPS级别。如果是8卡H100,算力理论上能有较为可观的提升。但实际算力还会受到诸如硬件协同效率、散热情况、软件优化等多种因素影响。比如在某些大规模深度学习模型训练场景下,8卡H100组合起来的算力可能会达到几十甚至上百TFLOPS。

〖伍〗、支持更高分辨率生成。运维与采购建议 服务器平台优先选取支持PCIe 0的型号,并配备液冷散热系统,确保长时间高负载运行稳定性。模型推理时,环境温度控制在20±2℃,相对湿度≤60%,可提升能效比约15%。预算有限时,可先通过云端部署(如AWS、Azure)体验功能,再根据需求逐步升级本地硬件。

〖陆〗、核心定位与产品背景 Tesla P4:发布于2016年,是NVIDIA针对边缘计算和数据中心推出的专业加速卡,基于Pascal架构,专注于AI推理(如图像识别、语音处理)和视频转码,无显示输出功能,仅支持被动散热或服务器级主动散热。

华为gpu服务器购买费用调研

华为GPU服务器的费用因型号、配置和采购渠道不同差异较大,通常单台售价在10万至50万元人民币区间。影响费用的核心因素 GPU型号:搭载NVIDIA A100的机型比国产升腾910B成本高约30%-50%。 计算节点数量:8卡服务器(如Atlas 800)比4卡机型贵60%以上。

G6v.xlarge.2年费7,199元,相当于月均599元,较按月计费节省约13%。代理商折扣政策通过华为云代理商(如典名科技)购买,可享受折扣和返利政策,进一步降低企业成本。例如,G6v.xlarge.2年费实际支付约7,199×0.7×0.85=4,266元,较原价降低约41%。

企业级GPU服务器的费用区间通常在5万元至50万元人民币之间,具体取决于配置、品牌和应用场景。基础配置影响费用 入门级:搭载1-2张中端GPU(如NVIDIA T4或A10),费用约5-15万元,适合轻量级AI推理或图形处理。

腾讯云:新用户赠送额度高,但续费费用陡增,整体性价比一般。 生态支持(15%)优刻得(UCloud):预装TensorFlow、PyTorch等主流框架镜像,支持多模态大模型训练,联合DeepWisdom推出AI Agent开发平台MGX,提供全球智算网络支持。阿里云:生态资源丰富,但部分高级功能需额外购买。

8块4090显卡!机架式GPU服务器方案

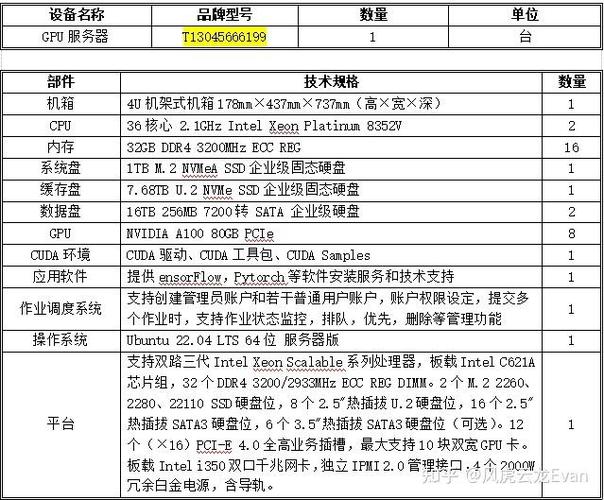

〖壹〗、针对您提出的机架式GPU服务器方案需求,以下是一个基于8块NVIDIA Geforce RTX 4090显卡的详细方案。此方案旨在提供强大的计算力,以支持复杂的数据分析、机器学习及深度学习等任务。服务器基础配置 机箱:选取一款高质量的机架式服务器机箱,确保有足够的空间和散热能力来容纳8块RTX 4090显卡。

〖贰〗、卡英伟达4090深度学习服务器 这款服务器搭载了8张NVIDIA Geforce RTX 4090涡轮版显卡,以其极致的计算性能和效率,能够显著减少深度学习模型的训练和推理任务时间。

〖叁〗、方案二:4090 8GPU 4U机架式服务器GPU配置:8块NVIDIA GeForce RTX 4090,每卡24GB GDDR6X显存,集群总显存192GB。支持数十亿参数模型训练(如70亿参数模型全参数微调,130亿级模型LoRA/QLoRA微调)。

〖肆〗、任务调度优化:采用Kubernetes集群管理,提高GPU利用率至85%以上。硬件迭代规划:与机房签订3年以上合约可获得15-20%的电费折扣。综上所述,托管八卡4090算力服务器到苏州胜网高电机房或中国电信苏州太湖世界数据中心都是较为划算的选取。

〖伍〗、张4090跑70B参数的详细解释如下:显卡配置:8张NVIDIA RTX 4090 48GB GPU可以支撑70B(即700亿)参数大模型的分布式训练。这种配置能够轻松实现高效并行计算,无论是多模态联合优化还是超大规模语言模型微调。

〖陆〗、图灵计算工作站GX660M是一款集高性能计算与静音环境于一体的超级异构计算系统。它支持双Xeon第4代可扩展处理器,并比较高可配置8块RTX第4代GPU超算卡(包括RTX 4090和RTX 6000Ada等),同时支持PCIe 0总线,为海量存储和高效计算提供了坚实基础。

8卡gpu服务器功率要求

卡算力服务器的散热量通常在3600W至6800W之间,具体取决于GPU型号、功耗设计及运行状态。以下从关键参数、影响因素及散热设计三方面展开分析:核心散热参数不同GPU配置的散热需求差异显著。

一块GPU卡一般耗电350W,一般4U的服务器最大可以支持8块GPU卡,通常业内多称之为8卡GPU服务器,当然也有4卡,6卡的。如果装满8卡GPU,那么其耗电在2800瓦,差不多就是 13A电力。

中配置GPU服务器:当服务器搭载中等数量的GPU(如4-6张)时,其功率会相应增加,可能在2000W-4000W之间。这类服务器能够满足大多数高性能计算和深度学习等应用的需求。高配置GPU服务器:对于配置了8张或更多高性能GPU卡的服务器,其功耗可能会逼近甚至超过4000W,甚至达到5000W以上。

功耗估算 典型工作负载下的功耗:一种观点认为,H200八卡服务器在典型工作负载下的整机功耗约为3500-4200W。这个范围提供了一个大致的功耗借鉴。最大耗电量:以H800 GPU PCIE 服务器整机为例(虽非H200,但可作为借鉴),其最大耗电量约为6800W。

关于8卡gpu服务器到此分享完毕,希望能帮助到您。

标签: gpu服务器