极智算总结:

- 阿里云GPU服务器推荐

- a100gpu是算力服务器吗

- GPU服务器直通和switch区别

- 服务器GPU配置的费用区间是多少

- GPU云服务器厂商综合评测与排名(2025年更新版)

- 为什么顶级团队都在抢着使用gpu服务器?

阿里云GPU服务器推荐

〖壹〗、大模型推理加速:DeepGPU中的大语言模型推理引擎(DeepGPU-LLM)提供了高性能的大模型推理服务,经过调优后,多卡集合通信性能显著提升。显存优化:在显存方面,DeepGPU也提供了优化方案,能够显著降低显存占用,提高资源利用率。

〖贰〗、阿里云服务器可以选取显卡,其GPU服务器支持配置专业级GPU卡。

〖叁〗、阿里云GPU云服务器详解:NVIDIA AV100、TPP100 GPU卡 阿里云GPU云服务器(GPU Cloud Computing,GPU)提供GPU算力的弹性计算服务,具有超强的计算能力,适用于深度学习、科学计算、图形可视化、视频处理等多种应用场景。

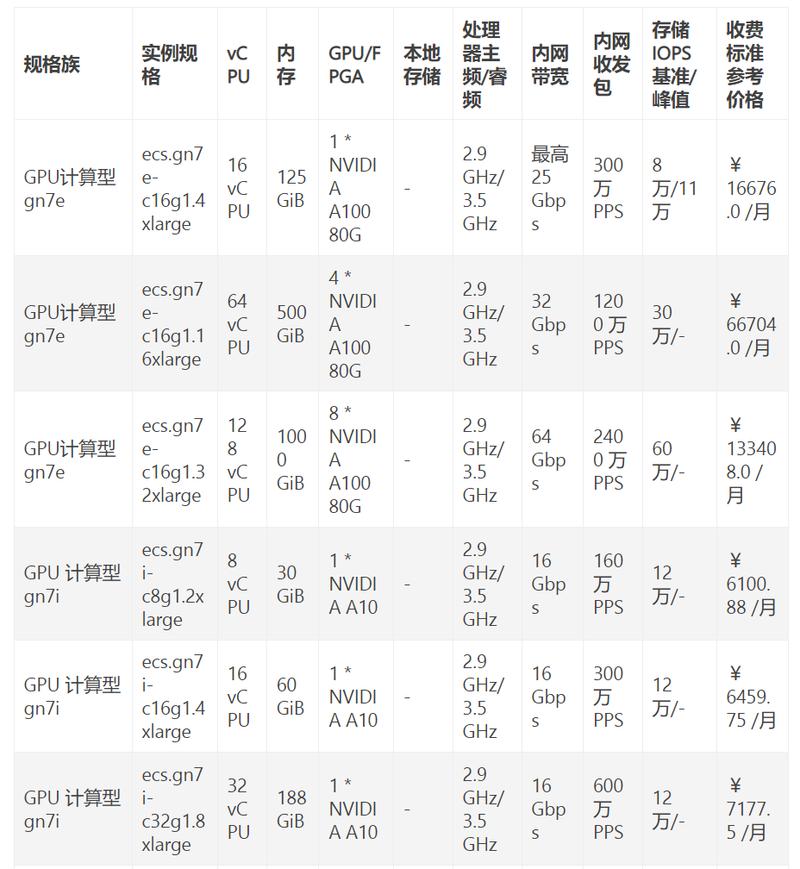

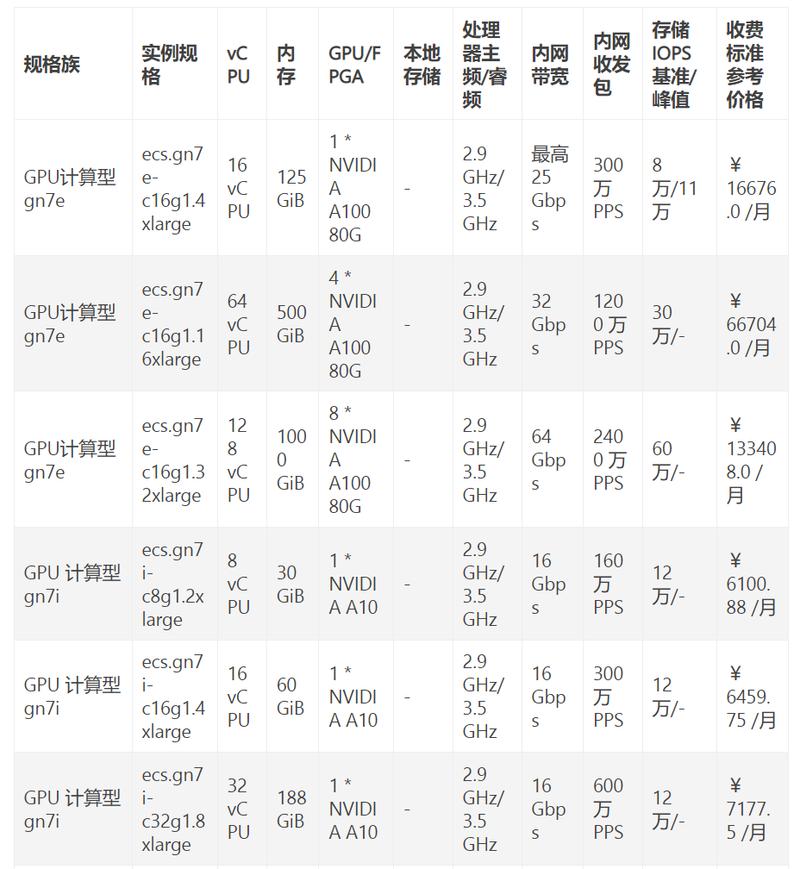

〖肆〗、GPU计算型gn6i(T4卡):配置为4核15G内存,包月优惠价1681元/月起,包年16148元/年起(约4折),适用于图形渲染、视频处理。GPU计算型gn6v(V100卡):配置是8核32G内存,包月3830元/月起,用于深度学习、科学计算。

a100gpu是算力服务器吗

A100 GPU本身不是完整的算力服务器,但它是构成算力服务器的核心组件之一。算力服务器是搭载高性能图形处理器(GPU)的云计算服务器,其核心功能是通过多块高端显卡的协同计算,实现大规模并行处理能力。

A100是英伟达2020年发布的旗舰级数据中心GPU,基于Ampere架构,具有强大的计算能力和高带宽显存,适用于高性能计算(HPC)和深度学习任务。

A100 80G SXM4是一款具备超强算力的GPU服务器,适用于深度学习、人工智能及大数据分析等高性能计算场景。其核心优势体现在硬件架构、内存性能、加速能力及管理功能四个方面,具体如下: 核心硬件架构GPU型号与架构:搭载NVIDIA A100 Tensor Core GPU,基于7nm工艺的GA100架构,专为高性能计算设计。

英伟达A100显卡的算力非常高,具体表现如下:AI训练峰值算力:312TFLOPS。这使其在处理复杂的人工智能任务时具有出色的性能。AI推理峰值算力:1248TOPS。这意味着A100在进行快速、高效的推理任务时同样表现出色,适用于需要实时响应的应用场景。

DGXA100 AI 是世界上第一台单节点 AI 算力达到 5 PFLOPS 的服务器 ,每台 DGX A100 可以分割为多达 56 个独立运行的实例,还集合了 8 个 NVIDIA A100 GPU,每个 GPU 均支持 12 路 NVLink 互连总线据了解,与。

GPU服务器直通和switch区别

定义与结构直通模式:在此模式下,GPU直接连接到CPU,不经过任何中间交换芯片(switch芯片)。这种设计简化了数据传输路径,使得CPU到GPU的通信效率较高。Switch模式:在此模式下,GPU之间通过内置的switch芯片进行连接。

选取gpu。根据gpu相关信息了解到,gpu高效的并行性,高密集的运算,超长图形流水线。根据switch相关信息了解到,switch最不让人满意的地方就是续航能力,而且性价比不足,可玩的游戏不多。

PCIe 0互联芯片(Retimer)与PCIe 0 Switch芯片的核心区别在于功能定位、技术实现及成本价值,具体如下: 功能定位差异PCIe 0 Retimer(互联芯片):作为信号增强器件,主要解决高速信号传输中的物理层衰减问题。

Hopper GPU还添加了针对多租户、多用户配置的虚拟化支持,以及新的DPX指令集,可加快选定映射、DNA和蛋白质分析应用的递归循环速度。同时,它还支持通过机密计算增强安全性。NVLink Switch 新的NVIDIA NVSwitch是连接多台服务器以构建AI超级计算机的关键组件。

服务器GPU配置的费用区间是多少

〖壹〗、服务器GPU配置的费用区间通常在几千元到几十万元不等,具体取决于GPU型号、数量、品牌以及配套硬件需求。入门级配置(约5000-3万元) 单卡方案:如NVIDIA T400/T600等专业卡,适合基础图形处理或轻量级计算。 二手/旧款显卡:如GTX 1080 Ti或RTX 2080,性价比较高但无官方保修。

〖贰〗、华为GPU服务器的费用因型号、配置和采购渠道不同差异较大,通常单台售价在10万至50万元人民币区间。影响费用的核心因素 GPU型号:搭载NVIDIA A100的机型比国产升腾910B成本高约30%-50%。 计算节点数量:8卡服务器(如Atlas 800)比4卡机型贵60%以上。

〖叁〗、企业级GPU服务器的费用区间通常在5万元至50万元人民币之间,具体取决于配置、品牌和应用场景。基础配置影响费用 入门级:搭载1-2张中端GPU(如NVIDIA T4或A10),费用约5-15万元,适合轻量级AI推理或图形处理。

〖肆〗、图形处理服务器的费用区间通常在5万元至50万元人民币之间,具体取决于配置、品牌和应用场景。基础配置服务器 入门级(5万-15万元):搭载中端GPU(如NVIDIA RTX A4000或AMD Radeon Pro W6800),适合轻量级渲染或小型AI训练。

〖伍〗、高端型号定价:配备英伟达下一代专为加速AI设计的GPU——Blackwell的服务器,市场定价区间为200万至300万美元每台。

〖陆〗、英伟达GPU服务器费用 高端定价:根据摩根斯坦利的深度研究报告,配备英伟达下一代专为加速AI设计的GPU——Blackwell的服务器,其市场定价区间将攀升至200万至300万美元每台。

GPU云服务器厂商综合评测与排名(2025年更新版)

华为云:国产化方案生态逐步完善,但与世界主流框架的兼容性仍有提升空间。腾讯云:生态支持相对较弱,主要依赖自身平台资源。 安全性(10%)优刻得(UCloud):提供数据加密、合规认证、容灾备份等全方位安全保障,符合医疗等行业高标准要求。阿里云:安全性较高,但需额外购买安全合规模块。

京东云:排名第五,京东云凭借其在电商场景优化和定制化存储方案方面的优势,为电商行业提供了高效的GPU云服务器服务。其支持的NVIDIA A10/A40等GPU型号,在性能和性价比上均表现出色。电信云:排名第六,电信云依托其网络带宽优势和丰富的政企客户服务经验,在GPU云服务器领域也占据了一定的市场份额。

年中国市场服务器排名(加速服务器维度)显示,浪潮、新华联想位居销售额前三,浪潮、新华宁畅位列出货量前三,整体市场规模呈高速增长态势。

为什么顶级团队都在抢着使用gpu服务器?

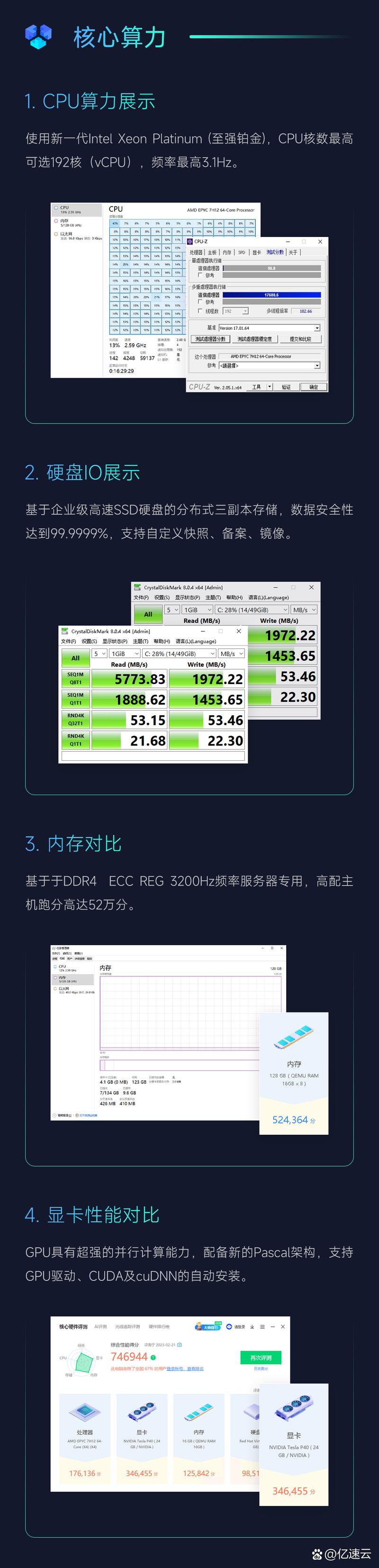

顶级团队抢着使用GPU服务器,主要源于其在算力、能耗比、扩展性等方面的显著优势,能大幅提升AI研发效率并降低成本,具体如下:算力碾压:实现大模型训练速度的质变 单卡算力优势:GPU服务器单卡算力可达312 TFLOPS(每秒万亿次浮点运算),远超传统CPU服务器。

游戏:在游戏领域,GPU服务器能够为游戏提供强大的图形渲染支持,保证游戏的画面质量和流畅度。无论是大型的网络游戏还是单机游戏,都需要GPU服务器来处理复杂的图形计算,为玩家带来更好的游戏体验。例如一些3A级大作,对图形处理要求极高,只有使用GPU服务器才能满足其运行需求。

性能侧重不同:CPU服务器在单线程性能、复杂逻辑处理上更优,而GPU服务器在浮点运算、图形处理、深度学习训练等场景中效率更高。应用场景分化:普通服务器适用于办公系统、数据库管理、Web服务等;GPU服务器则专注于需要高吞吐量计算的领域,如深度学习模型训练、科学模拟、视频渲染等。

GPU服务器是指在服务器中安装了高性能的显卡(GPU),以提供更加强大的计算能力和图形处理能力。GPU服务器广泛应用于深度学习、图像处理、自然语言处理、科学计算等领域。GPU服务器的性能优越,可以大幅缩短计算时长,提高工作效率。

如果你还想了解更多这方面的信息,记得收藏关注本站。

标签: gpu服务器