极智算总结:

- 两台gpu服务器卡如何组网可以实现点对点

- 刀片服务器怎么插GPU卡:GPU卡是否跟显卡似的插在刀片主板上?_百度...

- 8块4090显卡!机架式GPU服务器方案

- GPU服务器需要什么配置

- ...元全功能二合一白群晖,8100T,蜗牛小机箱,M2固态,本地GPU服务器...

- 如何科学的搭建一台深度学习服务器?

- 服务器GPU配置的费用区间是多少

- 高性能GPU服务器集群拓扑及组网方案

两台gpu服务器卡如何组网可以实现点对点

两台GPU服务器卡要实现点对点组网,可以通过使用专用的高速互连网络来实现,比如InfiniBand(IB)网络。以下是具体的组网步骤:购买并安装专用高速互连设备:选取设备:根据两台GPU服务器的配置和需求,选取适合的InfiniBand设备。

技术特点 高速互连:NVLink通过高速连接两块NVIDIA显卡,能够实现显存和性能的扩展,从而满足最大视觉计算工作负载的需求。高带宽:与传统的PCIe相比,NVLink提供了高达10倍的带宽,这使得多个GPU能够在单个服务器内通过点对点网络连接在一起,形成混合立方体网格。

统一内存:支持连接的GPU之间的内存池,对于大型数据集任务至关重要。工作原理 NVLink由可以双向传输数据的高速数据通道组成,采用点对点连接,有效减少瓶颈并提高数据吞吐量。支持网状拓扑,允许GPU之间实现更通用且数量更多的连接。

高速点对点链路:NVLink是专门设计为连接GPU的高速点对点链路,具有比传统网络更高的性能和更低的开销。网络内聚合:第三代NVswitch配备64个NVLink端口,提供高达18Tbps的交换容量,支持多播和网络内聚合功能,有助于减少训练迭代过程中GPU之间的数据传输量。

关键技术突破Fabric Link片间组网技术:支持GPU间直接通信,无需通过CPU中转,可构建128卡国产GPU服务器超节点。该技术解决了升腾、海光等国产AI芯片在多卡互联时的带宽瓶颈,显著提升集群计算效率。

刀片服务器怎么插GPU卡:GPU卡是否跟显卡似的插在刀片主板上?_百度...

显卡的接口为PCIE接口,是安装在刀片主板的PCIE插槽上的,GPU加速卡的接口为PCIE接口,也是安装在PCIE插槽上的。显卡PCIE接口与GPU加速卡PCIE接口对比,可见完全相同:安装GPU加速卡需要关闭服务器进行安装,安装的操作方式与安装显卡完全相同,对准插槽将GPU加速卡卡入PCIE插槽,锁紧服务器机箱后部的固定装置,完成安装。

准备工作确认硬件兼容性检查服务器主板是否具备PCIe插槽(通常为x16规格),这是外接显卡的核心接口。若服务器无内置PCIe插槽,需通过PCIe扩展卡或外置显卡坞(如Thunderbolt 3/4接口设备)实现连接,但后者可能受带宽限制影响性能。

是否需要连接额外供电,关键在于GPU卡的具体需求。如果GPU卡需要外接电源,就必须安装riser卡,该卡上面设有供电接口。华为RH2288H V3服务器主板上确实有额外的供电接口,这些接口通常位于主板的边缘位置,便于连接扩展卡。

英伟达的某些服务器架构,如NV72,采用了机柜和“刀片”的设计。每个机柜包含多个服务器“刀片”,每个“刀片”内部又包含一定数量的GPU。在这种架构下,显卡的总数量取决于机柜的数量、“刀片”的数量以及每个“刀片”内部的GPU数量。因此,不同配置的NV72架构服务器,其显卡数量也会有所不同。

GPU服务器出现显卡掉机的原因可能有多种,包括GPU驱动问题、软件兼容性、硬件隐患、操作系统紊乱或应用程序冲突,以及环境因素干扰。 GPU驱动问题:低版本的驱动可能含有bug,导致与硬件或其他软件的兼容性问题,从而引发显卡掉卡。驱动程序过时、损坏或与GPU型号不匹配,也可能导致显卡无法正常工作。

看好显卡辅助电源插座是6PIN还是8PIN的,并且注意固定卡勾面,然后将对应的电源插头以及锁勾与显卡勾面是一个方向,直接插在显卡辅助电源插座上并锁住卡勾即可。 电脑显卡需要辅助电源供电,是因为主板上的PCI-E插槽,不能供给它足够的电源功率而增加的,有这个辅助电源插座,就必须插辅助电源,不然显卡是不能工作的。

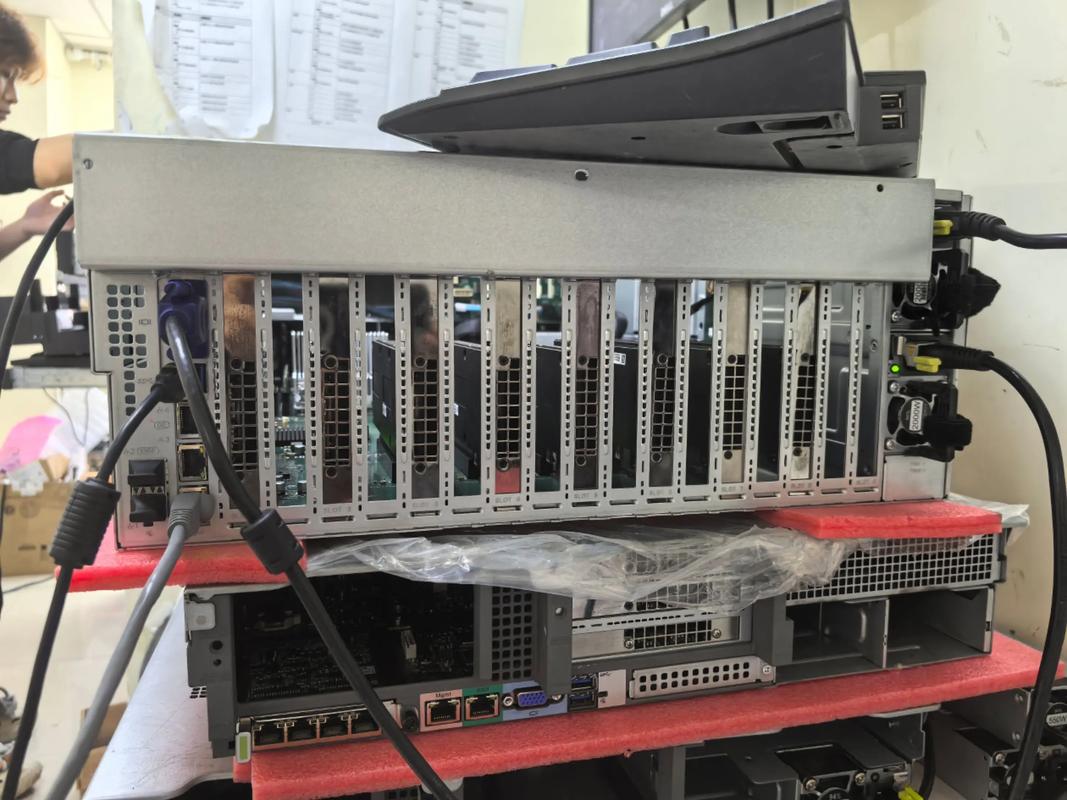

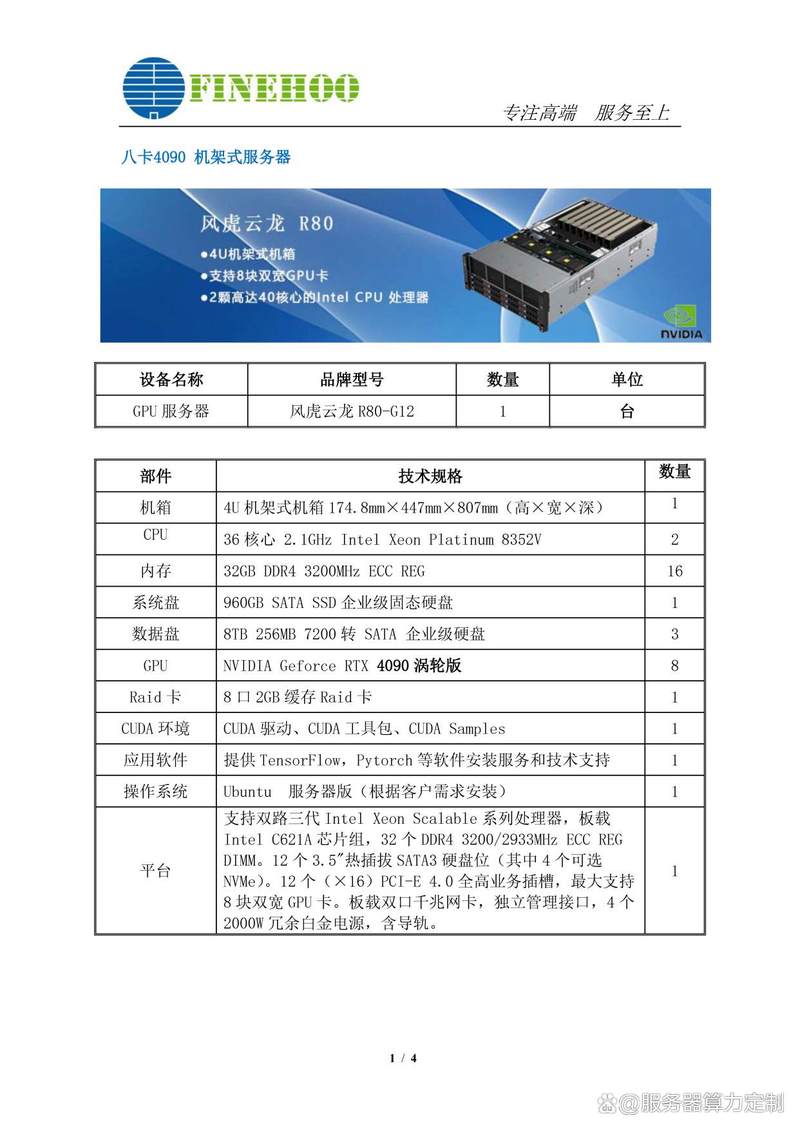

8块4090显卡!机架式GPU服务器方案

〖壹〗、针对您提出的机架式GPU服务器方案需求,以下是一个基于8块NVIDIA Geforce RTX 4090显卡的详细方案。此方案旨在提供强大的计算力,以支持复杂的数据分析、机器学习及深度学习等任务。服务器基础配置 机箱:选取一款高质量的机架式服务器机箱,确保有足够的空间和散热能力来容纳8块RTX 4090显卡。

〖贰〗、卡英伟达4090深度学习服务器 这款服务器搭载了8张NVIDIA Geforce RTX 4090涡轮版显卡,以其极致的计算性能和效率,能够显著减少深度学习模型的训练和推理任务时间。

〖叁〗、方案二:4090 8GPU 4U机架式服务器GPU配置:8块NVIDIA GeForce RTX 4090,每卡24GB GDDR6X显存,集群总显存192GB。支持数十亿参数模型训练(如70亿参数模型全参数微调,130亿级模型LoRA/QLoRA微调)。

〖肆〗、任务调度优化:采用Kubernetes集群管理,提高GPU利用率至85%以上。硬件迭代规划:与机房签订3年以上合约可获得15-20%的电费折扣。综上所述,托管八卡4090算力服务器到苏州胜网高电机房或中国电信苏州太湖世界数据中心都是较为划算的选取。

〖伍〗、张4090跑70B参数的详细解释如下:显卡配置:8张NVIDIA RTX 4090 48GB GPU可以支撑70B(即700亿)参数大模型的分布式训练。这种配置能够轻松实现高效并行计算,无论是多模态联合优化还是超大规模语言模型微调。

〖陆〗、图灵计算工作站GX660M是一款集高性能计算与静音环境于一体的超级异构计算系统。它支持双Xeon第4代可扩展处理器,并比较高可配置8块RTX第4代GPU超算卡(包括RTX 4090和RTX 6000Ada等),同时支持PCIe 0总线,为海量存储和高效计算提供了坚实基础。

GPU服务器需要什么配置

〖壹〗、GPU服务器需要以下关键配置:高性能的GPU:核心部件:高性能GPU是GPU服务器的核心,直接影响服务器的处理能力。选取要点:通常选取专业级GPU,如NVIDIA的Tesla或Quadro系列、AMD的Radeon Instinct系列。需关注内存容量、浮点计算能力(TFLOPS)、内存带宽及最大显示分辨率。

〖贰〗、GPU服务器的典型配置如下:CPU:类型:Intel Xeon 或 AMD EPYC系列。核心数:至少16核,以提供强大的多任务处理能力。主频:至少0GHz,确保高效的处理速度。缓存:至少64MB,以加快数据访问速度。GPU:类型:NVIDIA Tesla、Quadro或GeForce系列,专为并行计算而设计。

〖叁〗、选购商用服务器GPU时,需重点关注计算性能、显存容量、兼容性、散热及扩展性等核心参数。计算性能 CUDA核心数/流处理器数:直接影响并行计算能力,数值越高处理复杂任务(如AI训练)效率越高。

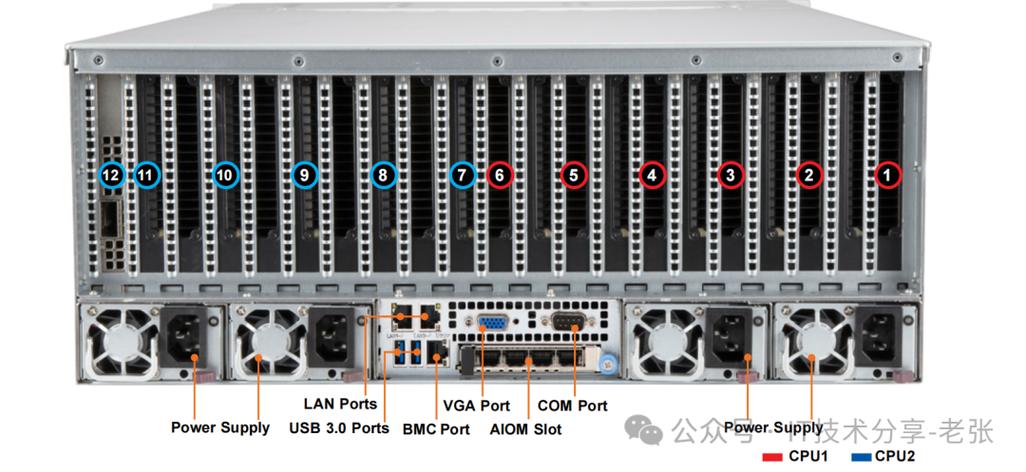

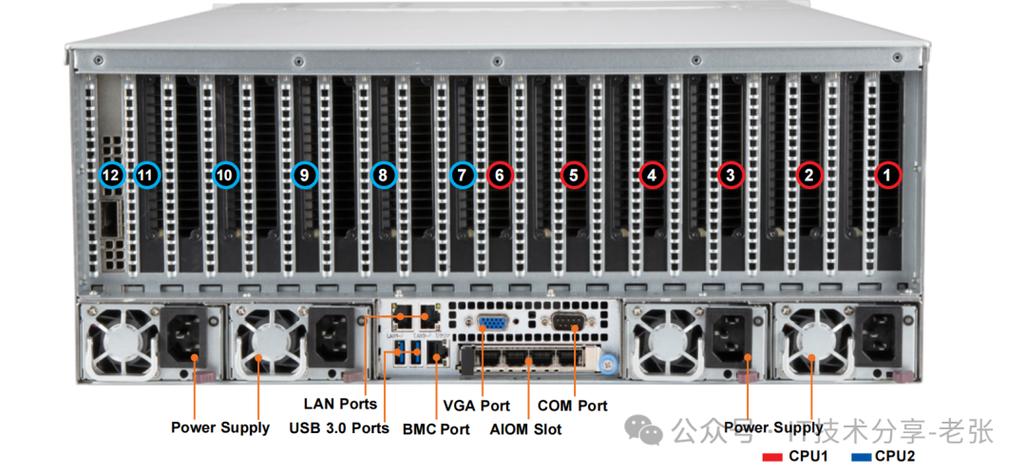

〖肆〗、高性能GPU服务器集群拓扑及组网方案如下:硬件拓扑 主机配置:每台主机配备8块高性能GPU,机型包括A100、A800、H100、H800。内部硬件架构:PCIe总线:提供高效数据传输,支持CPU、内存、NVME、GPU和网卡等设备互联。PCIe Gen5提供卓越性能。

〖伍〗、针对客户提出的CPU+GPU高性能服务器需求,推荐机型TRY SR212(P83-SSX1)可完全满足配置要求,具体分析如下:核心配置满足度CPU性能:采用80核160线程设计,基础频率7GHz,全核心满载时可达98GHz。

〖陆〗、普通服务器:硬件配置相对简单,主要关注CPU、内存和存储等基本配置,以满足一般应用需求。费用与维护成本 GPU服务器:由于配备了高性能的GPU显卡和其他高端硬件,费用相对较高。同时,由于GPU服务器的复杂性和高性能需求,其维护成本也相对较高。

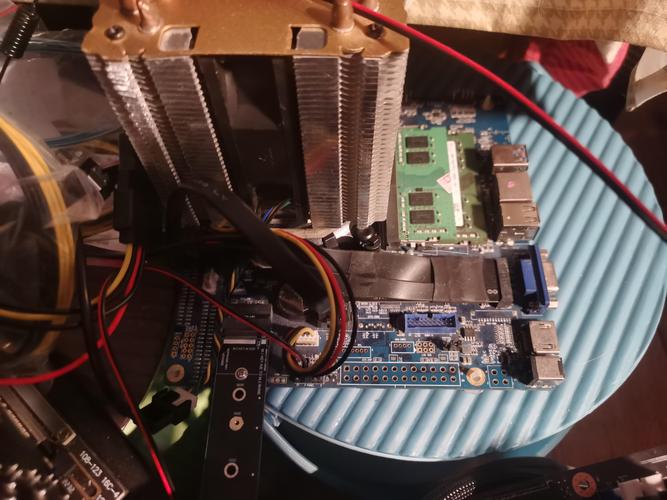

...元全功能二合一白群晖,8100T,蜗牛小机箱,M2固态,本地GPU服务器...

机箱:蜗牛B款,虽然空间略小,但通过巧妙布局实现了高性能NAS的搭建。系统搭建与优化 系统选取:二合一白群晖系统,引导在固态上,提升开机速度。版本选用DSM3,洗白后可以使用QC教程进行进一步优化。

如何科学的搭建一台深度学习服务器?

〖壹〗、科学的搭建深度学习服务器需要综合考虑GPU、CPU、内存、磁盘存储和服务器机架等多个方面。在选取时,需根据具体任务需求、预算和可用空间等因素进行权衡。通过合理的配置和搭配,可以搭建出性价比高、性能强劲的深度学习服务器,满足各种深度学习任务的需求。

〖贰〗、综上所述,科学的搭建一台深度学习服务器需要综合考虑GPU、CPU、内存、磁盘存储及机架等多个方面。通过合理的配置与优化,可以构建出性价比高、性能稳定的深度学习服务器,满足各种深度学习任务的需求。

〖叁〗、总体方案概述在3500元的预算内,组装一台能够进行AI深度学习的基础服务器是可行的,但需要注意的是,这样的配置可能在性能和扩展性上有所限制。因此,我们需要在满足基本需求的前提下,尽可能优化硬件选取。

〖肆〗、深度学习环境搭建指南:配置深度学习环境服务器 安装Nvidiadocker:借鉴Nvidiadocker教程进行配置,确保可以在docker环境中使用GPU。拉取nvidia/cuda镜像:根据Linux版本和服务器cuda驱动版本,选取cudnn8devel版本,在服务器端拉取镜像。创建自定义镜像:自行创建dockerfile文件并命名为Dockerfile。

〖伍〗、搭建一台大模型服务器的配置建议 搭建一台用于运行大型模型(如大型语言模型)的服务器,需要综合考虑计算能力、内存、存储空间、网络、软件框架、安全性、扩展性以及预算等多个方面。

〖陆〗、选取云服务器规格 首先,登录潞晨云服务器的管理控制台。在控制台中,根据深度学习任务的需求,选取适合的云服务器规格。对于深度学习任务,特别是涉及图像识别、自然语言处理等复杂任务时,建议选取配置更高的GPU实例。GPU实例能够显著加速深度学习模型的训练和推理过程,提高计算效率。

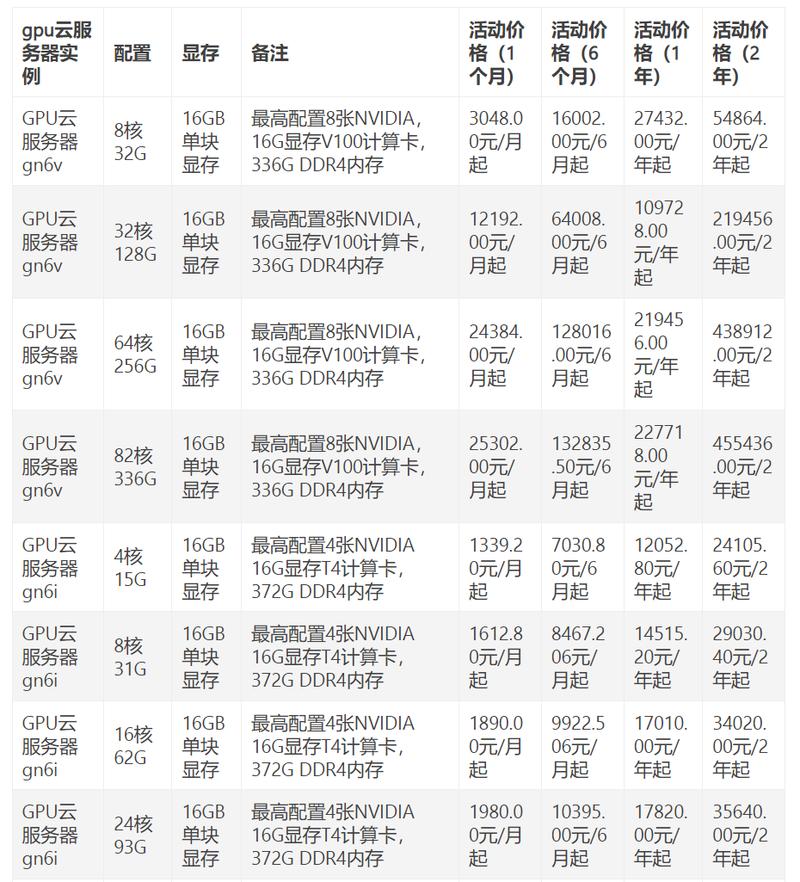

服务器GPU配置的费用区间是多少

服务器GPU配置的费用区间通常在几千元到几十万元不等,具体取决于GPU型号、数量、品牌以及配套硬件需求。入门级配置(约5000-3万元) 单卡方案:如NVIDIA T400/T600等专业卡,适合基础图形处理或轻量级计算。 二手/旧款显卡:如GTX 1080 Ti或RTX 2080,性价比较高但无官方保修。

华为GPU服务器的费用因型号、配置和采购渠道不同差异较大,通常单台售价在10万至50万元人民币区间。影响费用的核心因素 GPU型号:搭载NVIDIA A100的机型比国产升腾910B成本高约30%-50%。 计算节点数量:8卡服务器(如Atlas 800)比4卡机型贵60%以上。

企业级GPU服务器的费用区间通常在5万元至50万元人民币之间,具体取决于配置、品牌和应用场景。基础配置影响费用 入门级:搭载1-2张中端GPU(如NVIDIA T4或A10),费用约5-15万元,适合轻量级AI推理或图形处理。

图形处理服务器的费用区间通常在5万元至50万元人民币之间,具体取决于配置、品牌和应用场景。基础配置服务器 入门级(5万-15万元):搭载中端GPU(如NVIDIA RTX A4000或AMD Radeon Pro W6800),适合轻量级渲染或小型AI训练。

高端型号定价:配备英伟达下一代专为加速AI设计的GPU——Blackwell的服务器,市场定价区间为200万至300万美元每台。

英伟达GPU服务器费用 高端定价:根据摩根斯坦利的深度研究报告,配备英伟达下一代专为加速AI设计的GPU——Blackwell的服务器,其市场定价区间将攀升至200万至300万美元每台。

高性能GPU服务器集群拓扑及组网方案

〖壹〗、测试时需搭配200Gbps交换机以发挥卡间性能。L40S架构优化数据路径,采用单机4卡设计消除主机带宽瓶颈。综上所述,高性能GPU服务器集群拓扑及组网方案需综合考虑硬件拓扑、内部互联技术、网络技术选取以及带宽分析等因素,以实现高效的数据传输和计算性能。

〖贰〗、高性能GPU服务器集群拓扑及组网方案 高性能GPU服务器硬件拓扑与集群组网,采用集群式架构,每台主机配备8块高性能GPU,包括A100、A800、H100、H800四种机型。典型8*A100GPU主机内部硬件架构包括高效互联的PCIe总线、NVLink、DCGM监视工具、NVSwitch交换芯片等。

〖叁〗、在GPU/TPU集群网络组网中,NVLink、InfiniBand、ROCE以太网Fabric以及DDC网络方案是当前流行的技术选取。这些技术各有优劣,适用于不同的场景和需求。以下是对这些技术的详细分析:NVLink交换系统 优势:高速点对点链路:NVLink是专门设计为连接GPU的高速点对点链路,具有比传统网络更高的性能和更低的开销。

文章到此结束,如果本次分享的gpu服务器组装和gpu服务器怎么安装gpu驱动的问题解决了您的问题,那么我们由衷的感到高兴!