极智算总结:

- 如何搭建高通量计算平台?

- (转载)一文看懂英伟达A100、H100、A800、H800、H20

- Vscode远程Linux服务器,搭建Pytorch环境

- 使用潞晨云服务器搭建深度学习环境

- 搭建一台大模型服务器怎样配置好?

- 如何搭建多人共用的gpu服务器?

- ...元全功能二合一白群晖,8100T,蜗牛小机箱,M2固态,本地GPU服务器...

如何搭建高通量计算平台?

〖壹〗、科研预算需从5W起,具体根据硬件配置、软件许可、技术支持等因素综合考虑。在预算范围内选取性价比比较高的硬件和软件方案,确保平台的性能和稳定性。总结:搭建高通量计算平台需要综合考虑硬件、软件、系统调度、开发环境管理等多个方面。通过合理的规划和配置,可以构建一个高效、稳定、可扩展的高通量计算平台,为科研和工程应用提供强大的计算支持。

〖贰〗、搭建高通量计算平台,首先需要理解计算背景。第一性原理计算作为研究复合半导体电子结构的有力手段,相比实验研究更精确地模拟结构与缺陷对半导体性质的影响,有助于设计复合体系。中山大学某课题组借助宝禄计算平台优化技术进步,轻松扩展以适应不断变化的需求。平台提供统一管理,监控资源状态,确保高效运行。

〖叁〗、搭建高通量计算平台,主要是通过集成高性能硬件与先进软件管理系统来实现高效、精确的计算解决方案。以下是搭建高通量计算平台的关键要素: 核心硬件配置 高性能服务器:采用如Intel Platinum 8373C处理器的高性能CPU,提供强大的浮点计算能力,如5990.4GFlops的理论性能。

(转载)一文看懂英伟达A100、H100、A800、H800、H20

〖壹〗、H100在Transformer-based AI任务(如GPT)中比A100快6倍,而推理吞吐量也更高。小结 AI训练:需要高带宽 + 高精度计算,推荐H100/A100及其变种。AI推理:需要低延迟 + 高吞吐量,推荐H100/H800/H20。H100在Transformer模型训练和推理吞吐量方面遥遥领先。A100/A800仍然是中等预算下的优秀选取。

〖贰〗、对于AI训练任务,建议选取H100或A100系列GPU,它们提供强大的计算能力和高带宽内存,适合处理大规模数据集和复杂模型。推理场景 对于AI推理任务,A800或H800系列GPU是更好的选取。它们提供稳定的计算能力和适中的内存容量与带宽,满足大多数推理任务的需求。

〖叁〗、A100:拥有40GB显存,提供PCIE版和SXM版两种形式。A100是英伟达上一代的高性能GPU,广泛应用于AI计算、高性能计算等领域。A800:作为A100的替代产品,A800同样拥有80GB显存(与后续提到的H100、H800的某版本相同),也提供PCIE版和SXM版。

Vscode远程Linux服务器,搭建Pytorch环境

〖壹〗、在Vscode中远程连接到Linux服务器并搭建Pytorch环境的步骤如下:准备SSH连接环境:在Vscode中,点击“添加远程主机”。输入SSH用户名和服务器IP地址。选取保存SSH信息的文件,完成设置。输入密码,成功连接Linux服务器并浏览文件。

〖贰〗、首先,确保SSH连接的环境准备。在Vscode中,点击添加远程主机,输入SSH用户名和服务器IP,接着选取保存SSH信息的文件。完成这些步骤后,只需输入密码,即可成功连接Linux服务器并浏览文件。下面,安装Anaconda Linux版,下载时记得选取Linux版本,并在清华大学Anaconda下载站点获取(例如2020版)。

〖叁〗、安装Pytorch 打开Miniconda3的命令行界面。创建一个新的conda环境。使用从Pytorch官方网站获取的conda安装命令在该环境中安装Pytorch。确保命令中包含正确的CUDA版本信息,以启用GPU加速。安装完成后,通过运行简单的Pytorch测试代码来验证安装是否成功。

〖肆〗、激活虚拟环境:先激活Miniconda中创建的虚拟环境。下载并安装PyTorch:在pytorch下载地址选取对应选项,生成下载命令并输入到命令行界面。验证安装:在命令行界面输入python,进入python编辑环境,输入import torch以验证PyTorch是否安装成功。

〖伍〗、首次启动新安装的 Linux 发行版时,将打开一个控制台窗口,要求你等待将文件解压缩并存储到计算机上。 未来的所有启动时间应不到一秒。2安装Ubuntu: 打开Microsoft Store搜索Ubuntu进行安装。WSL-Ubuntu默认安装在C盘,在配置CUDA等环境后,所占用的空间通常会达到30GB以上。

〖陆〗、PyTorch基于PyCharm和VSCode的安装教程如下:安装前准备 确保你的系统已经安装了Anaconda,因为我们将通过Anaconda来管理Python环境和依赖。创建和激活PyTorch环境 打开Anaconda Prompt:输入python命令确认Python版本。

使用潞晨云服务器搭建深度学习环境

选取云服务器规格 登录管理控制台:首先,登录潞晨云服务器的管理控制台。选取规格:在选取云服务器规格时,考虑到深度学习任务的计算密集型特点,建议选取配置更高的GPU实例。GPU实例能够显著加速深度学习模型的训练和推理过程。 部署与配置 借鉴文档:潞晨云提供了详细的部署和配置文档,这些文档对于初学者来说非常友好。

使用潞晨云服务器搭建深度学习环境是一个高效且灵活的选取。通过选取合适的云服务器规格、快速部署和配置、准备数据集、编写训练脚本进行模型训练以及使用训练好的模型进行推理任务,你可以轻松地在云上搭建起一个完整的深度学习环境。

选取云服务器规格 登录管理控制台:首先,登录潞晨云服务器的管理控制台。选取规格:根据你的深度学习工作负载需求,选取适合的云服务器规格。对于深度学习任务,特别是涉及图像、视频等大数据量的处理,建议选取配置更高的GPU实例,以加速训练过程。

选取云服务器规格 首先,登录潞晨云服务器的管理控制台。在控制台中,根据深度学习任务的需求,选取适合的云服务器规格。对于深度学习任务,特别是涉及图像识别、自然语言处理等复杂任务时,建议选取配置更高的GPU实例。GPU实例能够显著加速深度学习模型的训练和推理过程,提高计算效率。

使用潞晨云服务器搭建深度学习环境,可以按照以下步骤进行:选取云服务器规格:在潞晨云服务器的管理控制台中,根据深度学习工作负载的需求,选取相应的云服务器规格。推荐选取:为了加速深度学习任务,建议选取配置较高的GPU实例。部署和配置:借鉴潞晨云提供的详细文档和教程进行部署和配置。

搭建一台大模型服务器怎样配置好?

根据预算选取配置:服务器配置费用可能相差很大,根据您的预算和需求选取合适的配置。在有限的预算内,优先满足模型的计算、内存和存储需求,以确保服务器的性能和稳定性。总结 搭建一台大模型服务器需要综合考虑多个方面,包括CPU与GPU、内存、存储、网络、软件框架、安全性、扩展性和预算等。

卡 GPU大模型服务器:静音塔式机箱设计,搭载2个12核心1GHz的Intel Xeon Silver4310 CPU,8个32GB DDR4 3200MHz ECC REG内存,1个1TB的M.2 NVMe SSD固态硬盘和1个8TB 256MB 7200转SATA企业级硬盘,装配4个NVIDIA Geforce RTX 4090三风扇版GPU。

综上所述,运行700亿参数规模的多模态大模型进行微调和推理所需的硬件配置应包括:高性能GPU(如NVIDIA A100或H100)、多核服务器级CPU(如Intel Xeon Scalable或AMD EPYC)、大量内存(至少128GB至256GB RAM)以及大容量高速存储(如1TB+ NVMe SSD)。

如何搭建多人共用的gpu服务器?

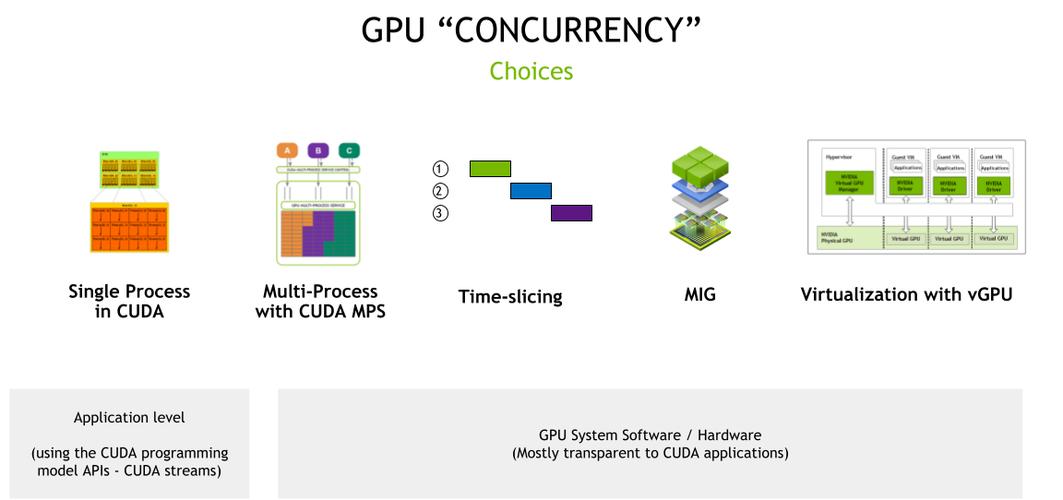

搭建多人共用的GPU服务器,可以按照以下步骤进行:选取服务器硬件:确保支持GPU:选取能够支持至少一个或多个高性能GPU的服务器硬件。考虑CPU、内存和硬盘:根据任务需求,选取性能强劲的CPU、足够的内存容量以及充足的硬盘空间。电源和散热:确保电源供应稳定且散热系统能够有效应对高负载运行时的热量问题。

为GPU创建Resource Mapping:在Proxmox上创建Resource Mapping,实现GPU设备的池化管理,便于虚拟机动态分配。部署DoraCloud云桌面 在线安装DoraCloud:使用一键安装脚本在线安装DoraCloud。基础配置:安装后,进入DoraCloud后台,根据配置向导完成虚拟化、资源池、集群、用户数据库的配置。

电源:选取能够承载CPU和GPU消耗的电源,确保稳定运行。二级存储:固态硬盘或SATA硬盘,用于存储数据和系统文件。选取GPU 根据计算需求选取合适的GPU品牌和型号。特斯拉工作站产品(C系列):主动降温,适合桌面计算机。服务器产品(M系列):被动降温,适合安装在服务器上。

硬件拓扑 主机配置:每台主机配备8块高性能GPU,机型包括A100、A800、H100、H800。内部硬件架构:PCIe总线:提供高效数据传输,支持CPU、内存、NVME、GPU和网卡等设备互联。PCIe Gen5提供卓越性能。NVLink:NVIDIA开发的高速互联方式,用于同主机内不同GPU之间的通信。

连接两个GPU服务器到互连设备上:物理连接:使用专用的InfiniBand线缆将两台服务器的InfiniBand网卡连接起来。检查连接:确保连接稳定且无误,避免松动或接触不良导致的通信故障。设置驱动程序:安装驱动:在每台服务器上安装InfiniBand网卡的驱动程序,确保它们能够正常工作。

管理、磁盘、网络、SSH密钥:在“管理”下方找到“可用性策略”,如需要创建可抢占实例(以相对低廉的费用使用高性能的GPU服务器,但有效期只有24小时,过期或遇到特殊情况会被自动删除),只需将“抢占”设置为开启。SSH密钥部分可以暂时忽略,后续会详细讲解。

...元全功能二合一白群晖,8100T,蜗牛小机箱,M2固态,本地GPU服务器...

〖壹〗、本方案通过精心挑选硬件和优化系统配置,实现了一款充满魔改的千元全功能二合一白群晖NAS。该NAS不仅性能远超J1900平台,还能运行开源大模型,满足本地GPU服务器的需求。同时,通过洗白教程和第三方套件的安装,进一步提升了系统的实用性和稳定性。

关于gpu服务器搭建和gpu服务器装什么系统的介绍到此就结束了,不知道你从中找到你需要的信息了吗 ?如果你还想了解更多这方面的信息,记得收藏关注本站。