极智算总结:

- GPU服务器与通用服务器的区别

- gpu服务器与普通服务器的硬件区别

- 显卡服务器/GPU服务器与普通服务器的区别有哪些

- gpu服务器和普通服务器有什么区别?

- gpu服务器与cpu服务器的区别在哪?

- 常见的关于GPU云服务器和GPU物理服务器的区别(值得收藏)

GPU服务器与通用服务器的区别

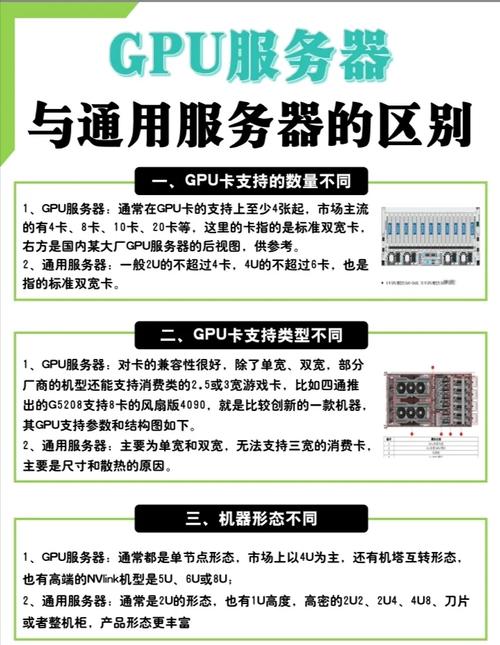

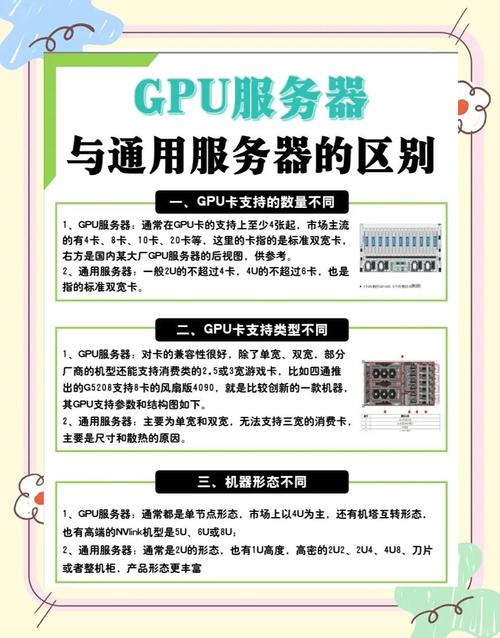

通用服务器:哪里都可以用,比如做私有云、分布式存储、管理节点、HPC通用算力节点等等。两者在业务场景定位上有所不同,GPU服务器更专注于高性能计算和图形处理等领域,而通用服务器则更为通用,适用于多种场景。综上所述,GPU服务器与通用服务器在GPU卡支持数量、类型、机器形态、拓扑结构、功耗、费用以及业务场景定位等方面均存在显著差异。

GPU服务器与普通服务器的硬件区别 GPU服务器和普通服务器之间的主要区别在于它们所针对的工作负载类型以及为此优化的硬件配置。以下是两者之间的一些关键差异:处理器(CPU)普通服务器:通常配备多核高性能中央处理器(CPU),这些CPU适用于处理大量并发请求或执行复杂的计算任务,如数据库查询、Web服务等。

GPU服务器和普通服务器的主要区别如下:核心功能与应用场景 GPU服务器:基于GPU构建,主要应用于视频编解码、深度学习、科学计算等多种需要高性能计算的场景。GPU服务器提供快速、稳定、弹性的计算服务,并具备和标准云服务器一致的管理方式。

GPU服务器:由于配备了高性能的GPU和相关的硬件资源,GPU服务器的费用通常较高。普通服务器:费用相对较为亲民,适合预算有限的用户或企业。稳定性与可靠性:GPU服务器:通常设计为能够长时间稳定运行,以满足高性能计算任务的需求。它们通常具有更高的可靠性和稳定性要求。

显卡服务器(GPU服务器)与普通服务器的区别主要体现在以下几个方面:处理器类型 普通服务器:通常配备中央处理器(CPU)作为主要处理器,用于执行大部分通用计算任务和操作系统管理。CPU设计用于处理广泛的计算任务,包括逻辑运算、数据移动和输入输出操作等。

gpu服务器与普通服务器的硬件区别

GPU服务器和普通服务器之间的主要区别在于它们所针对的工作负载类型以及为此优化的硬件配置。以下是两者之间的一些关键差异:处理器(CPU)普通服务器:通常配备多核高性能中央处理器(CPU),这些CPU适用于处理大量并发请求或执行复杂的计算任务,如数据库查询、Web服务等。

普通服务器:计算能力相对较弱,适用于一般的计算任务,但无法胜任大规模并行计算或高性能计算任务。硬件配置 GPU服务器:通常配备高性能的GPU显卡,以及与之匹配的CPU、内存和存储设备,以满足高性能计算需求。普通服务器:硬件配置相对简单,主要关注CPU、内存和存储等基本配置,以满足一般应用需求。

GPU服务器:由于配备了高性能的GPU和相关的硬件资源,GPU服务器的费用通常较高。普通服务器:费用相对较为亲民,适合预算有限的用户或企业。稳定性与可靠性:GPU服务器:通常设计为能够长时间稳定运行,以满足高性能计算任务的需求。它们通常具有更高的可靠性和稳定性要求。

普通服务器:相对较低的硬件成本,适用于小规模的计算需求。普通服务器的硬件配置相对简单,因此其成本也相对较低。显卡服务器(GPU服务器):由于GPU的高性能和计算能力,其硬件成本通常较高。此外,GPU服务器的配置也相对复杂,需要更多的硬件资源来支持其高性能的计算任务。

显卡服务器/GPU服务器与普通服务器的区别有哪些

显卡服务器(GPU服务器):由于GPU的大规模并行计算特性,其功耗较高。因此,GPU服务器需要更多的电力供应来支持其高性能的计算任务。硬件成本 普通服务器:相对较低的硬件成本,适用于小规模的计算需求。普通服务器的硬件配置相对简单,因此其成本也相对较低。

显卡服务器与普通服务器的区别主要包括以下几点:硬件配置与性能:普通服务器:主要依靠中央处理器进行单线程或小规模并行计算,性能适用于常规任务。GPU服务器:额外搭载了强大的图形处理器,拥有数千个并行计算核心,能同时处理大规模数据和图形密集任务,计算性能远超普通服务器。

GPU服务器:由于高性能硬件的集成,电力消耗相对较高。普通服务器:电力消耗相对较低,更节能。硬件成本:GPU服务器:高性能硬件导致硬件成本昂贵。普通服务器:硬件成本相对较低,更经济。并行计算与数据处理:GPU服务器:具有显著的并行计算优势,能够高效处理大规模数据集。

它与普通服务器相比,在应用、性能、处理特定任务、电力消耗、硬件成本、并行计算、数据处理和编程模型等多方面具有显著区别。

GPU服务器和普通服务器的主要区别如下:核心功能与应用场景 GPU服务器:基于GPU构建,主要应用于视频编解码、深度学习、科学计算等多种需要高性能计算的场景。GPU服务器提供快速、稳定、弹性的计算服务,并具备和标准云服务器一致的管理方式。

gpu服务器和普通服务器有什么区别?

GPU服务器和普通服务器的主要区别如下:核心功能与应用场景 GPU服务器:基于GPU构建,主要应用于视频编解码、深度学习、科学计算等多种需要高性能计算的场景。GPU服务器提供快速、稳定、弹性的计算服务,并具备和标准云服务器一致的管理方式。

显卡服务器(GPU服务器):由于GPU的大规模并行计算特性,其功耗较高。因此,GPU服务器需要更多的电力供应来支持其高性能的计算任务。硬件成本 普通服务器:相对较低的硬件成本,适用于小规模的计算需求。普通服务器的硬件配置相对简单,因此其成本也相对较低。

GPU服务器:由于配备了高性能的GPU和相关的硬件资源,GPU服务器的费用通常较高。普通服务器:费用相对较为亲民,适合预算有限的用户或企业。稳定性与可靠性:GPU服务器:通常设计为能够长时间稳定运行,以满足高性能计算任务的需求。它们通常具有更高的可靠性和稳定性要求。

GPU服务器和普通服务器之间的主要区别在于它们所针对的工作负载类型以及为此优化的硬件配置。以下是两者之间的一些关键差异:处理器(CPU)普通服务器:通常配备多核高性能中央处理器(CPU),这些CPU适用于处理大量并发请求或执行复杂的计算任务,如数据库查询、Web服务等。

通用服务器:哪里都可以用,比如做私有云、分布式存储、管理节点、HPC通用算力节点等等。两者在业务场景定位上有所不同,GPU服务器更专注于高性能计算和图形处理等领域,而通用服务器则更为通用,适用于多种场景。

GPU服务器与普通服务器区别在于稳定性要求、接口、缓存、指令集与费用方面。GPU服务器旨在长时间稳定运行,可靠性与稳定性要求更高,常常全年开机,偶尔维护,而普通服务器按照7*24小时设计,具备缓存技术,采用RISC指令集,接口与主板设计也有所不同。

gpu服务器与cpu服务器的区别在哪?

〖壹〗、GPU服务器与CPU服务器在处理能力、应用场景、能源消耗和成本上有显著区别。处理能力方面,CPU以逻辑运算和串行处理见长,而GPU则擅长并行处理大量重复数据,适用于深度学习、图形渲染、物理模拟等高度并行计算任务。

〖贰〗、GPU架构以大量小而快的逻辑单元,以并行方式处理任务,特别适合重复计算。CPU则擅长处理复杂逻辑和控制任务。GPU在高强度并行计算中性能优于CPU。GPU服务器应用场景 GPU服务器适用于视频编解码、深度学习、科学计算等场景。提供高计算性能,有效提高计算效率与竞争力。

〖叁〗、GPU服务器与CPU服务器的主要区别在于它们的计算能力和适用场景。以下是两者的区别及如何选取GPU服务器的详细解GPU服务器与CPU服务器的区别 计算能力:CPU服务器:CPU擅长处理复杂的逻辑运算和程序流程控制,适合执行各种通用任务。

〖肆〗、GPU服务器与CPU服务器的主要区别在于处理任务的类型和性能。以下是两者的具体区别及如何选取GPU服务器的建议:GPU服务器与CPU服务器的区别 处理任务类型:CPU服务器:擅长处理复杂逻辑和控制任务,是计算机系统的运算和控制核心。

〖伍〗、GPU在深度学习领域的优势 深度学习依赖大量数据进行训练,而GPU在处理大数据方面拥有显著优势。因此,GPU服务器在深度学习、科学计算等领域展现出强大的计算性能,释放计算压力,提升产品效率与竞争力。

常见的关于GPU云服务器和GPU物理服务器的区别(值得收藏)

稳定性 GPU云服务器:突破了传统GPU服务器的限制,具有高并行、高吞吐、低时延的极致性能。云服务器提供商通常会提供稳定的基础设施和运维支持,确保服务的稳定性和数据的高可用性。GPU物理服务器:稳定性需要用户自行部署和保障。

云GPU服务器,即基于云计算技术提供的,配备有图形处理器(GPU)的虚拟或物理服务器。这种服务器能够借助云厂商的强大资本力,让用户免去购买GPU的高额成本,同时依然能够使用到计算能力强大但颇为昂贵的GPU,如A100等。这就相当于用户只花费了较少的成本,却享受到了高性能的计算服务。

通用服务器:低配的一般为500-550w,还有800W、1000W、1200W和1600W,通常超过2KW的不多。GPU服务器在功耗上明显高于通用服务器。单台服务器费用 GPU服务器:费用通常是通用服务器的2-3倍,实际出货一台轻松过十万,大几十万到上百万也是正常,主要取决于GPU卡的费用。

低成本:相较于自建GPU计算集群,GPU云服务器能够显著降低企业的IT成本,包括硬件采购、运维管理等方面的费用。易于使用:浪潮云GPU云服务器提供友好的用户界面和丰富的API接口,用户无需具备专业的GPU编程知识,即可轻松上手使用。

关于服务器和gpu到此分享完毕,希望能帮助到您。