极智算总结:

- gpu国产替代龙头

- gpu服务器是什么?有什么作用?

- GPU服务器怎样才能选出比较好的?

- GPU边缘融合什么是GPU边缘融合?

- 服务器:板块介绍

- ai硬件基础设施包括哪些

- gpu和npu有什么区别,分别龙头公司有哪些

- GPU平台的DGX、EGX、IGX、HGX、MGX区别

- GPU服务器与CPU服务器的区别,如何选取GPU服务器

- Supermicro推出适用于边缘计算部署的1U服务器

gpu国产替代龙头

〖壹〗、GPU国产替代龙头企业有寒武纪、海光信息、中科曙光、神州数码、瑞芯微、景嘉微、沪电股份、卓易信息等。云端AI芯片领域:寒武纪技术突破显著,思元590芯片支持千亿参数大模型训练,2025年Q1订单增长超80%,净利润扭亏为盈。

〖贰〗、以下为不同领域的GPU国产替代龙头企业:AI训练/云端GPU领域寒武纪(688256):是唯一实现7nm流片的国产GPU企业,软件生态适配率超80%。思元590芯片性能接近英伟达H20,支持千亿参数模型训练。2025年Q1订单增长120%,国内市占率提升至35%以上,目标替代英伟达A100的20%份额。

〖叁〗、近来在GPU国产替代方面有不少表现较为突出的企业。像景嘉微就是其中之一。 景嘉微在图形处理芯片领域持续发力。其研发的图形处理芯片已广泛应用于多个领域,为国产GPU发展奠定了基础。它不断进行技术创新,提升产品性能,在国内GPU市场占据重要地位。 海光信息也备受关注。

〖肆〗、龙芯中科(688047):自主CPU/GPU架构代表,3A6000处理器集成自研GPU核,支持OpenGL 3,工控、信创替代效应显著。寒武纪(688256):AI芯片龙头,思元590支持千亿参数大模型推理,与阿里云合作千卡级智算集群,智能驾驶、智慧城市订单增速超50%。

gpu服务器是什么?有什么作用?

〖壹〗、综上所述,GPU服务器是一种基于GPU加速计算的服务器,具有广泛的应用领域和多种类型。在选取GPU服务器时,需要根据业务需求、服务器应用情景、顾客自身应用群体和IT运维能力、配套设施应用软件和服务的使用价值以及总体GPU集群系统软件的完善程度和工程效率等因素进行综合考虑。

〖贰〗、GPU服务器是一种配备高性能图形处理器的服务器,其作用主要体现在图形处理与计算加速、深度学习与机器学习以及高性能计算集群等方面。 图形处理与计算加速: GPU服务器具备强大的并行处理能力,能够高效地进行图形处理和计算加速。

〖叁〗、GPU服务器是基于GPU的应用于多种场景(如视频编解码、深度学习、科学计算等)的快速、稳定、弹性的计算服务,而普通服务器则主要用于满足日常的网络访问、数据存储和处理等基本需求。以下是两者之间的详细对比:应用场景:GPU服务器:主要面向需要高性能计算能力的场景,如深度学习训练、图形渲染、科学计算等。

〖肆〗、GPU服务器的作用主要是提供基于GPU的快速、稳定、弹性的计算服务,应用于视频编解码、深度学习、科学计算等多种场景。以下是对GPU服务器作用的详细阐述:GPU加速计算提升性能GPU加速计算通过转移应用程序计算密集部分的工作负载到GPU,实现应用程序性能的显著提升。

〖伍〗、GPU服务器是一种配备了高性能图形处理器的服务器,其主要作用是进行高性能计算、图形渲染和深度学习等任务。以下是关于GPU服务器的详细解释:定义 GPU服务器通过集成高性能的图形处理器,能够执行复杂的图形处理和大规模数据并行运算任务。

GPU服务器怎样才能选出比较好的?

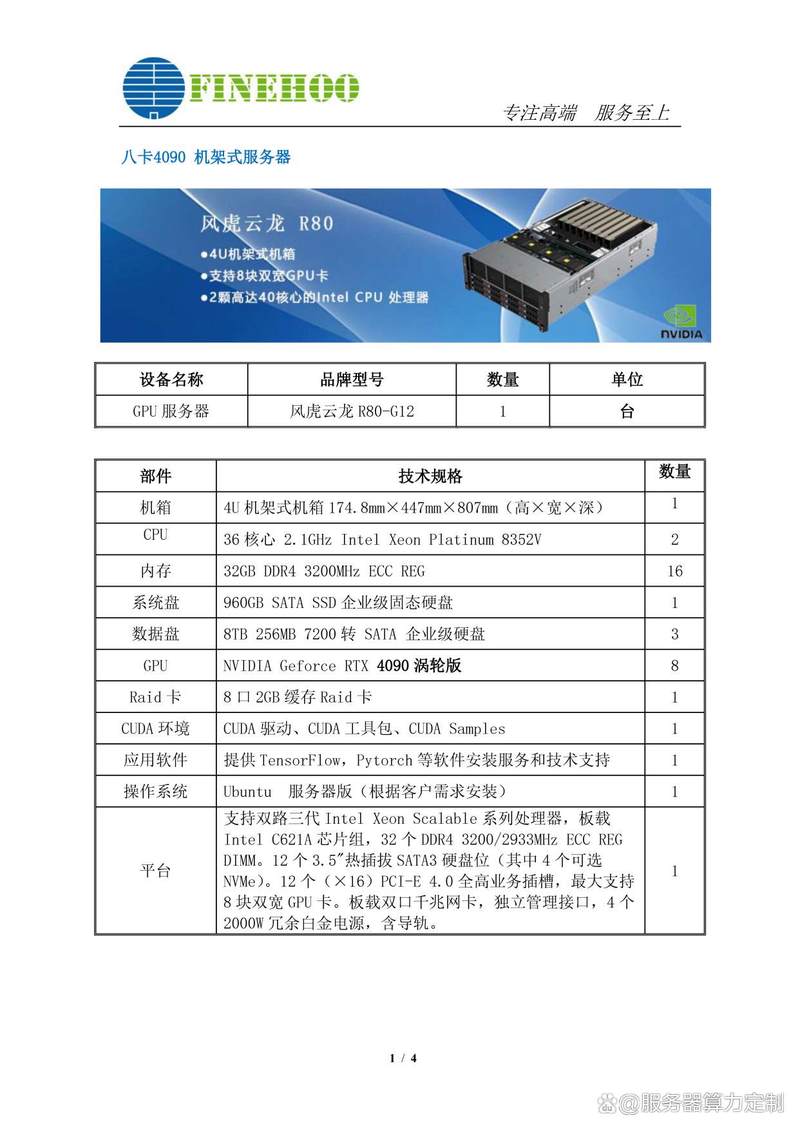

根据您的具体计算需求选取合适的GPU型号。例如,如果您需要进行大规模的AI训练任务,那么A100 GPU将是更好的选取;而如果您只是进行轻量级的AI推理或图形渲染任务,那么T4 GPU将足够满足需求。预算 预算是选取GPU服务器时需要考虑的重要因素。不同型号的GPU服务器在费用上存在较大差异。

综上所述,通过明确应用需求、合理规划预算以及重视扩展性与服务这三招,你可以精准匹配适合自身需求的 GPU 服务器配置。在选取时,可以关注市场上主流的服务器品牌和配置,结合自身的实际情况进行考量,选取最适合自己的 GPU 服务器。

考虑顾客自身应用群体和IT运维能力:对于大型企业而言,他们自己的运维能力较强,这时会选取通用性的PCI-e服务器;而对于IT运维能力不那么强的顾客,他们更关心数据以及数据标注等,这类人通常被称为大数据工程师,他们挑选GPU服务器的标准也会有所不同。考虑配套设施应用软件和服务的使用价值。

此外,服务质量也是选取GPU服务器时不可忽视的因素。选取一家提供良好售后服务和技术支持的厂商,能够在遇到问题时及时获得帮助,确保业务的连续性和稳定性。最后,费用也是影响决策的一个重要因素,你需要在性能和成本之间找到一个平衡点。综上所述,思腾合力的IW系列GPU服务器是一个值得推荐的选取。

根据应用场景选取GPU服务器。确保所选服务器能够满足特定业务对计算性能的需求。关注性能指标:精度:根据应用需求选取合适的计算精度。显存:确保显存足够大,以容纳大规模数据集和模型。功耗:考虑服务器的功耗和散热性能,以确保稳定运行。选取服务器类型:根据需求选取OEM或非OEM服务器。

GPU边缘融合什么是GPU边缘融合?

〖壹〗、GPU边缘融合技术是一种用于改善多台投影机组合显示时画面边缘亮度不一致问题的技术。以下是关于GPU边缘融合技术的详细解释:主要功能:边缘融合:通过渐进降低投影机重叠区域的亮度,使得整个画面在视觉上呈现一致的亮度,从而提升整体显示效果。

〖贰〗、中旭信达GPU融合系统以其强大的处理能力、丰富的功能与高灵活性,广泛应用于媒体包房、工业信号控制、图形图像处理、视景仿真、虚拟现实、会议会展等多元领域,以大规模集成电路GPU编程与亿门级GPU芯片编程为基础,展现出其在技术实现与实际应用中的卓越表现。

〖叁〗、边缘融合技术是一种专业的大屏幕投影系统,它通过多个投影设备的协同工作,构建出一个高性能的多通道显示系统。与常规投影系统相比,边缘融合系统具有显著的优势。

〖肆〗、GPU融合技术,可降低游戏GPU的负载,再通过协处理器补回,在部分游戏场景下达到降低功耗、发热,稳定帧率的作用,游戏对局更流畅。GPU融合功能会降低游戏画质,可以根据需要开启。可以进入设置--游戏魔盒--GPU融合,开启支持游戏后的开关即可。注:开启GPU融合功能会降低游戏画质,可以根据需要开启。

〖伍〗、和而泰与摩尔线程联合开发的AI边缘控制器是一种融合GPU加速能力与边缘控制技术的智能设备,主要用于工业质检、智能仓储等需要实时AI处理的边缘场景。

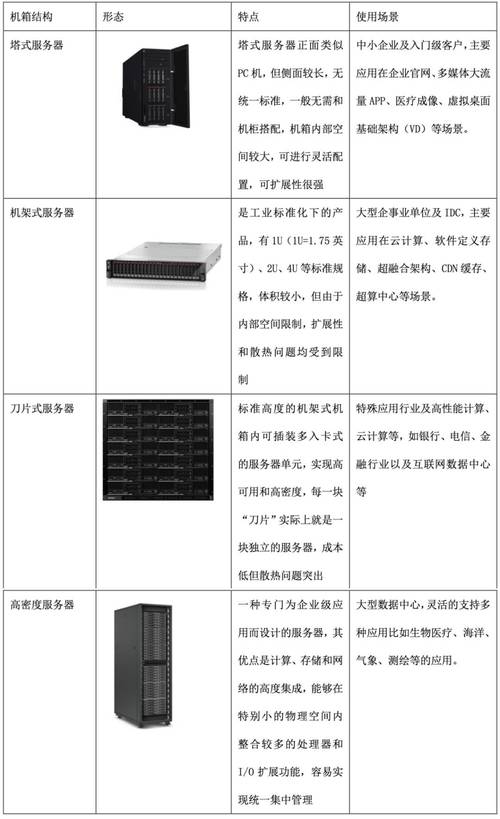

服务器:板块介绍

服务器一般由CPU、存储芯片、PCB主板、电源、机柜、散热等模块组成。随着应用场景的不断变化,服务器也经历了从通用服务器到云服务器、边缘服务器,再到AI服务器的演进。AI服务器作为最新一代的服务器产品,采用GPU增强其并行计算能力,CPU+GPU成为AI服务器的核心部件,满足了AI应用对高性能计算能力的需求。

华为云·鲲鹏:板块介绍 华为云·鲲鹏板块主要包括以下几个关键组成部分:鲲鹏芯片 核心地位:鲲鹏920作为低功耗、高性能的Arm处理器,是鲲鹏生态发展壮大的核心所在。它不仅为鲲鹏服务器主板及整机产品提供芯片支撑,还推动了华为在自主研发芯片领域的进一步探索,为鲲鹏生态的发展奠定了坚实基础。

人工智能涉及的股票板块主要包括AI芯片、语音识别、计算机视觉、安防AI、算力基础设施、服务器、人机协同、数字创意、自然语言处理、AI多模态、智能投顾、AI办公、AI安全等板块。 AI芯片板块:代表企业:寒武纪、海光信息等。这些企业专注于AI芯片的研发和生产,为人工智能应用提供强大的算力支持。

华为云·鲲鹏板块主要涵盖了基于鲲鹏处理器的全栈IT基础设施、行业应用及服务。以下是该板块的详细介绍:鲲鹏计算产业概述 鲲鹏计算产业是基于鲲鹏处理器构建的一系列IT基础设施、行业应用及服务的总称。

Triton推理服务器的高阶架构Triton推理服务器采用主从(client-server)架构,由以下四个板块组成:模型仓(Model Repository):存放Triton服务器所要使用的模型文件与配置文件的存储设备。可以是本地服务器的文件系统,也可以使用Google、AWS、Azure等云存储空间。

国产操作系统现状 近来,国内操作系统市场中,中标麒麟是较为突出的国产操作系统产品。中标软件基于Linux操作系统技术,推出了中标麒麟高级服务器操作系统(虚拟化版)以及中标麒麟桌面操作系统。

ai硬件基础设施包括哪些

物理基础设施:包括电力供应、冷却系统和物理安全等,确保AI硬件基础设施的稳定运行。虚拟化技术:通过软件定义的方式,将物理硬件资源抽象为虚拟资源,提高资源利用率和灵活性。这些硬件基础设施共同构成了AI系统的底层支撑,为AI算法的训练、推理和应用提供了强大的计算能力、存储能力和网络能力。

AI基础设施主要包括计算设备、数据存储和处理系统、网络和通信设施、云计算平台、传感器和物联网设备、开发和调试工具、安全和隐私保护措施、监控和故障排除系统、用户界面和交互设计以及人才和培训等方面。

AI基础设施体系主要包括硬件、软件和网络资源等部分。在硬件方面,像GPU、CPU、内存、服务器等高性能计算设备为人工智能提供了强大的计算能力和存储空间。这些硬件设备能够应对人工智能模型训练和推理过程中的大规模计算需求,确保模型的高效运行。

硬件基础设施:高性能计算集群:AI模型训练和推理需要强大的计算能力,高性能计算集群是AI基建的重要组成部分,包括高性能服务器、GPU/TPU等加速设备。边缘计算设备:为了支持AI技术在物联网、自动驾驶等领域的实时应用,边缘计算设备如智能摄像头、传感器等也构成了AI基建的一部分。

算力基础设施硬件是AI算力产业链的基础,主要包括芯片、服务器、光模块、高速铜连接、PCB以及液冷散热等关键组件。芯片:芯片是AI计算的核心,包括用于AI和高性能计算的DCU芯片(如海光信息提供)、云边端一体的AI芯片(如寒武纪提供)、国产GPU龙头(如景嘉微)以及国产CPU龙头(如龙芯中科)等。

基础设施 AI技术的底层是强大的基础设施,这些硬件为AI模型的训练和推理提供了必要的计算能力和存储空间。GPU(图形处理单元):专为并行计算而设计,适用于深度学习和复杂的计算任务。相比于传统的CPU,GPU在处理大量数据时表现更为出色,尤其在图像处理和神经网络训练方面。

gpu和npu有什么区别,分别龙头公司有哪些

〖壹〗、GPU与NPU的核心区别在于设计目标、架构特点和应用场景,龙头公司分别聚焦不同技术赛道。GPU与NPU的核心区别设计目标 GPU:最初为图形渲染设计,后因并行计算能力突出,扩展至通用计算领域(如科学计算、深度学习训练),强调高算力与生态兼容性。

〖贰〗、GPU领域的龙头公司有英伟达。英伟达在全球GPU市场占据主导地位,其产品广泛应用于游戏、专业图形、数据中心等多个领域。NPU方面,华为曾在这一领域有突出表现。华为的升腾系列NPU为其人工智能应用提供了强大的算力支持,在智能安防、智能驾驶等场景发挥了重要作用。

〖叁〗、不同类型的处理器在算力表现上各有优劣。CPU适合执行通用计算任务,但其算力相对较低;GPU具有强大的并行计算能力,适合处理大规模并行计算任务;NPU和TPU则是专门为深度学习优化的处理器,具有更高的能效比和算力表现。

〖肆〗、GPU:主要用于图形计算和并行计算,适合处理大规模的矩阵运算和向量计算,广泛应用于图形渲染、游戏和机器学习等领域。GPGPU:结合了GPU的并行计算能力和CPU的通用处理能力,擅长处理大量图像数据,在高性能运算和科学研究中有广泛应用。

〖伍〗、NPU与GPU相比,有以下主要差别:设计目的与用途 NPU:专为加速AI任务而设计,包括深度学习和推理。能够高效地处理大量数据,并利用专用存储器快速执行复杂的AI算法。

GPU平台的DGX、EGX、IGX、HGX、MGX区别

〖壹〗、综上所述,DGX、EGX、IGX、HGX和MGX是英伟达针对不同应用场景和需求推出的GPU平台。它们各自具有独特的特点和优势,用户可以根据具体需求选取合适的平台。

〖贰〗、IGX是工业级边缘AI平台,专为工业和医疗环境设计,强调企业级硬件、软件与安全支持,适用于关键任务的工业和医疗应用。HGX作为超大规模GPU加速器,提供高度定制的硬件解决方案,满足OEM厂商针对特定需求的微调,强调灵活性和灵活性的定制性。

〖叁〗、DGX - AI计算的专门力量 相较于HGX的全能,DGX则更加聚焦于AI计算。它专为AI研究和开发量身定制,提供强大的GPU加速和优化的软件环境,使得科学家和工程师能够更快速地构建、训练和部署复杂的AI模型。

〖肆〗、MGX架构:灵活性与可扩展性 NVIDIA为不同应用场景提供了多种架构,如NV EGX专为边缘AI优化,实现本地实时处理,NV HGX则聚焦AI和HPC的高性能计算,通过NVLink和NVSwitch连接多GPU,灵活配置。而NV DGX则专为AI定制,硬件配置固定。

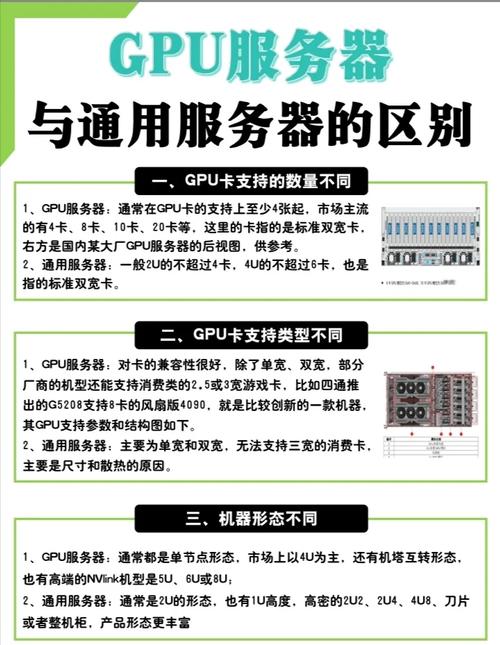

GPU服务器与CPU服务器的区别,如何选取GPU服务器

GPU架构以大量小而快的逻辑单元,以并行方式处理任务,特别适合重复计算。CPU则擅长处理复杂逻辑和控制任务。GPU在高强度并行计算中性能优于CPU。GPU服务器应用场景 GPU服务器适用于视频编解码、深度学习、科学计算等场景。提供高计算性能,有效提高计算效率与竞争力。

综上所述,GPU服务器与CPU服务器在处理任务类型和性能上存在显著差异。在选取GPU服务器时,应综合考虑业务需求、性能指标、服务器类型、特殊要求以及综合评估等因素,以确保所选服务器能够满足特定应用场景的需求。

GPU服务器与CPU服务器的主要区别在于它们的计算能力和适用场景。以下是两者的区别及如何选取GPU服务器的详细解GPU服务器与CPU服务器的区别 计算能力:CPU服务器:CPU擅长处理复杂的逻辑运算和程序流程控制,适合执行各种通用任务。

Supermicro推出适用于边缘计算部署的1U服务器

〖壹〗、Supermicro推出了适用于边缘计算部署的1U服务器。这款1U服务器是Supermicro针对边缘计算环境专门设计的,具备以下关键特性和优势:专为高计算量工作负载设计:该服务器专为AI、AR/VR、转码、游戏以及其他高计算量工作负载而打造,能够嵌入到电信网络中,以低延迟完成复杂计算任务。

〖贰〗、Supermicro AS-1115SV-WTNRT 是一款紧凑的 1U 服务器,专为需要高密度存储和计算能力的场景设计,如企业数据中心和边缘计算环境。

〖叁〗、Supermicro 1U AMD EPYC Siena是一款专为高性能应用设计的紧凑型1U服务器,其主要特点如下:高度与尺寸:高度约为597毫米,深度为25英寸,适合标准机架部署。CPU性能:搭载AMD EPYC 8004“Siena”系列CPU,具有64核/128线程SP6设计,性能卓越。

〖肆〗、在ISC 2020期间,NVIDIA携手多家全球领先的服务器制造商,共同发布了多款内置NVIDIA A100的系统。这些系统旨在应对AI、数据科学和科学计算领域最复杂的挑战,展现了业界对于高性能计算技术的持续追求与创新。

〖伍〗、W) x 249mm (D),重量63KG。应用:适用于网络安全设备、通用客户前提设备(UCPE)、软件定义广域网(SD-WAN)、NFV边缘计算服务器、虚拟化服务器以及物联网边缘计算/网关等场景。以上四款产品各具特色,可根据具体应用场景和需求进行选取。如需了解更多嵌入服务器产品,请联系相关供应商。

OK,关于边缘gpu服务器和边缘服务器英文的内容到此结束了,希望对大家有所帮助。