极智算总结:

- 遥感科学国家重点实验室的计算利器—工作站/服务器硬件配置推荐_百度...

- 机器学习gpu电脑配置深度学习对硬件的要求

- 如何科学的搭建一台深度学习服务器?

- 实验室配置服务器,4090,a100和a800选哪个?

- 通晓的回答下哪家GPU服务器更适合深度学习领域?

- 研究生毕设可能要用到深度学习,但实验室没gpu怎么办?

遥感科学国家重点实验室的计算利器—工作站/服务器硬件配置推荐_百度...

遥感科学国家重点实验室的项目成果主要包括以下几个方面:遥感辐射传输机理与反演理论研究:地表辐射模型系列:实验室通过几何光学模型,构建了一套完整的地表辐射模型系列,深入剖析了遥感像元空间尺度效应及其转换规律。

地理空间信息服务:构建基于遥感数据的地理空间信息服务平台,为政府决策、科学研究和社会公众提供服务。综上所述,遥感科学国家重点实验室在遥感信息的机理研究、遥感技术的尖端探索、遥感应用的基石以及遥感地理空间信息的集成理论构建等方面均处于学科前沿,为推动遥感科学的发展和应用做出了重要贡献。

遥感科学国家重点实验室的研究领域主要包括以下几个方面:遥感辐射传输原理与反演理论:专注于构建自主的遥感辐射传输模型,融合世界先进的多尺度模型。发展多源遥感数据协同反演的理论和方法,旨在建立涵盖多尺度遥感观测数据、地面台站观测数据和地表过程模型的综合理论体系。

遥感科学国家重点实验室简要概况如下:成立背景与历程:该实验室源于中国科学院遥感应用研究所和北京师范大学的联合力量,于2003年获得科技部的认可。2004年,实验室正式启动建设进程。2005年,实验室成功通过了国家验收和全国实验室的权威评审。

遥感科学国家重点实验室专注于多个关键科研领域,致力于推动遥感科技的发展。实验室的核心学术研究方向主要包括: 遥感信息机理:深入探究遥感数据背后的原理和技术,为数据解析提供理论基础。 遥感高技术前沿:实验室紧跟全球遥感技术的最新进展,探索前沿技术和创新应用。

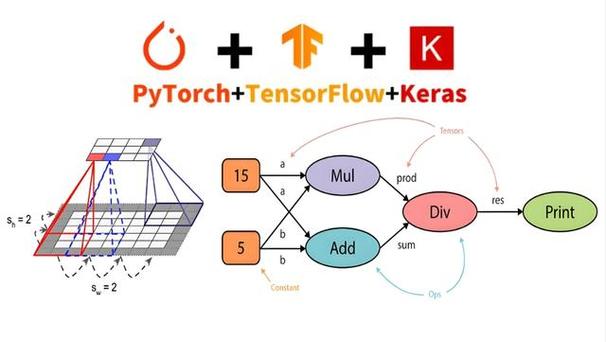

机器学习gpu电脑配置深度学习对硬件的要求

〖壹〗、要做一个深度学习的服务器,需要的配置有GPU RAM, 储存器,因为GPU是在我做深度学习服务器里面一个非常重要的部分,相当于是一个心脏,是非常核心的一个服务器,所以GPU是一个非常重要的东西,储存器也是相当重要的,因为很多数据都要放在ssd储存器上。

〖贰〗、对CPU没有太多要求,显卡的内存要大于3g要使用CUDNN的话,GPU的运算能力必须达到0。没有GPU也是可以的,但是会非常的慢对GPU没有要求,唯一的要求就是显卡要支持cuda(A卡泪奔。)。如果你显卡不支持cuda,也不要紧,可以用CPU跑。在你的网络配置文件solver.prototxt文件最后一行,设置为CPU模式即可。

〖叁〗、内存(RAM):足够的内存对于机器学习至关重要。初学者可以选取16GB作为起点,但随着模型复杂度的提高和数据量的增加,32GB或更高的内存容量将更为适宜。足够的内存可以确保数据快速加载和处理,避免在执行大规模计算任务时出现瓶颈。存储:建议选取SSD(固态硬盘)作为存储设备。

〖肆〗、处理器(CPU):推荐选取性能较强的处理器,如Intel Xeon W和AMD Threadripper Pro系列CPU,这些处理器具有出色的可靠性和为多个视频卡(GPU)提供所需的PCI-Express通道的能力。对于数据分析,i7四核处理器也是一个性能良好的选取。

如何科学的搭建一台深度学习服务器?

科学的搭建深度学习服务器需要综合考虑GPU、CPU、内存、磁盘存储和服务器机架等多个方面。在选取时,需根据具体任务需求、预算和可用空间等因素进行权衡。通过合理的配置和搭配,可以搭建出性价比高、性能强劲的深度学习服务器,满足各种深度学习任务的需求。

综上所述,科学的搭建一台深度学习服务器需要综合考虑GPU、CPU、内存、磁盘存储及机架等多个方面。通过合理的配置与优化,可以构建出性价比高、性能稳定的深度学习服务器,满足各种深度学习任务的需求。

搭建一台深度学习服务器需要以下步骤: 选取合适的硬件。 安装操作系统和相关软件。 配置服务器环境。 连接和优化硬件资源。下面详细解释这几个步骤:选取合适的硬件:对于深度学习服务器来说,硬件是基础。

深度学习环境搭建指南:配置深度学习环境服务器 安装Nvidiadocker:借鉴Nvidiadocker教程进行配置,确保可以在docker环境中使用GPU。拉取nvidia/cuda镜像:根据Linux版本和服务器cuda驱动版本,选取cudnn8devel版本,在服务器端拉取镜像。创建自定义镜像:自行创建dockerfile文件并命名为Dockerfile。

实验室配置服务器,4090,a100和a800选哪个?

选取实验室配置服务器的GPU时,主要考虑用途、预算和性能需求。对于深度学习与机器学习应用,GeForce系列如1080TI、2080TI、3090及4090等,因普及而广为使用。Tesla A100/A800具备双精度算力与高规格显存,性能显著,但性价比见仁见智。6-7万至8-9万的售价(仅供借鉴)反映了其高端定位。

算力性能上,H100和A100在深度学习等AI任务中表现出色,而RTX 4090则在图形渲染和游戏性能方面领先。显存与带宽:A100和H100提供高容量HBM2e和HBM3显存,带宽分别高达2 TB/s和3 TB/s。RTX 4090使用GDDR6X显存,容量为24GB,带宽相对较低。A800和H800的显存和带宽受限于出口管制。

A800定位为高端型号,性能稍逊于A100,但依然具备高效的并行处理和5TB/s的显存带宽,适用于专业图形渲染和高性能计算。H100专为数据中心优化,拥有1000TFLOPs的运算力,配合高速的5TB/s显存,适合大规模的数据分析和机器学习任务。

个人或实验室针对大模型的推理和微调需求配置服务器时,高端显卡近来可选 A100、A800、H100 和 4090 等。在大模型微调任务中,4090 的通信带宽相对较低,在大规模训练任务中通信会成为瓶颈。在预算差不多的情况下,两张 3090 比一张 4090 更值得推荐。

通晓的回答下哪家GPU服务器更适合深度学习领域?

〖壹〗、深度学习需要大量的并行计算资源,而且动辄计算几天甚至数周,而英伟达NVIDIA、英特尔Intel、AMD显卡(GPU)恰好适合这种工作,提供几十上百倍的加速,性能强劲的GPU能在几个小时内完成原本CPU需要数月完成的任务,所以近来深度学习乃至于机器学习领域已经全面转向GPU架构,使用GPU完成训练任务。

〖贰〗、高性能计算服务器推荐:超越想象的4卡英伟达4090深度学习GPU服务器 在2024年下半年的深度学习领域,一款全新的高性能计算服务器正以其卓越的性能和创新的配置引领着行业的革新。

〖叁〗、推荐GPU服务器平台:易学智能 简介:易学智能是一个专业且高效的GPU服务器平台,它不仅提供了丰富的GPU资源租赁服务,还涵盖了技术培训、人工智能技术分享等多方面的功能。该平台以其灵活多样的计费模式、强大的硬件配置、便捷的操作体验以及丰富的帮助文档,成为了深度学习训练领域的佼佼者。

〖肆〗、在2024年,深度学习领域的云GPU平台为研究人员和开发者提供了强大的计算资源。以下是基于硬件可用性、定价结构、软件和生态系统、易用性、客户支持以及附加功能等多个维度综合评估的前十云GPU平台:CUDO Compute 优点:提供广泛的NVIDIA GPU选取,包括最新的型号,且费用通常比传统云提供商更实惠。

研究生毕设可能要用到深度学习,但实验室没gpu怎么办?

〖壹〗、深度学习在现今的学术与工业领域越来越普及,尤其在研究生阶段,这成为了必备技能之一。然而,对于实验室尚未购置GPU资源的学生们,可能会遇到经费或采购周期的问题,这无疑会增加完成毕设的难度。因此,寻找替代方案便成为了关键。云GPU服务器平台成为了学生们的首选解决方案。

〖贰〗、开学在即,不少大学生面临跑深度学习模型的挑战,然而高昂的GPU费用让他们望而却步。配置个人设备几乎不可能,实验室的设备又老旧且不足用。过去,他们常寻找国外平台通过“薅羊毛”方式获取服务,但费用恢复后,只得无奈放手。今年因疫情,学校开放成为难题,实验更是难以进行。

〖叁〗、多看相关专业领域的一些权威期刊,对所报考导师的学术观点、论文、专著应有较深的了解。『3』关注一下相关评委的研究方向,毕竟不是你的导师的评委也可能提出一些问题。特别提醒:如果你的观点和导师的一致或者可以在他的基础上有所创新,那他一定会对你留下不错的印象。

〖肆〗、从一个过来人的角度说,比较好自己做,这样可以多学一些知识。但退一步讲,即使自己真的搞不出来超出自己能力了,也要找靠谱的人,不然很可能花了钱和时间什么成果都没有。

实验室gpu服务器搭建的介绍就聊到这里吧,感谢你花时间阅读本站内容,更多关于用实验室服务器跑代码、实验室gpu服务器搭建的信息别忘了在本站进行查找哦。