极智算总结:

- 企业级GPU服务器的市场费用区间是多少

- 火山引擎GPU服务器介绍:费用费用、优势功能及使用说明

- 什么是gpu服务器?

- 超级计算机,服务器的运算节点是什么

- 高性能GPU服务器集群拓扑及组网方案

- GPU服务器怎么选取呢?

- GPU服务器与通用服务器的区别

- 华为gpu服务器购买费用调研

- 如何开启ecc内存模式

- 两台gpu服务器卡如何组网可以实现点对点

企业级GPU服务器的市场费用区间是多少

企业级GPU服务器的费用区间通常在5万元至50万元人民币之间,具体取决于配置、品牌和应用场景。基础配置影响费用 入门级:搭载1-2张中端GPU(如NVIDIA T4或A10),费用约5-15万元,适合轻量级AI推理或图形处理。

图形处理服务器的费用区间通常在5万元至50万元人民币之间,具体取决于配置、品牌和应用场景。基础配置服务器 入门级(5万-15万元):搭载中端GPU(如NVIDIA RTX A4000或AMD Radeon Pro W6800),适合轻量级渲染或小型AI训练。

华为GPU服务器的费用因型号、配置和采购渠道不同差异较大,通常单台售价在10万至50万元人民币区间。影响费用的核心因素 GPU型号:搭载NVIDIA A100的机型比国产升腾910B成本高约30%-50%。 计算节点数量:8卡服务器(如Atlas 800)比4卡机型贵60%以上。

高端型号定价:配备英伟达下一代专为加速AI设计的GPU——Blackwell的服务器,市场定价区间为200万至300万美元每台。

火山引擎GPU服务器介绍:费用费用、优势功能及使用说明

火山引擎GPU服务器的计费类型多样,以满足不同用户的需求。主要包括按量计费、包年包月、抢占式实例和弹性约束实例四种模式。按量计费适合短时间使用,按小时收费;包年包月则适合长期使用,平均到每小时的费用更优惠。

性能优越:GPU 云服务器具有高并行、高吞吐、低时延等特点,在科学计算中的性能表现显著优于传统架构,同时在图像处理等场景也有明显优势。

我用过呀,火山引擎云服务器是一种安全稳定、可弹性伸缩的云计算服务。云服务器可以根据业务需要实时启用和增减计算资源,有效降低IT维护成本,助力核心业务增长。核心优势就是稳定安全、多样配置、即开即用。从功能上来说,第一,可以提供安全可靠的弹性计算服务。

火山引擎采用TensorRT推理框架后,线上服务速度提升了4至5倍,这大大提升了服务的实时性和可用性。节省计算资源:由于TensorRT能够高效利用GPU资源,因此火山引擎在提供高频海量计算请求的同时,能够节省大量的计算资源。这对于企业来说,意味着可以降低运营成本,提高资源利用率。

火山引擎的优势 速度快:经过对比,火山引擎的响应速度在同类平台中表现优异。有免费额度:新用户注册即可获得50万token的免费额度,满足基本使用需求。费用便宜:即使超出免费额度,火山引擎的定价也极具竞争力,近来提供DeepSeek官方五折的优惠费用。

更全产品能力:火山引擎AI一体机集成了火山方舟的同源能力,支持模型精调、推理、测评全方位功能和服务。不仅能单机8卡部署满血DeepSeek等开源模型,还预置了联网搜索等100+插件和海量行业应用模板,提供零代码、低代码的分钟级AI应用构建。同时,全面兼容英伟达GPU及国产异构计算卡,满足多样化算力需求。

什么是gpu服务器?

GPU服务器:配备高性能的GPU,具有强大的并行计算能力。这使得GPU服务器在处理大规模数据集和复杂计算任务时表现出色。普通服务器:主要依赖CPU进行计算,虽然CPU在处理串行任务时表现出色,但在处理大规模并行计算任务时,其性能往往不如GPU。

GPU服务器是基于GPU的应用于多种场景的快速、稳定、弹性的计算服务。其出色的图形处理能力和高性能计算能力提供极致计算性能,有效解放计算压力,提升产品的计算处理效率与竞争力。GPU服务器的主要用处包括但不限于以下几个方面:视频编解码:GPU服务器可以加速视频编解码过程,提高视频处理效率。

综上所述,GPU服务器是一种基于GPU加速计算的服务器,具有广泛的应用领域和多种类型。在选取GPU服务器时,需要根据业务需求、服务器应用情景、顾客自身应用群体和IT运维能力、配套设施应用软件和服务的使用价值以及总体GPU集群系统软件的完善程度和工程效率等因素进行综合考虑。

GPU服务器:基于GPU构建,主要应用于视频编解码、深度学习、科学计算等多种需要高性能计算的场景。GPU服务器提供快速、稳定、弹性的计算服务,并具备和标准云服务器一致的管理方式。普通服务器:通常用于一般的办公场景、数据存储、网站托管等,其计算能力和图形处理能力相对有限,无法满足高性能计算需求。

GPU服务器是基于GPU应用在视频编解码、深度学习、科学计算等多场景下的稳定、快速且弹性的计算服务。GPU服务器的作用加速计算:GPU能够显著加快计算速度,通过将应用软件中的部分计算负荷迁移到GPU上,而CPU则继续运行其他代码。这种分工使得应用软件的运行速度得到明显提升。

超级计算机,服务器的运算节点是什么

〖壹〗、超级计算机中,运算节点通常指的是执行计算任务的基本单元,它们可以是CPU,也可以是GPU,或者是两者结合的架构。在这个例子中,提到的两个CPU每个含有12个processor,这表明运算节点可能是基于多核处理器的CPU,或者是多个处理器的组合。每个CPU作为独立的运算节点,拥有自己的cache和内存,能够独立执行任务。

〖贰〗、超级计算机的基础节点包括三种:16000个计算节点,4096个管理节点,256个IO节点和64个存储服务器。先看看最小的组件:计算节点。2 个Intel Ivy Bridge CPU + 3个 Intel Xeon Phi 。CPU之间用QPI总线互联,一般NUMA架构是这么做的。每个CPU有自己的DIMM内存,一共64GB。

〖叁〗、超级计算机(Supercomputers)通常是指由数百数千甚至更多的处理器(机)组成的、能计算普通PC机和服务器不能完成的大型复杂课题的计算机。超级计算机是计算机中功能最强、运算速度最快、存储容量最大的一类计算机,是国家科技发展水平和综合国力的重要标志。超级计算机拥有最强的并行计算能力,主要用于科学计算。

〖肆〗、神威·太湖之光超级计算机由40个运算机柜和8个网络机柜组成。 每个运算机柜比家用的双门冰箱略大,打开柜门,4块由32块运算插件组成的超节点分布其中。 每个插件由4个运算节点板组成,一个运算节点板又含2块“申威26010”高性能处理器。

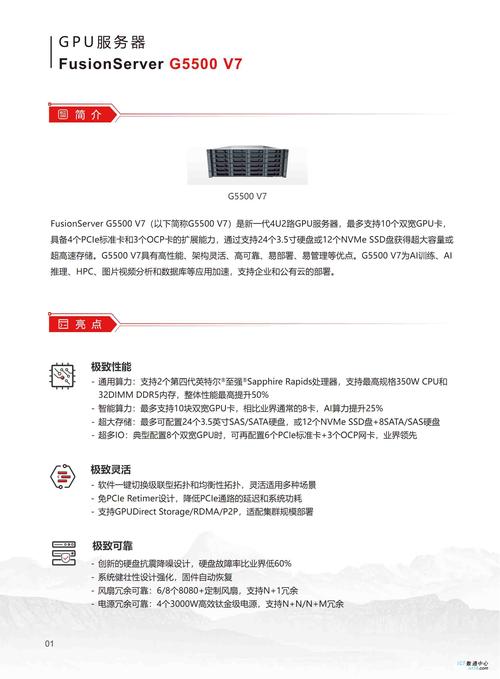

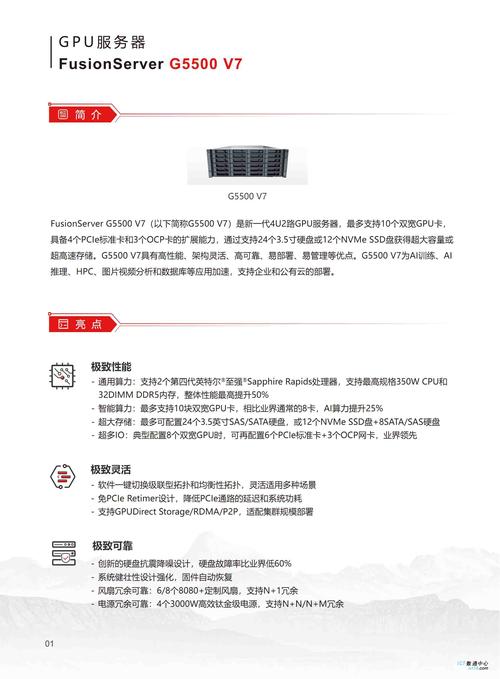

高性能GPU服务器集群拓扑及组网方案

测试时需搭配200Gbps交换机以发挥卡间性能。L40S架构优化数据路径,采用单机4卡设计消除主机带宽瓶颈。综上所述,高性能GPU服务器集群拓扑及组网方案需综合考虑硬件拓扑、内部互联技术、网络技术选取以及带宽分析等因素,以实现高效的数据传输和计算性能。

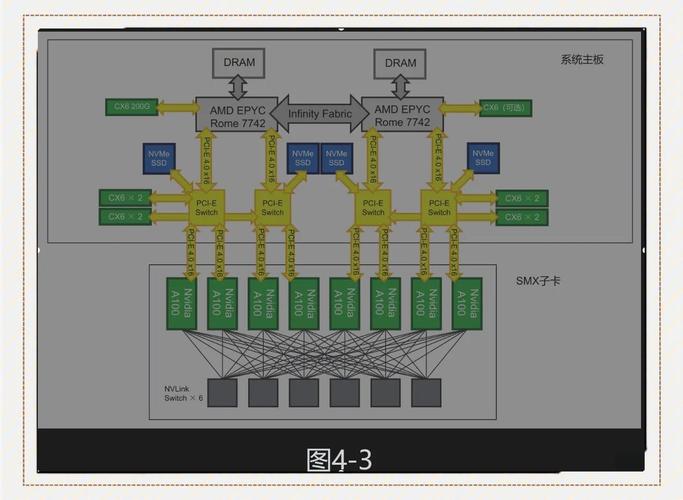

高性能GPU服务器集群拓扑及组网方案 高性能GPU服务器硬件拓扑与集群组网,采用集群式架构,每台主机配备8块高性能GPU,包括A100、A800、H100、H800四种机型。典型8*A100GPU主机内部硬件架构包括高效互联的PCIe总线、NVLink、DCGM监视工具、NVSwitch交换芯片等。

在GPU/TPU集群网络组网中,NVLink、InfiniBand、ROCE以太网Fabric以及DDC网络方案是当前流行的技术选取。这些技术各有优劣,适用于不同的场景和需求。以下是对这些技术的详细分析:NVLink交换系统 优势:高速点对点链路:NVLink是专门设计为连接GPU的高速点对点链路,具有比传统网络更高的性能和更低的开销。

两台GPU服务器卡要实现点对点组网,可以通过使用专用的高速互连网络来实现,比如InfiniBand(IB)网络。以下是具体的组网步骤:购买并安装专用高速互连设备:选取设备:根据两台GPU服务器的配置和需求,选取适合的InfiniBand设备。

性能表现:每台B200服务器都配备了八颗与第五代NVIDIA NVLink互连的NVIDIA Blackwell GPU,提供卓越的训练和推论效能。在128台服务器的规模下,该组网方案将能够支持大规模并行计算和深度学习应用,实现高效的计算资源利用和数据处理能力。

GPU服务器怎么选取呢?

〖壹〗、选取GPU型号 边缘服务器:在边缘服务器租用上,需根据业务量和使用场景来选取GPU型号。例如,对于火车站卡口、机场卡口或公安卡口等场景,可能需要选取T4或P4等型号的GPU服务器。

〖贰〗、阿里云GPU服务器:全球覆盖,企业级稳定;提供T4/V100/A100等多种GPU型号选取;费用相对较高,但性能稳定可靠。腾讯云GPU服务器:国内低延迟,BGP优化;提供T4/A10/A100等GPU型号选取;适合游戏、直播等国内业务场景。

〖叁〗、预算充足:若预算充足,可以选取性能卓越的服务器配置,如风虎云龙 RH88。这样的服务器不仅拥有强大的硬件配置,还可以根据具体需求进行定制化,从 CPU、内存、硬盘到 GPU 等各个组件都能按照自身要求进行选配,打造完全符合自己需求的高性能服务器。

〖肆〗、显存容量的选取需根据模型参数规模来确定,一般遵循公式:显存容量 ≥ 模型参数规模(GB)× 2(考虑中间变量)。例如,训练100亿参数模型至少需要24GB显存,RTX 4090的24GB显存即可满足需求,而盲目选取更高显存的A100则会浪费成本。

〖伍〗、根据应用场景选取GPU服务器。确保所选服务器能够满足特定业务对计算性能的需求。关注性能指标:精度:根据应用需求选取合适的计算精度。显存:确保显存足够大,以容纳大规模数据集和模型。功耗:考虑服务器的功耗和散热性能,以确保稳定运行。选取服务器类型:根据需求选取OEM或非OEM服务器。

GPU服务器与通用服务器的区别

通用服务器:哪里都可以用,比如做私有云、分布式存储、管理节点、HPC通用算力节点等等。两者在业务场景定位上有所不同,GPU服务器更专注于高性能计算和图形处理等领域,而通用服务器则更为通用,适用于多种场景。综上所述,GPU服务器与通用服务器在GPU卡支持数量、类型、机器形态、拓扑结构、功耗、费用以及业务场景定位等方面均存在显著差异。

GPU服务器:通常配备高性能的GPU卡,以及与之匹配的高性能CPU、内存和存储设备。普通服务器:硬件配置相对较为通用,主要根据具体应用场景进行配置。费用:GPU服务器:由于配备了高性能的GPU和其他相关硬件,费用相对较高。普通服务器:费用相对较为亲民,根据具体配置和品牌有所不同。

GPU服务器与普通服务器的硬件区别 GPU服务器和普通服务器之间的主要区别在于它们所针对的工作负载类型以及为此优化的硬件配置。以下是两者之间的一些关键差异:处理器(CPU)普通服务器:通常配备多核高性能中央处理器(CPU),这些CPU适用于处理大量并发请求或执行复杂的计算任务,如数据库查询、Web服务等。

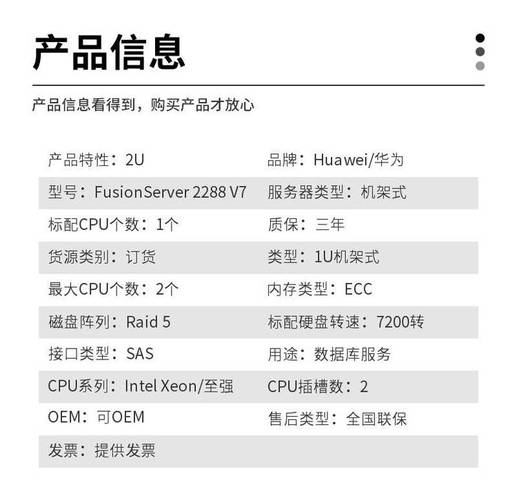

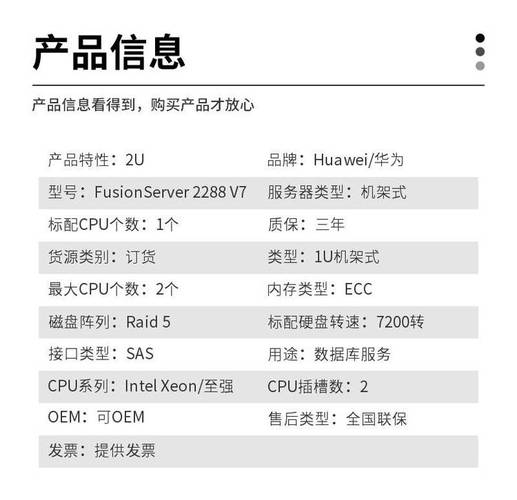

华为gpu服务器购买费用调研

华为GPU服务器的费用因型号、配置和采购渠道不同差异较大,通常单台售价在10万至50万元人民币区间。影响费用的核心因素 GPU型号:搭载NVIDIA A100的机型比国产升腾910B成本高约30%-50%。 计算节点数量:8卡服务器(如Atlas 800)比4卡机型贵60%以上。

G6v.xlarge.2年费7,199元,相当于月均599元,较按月计费节省约13%。代理商折扣政策通过华为云代理商(如典名科技)购买,可享受折扣和返利政策,进一步降低企业成本。例如,G6v.xlarge.2年费实际支付约7,199×0.7×0.85=4,266元,较原价降低约41%。

企业级GPU服务器的费用区间通常在5万元至50万元人民币之间,具体取决于配置、品牌和应用场景。基础配置影响费用 入门级:搭载1-2张中端GPU(如NVIDIA T4或A10),费用约5-15万元,适合轻量级AI推理或图形处理。

如何开启ecc内存模式

开启ECC内存模式的方法主要有两种:一种是针对服务器主板BIOS的设置,另一种是针对GPU节点的设置。针对服务器主板BIOS的设置:进入BIOS设置:在启动计算机时,按下特定的键(如FDEL或ESC)进入BIOS设置界面。找到内存或高级设置:在BIOS菜单中,浏览到与内存或高级设置相关的选项。

使用方向键在BIOS界面中导航至“高级”或“模式设置”选项。具体名称可能因BIOS版本不同而有所差异。开启ECC模式:在“高级”或“模式设置”选项下,找到“ecc内存校验”或“ecc模式”相关设置,并根据提示进行勾选。保存设置并退出:完成设置后,按下F10键以保存并退出BIOS设置。随后,重启电脑。

您好,感谢您选取惠普产品。惠普z220sff 工作站BIOS中,查看advanced栏目下bus options 中,ECC support修改为Enable 选取开启ECC内存功能。

首先将ecc内存安装至台式机上。其次在bios选项中打开ecc选项。最后在普通主板上使用ecc内存即可。ECC内存,即应用了能够实现错误检查和纠正技术的内存条。

两台gpu服务器卡如何组网可以实现点对点

〖壹〗、两台GPU服务器卡要实现点对点组网,可以通过使用专用的高速互连网络来实现,比如InfiniBand(IB)网络。以下是具体的组网步骤:购买并安装专用高速互连设备:选取设备:根据两台GPU服务器的配置和需求,选取适合的InfiniBand设备。

〖贰〗、统一内存:支持连接的GPU之间的内存池,对于大型数据集任务至关重要。工作原理 NVLink由可以双向传输数据的高速数据通道组成,采用点对点连接,有效减少瓶颈并提高数据吞吐量。支持网状拓扑,允许GPU之间实现更通用且数量更多的连接。

〖叁〗、技术特点 高速互连:NVLink通过高速连接两块NVIDIA显卡,能够实现显存和性能的扩展,从而满足最大视觉计算工作负载的需求。高带宽:与传统的PCIe相比,NVLink提供了高达10倍的带宽,这使得多个GPU能够在单个服务器内通过点对点网络连接在一起,形成混合立方体网格。

〖肆〗、高速点对点链路:NVLink是专门设计为连接GPU的高速点对点链路,具有比传统网络更高的性能和更低的开销。网络内聚合:第三代NVswitch配备64个NVLink端口,提供高达18Tbps的交换容量,支持多播和网络内聚合功能,有助于减少训练迭代过程中GPU之间的数据传输量。

gpu服务器节点和gpu服务器显卡的问题分享结束啦,以上的文章解决了您的问题吗?欢迎您下次再来哦!