极智算总结:

- 高性能计算服务器推荐(二)科研新动力:2024下半年8卡GPU服务器,科研界...

- 中国长城推出4u8卡gpu服务器

- 8卡gpu服务器功率要求

- 8卡大模型机器配置推荐

- 8块4090显卡!机架式GPU服务器方案

- 使用DoraCloud搭建8卡GPU云桌面环境

高性能计算服务器推荐(二)科研新动力:2024下半年8卡GPU服务器,科研界...

〖壹〗、卡英伟达4090深度学习服务器 这款服务器搭载了8张NVIDIA Geforce RTX 4090涡轮版显卡,以其极致的计算性能和效率,能够显著减少深度学习模型的训练和推理任务时间。

〖贰〗、NVIDIA液冷GPU的推出,为高性能绿色数据中心的建设提供了新的解决方案。这款GPU不仅提升了数据中心的计算性能和能效,还为实现可持续发展目标做出了重要贡献。未来,随着液冷技术的不断发展和完善,我们有理由相信,它将在更多领域发挥重要作用,推动全球向更加绿色、可持续的未来迈进。

〖叁〗、曙光凭借高性能计算优势,在特定领域占据重要地位。 为科研机构提供强大计算能力,助力科研项目突破。像在天体物理研究中,曙光服务器支持大规模数据模拟和分析。 针对气象预报等对时效性要求高的领域,曙光高性能服务器能快速处理海量气象数据,提高预报准确性。

〖肆〗、数据存储的新动力:亿玖EN212-S6HM分布式闪存存储服务器 亿玖EN212-S6HM分布式闪存存储服务器是一款高性能的存储设备,专为满足大数据时代对数据存储的高效、可靠需求而设计。以下是对该服务器的详细解析:分布式架构设计 EN212-S6HM采用分布式架构设计,将多个存储节点分布在不同的地理位置。

中国长城推出4u8卡gpu服务器

〖壹〗、中国长城推出的4U8卡GPU服务器是一款高性能、高密度的计算解决方案,专为满足大规模并行计算和深度学习等应用需求而设计。

〖贰〗、龙芯服务器品牌有曙光、北方自控、诚迈科技、中核华辉、兴研科技、浪潮信息、中兴通讯、联想开天、中国长城、中科曙光、同方股份、浪潮计算机、超越科技、航天706所、国鑫、紫光股份(新华三)等。曙光:早期推出龙腾服务器填补空白,现有机架式、刀片等系列产品。

8卡gpu服务器功率要求

〖壹〗、一块GPU卡一般耗电350W,一般4U的服务器最大可以支持8块GPU卡,通常业内多称之为8卡GPU服务器,当然也有4卡,6卡的。如果装满8卡GPU,那么其耗电在2800瓦,差不多就是 13A电力。

〖贰〗、中配置GPU服务器:当服务器搭载中等数量的GPU(如4-6张)时,其功率会相应增加,可能在2000W-4000W之间。这类服务器能够满足大多数高性能计算和深度学习等应用的需求。高配置GPU服务器:对于配置了8张或更多高性能GPU卡的服务器,其功耗可能会逼近甚至超过4000W,甚至达到5000W以上。

〖叁〗、处理器:AMD EPYC 7443 24核 * 2内存:64GB * 8硬盘:4TB NVME + 16TB HDD * 6GPU:NVIDIA 4070TI * 8网卡:I350-T4,X520-2电源:4个2000瓦电源机箱:4U机箱主板:同泰怡主板软件部署 部署Proxmox VE 2 配置规划:将默认的Local-lvm存储改造为文件存储。

〖肆〗、电源:考虑到8块RTX 4090显卡的高功耗,选取一款高功率的服务器电源至关重要。建议选用至少2000W以上的冗余电源,以确保在单个电源故障时,服务器仍能正常运行。处理器配置 CPU:推荐采用2颗36核心的1GHz Intel Xeon Platinum 8352V处理器。

〖伍〗、功耗估算 典型工作负载下的功耗:一种观点认为,H200八卡服务器在典型工作负载下的整机功耗约为3500-4200W。这个范围提供了一个大致的功耗借鉴。最大耗电量:以H800 GPU PCIE 服务器整机为例(虽非H200,但可作为借鉴),其最大耗电量约为6800W。

〖陆〗、适用场景:中大规模企业快速落地AI应用,尤其适合金融、医疗、政务等对数据安全要求高的敏感场景。方案二:4090 8GPU 4U机架式服务器GPU配置:8块NVIDIA GeForce RTX 4090,每卡24GB GDDR6X显存,集群总显存192GB。支持数十亿参数模型训练(如70亿参数模型全参数微调,130亿级模型LoRA/QLoRA微调)。

8卡大模型机器配置推荐

方案二:4090 8GPU 4U机架式服务器GPU配置:8块NVIDIA GeForce RTX 4090,每卡24GB GDDR6X显存,集群总显存192GB。支持数十亿参数模型训练(如70亿参数模型全参数微调,130亿级模型LoRA/QLoRA微调)。

运行8卡大模型对机器配置有较高要求。 处理器:建议选用具有多核心和高主频的CPU,比如英特尔至强铂金系列等,能为模型运行提供稳定的计算基础。 显卡:8卡意味着需要多张高性能显卡,像英伟达的A100、H100等专业计算卡,它们具备强大的并行计算能力,可大幅加速模型训练。

选取DeepSeek大模型:在模型管理功能菜单中,选取需要部署的DeepSeek大模型。本例中,选取DeepSeek-R1671B参数模型。LinkAI私有化版还支持其他参数的DeepSeek模型(如5B~70B的蒸馏版本),以及Qwen、Llama等不同参数大小的开源模型。企业可根据实际需求和机器资源条件选取适合的模型。

卡L40理论上具备微调32B模型的潜力,但需结合具体微调场景验证资源需求。硬件配置与显存支持NVIDIA L40或L40S单卡显存为48GB,8卡总显存达384GB。对于32B参数的模型,若采用FP16精度,模型参数占用约64GB显存(32B×2字节/参数),加上梯度、优化器状态等中间变量,实际显存需求可能翻倍至128GB以上。

此类大模型对显存和算力要求极高,8卡H20(单卡141GB显存)通过显存共享和算力聚合,可实现单套大模型的高效运行,但难以同时部署多套同类模型。

图片展示:8卡英伟达A100深度学习GPU服务器 这款服务器则采用了8张NVIDIA A100显卡,其计算性能和效率同样出色,能够为用户的大规模深度学习模型训练和推理任务带来革命性的加速体验。

8块4090显卡!机架式GPU服务器方案

针对您提出的机架式GPU服务器方案需求,以下是一个基于8块NVIDIA Geforce RTX 4090显卡的详细方案。此方案旨在提供强大的计算力,以支持复杂的数据分析、机器学习及深度学习等任务。服务器基础配置 机箱:选取一款高质量的机架式服务器机箱,确保有足够的空间和散热能力来容纳8块RTX 4090显卡。

卡英伟达4090深度学习服务器 这款服务器搭载了8张NVIDIA Geforce RTX 4090涡轮版显卡,以其极致的计算性能和效率,能够显著减少深度学习模型的训练和推理任务时间。

方案二:4090 8GPU 4U机架式服务器GPU配置:8块NVIDIA GeForce RTX 4090,每卡24GB GDDR6X显存,集群总显存192GB。支持数十亿参数模型训练(如70亿参数模型全参数微调,130亿级模型LoRA/QLoRA微调)。

任务调度优化:采用Kubernetes集群管理,提高GPU利用率至85%以上。硬件迭代规划:与机房签订3年以上合约可获得15-20%的电费折扣。综上所述,托管八卡4090算力服务器到苏州胜网高电机房或中国电信苏州太湖世界数据中心都是较为划算的选取。

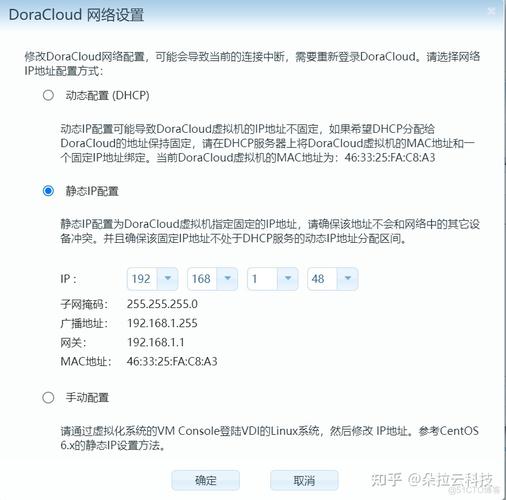

使用DoraCloud搭建8卡GPU云桌面环境

为GPU创建Resource Mapping:在Proxmox上创建Resource Mapping,实现GPU设备的池化管理,便于虚拟机动态分配。部署DoraCloud云桌面 在线安装DoraCloud:使用一键安装脚本在线安装DoraCloud。

点击RDP文件,连接用户桌面,输入Windows账户和密码,进入系统。使用DoraCloudClient客户端登录:下载并打开DoraCloudClient。输入DoraCloud管理后台的地址、用户名和密码。点击登录,会自动下载RDP文件进入云桌面。通过以上步骤,即可成功使用Proxmox和DoraCloud搭建桌面云系统。

使用DoraCloud搭建统信UOS的信创云桌面的步骤如下: 环境准备: 确保服务器配置满足要求,包括256G内存和960G企业级SSD。 确保局域网环境稳定,DHCP服务正常运行,并能访问互联网。

可以使用DoraCloud搭建免费的桌面云办公平台。以下是具体步骤和注意事项:准备硬件资源:内存:每个用户需准备8GB内存。系统盘:每个用户需80GB系统盘,推荐使用SSD以提高性能。软件准备与安装:安装DoraCloud管理系统,通过Proxmox的shell进行在线安装。系统会自动分配或手动配置IP地址。

创建桌面池,配置UOSCloud模板、虚拟机数量(最大3个预创建3个),以及管理员账号(内置模板账号),并设定用户数据盘。创建群组和用户,分配UOS桌面给群组,批量新增用户。至此,DoraCloud桌面云环境搭建完成,用户可通过客户端或云终端登录,访问统信UOS桌面模板和创建的桌面。

使用Proxmox和DoraCloud搭建桌面云系统的步骤如下:准备工作:确保服务器配置满足要求:i5及以上CPU,8GB及以上内存,SSD硬盘。启用DHCP服务。下载Proxmox VE 2的ISO镜像,可以从官方或中科大、清华大学的开源镜像站获取。准备U盘制作工具。安装Proxmox:通过U盘启动服务器,按照提示完成Proxmox的安装。

关于本次8卡服务器gpu和8卡服务器gpu全部打开mp3的注意事项的问题分享到这里就结束了,如果解决了您的问题,我们非常高兴。