极智算总结:

- 4u5卡gpu是什么档次

- 两台gpu服务器卡如何组网可以实现点对点

- 8卡gpu服务器功率要求

- 2024年8月!!!当下最火GPU服务器你知道是哪几款吗?

- 如何搭建多人共用的gpu服务器?

- ...科研新动力:2024下半年8卡GPU服务器,科研界新宠

4u5卡gpu是什么档次

〖壹〗、U5卡GPU属于中高端档次。4U5卡GPU在性能方面表现较为出色。它具备较高的计算能力,能够快速处理复杂的图形计算任务,像在一些专业的图形设计软件中,能高效地渲染出高质量的图像。在游戏领域,也可以流畅运行主流3A游戏,为玩家带来清晰、逼真的画面体验。

〖贰〗、U5卡GPU服务器通常被认为是高性能计算或高端服务器配置的一种。配置特点 支持多GPU卡:4U5卡GPU服务器支持5块全高双宽高性能GPU卡,这种配置使得服务器在处理大规模数据和高复杂度计算任务时具有显著优势。

〖叁〗、GPU卡支持数量 GPU服务器:通常在GPU卡的支持上至少4张起,市场主流的有4卡、8卡、10卡、20卡等,这里的卡指的是标准双宽卡。通用服务器:一般2U的不超过4卡,4U的不超过6卡,同样指标准双宽卡。GPU服务器在GPU卡支持数量上明显多于通用服务器。

〖肆〗、性能卓越的4U双路4GPU高性能计算服务器EG404E6HR具有以下特点:处理器配置强大:搭载了第5/4代英特尔至强可扩展系列处理器,支持双路配置,采用高吞吐、低延时架构,提供卓越的计算性能。

〖伍〗、在企业数字化转型的关键时刻,高性能和高可靠性是GPU服务器解决方案的必备条件。Enine亿玖的4U双路4GPU服务器EG404-E6HR,凭借其卓越的性能,成为了应对这些挑战的理想选取。这款服务器搭载了第5/4代英特尔至强可扩展系列处理器,拥有480mm宽*180mm高*665mm深的4U标准设计,紧凑且高效。

〖陆〗、在MLPerf Inference v1这一行业标准的推理性能衡量标准中,NVIDIA H100和Transformer Engine的性能比A100高5倍,进一步证明了H100在深度学习推理任务中的卓越表现。

两台gpu服务器卡如何组网可以实现点对点

两台GPU服务器卡要实现点对点组网,可以通过使用专用的高速互连网络来实现,比如InfiniBand(IB)网络。以下是具体的组网步骤:购买并安装专用高速互连设备:选取设备:根据两台GPU服务器的配置和需求,选取适合的InfiniBand设备。

统一内存:支持连接的GPU之间的内存池,对于大型数据集任务至关重要。工作原理 NVLink由可以双向传输数据的高速数据通道组成,采用点对点连接,有效减少瓶颈并提高数据吞吐量。支持网状拓扑,允许GPU之间实现更通用且数量更多的连接。

技术特点 高速互连:NVLink通过高速连接两块NVIDIA显卡,能够实现显存和性能的扩展,从而满足最大视觉计算工作负载的需求。高带宽:与传统的PCIe相比,NVLink提供了高达10倍的带宽,这使得多个GPU能够在单个服务器内通过点对点网络连接在一起,形成混合立方体网格。

高速点对点链路:NVLink是专门设计为连接GPU的高速点对点链路,具有比传统网络更高的性能和更低的开销。网络内聚合:第三代NVswitch配备64个NVLink端口,提供高达18Tbps的交换容量,支持多播和网络内聚合功能,有助于减少训练迭代过程中GPU之间的数据传输量。

在实际应用中,除了考虑硬件性能外,还需要关注软件优化、网络配置等方面。例如,正确安装和配置NCCL、使用高性能的网卡和交换机等都可以进一步提升分布式训练的性能。通过以上分析,我们可以更好地理解NCCL在GPU分布式训练中的作用以及DGX系列服务器的性能优势。

工业数据采集卡:如NI PCIe-7852R通过PCIe接口实现多通道高速数据采集。车载计算平台:NVIDIA DRIVE AGX Orin等车载计算平台通过PCIe连接激光雷达、摄像头等传感器,实现自动驾驶数据处理。PCIe的相关应用案例 数据中心与云计算 GPU资源池化:通过PCIe交换机实现多台服务器共享GPU资源。

8卡gpu服务器功率要求

中配置GPU服务器:当服务器搭载中等数量的GPU(如4-6张)时,其功率会相应增加,可能在2000W-4000W之间。这类服务器能够满足大多数高性能计算和深度学习等应用的需求。高配置GPU服务器:对于配置了8张或更多高性能GPU卡的服务器,其功耗可能会逼近甚至超过4000W,甚至达到5000W以上。

一块GPU卡一般耗电350W,一般4U的服务器最大可以支持8块GPU卡,通常业内多称之为8卡GPU服务器,当然也有4卡,6卡的。如果装满8卡GPU,那么其耗电在2800瓦,差不多就是 13A电力。

卡算力服务器的散热量通常在3600W至6800W之间,具体取决于GPU型号、功耗设计及运行状态。以下从关键参数、影响因素及散热设计三方面展开分析:核心散热参数不同GPU配置的散热需求差异显著。

功耗估算 典型工作负载下的功耗:一种观点认为,H200八卡服务器在典型工作负载下的整机功耗约为3500-4200W。这个范围提供了一个大致的功耗借鉴。最大耗电量:以H800 GPU PCIE 服务器整机为例(虽非H200,但可作为借鉴),其最大耗电量约为6800W。

2024年8月!!!当下最火GPU服务器你知道是哪几款吗?

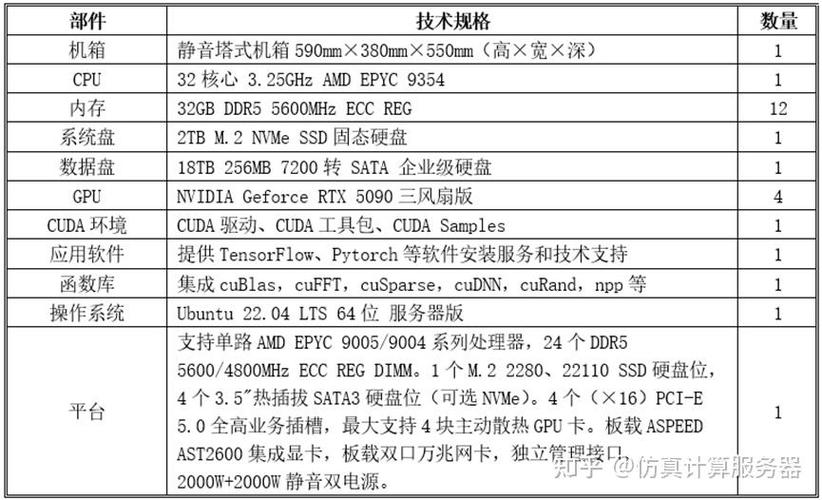

年8月当下最火的GPU服务器是4卡安静4090工作站以及相关的双卡4090工作站和四卡4090塔式静音服务器。以下是对这几款服务器的详细介绍:4卡安静4090工作站 这款GPU服务器以其极致的计算性能和效率,显著减少了训练推理任务的时间,被誉为性能怪兽。

卡英伟达4090深度学习服务器 这款服务器搭载了8张NVIDIA Geforce RTX 4090涡轮版显卡,以其极致的计算性能和效率,能够显著减少深度学习模型的训练和推理任务时间。

高性能计算服务器推荐:超越想象的4卡英伟达4090深度学习GPU服务器 在2024年下半年的深度学习领域,一款全新的高性能计算服务器正以其卓越的性能和创新的配置引领着行业的革新。

如何搭建多人共用的gpu服务器?

搭建多人共用的GPU服务器,可以按照以下步骤进行:选取服务器硬件:确保支持GPU:选取能够支持至少一个或多个高性能GPU的服务器硬件。考虑CPU、内存和硬盘:根据任务需求,选取性能强劲的CPU、足够的内存容量以及充足的硬盘空间。电源和散热:确保电源供应稳定且散热系统能够有效应对高负载运行时的热量问题。

电源:选取能够承载CPU和GPU消耗的电源,确保稳定运行。二级存储:固态硬盘或SATA硬盘,用于存储数据和系统文件。选取GPU 根据计算需求选取合适的GPU品牌和型号。特斯拉工作站产品(C系列):主动降温,适合桌面计算机。服务器产品(M系列):被动降温,适合安装在服务器上。

为GPU创建Resource Mapping:在Proxmox上创建Resource Mapping,实现GPU设备的池化管理,便于虚拟机动态分配。部署DoraCloud云桌面 在线安装DoraCloud:使用一键安装脚本在线安装DoraCloud。基础配置:安装后,进入DoraCloud后台,根据配置向导完成虚拟化、资源池、集群、用户数据库的配置。

...科研新动力:2024下半年8卡GPU服务器,科研界新宠

综上所述,这两款8卡GPU服务器均具备出色的计算性能、稳定性和可扩展性,是科研工作者在2024年下半年进行深度学习研究和模型训练的理想选取。无论是选取RTX 4090还是A100显卡的服务器,都能为用户带来卓越的计算体验和科研成果。

关于多gpu卡服务器到此分享完毕,希望能帮助到您。

标签: gpu服务器