极智算总结:

- 如何使用gpu

- gpu服务器怎么用

- 如何在服务器使用显卡

- 如何在Linux系统中安装GPU驱动

- 在linux算力服务器安装stable-diffusion-webui最详细排坑教程

- 【深度学习】谷歌云GPU服务器创建与使用指南(一)

- 不再被GPU各种驱动绑架!一站式解决GPU问题

如何使用gpu

选取GPU:选取具有足够CUDA核心、高内存带宽和足够显存的GPU,以确保能够处理大型模型和大量数据。环境设置:安装PyTorch:确保安装了支持CUDA的PyTorch版本。安装CUDA驱动程序和工具包:这是运行CUDA程序所必需的。

使用GPU的方法主要包括确认硬件支持、安装驱动程序、安装CUDA和cuDNN(针对深度学习)、配置环境变量、安装深度学习框架以及验证安装等步骤。前期准备 确认硬件支持:确保计算机或服务器装有支持CUDA或其他并行计算框架的GPU,如NVIDIA GPU。

GPU是图形处理器,启用Gpu渲染加速,就是调用GPU加速图形的渲染和填充。开启GPU渲染加速后可以提升图形加载速度,降低CPU处理器的负担,使系统运行更加流畅,但是也更加耗电。强制进行GPU渲染,就是用显卡来运行游戏,而不是用CPU来运行。

要用GPU加速任一程序,具体方法包括确保硬件和软件支持、配置环境、设置默认GPU、进行应用程序特定的设置以及检查GPU是否可用。 确保硬件和软件支持 硬件:计算机需配备支持GPU加速的独立显卡,并确保显卡驱动程序是最新的。软件:对于要加速的程序,需确认其是否支持GPU加速功能。

gpu服务器怎么用

〖壹〗、GPU服务器的使用主要包括以下步骤: 明确应用需求:首先确定你要使用GPU服务器进行哪种类型的计算,如深度学习、科学计算或图形渲染等,因为不同的应用对GPU的型号和性能要求不同。 选取云服务提供商:根据你的需求和预算,选取一个合适的云服务提供商,比较其费用、性能、服务质量和支持情况。

〖贰〗、管理、磁盘、网络、SSH密钥:在“管理”下方找到“可用性策略”,如需要创建可抢占实例(以相对低廉的费用使用高性能的GPU服务器,但有效期只有24小时,过期或遇到特殊情况会被自动删除),只需将“抢占”设置为开启。SSH密钥部分可以暂时忽略,后续会详细讲解。

〖叁〗、在VSCode中远程连接到服务器并调用GPU:如果您习惯使用VSCode进行代码开发,可以通过配置远程连接插件(如Remote - SSH)连接到装备了GPU的服务器。在远程服务器上,您可以像在本地一样运行和调试使用GPU加速的代码,如PyTorch等深度学习框架。

〖肆〗、点击“免费使用”注册天翼云账号,通过天翼云官方网站的注册页面完成账号的创建。实名认证 登录天翼云官方网站控制台,完成实名认证。这一步是确保账号的安全性和合法性,部分产品可能需要将个人实名认证升级为企业认证以享受更多优惠。选取GPU云服务器 在天翼云官方网站的产品页面,选取GPU云服务器。

〖伍〗、在服务器使用显卡的步骤:操作系统安装 确定操作系统及版本号:选取Ubuntu作为操作系统。确定Ubuntu的版本号,需考虑驱动程序和CUDA的支持情况。例如,Ubuntu 204版本有对应的NVIDIA数据中心驱动程序。

如何在服务器使用显卡

〖壹〗、方案一(ubuntu-drivers模式):使用sudo ubuntu-drivers devices命令显示系统中检测到的显卡及其推荐的驱动状态。使用sudo ubuntu-drivers install --gpgpu命令自动检测并安装最适合硬件的驱动程序。

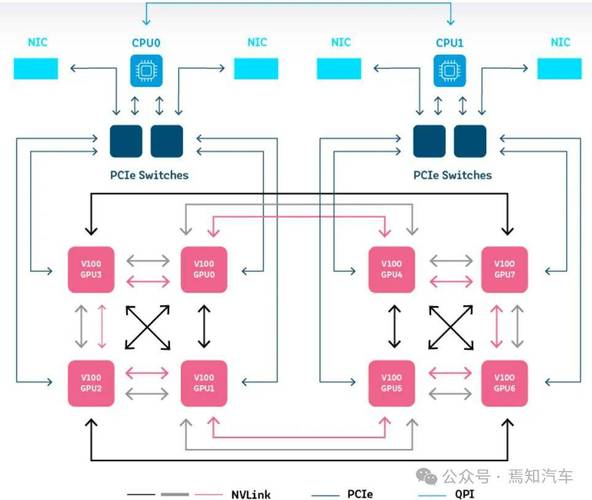

〖贰〗、准备工作确认硬件兼容性检查服务器主板是否具备PCIe插槽(通常为x16规格),这是外接显卡的核心接口。若服务器无内置PCIe插槽,需通过PCIe扩展卡或外置显卡坞(如Thunderbolt 3/4接口设备)实现连接,但后者可能受带宽限制影响性能。

〖叁〗、准备工作确认服务器兼容性需检查服务器是否具备PCIe插槽(常见为x8或x16规格),这是外接显卡的硬件基础。部分服务器可能需通过扩展卡或转接板支持额外PCIe通道。选取适配显卡根据服务器用途(如计算、渲染或AI训练)选取显卡型号,需确保显卡尺寸(如全高/半高)与机箱空间匹配,且电源功率足够。

〖肆〗、我个人偏好第三种方法,因为它对显卡无损。测试了Intel S5000VSA主板,使用PCI-E 8X转16X转接线连接影驰GT240显卡,成功点亮显示器并正常运行,但未安装Windows系统,未能进一步测试显卡性能。尽管如此,这种方法在大多数情况下都是可行的,可以满足临时或偶尔使用服务器作为图形处理设备的需求。

〖伍〗、方法是:在设备管理器中找到并禁用“Intel(R) HD Graphics”设备。然后重新启动服务器即可。需要注意的是,使用外置显卡会增加服务器的功耗和散热量,可能需要额外的风扇或冷却装置,否则可能会影响服务器的稳定性和寿命。同时,还需要根据具体应用场景和性能需求选取合适的显卡型号和驱动程序版本。

〖陆〗、卸下服务器外壳:打开2U服务器外壳的固定螺丝,将外壳从服务器上移除。安装riser卡(如果需要):在服务器主板上找到合适的位置,安装riser卡。插入GPU:将2080ti显卡轻轻地插入riser卡或主板上的PCIe插槽中,确保对准并稳固。

如何在Linux系统中安装GPU驱动

〖壹〗、确认GPU型号 使用命令lspci | grep i nvidia来识别你的GPU型号,这是选取对应驱动程序的基础。选取并安装CUDA和驱动程序 确定版本:对于PyTorch等深度学习框架,推荐使用CUDA 18配合NVIDIA驱动450.80.02或更新版本。

〖贰〗、在Linux系统中安装GPU驱动,可以按照以下步骤进行:版本对齐:选取合适的版本:确保选取的CUDA版本与GPU驱动程序版本相匹配,通常推荐使用CUDA的最新稳定版本,以保证最佳性能和兼容性。访问NVIDIA官方网站:访问NVIDIA的CUDA Toolkit Archive页面,根据GPU型号和操作系统选取相应的版本。

〖叁〗、欲在Linux环境下查看GPU显卡及安装驱动,关键命令与步骤如下。首先,使用`nvidia-smi`命令,它能直观显示GPU状态,如:GPU名称、计算速度、温度等,帮助诊断硬件问题。安装过程分三步。第一步,访问NVIDIA官方网站,根据系统类型下载合适的驱动。第二步,执行安装程序。

〖肆〗、在Linux/Ubuntu系统中安装NVIDIA驱动的步骤及问题解决策略如下:准备阶段:确认硬件信息:确保你知道自己的NVIDIA GPU型号,例如GTX 1060。下载对应驱动:根据GPU型号,从NVIDIA官方网站下载适用于你的Linux/Ubuntu系统的驱动程序。禁用开源驱动Nouveau:在命令模式下输入相关指令,保存并重启电脑。

在linux算力服务器安装stable-diffusion-webui最详细排坑教程

〖壹〗、系统准备与显卡驱动安装 确保服务器环境就绪:选取在合适的云厂商的GPU服务器上进行安装,如搭载NVIDIA Tesla T4显卡的服务器。检查显卡驱动:通过系统命令检查显卡是否被正确识别。

〖贰〗、在安装Linux算力服务器上的stable-diffusion-webui之前,首先需要确保服务器环境已准备就绪,具体配置要求如下。我选取在云厂商的GPU服务器上进行安装,服务器搭载NVIDIA Tesla T4显卡。

〖叁〗、下载代码stable-diffusion-webui。使用 bash webui.sh 启动,注意 root 用户启动时需要添加参数 -f。解决常见报错信息:错误提示:“This script must not be launched as root, aborting...”。通过添加参数 -f,或修改 webui.sh 脚本中的判断逻辑解决。

〖肆〗、在安装阶段,作者首先从本地下载stable diffusion webui源码,并通过FileZilla等工具上传至服务器。接着,创建并上传了用于调用的python库至repositories文件夹。随后,利用conda创建并激活虚拟环境,通过指定阿里源地址安装了pytorch 2版本,紧接着根据requirements.txt文件中的依赖包顺序安装。

〖伍〗、安装阶段: 下载源码:首先,从本地下载stable diffusion webui的源码,利用FileZilla等工具将其上传至Rocky Linux release 3的服务器上。 上传python库:创建并上传用于调用的python库至repositories文件夹,以便后续安装使用。

〖陆〗、我按照GitHub上的开源模型stable-diffusion-webui的教程进行了部署。首先,我安装了python6和pytorch最新版本13。然后,通过git clone或下载压缩包解压stable-diffusion-webui,并安装其他必须包。在安装过程中,我使用了github加速器来加速下载速度。

【深度学习】谷歌云GPU服务器创建与使用指南(一)

〖壹〗、点击“创建”后,可能会遇到GPU数量为0的情况。这是因为免费用户没有GPU配额。你需要在配额界面升级用户,然后在上方“指标”中搜索“k80”或“P100”,并申请增加限额。很快就会收到Google的邮件,提示你已经提升GPU限额。后续步骤 完成实例创建后,你就可以开始使用Google Cloud的GPU服务器了。

〖贰〗、GPU选取 GPU是深度学习服务器中的核心组件,负责执行大量的并行计算任务。在选取GPU时,需考虑显存大小、性能、散热方式及费用等因素。主流选取:GTX1080ti和RTX2080ti,这两款显卡显存大(11G),性价比高,适合大多数深度学习任务。

〖叁〗、GPU选取 GPU(图像处理单元)是深度学习服务器中的核心组件,负责执行模型训练中的大量计算任务。主流选取:GTX1080ti和RTX2080ti,这两款显卡显存大(11G),性价比高,适合大多数深度学习任务。高端选取:对于大型数据集或需要更高精度的任务,可以选取Tesla v100(16G/32G)或RTX8000(48G显存)。

〖肆〗、GPU服务器的使用主要包括以下步骤: 明确应用需求:首先确定你要使用GPU服务器进行哪种类型的计算,如深度学习、科学计算或图形渲染等,因为不同的应用对GPU的型号和性能要求不同。 选取云服务提供商:根据你的需求和预算,选取一个合适的云服务提供商,比较其费用、性能、服务质量和支持情况。

〖伍〗、GPU服务器是基于GPU(图形处理器)的应用,在视频编解码、深度学习、科学计算等多场景中提供稳定、快速且弹性的计算服务。GPU服务器的作用:GPU能够加速计算,提供卓越的应用软件性能。

不再被GPU各种驱动绑架!一站式解决GPU问题

不再被GPU各种驱动绑架!一站式解决GPU问题 对于需要进行AI项目的同学而言,寻找和支持各种版本的GPU驱动无疑是一项艰巨的任务。找到驱动后又常常面临各种不兼容的问题,这极大地影响了项目的进度和效率。然而,随着云计算技术的飞速发展,云GPU服务器已经为解决这类问题提供了有效的方案。

在英雄联盟客户端的设置中,将图像偏好设置为DX9传统模式,这有助于解决某些与显卡驱动兼容性的问题。卸载腾讯WeGame:有玩家反映,卸载腾讯WeGame后,英雄联盟的运行变得更加流畅,不再出现GPU驱动重启的问题。如果安装了WeGame并遇到此问题,可以尝试卸载后观察是否有所改善。

兼容性上,可能会出现与新软件或游戏不兼容的现象,引发程序崩溃、报错等问题。 安全性也会受影响,新的安全漏洞可能无法通过老旧驱动得到有效防护。 为了解决这个问题,你可以前往GPU厂商的官方网站,如英伟达或AMD的官方网站,找到对应型号GPU的最新驱动程序进行下载安装。

优化网络环境和检查游戏文件:有时,网络环境的不稳定也可能导致游戏误报显卡驱动问题。此时,用户可以尝试优化网络环境,如重启路由器或关闭一些占网速的程序。同时,检查游戏文件的完整性也是解决此类问题的一个有效方法。用户可以通过Steam等游戏平台提供的验证功能来检查并修复游戏文件。

游戏里勾上等待垂直同步。帧数设置1完事。还卡。就设置成80.问题根源是lol不支持切换独显和核显。

驱动问题 原因:独立显卡的驱动程序未正确安装或版本过旧,导致系统无法识别独立显卡,从而默认使用集成显卡(通常被识别为GPU 0)。解决方法:前往显卡制造商的官方网站下载并安装最新版本的驱动程序。安装过程中,确保按照提示操作,并重启计算机以完成驱动的安装和配置。

OK,本文到此结束,希望对大家有所帮助。