极智算总结:

- 阿里云GPU服务器配置费用:一年、1个月和1小时GPU收费标准

- gpu服务器是什么配置

- (转载)一文看懂英伟达A100、H100、A800、H800、H20

- GPU服务器是什么?选深度学习GPU服务器看这里

- 如何选取GPU服务器配置?

- 火山引擎GPU服务器介绍:费用费用、优势功能及使用说明

- GPU服务器需要什么配置

- GPU服务器与通用服务器的区别

阿里云GPU服务器配置费用:一年、1个月和1小时GPU收费标准

〖壹〗、V100-16G卡GN6v实例:配备NVIDIA V100 16G GPU卡,8核32G内存的配置,年费用大约在45960元左右(3830元/月 * 12月)。T4卡GN6i实例:配备NVIDIA T4 GPU卡,4核15G内存的配置,年费用大约在20328元左右(1694元/月 * 12月)。

〖贰〗、A10卡VGN7i-vws:NVIDIA A10 GPU卡,30核186G CPU内存,优惠费用74600元/1个月。T4卡VGN6i-vws:NVIDIA T4 GPU卡,10核46G CPU内存,优惠费用28556元/1个月。V100-32G卡GN6e:NVIDIA V100 GPU卡,12核92G CPU内存,优惠费用94900元/1个月。

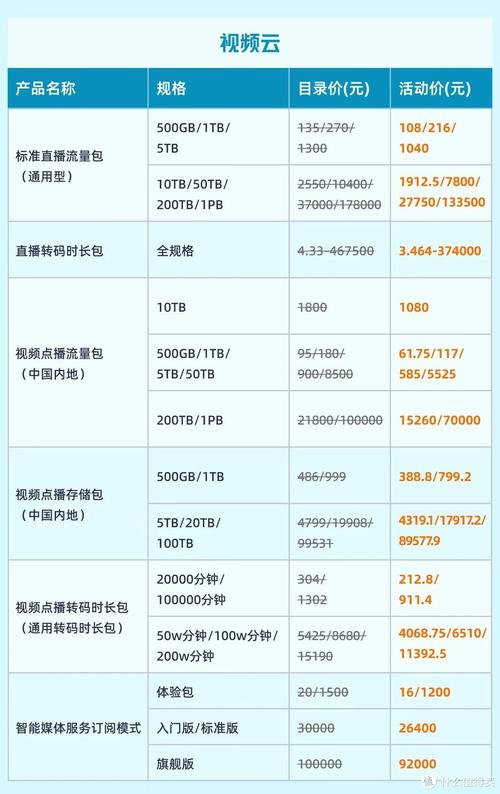

〖叁〗、优惠费用:16900元/1个月、101600元6个月、161480元一年。图片展示 以下是阿里云GPU服务器优惠活动和包年包月费用的图片展示:总结 阿里云提供了与4060对标配置的GPU服务器,包括gn6i实例和gn7i实例,费用根据配置和计费模式有所不同。

〖肆〗、其中,部分C2C平台(如橘皮优)因共享闲置算力,费用可低至1元/小时;按月计费的主流费用区间为1万元至2万元/月,但也有平台如极智算提供的4090八卡服务器月租费用为6600元至7980元,相比其他平台更具性价比。按供应商和配置划分:阿里云提供的GPU服务器租用费用根据配置不同有所区别。

〖伍〗、阿里云GPU服务器提供多种实例规格,以满足不同用户的需求。以下是一些常见的实例规格及其费用(以一个月为例):A10卡GN7i:配备32核CPU和188G内存,比较高可搭载4张NVIDIA A10-24G卡,费用为32199元/月。

〖陆〗、“gpu租用服务费元/月/例”这一说法指的是GPU租用服务的费用计算方式,但表述并不标准,其中“例”字使得表述变得模糊。以下是详细解读: GPU租用服务费 定义:指的是使用GPU进行计算任务所需支付的费用。

gpu服务器是什么配置

GPU服务器:通常配备高性能的GPU显卡,以及与之匹配的CPU、内存和存储设备,以满足高性能计算需求。普通服务器:硬件配置相对简单,主要关注CPU、内存和存储等基本配置,以满足一般应用需求。费用与维护成本 GPU服务器:由于配备了高性能的GPU显卡和其他高端硬件,费用相对较高。

GPU服务器的典型配置如下:CPU:类型:Intel Xeon 或 AMD EPYC系列。核心数:至少16核,以提供强大的多任务处理能力。主频:至少0GHz,确保高效的处理速度。缓存:至少64MB,以加快数据访问速度。GPU:类型:NVIDIA Tesla、Quadro或GeForce系列,专为并行计算而设计。

GPU服务器:不仅需要充足的系统内存来支持操作系统和其他应用程序,还需要为每个GPU分配专用的显存(VRAM)。显存用于存储GPU处理过程中的临时数据,对于处理大规模数据集和复杂图形任务至关重要。因此,GPU服务器的内存配置通常更高,以满足GPU的显存需求。

GPU服务器需要以下关键配置:高性能的GPU:核心部件:高性能GPU是GPU服务器的核心,直接影响服务器的处理能力。选取要点:通常选取专业级GPU,如NVIDIA的Tesla或Quadro系列、AMD的Radeon Instinct系列。需关注内存容量、浮点计算能力(TFLOPS)、内存带宽及最大显示分辨率。

(转载)一文看懂英伟达A100、H100、A800、H800、H20

H100在Transformer-based AI任务(如GPT)中比A100快6倍,而推理吞吐量也更高。小结 AI训练:需要高带宽 + 高精度计算,推荐H100/A100及其变种。AI推理:需要低延迟 + 高吞吐量,推荐H100/H800/H20。H100在Transformer模型训练和推理吞吐量方面遥遥领先。A100/A800仍然是中等预算下的优秀选取。

对于AI训练任务,建议选取H100或A100系列GPU,它们提供强大的计算能力和高带宽内存,适合处理大规模数据集和复杂模型。推理场景 对于AI推理任务,A800或H800系列GPU是更好的选取。它们提供稳定的计算能力和适中的内存容量与带宽,满足大多数推理任务的需求。

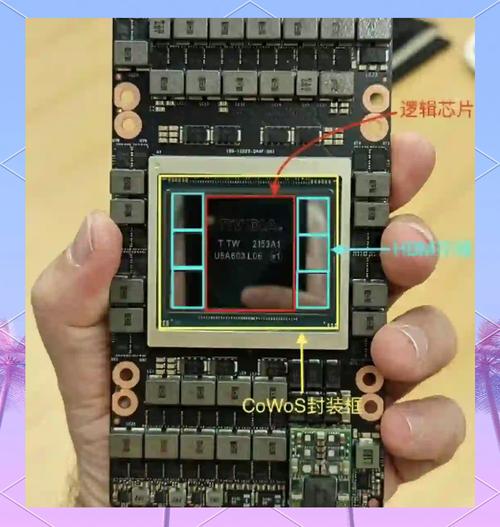

A100:拥有40GB显存,提供PCIE版和SXM版两种形式。A100是英伟达上一代的高性能GPU,广泛应用于AI计算、高性能计算等领域。A800:作为A100的替代产品,A800同样拥有80GB显存(与后续提到的H100、H800的某版本相同),也提供PCIE版和SXM版。

A100和A800:均属于Tesla系列中的高性能计算(HPC)和人工智能(AI)加速型号。A100是NVIDIA推出的旗舰级AI加速GPU,而A800则是针对中国市场推出的特供版(低配版)。H100和H800:同样属于Tesla系列,但更侧重于大模型训练和推理。

GPU服务器是什么?选深度学习GPU服务器看这里

NV-Link总线技术标准GPU服务器:NV-Link接口GPU的典型代表是NVIDIA V100,采用SXM2接口。具有NV-Link总线标准的GPU服务器可以分为两类:一类是英伟达设计的DGX超级计算机,另一类是英伟达合作伙伴设计的具有NV-Link接口的服务器。

GPU服务器是基于GPU应用在视频编解码、深度学习、科学计算等多场景下的稳定、快速且弹性的计算服务。GPU服务器的作用加速计算:GPU能够显著加快计算速度,通过将应用软件中的部分计算负荷迁移到GPU上,而CPU则继续运行其他代码。这种分工使得应用软件的运行速度得到明显提升。

CPU,即中央处理器,是计算机系统的运算和控制核心,负责复杂任务处理。GPU,图形处理器,专用于图像和图形计算,广泛用于个人电脑、游戏机和移动设备。GPU与CPU性能对比 GPU架构以大量小而快的逻辑单元,以并行方式处理任务,特别适合重复计算。CPU则擅长处理复杂逻辑和控制任务。

如何选取GPU服务器配置?

〖壹〗、CPU性能:选取强大的多核CPU(如Intel Xeon系列或AMD EPYC系列),以支持GPU的性能发挥。内存配置:根据任务需求选取内存容量,深度学习和大数据分析任务通常需要较大容量内存(如32GB或64GB)。存储性能:高速SSD存储能加快数据加载和读取速度,提高整体效率。

〖贰〗、GPU服务器需要以下关键配置:高性能的GPU:核心部件:高性能GPU是GPU服务器的核心,直接影响服务器的处理能力。选取要点:通常选取专业级GPU,如NVIDIA的Tesla或Quadro系列、AMD的Radeon Instinct系列。需关注内存容量、浮点计算能力(TFLOPS)、内存带宽及最大显示分辨率。

〖叁〗、阿里云GPU服务器:全球覆盖,企业级稳定;提供T4/V100/A100等多种GPU型号选取;费用相对较高,但性能稳定可靠。腾讯云GPU服务器:国内低延迟,BGP优化;提供T4/A10/A100等GPU型号选取;适合游戏、直播等国内业务场景。

〖肆〗、首先明确业务需求,确定是否需要GPU服务器的高性能计算能力。如果业务涉及深度学习、科学计算等需要大量并行计算的场景,则应选取GPU服务器。GPU接口类型:根据服务器的硬件配置和业务需求,选取合适的GPU接口类型,如PCIe、NVLink等。

〖伍〗、如何正确挑选GPU服务器:考虑业务要求:首先根据业务需求来选取合适的GPU型号规格。在高性能计算(HPC)中,还需要根据精度来选取,例如有的高性能计算需要双精度,这时如果应用RTX4090或是RTX A6000就不适合,只能使用H100或是A100。

〖陆〗、对于轻量推理场景,可选取“RTX 4070服务器+云算力弹性扩容”组合。线下部署满足日常需求,峰值流量时租用阿里云等云服务商的GPU资源,成本比全线下方案降低45%。中型企业(预算50-500万)推荐采用“升腾910B+A100异构集群”方案。

火山引擎GPU服务器介绍:费用费用、优势功能及使用说明

〖壹〗、火山引擎GPU服务器的计费类型多样,以满足不同用户的需求。主要包括按量计费、包年包月、抢占式实例和弹性约束实例四种模式。按量计费适合短时间使用,按小时收费;包年包月则适合长期使用,平均到每小时的费用更优惠。

〖贰〗、性能优越:GPU 云服务器具有高并行、高吞吐、低时延等特点,在科学计算中的性能表现显著优于传统架构,同时在图像处理等场景也有明显优势。

〖叁〗、火山引擎采用TensorRT推理框架后,线上服务速度提升了4至5倍,这大大提升了服务的实时性和可用性。节省计算资源:由于TensorRT能够高效利用GPU资源,因此火山引擎在提供高频海量计算请求的同时,能够节省大量的计算资源。这对于企业来说,意味着可以降低运营成本,提高资源利用率。

〖肆〗、我用过呀,火山引擎云服务器是一种安全稳定、可弹性伸缩的云计算服务。云服务器可以根据业务需要实时启用和增减计算资源,有效降低IT维护成本,助力核心业务增长。核心优势就是稳定安全、多样配置、即开即用。从功能上来说,第一,可以提供安全可靠的弹性计算服务。

〖伍〗、更全产品能力:火山引擎AI一体机集成了火山方舟的同源能力,支持模型精调、推理、测评全方位功能和服务。不仅能单机8卡部署满血DeepSeek等开源模型,还预置了联网搜索等100+插件和海量行业应用模板,提供零代码、低代码的分钟级AI应用构建。同时,全面兼容英伟达GPU及国产异构计算卡,满足多样化算力需求。

GPU服务器需要什么配置

内存配置:根据任务需求选取内存容量,深度学习和大数据分析任务通常需要较大容量内存(如32GB或64GB)。存储性能:高速SSD存储能加快数据加载和读取速度,提高整体效率。网络带宽:对于大规模数据传输,选取支持10GbE或更高网络速度的服务器。考虑预算与性价比 高性能GPU通常成本较高,需在性能和预算间平衡。

GPU服务器需要以下关键配置:高性能的GPU:核心部件:高性能GPU是GPU服务器的核心,直接影响服务器的处理能力。选取要点:通常选取专业级GPU,如NVIDIA的Tesla或Quadro系列、AMD的Radeon Instinct系列。需关注内存容量、浮点计算能力(TFLOPS)、内存带宽及最大显示分辨率。

GPU服务器:通常配备高性能的GPU显卡,以及与之匹配的CPU、内存和存储设备,以满足高性能计算需求。普通服务器:硬件配置相对简单,主要关注CPU、内存和存储等基本配置,以满足一般应用需求。费用与维护成本 GPU服务器:由于配备了高性能的GPU显卡和其他高端硬件,费用相对较高。

GPU服务器与通用服务器的区别

〖壹〗、通用服务器:哪里都可以用,比如做私有云、分布式存储、管理节点、HPC通用算力节点等等。两者在业务场景定位上有所不同,GPU服务器更专注于高性能计算和图形处理等领域,而通用服务器则更为通用,适用于多种场景。综上所述,GPU服务器与通用服务器在GPU卡支持数量、类型、机器形态、拓扑结构、功耗、费用以及业务场景定位等方面均存在显著差异。

〖贰〗、GPU服务器与普通服务器的硬件区别 GPU服务器和普通服务器之间的主要区别在于它们所针对的工作负载类型以及为此优化的硬件配置。以下是两者之间的一些关键差异:处理器(CPU)普通服务器:通常配备多核高性能中央处理器(CPU),这些CPU适用于处理大量并发请求或执行复杂的计算任务,如数据库查询、Web服务等。

〖叁〗、GPU服务器和普通服务器的主要区别如下:核心功能与应用场景 GPU服务器:基于GPU构建,主要应用于视频编解码、深度学习、科学计算等多种需要高性能计算的场景。GPU服务器提供快速、稳定、弹性的计算服务,并具备和标准云服务器一致的管理方式。

〖肆〗、GPU服务器:由于配备了高性能的GPU和相关的硬件资源,GPU服务器的费用通常较高。普通服务器:费用相对较为亲民,适合预算有限的用户或企业。稳定性与可靠性:GPU服务器:通常设计为能够长时间稳定运行,以满足高性能计算任务的需求。它们通常具有更高的可靠性和稳定性要求。

〖伍〗、显卡服务器(GPU服务器)与普通服务器的区别主要体现在以下几个方面:处理器类型 普通服务器:通常配备中央处理器(CPU)作为主要处理器,用于执行大部分通用计算任务和操作系统管理。CPU设计用于处理广泛的计算任务,包括逻辑运算、数据移动和输入输出操作等。

〖陆〗、显卡服务器与普通服务器的区别主要包括以下几点:硬件配置与性能:普通服务器:主要依靠中央处理器进行单线程或小规模并行计算,性能适用于常规任务。GPU服务器:额外搭载了强大的图形处理器,拥有数千个并行计算核心,能同时处理大规模数据和图形密集任务,计算性能远超普通服务器。

OK,关于gpu服务器规格和gpu服务器是什么意思的内容到此结束了,希望对大家有所帮助。