极智算总结:

- 近来gpu都有哪些架构

- GPU服务器到底有什么作用?

- CPU+GPU架构的区别、优势及应用

- 英伟达产品系列分类、架构、数据中心GPU所有型号及参数汇总(附国内外...

- gpu和npu有什么区别,分别龙头公司有哪些

- 百度凤巢之分布式层次GPU参数服务器架构

- 英伟达GPU卡A100、H100、A10和T4等架构、显存及使用场景区别

- gpgpu和cpu的架构

近来gpu都有哪些架构

近来主流的GPU架构有NVIDIA的CUDA架构、AMD的GCN架构、Intel的Xe架构和ARM的Mali架构。NVIDIA的CUDA架构:是面向GPU的并行计算架构,不仅支持高性能的图形渲染,还可用于大规模的并行计算任务。

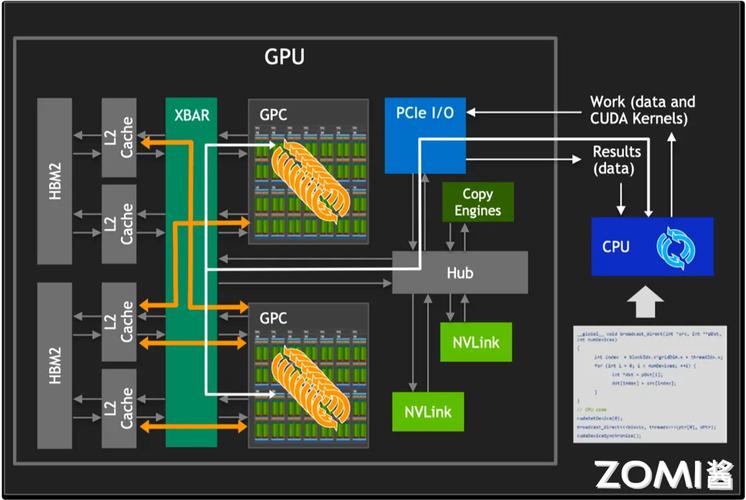

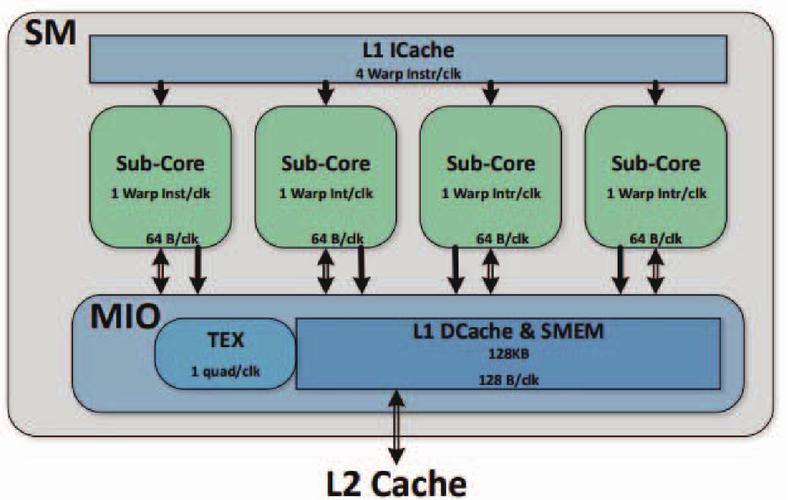

GPU(图形处理器)的硬件架构是理解和优化CUDA执行模型的基础。以NVIDIA的Pascal GP100架构为例,我们可以深入了解GPU设备的整体架构和SM(Streaming Multiprocessors,流多处理器)的内部结构。

GPU的主要架构包括以下几种:流处理器架构:是GPU的基础架构之一,通过大量的处理器核来完成图形处理任务。能够同时进行多个数据处理操作,以提高性能。每个流处理器包含一个或多个浮点运算单元和管线设计,用以完成纹理过滤和几何图形渲染等操作。流处理器数量越多的GPU在图形渲染能力上通常越强。

GPU的基本结构包含以下核心组件: 计算单元GPU的核心计算模块,NVIDIA称为SM(Streaming Multiprocessor),AMD称为CU(Compute Unit)。每个计算单元包含多个处理核心(如NVIDIA的CUDA核心、AMD的Stream Processor),负责执行浮点运算、整数运算等。

简介:Fermi架构是NVIDIA GPU架构自初代G80以来最重大的飞跃,基于提高双精度性能、ECC支持、True Cache Hierarchy等关键领域进行改进。四大亮点:第三代流式多处理器(SM),每个SM有32个CUDA内核,8倍于GT200的峰值双精度浮点性能。第二代并行线程执行ISA,具有完整C++支持的统一地址空间。

GPU的硬件架构通常包括多个层次,从底层的流处理器到顶层的流处理器阵列,每个层次都有其特定的功能和作用。底层计算单元:流处理器(SP):作为最基本的计算单元,负责执行具体的计算任务。双精度浮点运算单元(DP)和特殊功能单元(SFU):提供额外的计算功能,以满足不同场景的需求。

GPU服务器到底有什么作用?

〖壹〗、GPU服务器的作用主要是提供基于GPU的快速、稳定、弹性的计算服务,应用于视频编解码、深度学习、科学计算等多种场景。以下是对GPU服务器作用的详细阐述:GPU加速计算提升性能GPU加速计算通过转移应用程序计算密集部分的工作负载到GPU,实现应用程序性能的显著提升。

〖贰〗、GPU服务器是基于GPU的计算服务,适用于视频编解码、深度学习、科学计算等场景,提供高性能图形处理与计算能力;普通服务器则以CPU为核心,适用于常规办公、Web服务等低负载场景。两者在核心组件、应用场景、性能特点上存在显著差异。

〖叁〗、GPU服务器是基于GPU的、应用于多种场景的快速稳定弹性计算服务,具有出色的图形处理和高性能计算能力,能提升计算处理效率,满足各类互联网应用需求。具体作用如下:深度学习领域简单深度学习模型:GPU服务器可为机器学习提供训练或者预测服务。

〖肆〗、GPU服务器是基于GPU的应用于多种场景的快速、稳定、弹性的计算服务。其出色的图形处理能力和高性能计算能力提供极致计算性能,有效解放计算压力,提升产品的计算处理效率与竞争力。GPU服务器的主要用处包括但不限于以下几个方面:视频编解码:GPU服务器可以加速视频编解码过程,提高视频处理效率。

〖伍〗、GPU服务器:通常设计为能够长时间稳定运行,以满足高性能计算任务的需求。它们通常具有更高的可靠性和稳定性要求。普通服务器:虽然也具有一定的稳定性和可靠性,但相对于GPU服务器来说,其设计可能更注重成本效益和易用性。

CPU+GPU架构的区别、优势及应用

GPU(图形处理器):GPU采用数量众多的计算单元和超长的流水线,擅长进行图像处理、并行计算。对于复杂的单个计算任务来说,CPU的执行效率更高,通用性更强;而对于图形图像这种矩阵式多像素点的简单计算,更适合用GPU来处理。

不同架构有各自的优势和适用场景。CPU适用于复杂控制和顺序计算的任务;GPU适用于并行计算、图像处理和科学计算等任务;FPGA适用于实时信号处理、加速器设计和专用计算等任务;ASIC适用于需要定制设计和大规模生产的任务;DSA则适用于大规模高性能计算和深度学习等任务。

CPU和GPU在架构、性能特点和应用场景方面存在显著差异。CPU擅长处理需要快速响应的串行任务,而GPU则通过并行处理大量线程实现高吞吐量,适合处理大规模数据计算。在实际应用中,CPU和GPU通常协同工作,共同推动计算机系统的性能提升。

英伟达产品系列分类、架构、数据中心GPU所有型号及参数汇总(附国内外...

〖壹〗、Tesla架构:早期架构,奠定了英伟达GPU在高性能计算和AI领域的基础。Turing架构:引入实时光线追踪技术,提升了游戏和图形渲染的真实感。Ada Lovelace和Hopper架构:专注于光线追踪和AI推理的优化,提升了AI计算性能和效率。

〖贰〗、英伟达的产品系列包括GeForce、Quadro、Tesla、Tegra、Jetson和DGX,针对不同的应用领域提供了专业和高性能的GPU。以下是它们的特点和主要使用场景: GeForce系列(G系列):面向消费级市场,注重游戏性能,支持实时光线追踪和DLSS技术。

〖叁〗、RTX 40系列:采用Ada Lovelace架构,主打光线追踪与DLSS 3技术,包括RTX 4090、RTX 4080等。入门/中端型号:有GTX 1650 Super、RTX 3050(性价比之选)、RTX 3060 Ti、RTX 3070 Ti(具备主流游戏性能)。

gpu和npu有什么区别,分别龙头公司有哪些

GPU与NPU的核心区别在于设计目标、架构特点和应用场景,龙头公司分别聚焦不同技术赛道。GPU与NPU的核心区别设计目标 GPU:最初为图形渲染设计,后因并行计算能力突出,扩展至通用计算领域(如科学计算、深度学习训练),强调高算力与生态兼容性。

GPU领域的龙头公司有英伟达。英伟达在全球GPU市场占据主导地位,其产品广泛应用于游戏、专业图形、数据中心等多个领域。NPU方面,华为曾在这一领域有突出表现。华为的升腾系列NPU为其人工智能应用提供了强大的算力支持,在智能安防、智能驾驶等场景发挥了重要作用。

其次,二者的设计理念不同。GPU是基于通用并行计算架构,通过大量的核心并行工作来提升计算效率。NPU则是为特定的神经网络任务定制,采用专门的架构和算法加速。再者,在能耗方面,NPU相对更节能,因为它针对特定任务优化,减少了不必要的计算开销。GPU领域的龙头公司有英伟达等。

综上所述,NPU与GPU在设计目的、硬件架构、性能表现、应用场景以及集成与数据存储需求等方面都存在显著的差别。这些差别使得NPU和GPU在各自擅长的领域中都能发挥出最佳的性能。

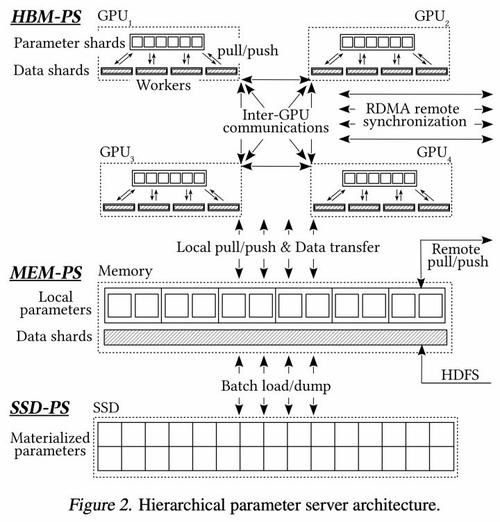

百度凤巢之分布式层次GPU参数服务器架构

百度凤巢之分布式层次GPU参数服务器架构 百度凤巢的分布式层次GPU参数服务器架构是一种专为大规模深度学习广告系统设计的架构。该架构通过分层存储和高效的数据传输机制,显著提升了广告系统的训练速度和性能。架构背景 在大规模深度学习广告系统中,CTR(点击率)预估是关键环节。

英伟达GPU卡A100、H100、A10和T4等架构、显存及使用场景区别

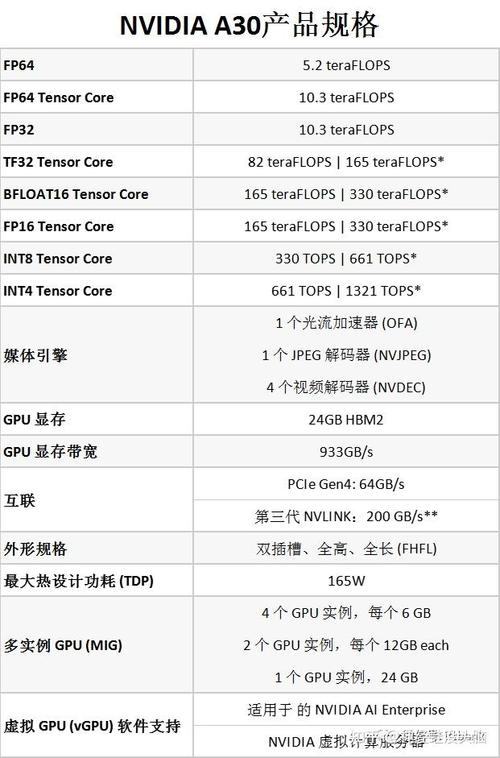

〖壹〗、英伟达GPU卡A100、H100、A10和T4在架构、显存和使用场景上各有特色。H100作为最新一代的GPU卡,适合进行大规模AI训练和HPC任务;A100则广泛应用于深度学习训练、科学计算和数据分析等领域;A10以其高性价比和多功能性,适合中等规模的AI推理和图形渲染任务;而T4则专为AI推理和边缘计算设计,具有低功耗和高效能的特点。

〖贰〗、NVIDIA A100和H100是面向大规模AI训练和高性能计算的顶级GPU卡,其中H100作为最新一代产品,性能更为卓越。NVIDIA T4是面向高性价比推理和边缘计算的GPU卡,专为AI推理优化,低功耗且高效。NVIDIA A10则是面向主流AI推理和中等规模训练的GPU卡,性价比高,支持AI推理和图形渲染。

〖叁〗、H100:单价高,适用于超大规模企业/云厂商,算力密度高。A100:单价适中,适用于中型企业/实验室,显存容量大,支持多任务。A30:单价较低,适用于高密度推理服务,能效比高。RTX 4090:单价亲民,适用于开发者/初创公司,单卡性价比高。

gpgpu和cpu的架构

〖壹〗、GPGPU与CPU的架构差异主要体现在核心设计、指令架构、并行能力及编程支持上,二者分别针对不同计算场景优化。核心数量与结构差异CPU采用少而精的核心设计,现代服务器级CPU(如Intel Xeon或AMD EPYC)通常集成4~64个高性能核心,每个核心配备复杂的控制逻辑和指令执行单元,深度优化单线程性能。

〖贰〗、现代GPU通常采用众核架构,即包含大量的计算核心(如英伟达的流多处理器核心SM或AMD的计算单元)。这些核心能够同时执行多个线程,并通过scratchpad内存进行通信和同步。这种多线程并行方式使得GPGPU能够处理大规模并行计算任务,实现高性能计算。

〖叁〗、整体微架构 GPGPU的流式多处理器架构按照流水线可以分为SIMT前端和SIMD后端。整个流水线处理划分为六个阶段:取指、译码、发射、操作数传送、执行与写回。流式多处理器中的主要模块包括:取指单元(I-Fetch):负责将指令请求发送到指令缓存,并将程序计数器(PC)指向下一条指令。

关于gpu服务器架构,gpu服务器搭建的介绍到此结束,希望对大家有所帮助。