极智算总结:

- gpu虚拟化的几种实现方式包括

- 英伟达显卡虚拟化vGPU实践指南

- 虚拟化界的强强联手:VirtIO与GPU虚拟化的完美结合

- 宅家教学,NVIDIA虚拟GPU能实现哪些功能

- vmware怎么配置使用主机gpu

- 浅谈GPU虚拟化技术(第一章)

- 详解GPU虚拟化技术

- 一文简介GPU虚拟化

- 浅谈GPU虚拟化三种方法

gpu虚拟化的几种实现方式包括

〖壹〗、GPU虚拟化的几种实现方式包括:基于GPU硬件虚拟化:方式描述:在GPU硬件级别上实现虚拟化,提供多个虚拟GPU。优点:性能损失较小。缺点:实现难度较大,需要硬件厂商的支持。基于GPU passthrough:方式描述:直接从物理GPU获取资源,为每个虚拟机分配一部分GPU资源。优点:不需要额外的虚拟化软件。

〖贰〗、GPU虚拟化的实现方式包括: 基于GPU硬件虚拟化:这种方式通过在GPU硬件级别上实现虚拟化,为多个虚拟机提供独立的虚拟GPU。它要求硬件支持并依赖操作系统和驱动程序。尽管实施难度较大且需要硬件厂商的支持,但优点是性能损失较小。

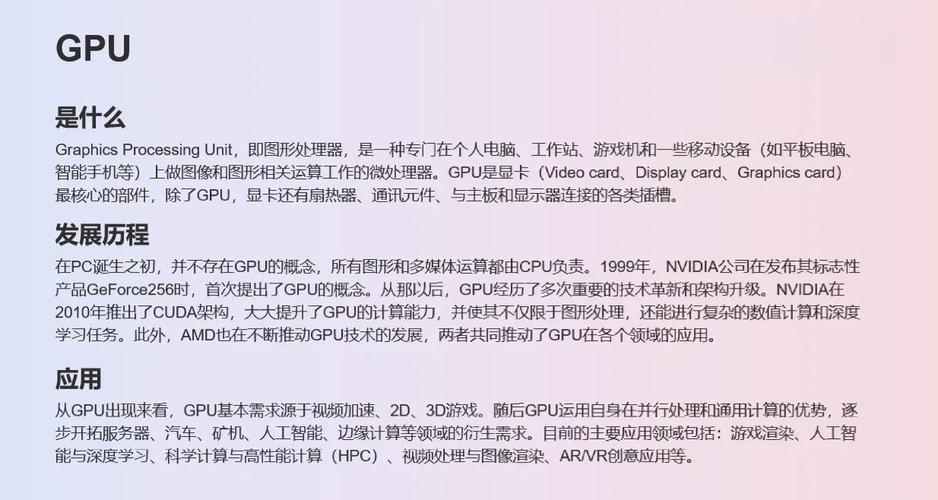

〖叁〗、随着大数据和人工智能的快速发展,GPU已成为复杂计算的关键工具。GPU虚拟化是将物理GPU分解为多个虚拟GPU,为多台计算机提供服务的过程。主要有三种实现方法:硬件、软件以及云服务虚拟化。硬件虚拟化通过在GPU上添加虚拟化支持芯片,建立物理GPU和虚拟GPU之间的通道,完整复制物理GPU功能。

英伟达显卡虚拟化vGPU实践指南

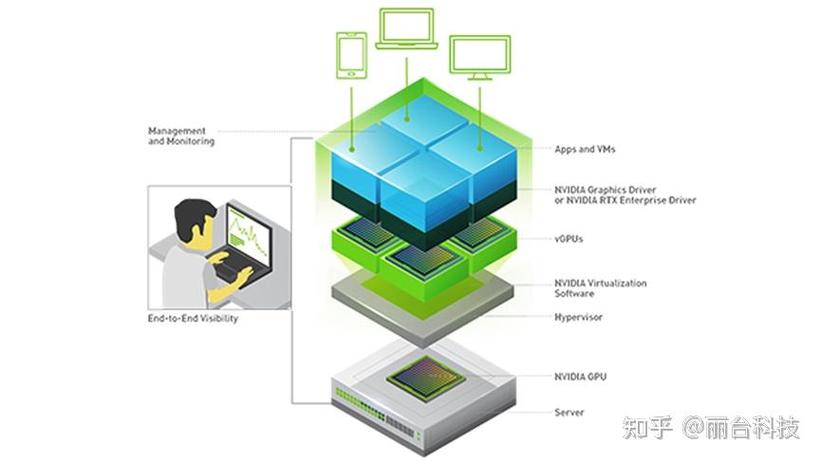

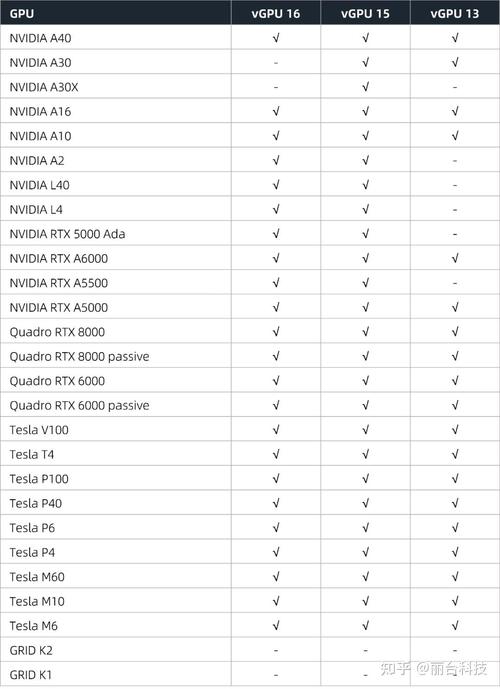

〖壹〗、在探讨英伟达显卡虚拟化vGPU实践的过程中,首先要明确选取GPU的重要性。英伟达的虚拟GPU产品包括GRID虚拟PC(GRID vPC)、GRID虚拟应用程序(GRID vApp)以及Quadro虚拟数据中心工作站(Quadro vDWS)。选取GPU时,可借鉴英伟达的官方网站,以获取详细的产品列表及对比信息。

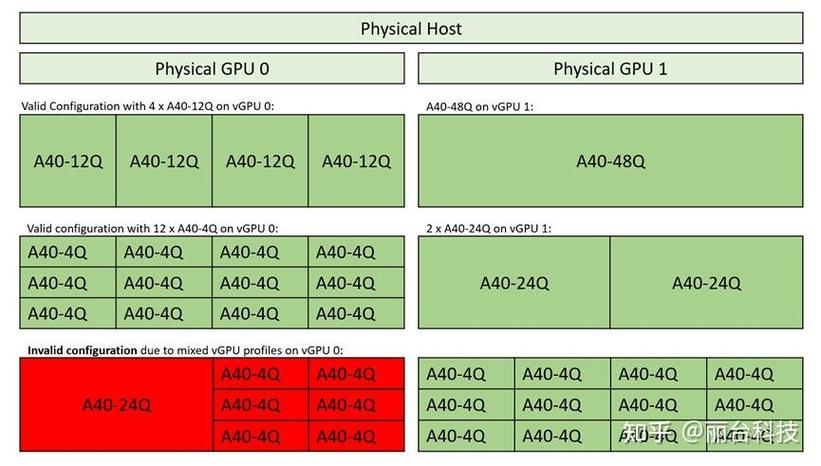

〖贰〗、物理 GPU 的选取NVIDIA vGPU 软件需要在具备 NVIDIA GPU 的平台上运行。vGPU 通过 time-sliced(时间切分)的方式共享 GPU 引擎,包括图形 (3D)、视频编解码引擎等。用户可以根据性能、成本和显存大小等因素选取合适的 GPU。

〖叁〗、NVIDIA RTX vWS 作为 NVIDIA vGPU 软件之一,结合了强大的 NVIDIA GPU,使用户能够从数据中心虚拟化任何应用程序,包括 ANSYS Discovery Live、ESRI ArcGIS Pro、Siemens NX、Dassault Systemes SolidWorks、Autodesk Revit 等。这种虚拟化技术使得用户能够在任何设备上实现媲美物理工作站级别的性能体验。

〖肆〗、超融合平台部署英伟达vGPU授权服务器前提条件:下载授权服务器镜像“3D 授权服务器 - HCI - 0.vma”。导入镜像:登录超融合控制台,点击[虚拟机/新增/导入虚拟机],选取下载的授权服务器镜像文件,选好分组后点击开始导入,等待完成。

〖伍〗、对于需要高性能图形处理的应用程序,如 CAD、3D 建模等,建议选取 B 系列 vGPU。对于远程应用程序环境中的控制台显示器,可以选取 A 系列 vGPU,以满足低分辨率和单个显示器的需求。总结:NVIDIA vPC 和 vApps 是基于 NVIDIA GPU 的虚拟化解决方案,提供高性能和灵活的工作方式。

〖陆〗、在虚拟化/超融合的舞台上,GPU的使用策略分为两种主要模式:GPU直通与vGPU。GPU直通(PCIe Pass-through): 这种方式几乎无性能损耗(小于5%),但不支持多个虚拟机共享,可能需要额外的GPU卡,且不支持在线迁移,适合对性能要求极高的场景。

虚拟化界的强强联手:VirtIO与GPU虚拟化的完美结合

通过 virtIO-gpu 的扩展(本地上下文),可以优化 GPU 虚拟化,实现 VirtIO 感知和特定 GPU 的自定义协议,直接向客户机提供原生上下文,客户机运行经过修改的原生 GPU 驱动程序。

虚拟机和实体机的性能差异取决于具体使用场景和配置,但通常虚拟机会有10%-30%的性能损耗。性能差异的主要来源 硬件虚拟化开销:虚拟机需要通过虚拟化层(如Hypervisor)访问物理硬件,这会增加CPU指令处理的延迟。

宅家教学,NVIDIA虚拟GPU能实现哪些功能

〖壹〗、NVIDIA虚拟GPU能够实现应用程序、桌面和工作站虚拟化,为宅家教学的师生提供了一系列强大的功能,具体包括:GPU加速虚拟实验室 高性能虚拟工作环境:通过将NVIDIA vGPU解决方案加入虚拟桌面环境,教育机构能够为师生提供与实体电脑和工作站同级别性能的虚拟工作环境。

〖贰〗、RX 5700 XT使用AMD的新RDNA架构和Radeon 7上首次亮相的7纳米工艺,为费用适中的包装带来了惊人的功能。该卡比其弟弟RX 5700消耗的功率更多,但由于性能提高,它确实可以更好地扩展到更高的分辨率。

vmware怎么配置使用主机gpu

在VMware中配置使用主机GPU,需要按照以下步骤进行:确保显卡驱动最新并支持虚拟化:首先,要访问显卡厂商官方网站下载并安装适配当前操作系统的最新显卡驱动。同时,确保显卡支持虚拟化技术,并在VMware虚拟机设置中启用“加速3D图形”选项。

在VMware Workstation Pro中利用主机GPU的步骤如下:首先,你需要准备两块显卡,其中一块为宿主机使用的GPU,安装好驱动程序。其次,通过设备管理器确认未安装驱动的GPU所对应的PCIE通道。接着,进入VMware Workstation Pro,对虚拟机添加相应的PCIE资源。最后,在虚拟机内安装GPU驱动程序。

编辑虚拟机设置,添加PCI设备,选取NVIDIA GPU。在GPU配置文件中设置GPU显存大小,并勾选“预留所有内存”。安装虚拟机驱动:在虚拟机中安装与ESXi主机驱动包中对应的虚拟机驱动。安装驱动后,重启虚拟机。虚拟机控制台界面可能会显示“黑屏”,这是正常现象。使用远程桌面RDP协议或Horizon等方式登录虚拟机。

独占模式与GPU直通独占模式:VM虚拟机中的一个特定模式,必须在全屏模式下才能显示出来。该模式的主要目的是让虚拟机能够直接使用物理主机上的硬件设备。GPU直通:一种虚拟化技术,它允许虚拟机直接访问物理主机上的显卡资源。通过GPU直通,虚拟机可以获得与物理机相似的图形处理性能。

将驱动上传至主机 /tmp 目录,开启 SSH 服务。进入维护模式后,使用命令执行安装操作。尽管安装提示无需重启,但建议重启主机以确保驱动正确加载。启动 xorg 服务,它是 ESXi 主机为虚拟机提供 3D 硬件加速的关键。启动服务后,GPU 功能将正常运行。使用命令检查驱动是否正确加载。

浅谈GPU虚拟化技术(第一章)

综上所述,GPU虚拟化技术的发展历程是一个不断演进、竞争与合作并存的过程。随着技术的不断成熟和应用场景的拓展,GPU虚拟化技术将在未来继续发挥重要作用。

以锐捷高性能GPU云桌面解决方案为例,提供GPU资源给每个VDI桌面,实现强大算力,优化桌面使用体验。无需GPU授权,性能卓越、体验高、性价比高,适用于普教新课改、高教机房、各行业办公场景。GPU虚拟化提高了资源利用率,节省了购买重复GPU的费用,是技术应用的典范。

在传统架构中,汇聚层交换机通常采用STP(生成树协议),确保一个VLAN网络只有一个汇聚层交换机在工作,其他作为备份。这种active-passive的HA模式限制了水平扩展能力。技术发展对网络架构的影响 随着技术的发展,数据中心网络架构面临诸多挑战和变革需求。

复杂性导致的安全问题:虚拟化环境的复杂性增加了安全管理的难度,使得安全问题难以被及时发现和解决。虚拟机迁移导致的漏洞:当虚拟机从一个物理服务器迁移到另一个物理服务器时,可能会引入物理主机的漏洞,从而威胁整个虚拟环境的安全。

详解GPU虚拟化技术

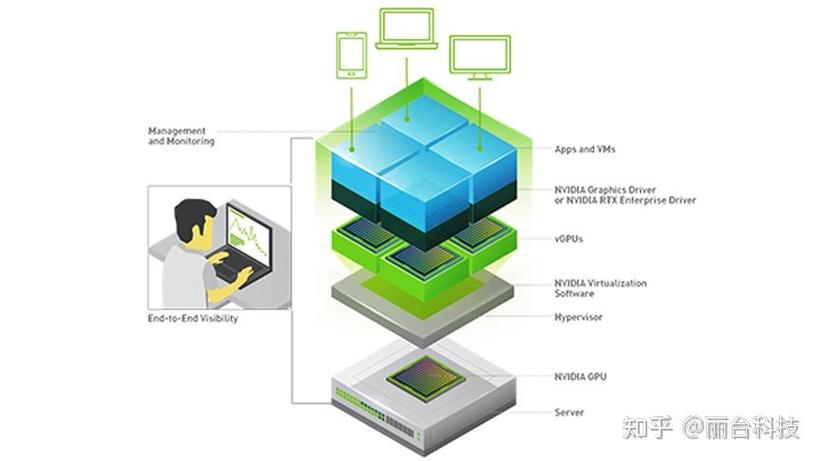

〖壹〗、GPU虚拟化是一项技术创新,旨在通过软件或硬件方式将一台物理计算机上的GPU资源划分为多个虚拟GPU(vGPU)设备,供多个虚拟机或容器使用。这一技术使得在虚拟化环境中,每个用户或虚拟机都能独立运行图形密集型应用程序,同时保持相互之间的隔离,互不干扰。

〖贰〗、综上所述,GPU虚拟化技术的发展历程是一个不断演进、竞争与合作并存的过程。随着技术的不断成熟和应用场景的拓展,GPU虚拟化技术将在未来继续发挥重要作用。

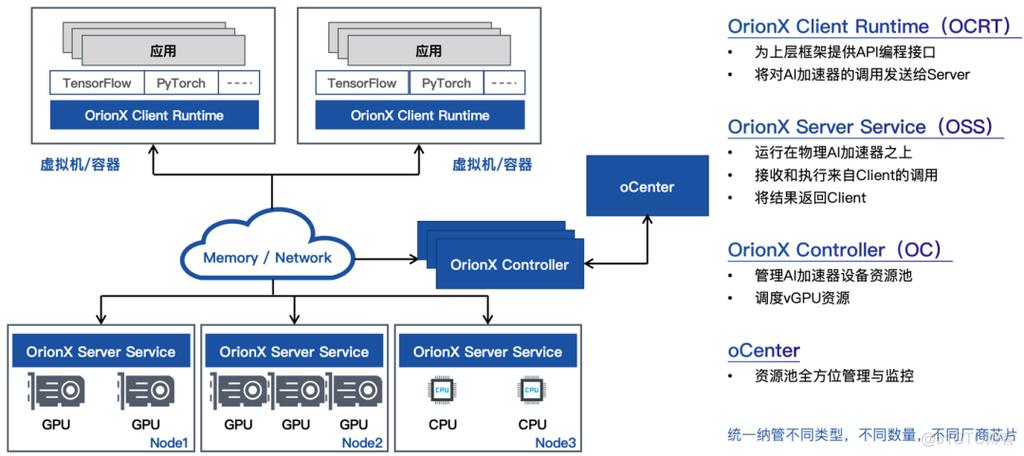

〖叁〗、GPU虚拟化技术通过资源切分显著提升了GPU资源的利用率。在当前的实践中,广泛采用拦截CUDA调用的方式来实现GPU虚拟化。这种拦截可以在CUDA API层面进行,也可以在内核层面虚拟一个GPU设备来截获cuda的系统调用。本文将重点讨论GPU池化中的远程调用尝试,特别是针对CUDA层面的远程调用。

〖肆〗、GPU虚拟化技术通过提高资源利用率、提供良好的隔离性以及实现资源的弹性扩展,为企业用户提供了高效利用GPU资源的解决方案。在GPU虚拟化的分类中,软件模拟、直通独占和直通共享是主要的三种方式。

〖伍〗、Citrix的3D桌面虚拟化解决方案中,大部分使用NVIDIA公司提供的显卡虚拟化技术,即vCUDA(virtual CUDA)技术。vCUDA采用在用户层拦截和重定向CUDA API的方法,在虚拟机中建立物理GPU的逻辑映像——虚拟GPU,实现GPU资源的细粒度划分、重组和再利用,支持多机并发、挂起恢复等虚拟机高级特性。

一文简介GPU虚拟化

GPU虚拟化简介 GPU虚拟化是一项技术创新,旨在通过软件或硬件方式将一台物理计算机上的GPU资源划分为多个虚拟GPU(vGPU)设备,供多个虚拟机或容器使用。这一技术使得在虚拟化环境中,每个用户或虚拟机都能独立运行图形密集型应用程序,同时保持相互之间的隔离,互不干扰。

GPU虚拟化技术通过提高资源利用率、提供良好的隔离性以及实现资源的弹性扩展,为企业用户提供了高效利用GPU资源的解决方案。在GPU虚拟化的分类中,软件模拟、直通独占和直通共享是主要的三种方式。

MIG:特点:将物理GPU划分为多个独立的虚拟GPU实例。优缺点:提供多实例隔离,但同样依赖特定GPU架构,并可能带来额外的管理挑战。Timesliced GPU:特点:通过时间切分技术,实现GPU资源的串行使用。优缺点:能够在一定程度上提高资源利用率,但可能影响实时性能。

GPU虚拟化是指将物理GPU资源以某种方式共享给多个虚拟机(VM)使用的技术。这种技术对于提高资源利用率、实现灵活的资源分配以及支持多样化的应用场景具有重要意义。以下是对GPU虚拟化技术的详细解析:整体Pass-Through方案整体Pass-Through方案是指将一整个物理GPU完全划给一个guest VM使用。

软件虚拟化在主机操作系统上安装支持虚拟化的软件,分割物理GPU资源为虚拟GPU,统一控制和管理。需深入了解硬件和操作系统,实现复杂。云服务虚拟化利用远程协议,通过云服务供应商提供GPU加速云服务,用户在云端享受GPU资源。只需购买服务,即可享受GPU虚拟化体验。

远程调用实现:在远程GPU侧,可以使用CUDA driver API将得到的fatbin载入module,并利用GetFunction函数输入mangling_name来获取需要调用的核函数句柄。这样,就可以实现远程调用核函数了。总结 GPU虚拟化中的GPU池化远程调用尝试是一项复杂而具有挑战性的任务。

浅谈GPU虚拟化三种方法

〖壹〗、硬件虚拟化通过在GPU上添加虚拟化支持芯片,建立物理GPU和虚拟GPU之间的通道,完整复制物理GPU功能。硬件设计需增加多个虚拟隔离和管理功能,硬件厂商支持才能实现。优势在于性能损失较小,但实现难度高。软件虚拟化在主机操作系统上安装支持虚拟化的软件,分割物理GPU资源为虚拟GPU,统一控制和管理。

〖贰〗、在GPU虚拟化的分类中,软件模拟、直通独占和直通共享是主要的三种方式。而在直通共享的全虚拟化方式中,PCIe SR-IOV、API转发、MPS方案、MIG技术和Time-sliced GPU等具体技术各有优缺点,用户可以根据实际需求和技术特点选取合适的技术方案。

〖叁〗、GPU虚拟化的实现方式包括: 基于GPU硬件虚拟化:这种方式通过在GPU硬件级别上实现虚拟化,为多个虚拟机提供独立的虚拟GPU。它要求硬件支持并依赖操作系统和驱动程序。尽管实施难度较大且需要硬件厂商的支持,但优点是性能损失较小。

好了,关于gpu如何实现硬件虚拟化和xen gpu虚拟化的问题到这里结束啦,希望可以解决您的问题哈!