极智算总结:

- 怎么调用服务器的gpu

- gpu服务器怎么用

- 常见的关于GPU云服务器和GPU物理服务器的区别(值得收藏)

- gpu温度怎么控温

- GPU服务器是什么?选深度学习GPU服务器看这里

- 两台gpu服务器卡如何组网可以实现点对点

- 不再被GPU各种驱动绑架!一站式解决GPU问题

- 【深度学习】谷歌云GPU服务器创建与使用指南(一)

- 【工具篇】如何优雅地监控显卡(GPU)使用情况?

- GPU服务器和普通服务器有什么区别?

怎么调用服务器的gpu

在VSCode中远程连接到服务器并调用GPU:如果您习惯使用VSCode进行代码开发,可以通过配置远程连接插件(如Remote - SSH)连接到装备了GPU的服务器。在远程服务器上,您可以像在本地一样运行和调试使用GPU加速的代码,如PyTorch等深度学习框架。

GPU服务器的使用主要包括以下步骤: 明确应用需求:首先确定你要使用GPU服务器进行哪种类型的计算,如深度学习、科学计算或图形渲染等,因为不同的应用对GPU的型号和性能要求不同。 选取云服务提供商:根据你的需求和预算,选取一个合适的云服务提供商,比较其费用、性能、服务质量和支持情况。

管理、磁盘、网络、SSH密钥:在“管理”下方找到“可用性策略”,如需要创建可抢占实例(以相对低廉的费用使用高性能的GPU服务器,但有效期只有24小时,过期或遇到特殊情况会被自动删除),只需将“抢占”设置为开启。SSH密钥部分可以暂时忽略,后续会详细讲解。

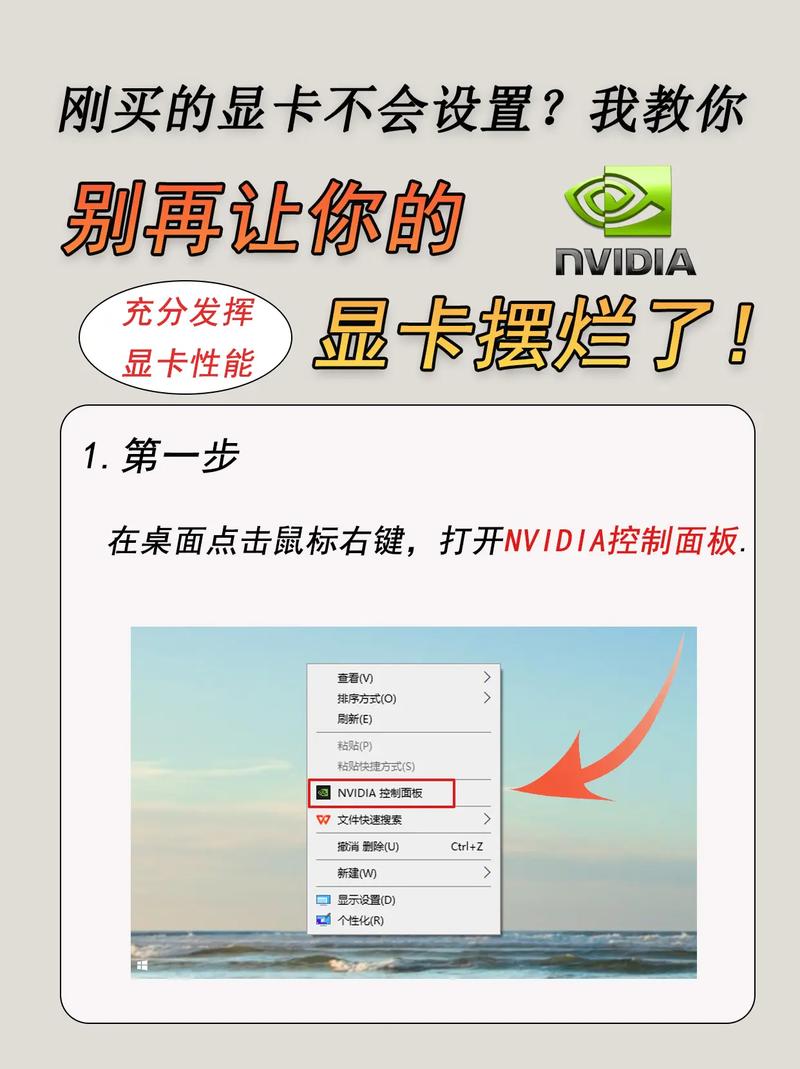

登录到DSM控制台。点击“控制面板”。在控制面板中,点击“高级模式”。在高级模式中,选取“GPU”。在GPU设置中,启用“启用GPU加速”。选取要使用的显卡。保存更改并重新启动服务器。

驱动软件准备 下载驱动:从NVIDIA官方网站下载适用于VMware ESXi的GPU驱动。注意,与普通显卡的驱动下载地址不同,需选取专门针对VMware ESXi的版本。下载链接需根据ESXi的具体版本进行选取,确保下载的驱动包包含ESXi主机驱动和虚拟机驱动。

遇到在GPU服务器上通过Docker使用GPU时的常见问题:Error response from daemon: could not select device driver nvidia with capabilities: [[ gpu]]。问题根源问题产生的原因是未安装nvidia-container-toolkit。这个工具的作用在于,旧版Docker不支持GPU,需要nvidia-docker来运行支持GPU的镜像。

gpu服务器怎么用

〖壹〗、GPU服务器的使用主要包括以下步骤: 明确应用需求:首先确定你要使用GPU服务器进行哪种类型的计算,如深度学习、科学计算或图形渲染等,因为不同的应用对GPU的型号和性能要求不同。 选取云服务提供商:根据你的需求和预算,选取一个合适的云服务提供商,比较其费用、性能、服务质量和支持情况。

〖贰〗、管理、磁盘、网络、SSH密钥:在“管理”下方找到“可用性策略”,如需要创建可抢占实例(以相对低廉的费用使用高性能的GPU服务器,但有效期只有24小时,过期或遇到特殊情况会被自动删除),只需将“抢占”设置为开启。SSH密钥部分可以暂时忽略,后续会详细讲解。

〖叁〗、在VSCode中远程连接到服务器并调用GPU:如果您习惯使用VSCode进行代码开发,可以通过配置远程连接插件(如Remote - SSH)连接到装备了GPU的服务器。在远程服务器上,您可以像在本地一样运行和调试使用GPU加速的代码,如PyTorch等深度学习框架。

〖肆〗、点击“免费使用”注册天翼云账号,通过天翼云官方网站的注册页面完成账号的创建。实名认证 登录天翼云官方网站控制台,完成实名认证。这一步是确保账号的安全性和合法性,部分产品可能需要将个人实名认证升级为企业认证以享受更多优惠。选取GPU云服务器 在天翼云官方网站的产品页面,选取GPU云服务器。

〖伍〗、在服务器使用显卡的步骤:操作系统安装 确定操作系统及版本号:选取Ubuntu作为操作系统。确定Ubuntu的版本号,需考虑驱动程序和CUDA的支持情况。例如,Ubuntu 204版本有对应的NVIDIA数据中心驱动程序。

常见的关于GPU云服务器和GPU物理服务器的区别(值得收藏)

〖壹〗、稳定性 GPU云服务器:突破了传统GPU服务器的限制,具有高并行、高吞吐、低时延的极致性能。云服务器提供商通常会提供稳定的基础设施和运维支持,确保服务的稳定性和数据的高可用性。GPU物理服务器:稳定性需要用户自行部署和保障。

〖贰〗、GPU 云服务器(GPU Cloud Computing,GPU)是提供 GPU 算力的弹性计算服务。它具有超强的并行计算能力,作为 IaaS(Infrastructure as a Service,基础设施即服务)层的尖兵利器,服务于深度学习训练、科学计算、图形图像处理、视频编解码等多种高性能计算场景。

〖叁〗、云服务器:虽提供GPU实例,但可能受限于虚拟化性能损耗;而GPU物理机直接通过硬件加速,性能更稳定,适合对延迟敏感的场景。总结:GPU服务器BGP线路显卡物理机通过整合高性能显卡、BGP多线网络及专业机房环境,为图形处理、深度学习、游戏挂机等场景提供了高效、稳定的计算解决方案。

〖肆〗、与云服务器的区别:性能:裸金属服务器在CPU、内存、带宽等性能上通常比云服务器更强悍,更适合高性能计算场景。资源隔离:裸金属服务器具备物理机级别的资源隔离优势,特别适合上云部署传统非虚拟化场景的应用。

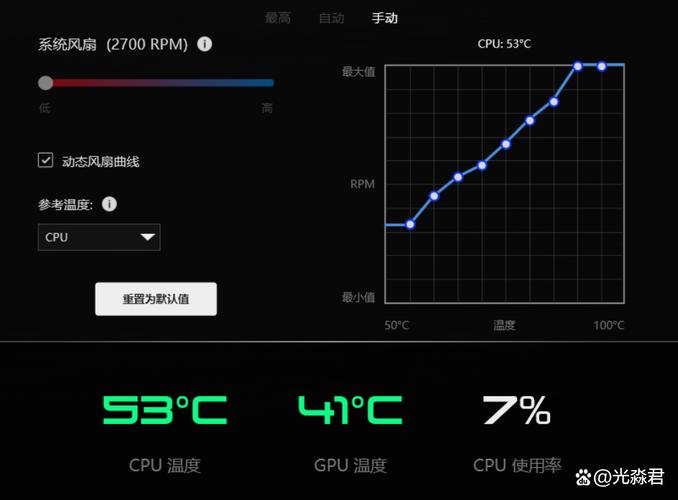

gpu温度怎么控温

〖壹〗、Alienware 17 R3的温度控制表现较好,且支持通过BIOS设置调整CPU温度限制以实现精准控温。具体温度控制表现及操作方法如下:散热表现与温度分布Alienware 17 R3在严苛测试中展现出优秀的散热能力。

〖贰〗、用红色框圈起来的部分,就可以看到cpu的温度,核心的温度,以及显卡和硬盘的温度。

〖叁〗、可以尝试使用如WaterfallPro、CpuIdle、SoftCoolerII、VCool或CPU降温圣手等控温软件,这些软件能够通过优化CPU的运行状态来降低温度。检查电压设置:在BIOS中检查CPU的电压设置,确保电压不过高也不过低,以保持CPU的稳定性和温度控制。

GPU服务器是什么?选深度学习GPU服务器看这里

NV-Link总线技术标准GPU服务器:NV-Link接口GPU的典型代表是NVIDIA V100,采用SXM2接口。具有NV-Link总线标准的GPU服务器可以分为两类:一类是英伟达设计的DGX超级计算机,另一类是英伟达合作伙伴设计的具有NV-Link接口的服务器。

GPU服务器是基于GPU应用在视频编解码、深度学习、科学计算等多场景下的稳定、快速且弹性的计算服务。GPU服务器的作用加速计算:GPU能够显著加快计算速度,通过将应用软件中的部分计算负荷迁移到GPU上,而CPU则继续运行其他代码。这种分工使得应用软件的运行速度得到明显提升。

GPU服务器是基于GPU的应用于多种场景的快速、稳定、弹性的计算服务。其出色的图形处理能力和高性能计算能力提供极致计算性能,有效解放计算压力,提升产品的计算处理效率与竞争力。GPU服务器的主要用处包括但不限于以下几个方面:视频编解码:GPU服务器可以加速视频编解码过程,提高视频处理效率。

GPU 云服务器(GPU Cloud Computing,GPU)是提供 GPU 算力的弹性计算服务。它具有超强的并行计算能力,作为 IaaS(Infrastructure as a Service,基础设施即服务)层的尖兵利器,服务于深度学习训练、科学计算、图形图像处理、视频编解码等多种高性能计算场景。

GPU服务器是一种配备高性能图形处理器的服务器,其作用主要体现在图形处理与计算加速、深度学习与机器学习以及高性能计算集群等方面。 图形处理与计算加速: GPU服务器具备强大的并行处理能力,能够高效地进行图形处理和计算加速。

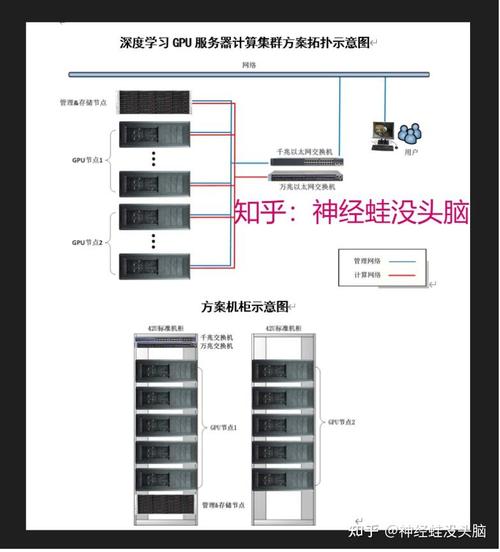

两台gpu服务器卡如何组网可以实现点对点

〖壹〗、两台GPU服务器卡要实现点对点组网,可以通过使用专用的高速互连网络来实现,比如InfiniBand(IB)网络。以下是具体的组网步骤:购买并安装专用高速互连设备:选取设备:根据两台GPU服务器的配置和需求,选取适合的InfiniBand设备。

〖贰〗、统一内存:支持连接的GPU之间的内存池,对于大型数据集任务至关重要。工作原理 NVLink由可以双向传输数据的高速数据通道组成,采用点对点连接,有效减少瓶颈并提高数据吞吐量。支持网状拓扑,允许GPU之间实现更通用且数量更多的连接。

〖叁〗、技术特点 高速互连:NVLink通过高速连接两块NVIDIA显卡,能够实现显存和性能的扩展,从而满足最大视觉计算工作负载的需求。高带宽:与传统的PCIe相比,NVLink提供了高达10倍的带宽,这使得多个GPU能够在单个服务器内通过点对点网络连接在一起,形成混合立方体网格。

〖肆〗、高速点对点链路:NVLink是专门设计为连接GPU的高速点对点链路,具有比传统网络更高的性能和更低的开销。网络内聚合:第三代NVswitch配备64个NVLink端口,提供高达18Tbps的交换容量,支持多播和网络内聚合功能,有助于减少训练迭代过程中GPU之间的数据传输量。

〖伍〗、在实际应用中,除了考虑硬件性能外,还需要关注软件优化、网络配置等方面。例如,正确安装和配置NCCL、使用高性能的网卡和交换机等都可以进一步提升分布式训练的性能。通过以上分析,我们可以更好地理解NCCL在GPU分布式训练中的作用以及DGX系列服务器的性能优势。

不再被GPU各种驱动绑架!一站式解决GPU问题

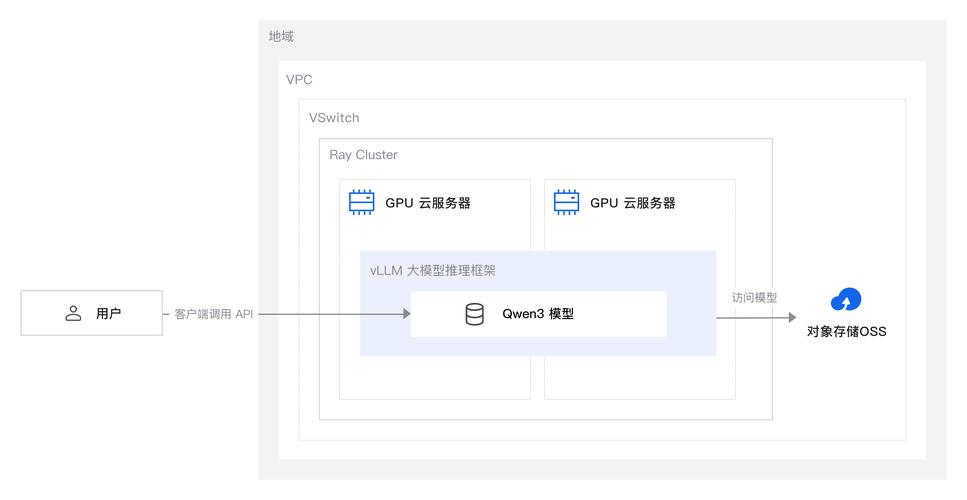

不再被GPU各种驱动绑架!一站式解决GPU问题 对于需要进行AI项目的同学而言,寻找和支持各种版本的GPU驱动无疑是一项艰巨的任务。找到驱动后又常常面临各种不兼容的问题,这极大地影响了项目的进度和效率。然而,随着云计算技术的飞速发展,云GPU服务器已经为解决这类问题提供了有效的方案。

在英雄联盟客户端的设置中,将图像偏好设置为DX9传统模式,这有助于解决某些与显卡驱动兼容性的问题。卸载腾讯WeGame:有玩家反映,卸载腾讯WeGame后,英雄联盟的运行变得更加流畅,不再出现GPU驱动重启的问题。如果安装了WeGame并遇到此问题,可以尝试卸载后观察是否有所改善。

兼容性上,可能会出现与新软件或游戏不兼容的现象,引发程序崩溃、报错等问题。 安全性也会受影响,新的安全漏洞可能无法通过老旧驱动得到有效防护。 为了解决这个问题,你可以前往GPU厂商的官方网站,如英伟达或AMD的官方网站,找到对应型号GPU的最新驱动程序进行下载安装。

游戏里勾上等待垂直同步。帧数设置1完事。还卡。就设置成80.问题根源是lol不支持切换独显和核显。

优化网络环境和检查游戏文件:有时,网络环境的不稳定也可能导致游戏误报显卡驱动问题。此时,用户可以尝试优化网络环境,如重启路由器或关闭一些占网速的程序。同时,检查游戏文件的完整性也是解决此类问题的一个有效方法。用户可以通过Steam等游戏平台提供的验证功能来检查并修复游戏文件。

Windows已经重启了您的gpu驱动,可以采取以下的方法进行解决: 更新显卡驱动程序:如果您最近更新了显卡驱动程序,请确保它与您的操作系统兼容。如果不兼容,请尝试回滚到较旧的版本。 禁用GPU加速:如果您的显卡驱动程序与操作系统不兼容,则可以尝试禁用GPU加速。

【深度学习】谷歌云GPU服务器创建与使用指南(一)

点击“创建”后,可能会遇到GPU数量为0的情况。这是因为免费用户没有GPU配额。你需要在配额界面升级用户,然后在上方“指标”中搜索“k80”或“P100”,并申请增加限额。很快就会收到Google的邮件,提示你已经提升GPU限额。后续步骤 完成实例创建后,你就可以开始使用Google Cloud的GPU服务器了。

GPU服务器的使用主要包括以下步骤: 明确应用需求:首先确定你要使用GPU服务器进行哪种类型的计算,如深度学习、科学计算或图形渲染等,因为不同的应用对GPU的型号和性能要求不同。 选取云服务提供商:根据你的需求和预算,选取一个合适的云服务提供商,比较其费用、性能、服务质量和支持情况。

GPU选取 GPU(图像处理单元)是深度学习服务器中的核心组件,负责执行模型训练中的大量计算任务。主流选取:GTX1080ti和RTX2080ti,这两款显卡显存大(11G),性价比高,适合大多数深度学习任务。高端选取:对于大型数据集或需要更高精度的任务,可以选取Tesla v100(16G/32G)或RTX8000(48G显存)。

GPU选取 GPU是深度学习服务器中的核心组件,负责执行大量的并行计算任务。在选取GPU时,需考虑显存大小、性能、散热方式及费用等因素。主流选取:GTX1080ti和RTX2080ti,这两款显卡显存大(11G),性价比高,适合大多数深度学习任务。

GPU服务器是基于GPU(图形处理器)的应用,在视频编解码、深度学习、科学计算等多场景中提供稳定、快速且弹性的计算服务。GPU服务器的作用:GPU能够加速计算,提供卓越的应用软件性能。

深度学习环境搭建指南:配置深度学习环境服务器 安装Nvidiadocker:借鉴Nvidiadocker教程进行配置,确保可以在docker环境中使用GPU。拉取nvidia/cuda镜像:根据Linux版本和服务器cuda驱动版本,选取cudnn8devel版本,在服务器端拉取镜像。创建自定义镜像:自行创建dockerfile文件并命名为Dockerfile。

【工具篇】如何优雅地监控显卡(GPU)使用情况?

nvidia-smi简介:nvidia-smi 是 NVIDIA 提供的一个命令行工具,用于管理和监控 NVIDIA GPU 设备。它是最有名且广泛使用的工具之一。使用方法:直接在终端输入 nvidia-smi 可以获取当前 GPU 的使用情况,包括温度、功耗、内存使用情况以及正在运行的进程等。

使用教程:查看基本参数:打开GPU-Z,即可在界面上看到显卡的详细参数。实时监控:点击“Sensors”选项卡,可以读取更多GPU的实时数据。在每一项的下拉菜单中,可以选取显示一定时间内各项的峰值、低值或平均值。

首先,回到电脑桌面模式,鼠标右键单击下面的状态栏,。然后,选取右键菜单的任务管理器,。下面,进入任务管理器,点击性能,。然后,进入性能点击左侧的GPU0,这里一般是集成显卡,。接着,进入集成显卡界面,可以看到下面的利用百分比了,。然后,点击GPU1这个一般是独立显卡,。

GPU编程模型并行性:GPU内部的计算单元本身是大量的并行,是天然的SIMD(单指令多数据)。不同厂商有自己的命名方式。CUDA编译与监控:CUDA相关代码需使用nvcc编译,具有优化和配置选项。nvidia-smi是监控和管理显卡使用情况的命令行工具,对优化时确定性能瓶颈很重要。

创建GPU实例首先,登录你的账号,进入算力市场或通过控制台,选取适合的GPU类型,如TITAN Xp。接着,配置镜像,包括框架、版本、Python和CUDA版本,点击创建。实例启动后,你可以管理其状态,如关机、重启或无卡模式。

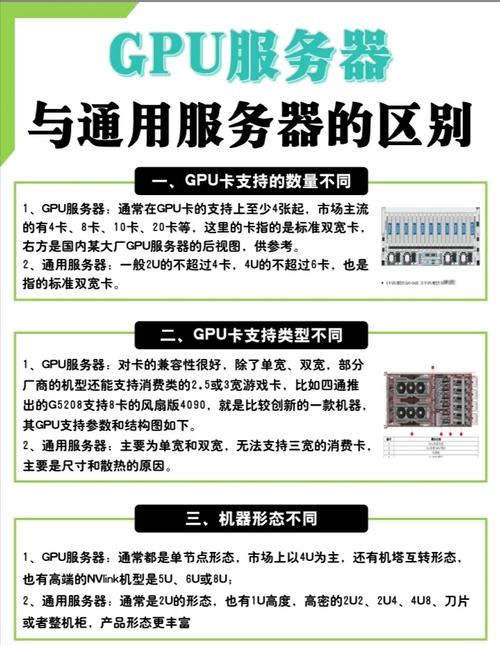

GPU服务器和普通服务器有什么区别?

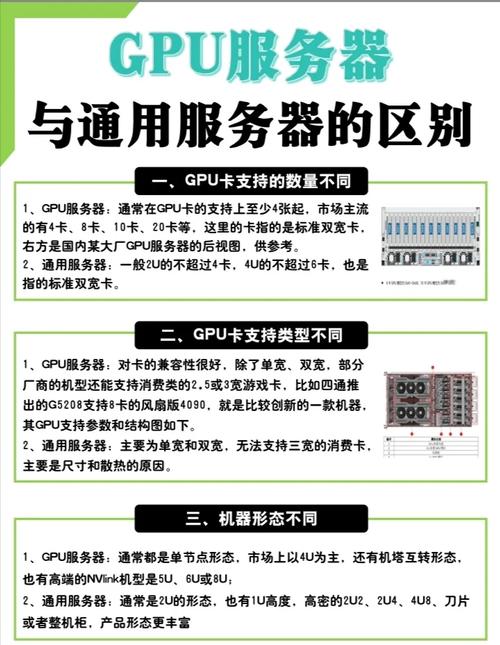

〖壹〗、GPU服务器和普通服务器的主要区别如下:核心功能与应用场景 GPU服务器:基于GPU构建,主要应用于视频编解码、深度学习、科学计算等多种需要高性能计算的场景。GPU服务器提供快速、稳定、弹性的计算服务,并具备和标准云服务器一致的管理方式。

〖贰〗、GPU服务器:由于配备了高性能的GPU和其他相关硬件,费用相对较高。普通服务器:费用相对较为亲民,根据具体配置和品牌有所不同。管理与维护:GPU服务器:由于硬件配置的特殊性,可能需要更专业的技术人员进行管理和维护。普通服务器:管理和维护相对较为简单,一般技术人员即可完成。

〖叁〗、显卡服务器(GPU服务器):由于GPU的大规模并行计算特性,其功耗较高。因此,GPU服务器需要更多的电力供应来支持其高性能的计算任务。硬件成本 普通服务器:相对较低的硬件成本,适用于小规模的计算需求。普通服务器的硬件配置相对简单,因此其成本也相对较低。

〖肆〗、GPU服务器:由于配备了高性能的GPU和相关的硬件资源,GPU服务器的费用通常较高。普通服务器:费用相对较为亲民,适合预算有限的用户或企业。稳定性与可靠性:GPU服务器:通常设计为能够长时间稳定运行,以满足高性能计算任务的需求。它们通常具有更高的可靠性和稳定性要求。

〖伍〗、GPU服务器和普通服务器之间的主要区别在于它们所针对的工作负载类型以及为此优化的硬件配置。以下是两者之间的一些关键差异:处理器(CPU)普通服务器:通常配备多核高性能中央处理器(CPU),这些CPU适用于处理大量并发请求或执行复杂的计算任务,如数据库查询、Web服务等。

〖陆〗、GPU服务器:一般是视频渲染图形处理、做AI训练、AI推理或者HPC计算为主。通用服务器:哪里都可以用,比如做私有云、分布式存储、管理节点、HPC通用算力节点等等。两者在业务场景定位上有所不同,GPU服务器更专注于高性能计算和图形处理等领域,而通用服务器则更为通用,适用于多种场景。

文章到此结束,如果本次分享的gpu服务器使用教程图解视频和gpu服务器操作系统的问题解决了您的问题,那么我们由衷的感到高兴!