极智算总结:

- 从新基建谈GPU算力(一)

- 用GPU算力租赁,你也可以高效、省钱做开发

- ...是如何计算出来的——算力的计算方法(CPU和GPU)

- 什么是CPU、GPU、NPU、TPU,及算力对比?

- GPU算力科普,什么是GPU算力?

- 香港GPU服务器有什么作用!可应用于哪些方面!

- GPU集群网络、集群规模、集群算力

- 大白话解释GPU的算力是怎么算出来的?

从新基建谈GPU算力(一)

GPU算力作为新基建中大数据中心的核心,是支撑人工智能、5G等网络新经济的关键技术,其发展直接推动新基建各领域效率提升与成本优化。

基建:确保充裕的供电及制冷条件,以支持GPU集群的高负载运行。GPU计算模块:数据中心级GPU(如A100):适合训练大型数据集及模型,支持NVLINK,具备高显存和混合精度计算训练能力。GeForce系列GPU(如RTX4090):性价比较高,但显存有限,不支持NVLINK,适合中小规模或对数据集和训练精度要求不高的场景。

数字化转型的基础,就是“新基建”。新基建将覆盖包括区块链在内的新技术基础设施,算力将成为新生产力。联接和计算是新基建的两个核心,一是联接网络、平台,二是计算,包括算力、算法。围绕新基建,算力是核心、数据是要素。

用GPU算力租赁,你也可以高效、省钱做开发

〖壹〗、GPU算力租赁的优势 降低成本:通过租赁GPU算力,开发者无需承担高昂的硬件购买成本,只需按需支付使用费用,大大降低了进入AI领域的门槛。灵活高效:GPU算力租赁平台通常提供多种资源选取,开发者可以根据项目需求选取合适的GPU配置,实现资源的灵活调配。

〖贰〗、GPU算力租赁:灵活高效的选取 GPU算力租赁服务允许用户根据自身需求,灵活选取和租用高性能的GPU资源。这种服务模式极大地降低了进入高技术领域的门槛,使得即便是预算有限的开发者也能轻松获取到强大的计算能力。

〖叁〗、GPU算力租赁的重要性 对于需要大量计算资源的AI项目来说,高性能的GPU服务器几乎是必备工具。然而,高昂的硬件成本、维护难度以及技术门槛让许多个人开发者和小型团队望而却步。GPU算力租赁正是为了解决这一问题而生,它允许用户以较低的成本获得所需的计算能力,降低了进入AI领域的门槛。

〖肆〗、用户可以根据实际需求,按需租赁算力资源,无需承担高昂的硬件购置和长期维护费用。这种按需付费的模式,使得初创公司和小型科研团队也能轻松获得强大的计算能力,从而专注于AI模型的开发与优化。灵活选取算力资源 GPU算力租用平台提供了多种型号的GPU供用户选取,如NVIDIAA100、V100、T4等。

...是如何计算出来的——算力的计算方法(CPU和GPU)

GPU的算力计算相对复杂,但核心思路是通过核心数量、频率和每周期计算能力来确定。主要有两种方法:峰值算力法和CUDA核心算力法。

算力计算方式:GPU的算力计算相对复杂,因为它取决于多个因素,包括GPU的架构、核心数、主频、内存带宽等。通常,GPU制造商会提供具体的算力数值,如NVIDIA的GPU通常会提供FP32(32位浮点数)或FP16(16位浮点数)等精度下的算力。

通用计算场景(以FLOPS为单位):使用基础公式“算力(FLOPS)= 核心数量 × 时钟频率(GHz)× 每时钟周期浮点运算次数”。核心数量指CPU物理核心数、GPU流处理器或SM单元数;时钟频率是处理器每秒运行周期数,单位为GHz;每周期运算次数由架构决定。

CPU和GPU的算力主要通过每秒执行的浮点运算次数来衡量,具体计算涉及核心数量、主频以及单周期浮点计算能力。以下是详细解释: 算力的衡量标准: 算力主要通过FLOPS来衡量。它反映了计算机每秒能执行的浮点运算数量,是衡量计算机处理速度和计算能力的重要指标。

什么是CPU、GPU、NPU、TPU,及算力对比?

〖壹〗、GPU是一种专门用于高效处理图像和图形的处理器,具有强大的并行计算能力。它最初是为了处理三维图形而设计的,但随着技术的发展,已广泛应用于科学计算、计算机视觉、深度学习等领域。

〖贰〗、定义:GPU是图形处理器,专为图像和图形处理而设计。 算力特点:GPU拥有更多核心和高速内存,对大规模并行任务有显著优势,因此在科学计算、计算机视觉和深度学习等领域有广泛应用。 NPU: 定义:NPU是神经处理单元,专为深度学习优化。 算力特点:NPU注重矩阵运算和卷积运算,能高效处理神经网络计算。

〖叁〗、GPU,作为图形处理器,专为图像和图形处理而设计,现在广泛应用于科学计算、计算机视觉和深度学习。与CPU相比,GPU拥有更多核心和高速内存,对大规模并行任务有显著优势。NPU,神经处理单元,是专为深度学习优化的处理器,设计上注重矩阵运算和卷积运算,能高效处理神经网络计算。

〖肆〗、NPU是一种专门用于进行神经网络计算的处理器。它主要用于加速人工智能和机器学习任务,包括图像识别、语音识别、自然语言处理等。NPU具有高度并行、低延迟和高能效的特点,特别适合在边缘计算、自动驾驶、机器人、智能手机等设备中进行实时的人工智能计算任务。

〖伍〗、CPU、GPU、NPU、DPU、TPU、IPU、LPU、MCU、MPU 这9大主流芯片我都认识。以下是关于这九种芯片的详细介绍: CPU(中央处理器)架构设计:采用复杂指令集(CISC)或精简指令集(RISC)架构,注重通用性和顺序执行能力。

GPU算力科普,什么是GPU算力?

GPU算力是指图形处理器(GPU)进行浮点运算的能力。以下是对GPU算力的详细科普:什么是GPUGPU,全称图形处理器(Graphics Processing Unit),又称显示核心、视觉处理器、显示芯片,是一种专门用于图像和图形相关运算工作的微型处理器。

GPU算力是指图形处理器在进行各种计算任务时所展现的计算能力。以下是关于GPU算力的详细解释:定义与功能:GPU算力主要由图形处理器提供,它是计算机中专门用于处理图形和图像运算的组件。除了传统的图形渲染,GPU还能在视频编解码、深度学习、科学计算等多种场景中提供高效的计算服务。

GPU算力是指GPU的运算能力。以下是关于GPU算力的详细解释:标称算力:标称算力是GPU硬件规格上的理论性能指标,通常表示为浮点吞吐量。以NVIDIA为例,其标称算力每两年会翻一番,单精度浮点运算的峰值可达到几十到百T。标称算力不包括专为特定任务加速的硬件单元,如tensorcore。

GPU,全称为图形处理器(Graphics Processing Unit),是计算机中用于处理图形和图像运算的专用处理器。它能在视频编解码、深度学习、科学计算等场景中提供快速、稳定、弹性的计算服务。GPU拥有多个核心,能在同一时间处理多个任务的不同部分,效率远超单一的CPU。

探讨GPU算力的计算方法,涉及到三个关键因素:计算核心数量、核心频率和核心单周期运算能力。GPU峰值计算能力,即算力,可通过以下公式计算:[公式]公式中,F_clk表示GPU的时钟周期内指令执行数(单位为FLOPS/Cycle),F_req为运行频率(单位为GHz),N_SM为GPU SM数量(单位为Cores)。

GPU的算力,简单来说,就是GPU每秒钟能做多少数学题。这里的数学题不是简单的加减乘除,而是更复杂的浮点运算(类似小数计算)和整数运算(类似整数统计)。为了更直观地理解,我们可以从以下几个方面来详细解释:算力是个啥?算力,全称计算能力,通常以每秒浮点运算次数(FLOPS)来表示。

香港GPU服务器有什么作用!可应用于哪些方面!

香港GPU服务器主要用于提供高性能的图形处理和计算能力,可应用于视频编解码、深度学习、科学计算、3D图形处理等多个领域。GPU服务器的作用:提供强大的算力:GPU服务器相比普通服务器能提供更高的算力,尤其在处理大规模并行计算任务时表现突出。出色的图形处理能力:GPU本身对图像处理有极佳的性能,适合处理视频、图形相关的任务。

GPU服务器是基于GPU的应用于多种场景的快速、稳定、弹性的计算服务。其出色的图形处理能力和高性能计算能力提供极致计算性能,有效解放计算压力,提升产品的计算处理效率与竞争力。GPU服务器的主要用处包括但不限于以下几个方面:视频编解码:GPU服务器可以加速视频编解码过程,提高视频处理效率。

GPU云服务器是基于GPU应用的计算服务,具备实时高速的并行计算和浮点计算能力,因此能够广泛应用于多个领域。视频编解码:在影视频网站、直播平台等场景中,GPU云服务器能很好地解决视频流量高并发对所需的快速、实时编解码的需求。

GPU服务器的主要应用场景和用途包括:深度学习与机器学习:GPU服务器在深度学习和机器学习中至关重要,它们能显著加速模型训练和推理过程,提高算法效率和精度,为人工智能的发展提供坚实基础。

GPU集群网络、集群规模、集群算力

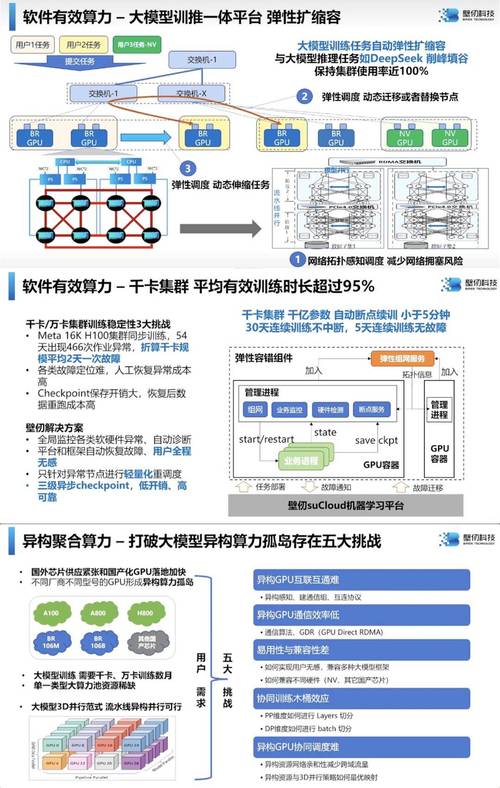

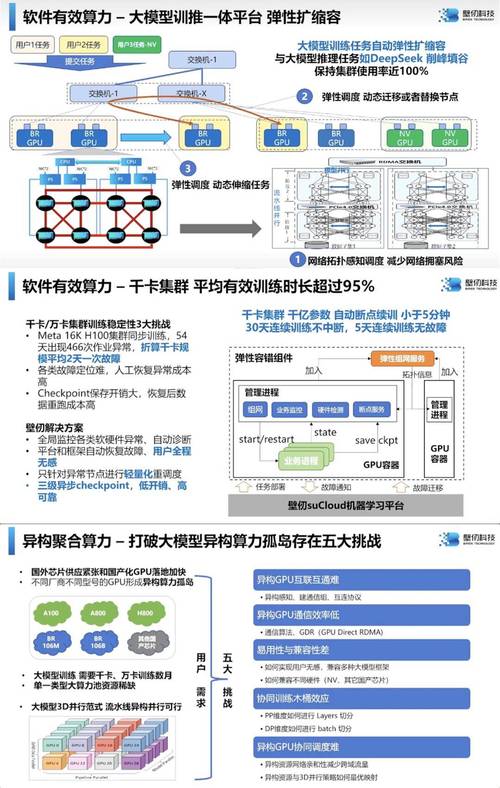

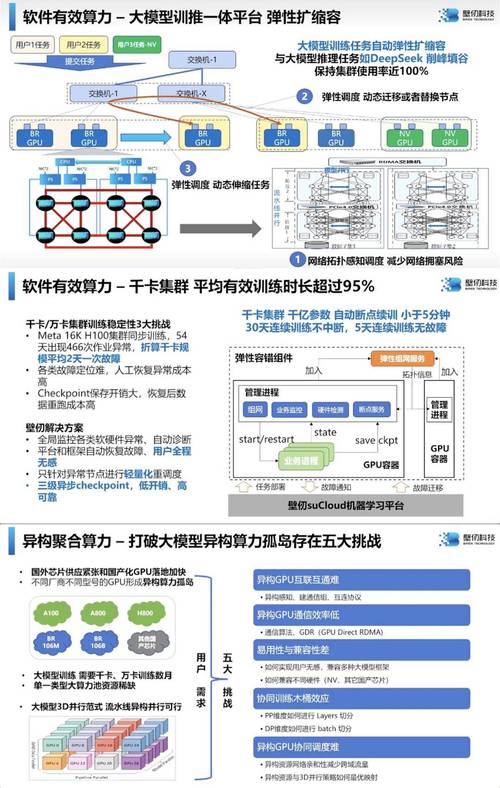

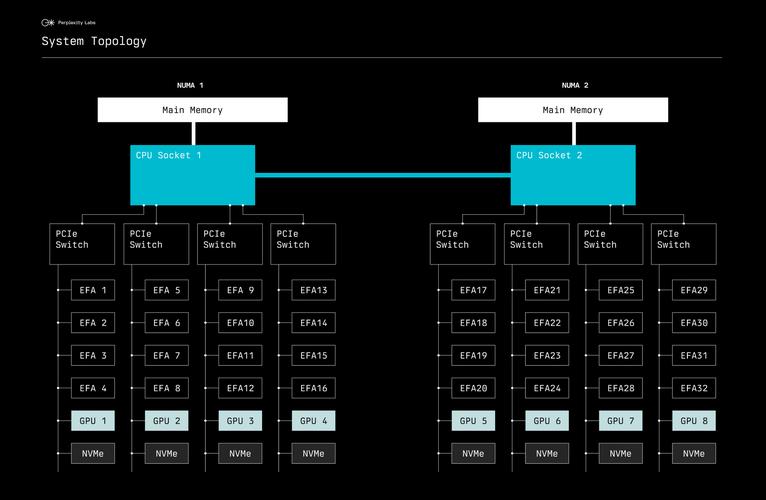

〖壹〗、GPU集群网络、集群规模、集群算力的情况如下:GPU集群网络: 网络配置:GPU服务器间的网络配置对集群性能至关重要。例如,Nvidia DGX A100推荐的配置是200 Gbps/卡,这一配置是由GPU卡的PCIe带宽决定的。不同的GPU服务器型号,如A800和H800,其计算网络配置各异,以适应不同的需求。

〖贰〗、AI时代的GPU集群网络算力分析主要包括以下几个方面:GPU集群的有效算力:单个GPU卡的有效算力可通过其峰值算力来估算,例如Nvidia A100的峰值FP16/BF16稠密算力为312 TFLOPS,实际有效算力约为298 TFLOPS。GPU集群的总有效算力取决于集群规模和集群网络配置。

〖叁〗、基建:确保充裕的供电及制冷条件,以支持GPU集群的高负载运行。GPU计算模块:数据中心级GPU(如A100):适合训练大型数据集及模型,支持NVLINK,具备高显存和混合精度计算训练能力。GeForce系列GPU(如RTX4090):性价比较高,但显存有限,不支持NVLINK,适合中小规模或对数据集和训练精度要求不高的场景。

大白话解释GPU的算力是怎么算出来的?

〖壹〗、综上所述,GPU的算力是通过CUDA核心数、核心时钟频率和每核心单个周期浮点计算系数这三个参数计算出来的。同时,还需要考虑不同精度的算力表述以及显存带宽的影响。在实际应用中,还需要结合具体的应用场景和需求来评估GPU的算力表现。

〖贰〗、GPU算力,通俗地说,就是GPU干活儿的“能力”大小。它衡量的是GPU在单位时间内能够处理的数据量和完成计算任务的复杂程度。如果GPU算力强大,就意味着它能在很短的时间内同时处理大量的数据和任务,迅速完成复杂的计算任务。反之,如果GPU算力较弱,处理同样任务的速度就会慢很多。

〖叁〗、计算成本呈指数级增长:GPT-3训练成本1200万美元,GPT-4估计1亿~2亿美元,未来100万亿参数模型成本可能突破10亿美元。数据效率的关键作用:DeepMind的Chinchilla定律指出,“小模型+大数据”可能比“大模型+小数据”更高效。例如,700亿参数模型用5倍数据训练,性能可能超过数据不足的1万亿参数模型。

关于gpu服务器算力到此分享完毕,希望能帮助到您。